Open AI ma problem, którego nie da się już ignorować. Każdego tygodnia 230 milionów ludzi na całym świecie traktuje ich czatbota jak lekarza pierwszego kontaktu, pytając o diagnozy i leczenie. Zamiast z tym walczyć, firma postanowiła sformalizować ten proces. Tak powstał ChatGPT Health – dedykowany moduł, który obiecuje bezpieczeństwo, ale jednocześnie stawia nas przed pytaniem: czy sztuczna inteligencja to na pewno najlepszy doradca w sprawach życia i śmierci?

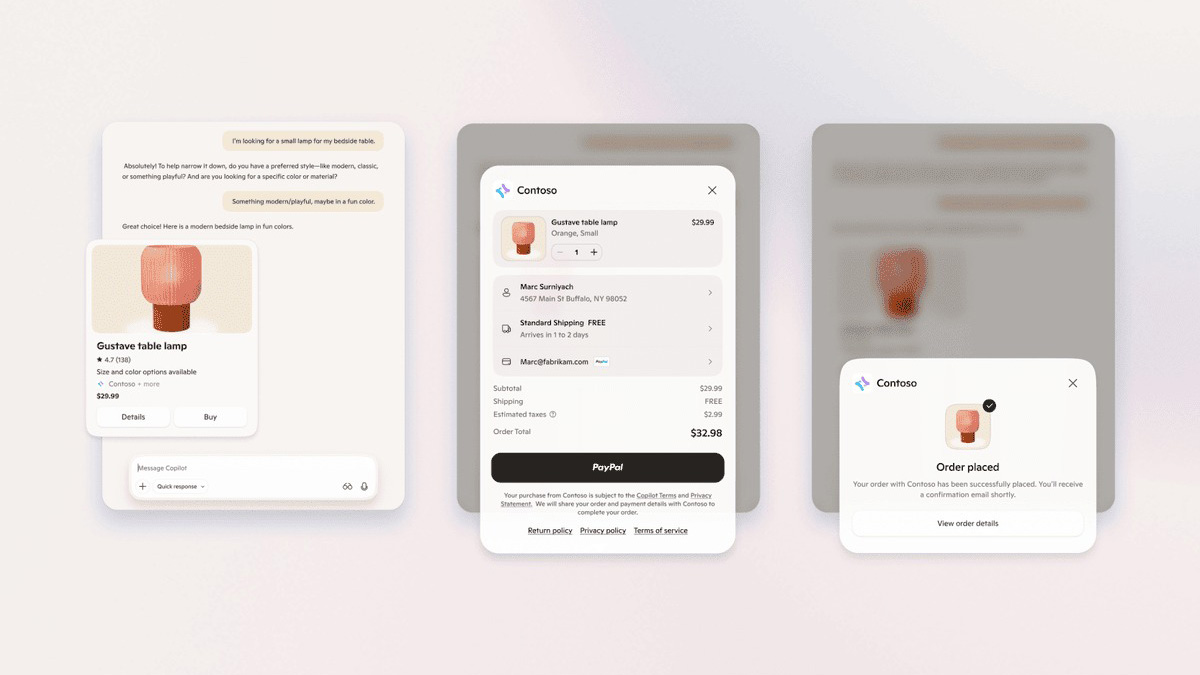

Nowe narzędzie to w teorii bezpieczny azyl. jeżeli zaczniesz opowiadać czatbotowi o swoim bólu w klatce piersiowej, system ma “wyczuć” temat i grzecznie zasugerować przenosiny do specjalnej sekcji Health. To tam OpenAI chce gromadzić nasze najbardziej intymne dane, od wyników badań laboratoryjnych po historię treningową z Apple Health czy Peloton.

Piaskownica z widokiem na Twoją prywatność

OpenAI projektując ChatGPT Health, postawiło na izolację. Moduł działa jako tzw. sandbox – ma własną pamięć i oddzielną historię rozmów, która nie miesza się z resztą naszych zapytań. Firma zarzeka się też, iż te konkretne konwersacje nie posłużą do trenowania przyszłych modeli. Dane będą zaszyfrowane, a dostęp do nich ma być ściśle limitowany.

fot. OpenAI

fot. OpenAIBrzmi to dobrze, dopóki nie uświadomimy sobie skali integracji. W USA ChatGPT Health może zostać podpięty bezpośrednio pod elektroniczną dokumentację medyczną (EHR). W jednym miejscu mogą spotkać się więc Twoje oficjalne wyniki od lekarza, dane z opaski fitness i przemyślenia algorytmu. Choć OpenAI twierdzi, iż to sposób na “ciągłość opieki”, dla wielu może to brzmieć jak kolejna próba przejęcia najbardziej wrażliwych informacji o nas wszystkich.

Kiedy prawdopodobieństwo przegrywa z prawdą

Największy sceptycyzm budzi jednak sama technologia. Modele LLM, na których opiera się ChatGPT, często nie mają pojęcia o tym, co jest prawdą. Zdarza się, iż jedynie przewidują, jakie słowo powinno paść po poprzednim, by zdanie brzmiało sensownie. W medycynie to “prawdopodobieństwo” może być zabójcze. OpenAI samo przyznaje, iż ich modele są podatne na halucynacje, a w historii zdarzały się już przypadki, gdy błędne sugestie AI kończyły się hospitalizacją użytkowników i nie tylko.

Mimo, iż nad ChatGPT Health przez dwa lata pracowało 260 lekarzy (możemy o tym przeczytać bezpośrednio w komunikacie na stronie OpenAI), regulamin pozostaje nieubłagany. Twórcy podkreślają, iż nie jest to narzędzie do diagnozowania ani leczenia. OpenAI tworzy więc dziwną hybrydę – z jednej strony promuje narzędzie jako odpowiedź na brak lekarzy i wysokie koszty opieki, a z drugiej próbuje zdjąć z siebie jakąkolwiek odpowiedzialność za to, co algorytm wygeneruje.

Dostęp? Nie dla wszystkich i nie wszędzie

Funkcja ma zadebiutować w przeglądarkach i na iOS w najbliższych tygodniach, początkowo dla wąskiej grupy testerów.

Fidji Simo z OpenAI przekonuje na swoim blogu, iż ChatGPT Health to konieczność, bo system opieki zdrowotnej jest niewydolny. Czy jednak lekarstwem na przepełnione przychodnie powinna być aplikacja, która potrafi “zmyślać” z ogromną pewnością siebie? Na to pytanie chyba każdy z nas będzie musiał odpowiedzieć sobie sam, gdy po raz pierwszy zobaczymy komunikat zapraszający nas do sekcji Zdrowie.

Źródło: OpenAI, TechCrunch / Zdj. otwierające: Unsplash (@maria_shalabaieva)