W erze cyfrowej, gdzie prawdziwość informacji często bywa podważana, konflikt między Izraelem a Iranem, który trwa od czerwca 2025 roku, uwypuklił nowe zagrożenie: dezinformację generowaną przez sztuczną inteligencję. W tej wojnie na narracje, której elementem stały się sztucznie generowane wideo, prawdziwość wielu materiałów pozostaje wątpliwa. Ale jak odróżnić prawdę od fałszu, gdy choćby chatboty, takie jak "Grok" Elona Muska, mają z tym trudność?

Fala fałszywych wideo zalewa Internet

W czasie konfliktu zarejestrowano liczne przypadki szerzenia fałszywych nagrań, które dzięki AI są przedstawiane jako autentyczne dokumentacje zniszczeń czy protestów. Irackie i irańskie media, według raportów BBC Verify oraz Deutsche Welle, często czerpały z tych treści, by wzmocnić swoją narrację. Jednakże analiza ujawnia, iż te nagrania mają nieprawidłowości, takie jak dziwne cienie czy nierealistyczne detale. To nie tylko wprowadza w błąd społeczeństwo, ale także nasila podziały między stronami konfliktu.

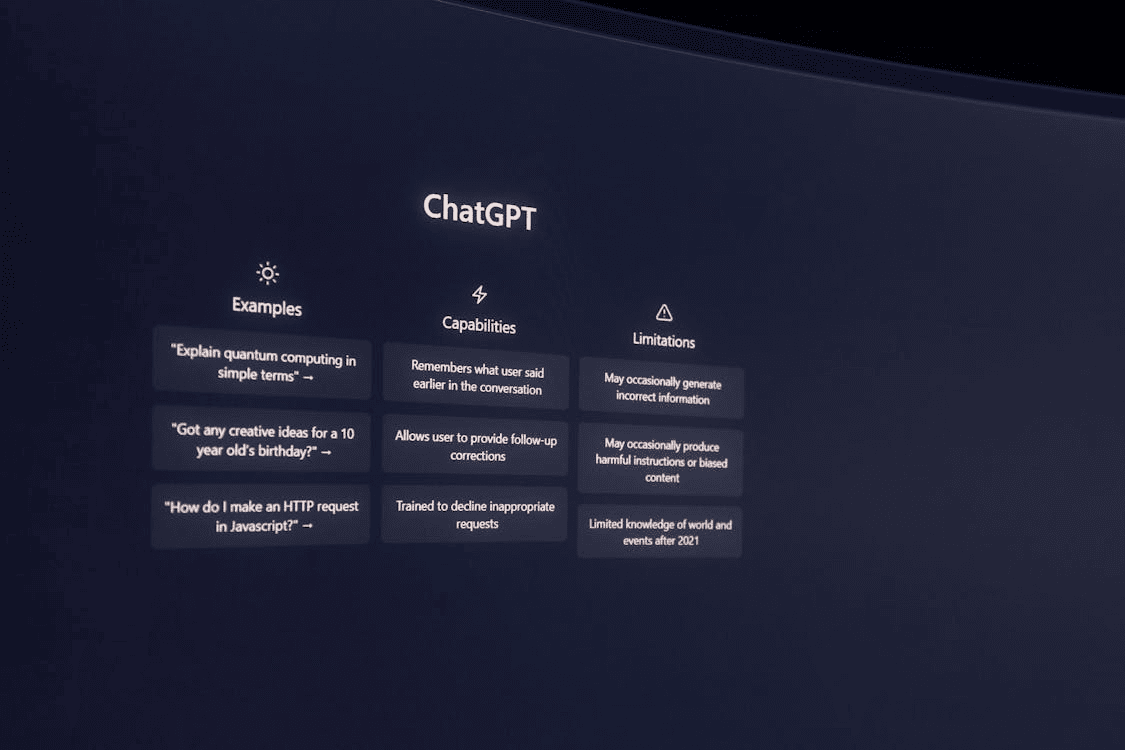

Wyzwania dla zaawansowanych technologii

Nawet narzędzia takie jak AI Elon Musk's "Grok", znane z zaawansowanej analizy danych, napotykają problemy w rozróżnieniu prawdziwych nagrań od fałszywych. Euronews Polska wskazuje, iż chatbot potrafił wielokrotnie dawać sprzeczne oceny dla tych samych materiałów, co oznacza, iż potrzeba bardziej skutecznych narzędzi do weryfikacji treści. Tymczasem popularne konta będące częścią tzw. "engagement farmers", często z niebieskimi weryfikacjami, sprytnie zwiększają zasięg tych fałszywych treści, zwiększając ich wiarygodność w oczach użytkowników.

W natłoku informacji i dezinformacji, internet staje się polem bitwy dla narracji różnorodnych interesów. Dlatego ważne jest, by korzystać z zaufanych źródeł i zawsze dwa razy sprawdzać informacje, zanim uznamy je za prawdziwe. Dla tych, którzy chcą być na bieżąco z podobnymi tematami, polecamy śledzenie sztucznainteligencjablog.pl – miejsca, gdzie w centrum uwagi stoi rzetelna wiedza o sztucznej inteligencji.