Wymagania przedsiębiorstw względem chmury obliczeniowej wyewoluowały dalece poza zakres, w jakim pierwotnie je wdrażano. Teraz bardziej niż kiedykolwiek firmy muszą być przygotowane na błyskawiczną rozbudowę.

Sprostanie niespodziewanym oczekiwaniom użytkowników przy jednoczesnym utrzymaniu poziomu usług to wymagająca sztuka, tym bardziej iż zadania realizowane w chmurze stają się coraz bardziej wyspecjalizowane, a to z kolei wymaga zastosowania odpowiednich rozwiązań obliczeniowych. CPU, DPU (Data Processing Unit), akceleratory AI są niezbędne, aby w pełni wykorzystać taką architekturę i ekosystem.

Według firmy Flexera prawie połowa wszystkich zadań i danych działa w tej chwili w chmurze publicznej, a 72% decydentów IT (ITDM) traktuje priorytetowo jej optymalizację jako kluczową dla obniżenia kosztów. Oznacza to, iż te wydatki stały się priorytetowe dla wielu przedsiębiorstw. Trendy te zarazem podkreślają to, jak ważne jest tworzenie systemów o odpowiedniej skali, ponieważ firmy powinny mieć infrastrukturę zoptymalizowaną dla ich konkretnych potrzeb biznesowych i wymagań. Warto sobie zdawać sprawę, iż adekwatna strategia względem korzystania z chmury obliczeniowej zapewnia elastyczność, bezpieczeństwo, wydajność i efektywność kosztową, co ma fundamentalne znaczenie dla utrzymania przewagi konkurencyjnej.

Dlaczego to teraz jest odpowiednia pora

Chmura obliczeniowa od dawna stanowi podstawę infrastruktury cyfrowej i budowano ją głównie wokół systemów ogólnego przeznaczenia. Jednak w tej chwili era uniwersalnych rozwiązań gwałtownie się starzeje w środowisku biznesowym coraz bardziej zdominowanym przez sztuczną inteligencję i zadania HPC, tj. charakterystyczne dla superkomputerów. Starsze systemy chmurowe nie są w stanie poradzić sobie z intensywnością obliczeniową modeli głębokiego uczenia, co uniemożliwia firmom czerpanie korzyści z inwestycji.

Jednocześnie natywna architektura chmury jest dziś standardem, ponieważ firmy stoją w obliczu rosnącej presji na wprowadzanie kolejnych innowacji, skracanie okresu potrzebnego do wprowadzania nowych rozwiązań na rynek oraz optymalizację kosztów. Brak tak zoptymalizowanej infrastruktury wiąże się z kolei z ryzykiem utraty tak istotnych cech operacyjnych, jak odpowiednio wysoka wydajność, efektywność i ochrona przed zagrożeniami. Co więcej, uruchamianie zadań typowych dla AI na dużą skalę bez odpowiednio zoptymalizowanej infrastruktury prowadzi do nadmiernego zużycia energii, co zwiększa zarówno koszty operacyjne, jak i wpływ na środowisko. Ta nieefektywność nadwyręża zasoby finansowe i podważa korporacyjne cele zrównoważonego rozwoju tak istotne dla interesariuszy, którzy często priorytetowo traktują inicjatywy ekologiczne.

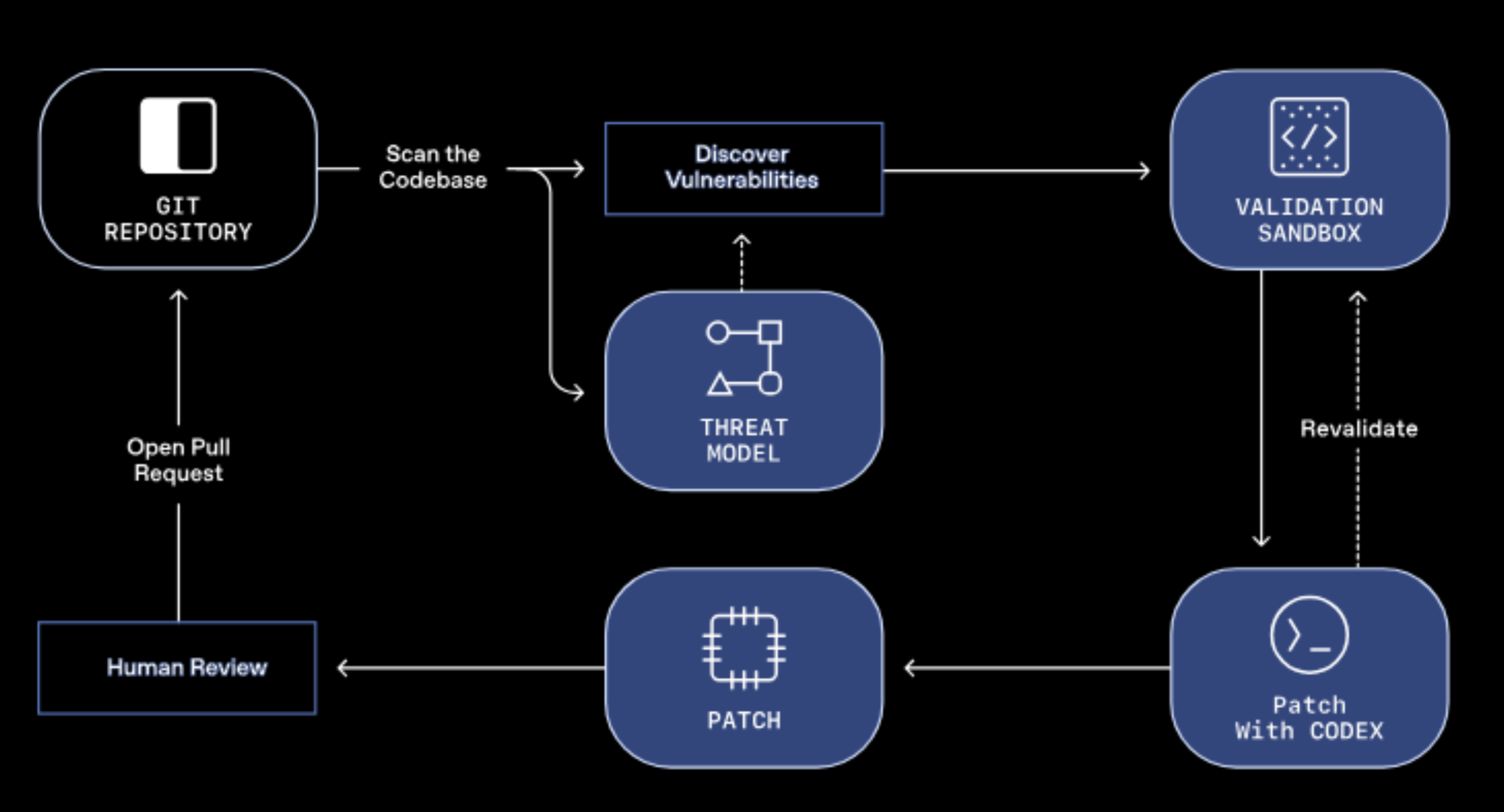

Poza wzrostem wydajności, bezpieczeństwo jest kolejnym czynnikiem przy wyborze sprzętu, który często jest niedoceniany. Rozwiązania zoptymalizowane dla chmury obliczeniowej często zapewniają solidny zestaw zaawansowanych zabezpieczeń, takich jak poufne przetwarzanie (confidential computing). Funkcje te sprawiają, iż poufne dane pozostają zaszyfrowane podczas ich użytkowania, co obniża ryzyko ze strony fizycznych ataków DIMM (Dual In-line Memory Module) czy wirtualnych zagrożeń w środowiskach hiperkonwergentnych.

Zagrożenia wynikające z wycieków danych stale rosną i to problem zarówno pod względem finansowym, jak i wizerunkowym, więc pozostawienie działającej chmury bez ochrony nie jest już dopuszczalną opcją w firmach. Wzrost liczby wyrafinowanych zagrożeń cybernetycznych – od hakerów po podmioty działające na zlecenie państw – sprawiło, iż wzmocniona ochrona staje się bezdyskusyjnym priorytetem.

Twój przewodnik po optymalizacji chmury na 2025 rok

Co więcej, wraz z coraz powszechniejszym zastosowaniem sztucznej inteligencji, decydenci ds. IT powinni upewnić się, iż ich infrastruktura do obsługi chmury jest odpowiednia do zadań wymagających dużej mocy obliczeniowej, a przy tym oferuje adekwatne koszty, ochronę i efektywność energetyczną. Choć potrzeby każdej firmy są inne, to zespoły IT przygotowujące się do modernizacji sprzętu powinny wziąć pod uwagę następujące kwestie:

-

Wydajność: czy instancje w chmurze zapewniają wydajność adekwatną dla Twojej organizacji? Infrastruktura chmurowa musi być zdolna do obsługi szeregu zadań – od aplikacji front-end po analitykę realizowaną w pamięci i ciężkie modele transakcyjne.

-

Efektywność i koszty: czy te same zadania mogłoby obsługiwać mniej serwerów? Wybór instancji o dużej gęstości mocy obliczeniowej pozwala uruchamiać większą liczbę maszyn wirtualnych lub kontenerów na pojedynczym serwerze, a to przekłada się na lepszą efektywność kosztową, energetyczną oraz przestrzenną.

-

Bezpieczeństwo: czy instancje oferują odpowiedni poziom ochrony danych? Np. poufne przetwarzanie pomaga chronić używane dane i zmniejsza podatność na luki w zabezpieczeniach w środowiskach zwirtualizowanych.

-

Ekosystem: wybór procesorów bazujących na standardowej architekturze x86 upraszcza obsługę chmury poprzez łatwiejsze tworzenie, utrzymanie i migrację aplikacji.

Niewidoczna optymalizacja, namacalny wpływ

Wybierając odpowiednie instancje decydenci ds. IT powinni oceniać implikacje i koszty w odniesieniu do każdej jednostki obliczeniowej. Tradycyjne rozwiązania serwerowe zmuszają przedsiębiorstwa do wyboru między nadmierną rozbudową środków, co prowadzi do niepotrzebnych wydatków, a niedostateczną, co może tworzyć wąskie gardła. Sprzęt zoptymalizowany dla chmury obliczeniowej zmienia to równanie, ponieważ umożliwia firmom osiąganie lepszych rezultatów przy wykorzystaniu mniejszej ilości zasobów przy jednoczesnym zachowaniu odpowiednio wysokiego poziomu wydajności, bezpieczeństwa i efektywności.

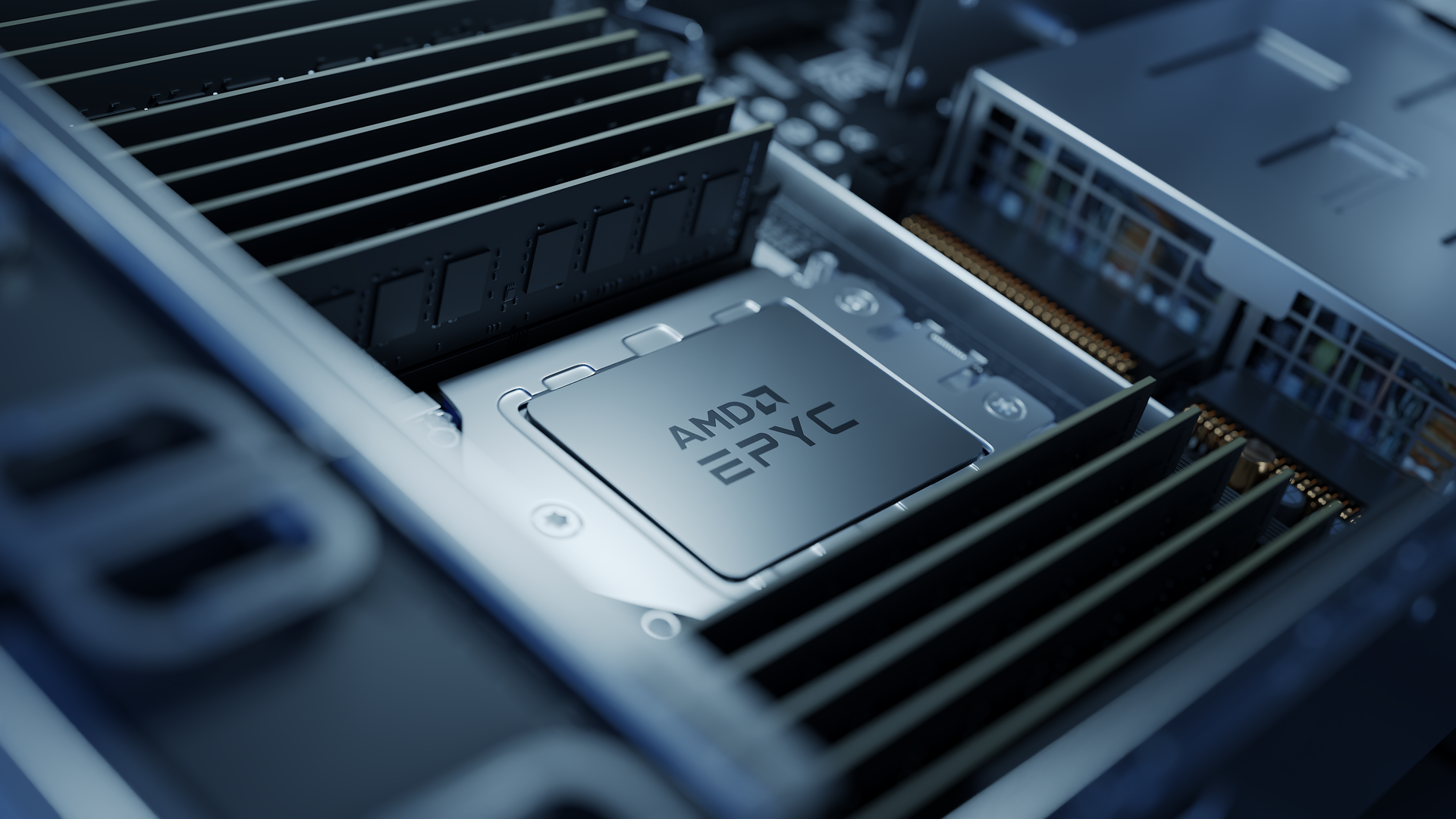

Ostatecznie optymalizacja chmury nie powinna być traktowana jako cel sam w sobie, ale jako stale towarzyszący proces. Na przykład Oracle Cloud i Google przedstawiły nowe rozwiązania działające w oparciu o najnowsze procesory AMD EPYC 5. generacji. Firma Oracle poinformowała z kolei, iż jej najnowsze instancje w standardzie E6 zapewniają do 33% więcej mocy obliczeniowej i pamięci oraz 2-krotnie większą przepustowość sieciową w porównaniu z E5, co przekłada się na choćby 2-krotnie wyższą wydajność wg branżowych benchmarków. Jednocześnie testy Google Cloud wykazały, iż nowe maszyny wirtualne C4D dzięki wykorzystaniu możliwości architektury AMD „Zen 5” pozwalają uzyskać choćby o 80% wyższą przepustowość w przeliczeniu na jeden na wirtualny CPU niż system poprzedniej generacji.

Ewoluująca technologia stojąca u podstaw chmury obliczeniowej daje przedsiębiorstwom, które priorytetowo traktują modernizację swojej infrastruktury, możliwość korzystania na bezproblemowej skalowalności i odporności tak potrzebnych dla przyszłych innowacji. Jest to także kolejny krok na drodze zrównoważonego rozwoju. W świecie, w którym kluczowa jest elastyczność, optymalizacja chmury nie jest już luksusem, ale imperatywem biznesowym, aby zachować konkurencyjność w 2025 roku i później.