Intel szczegółowo opisał swoją linię procesorów nowej generacji Xeon Data Center na 2024 rok, która będzie obejmować Granite Rapids i Sierra Forest.

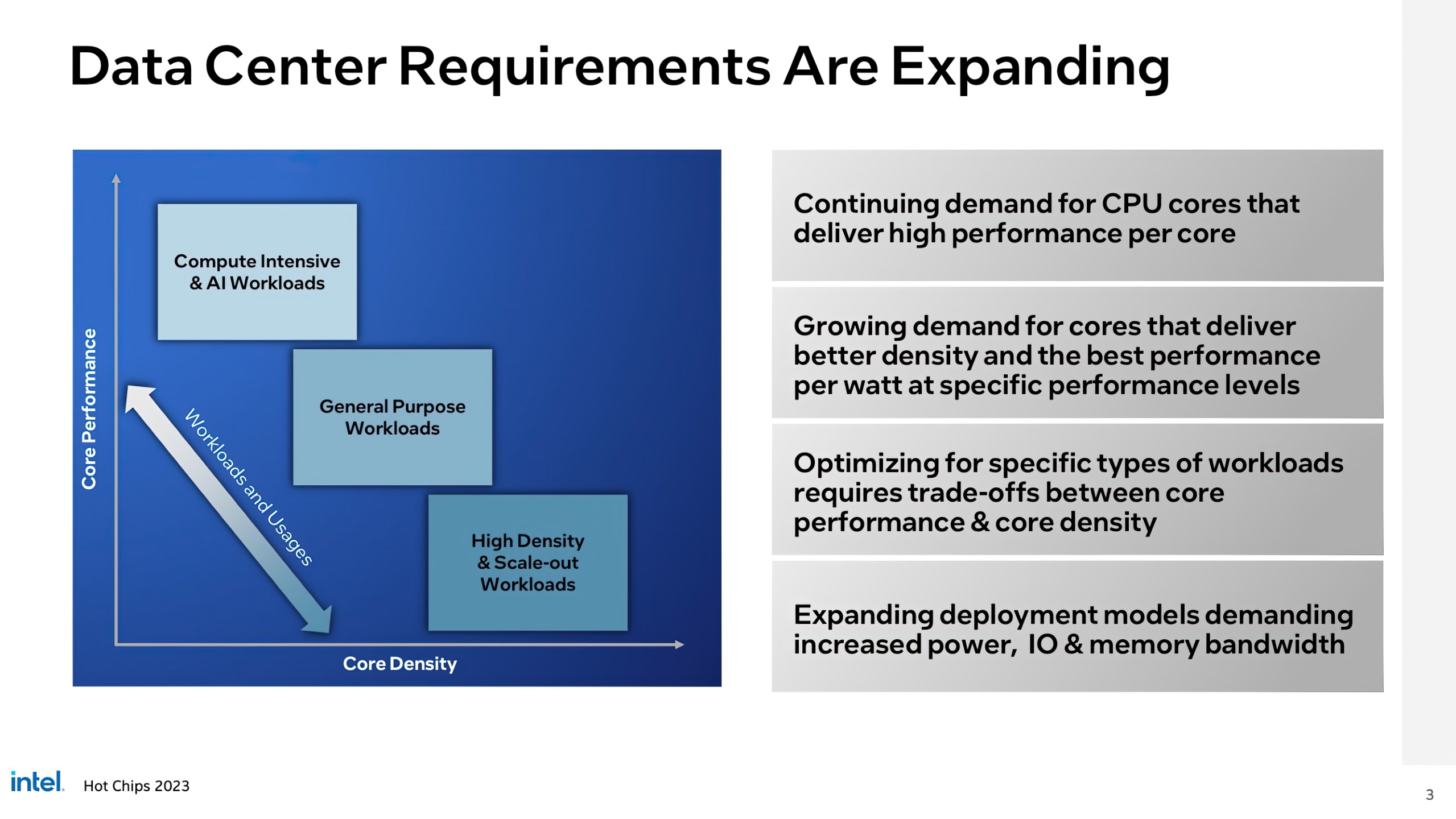

Konferencja HotChips 2023 rozpoczęła się od wyjaśnienia przez firmę Intel, w jaki sposób potrzeby nowoczesnych centrów danych rosną i stają się coraz bardziej skoncentrowane na obciążeniach roboczych. Można mieć wiele różnych obliczeń HPC, AI, o dużej intensywności obliczeniowej, wysokiej gęstości i ogólnego przeznaczenia, co oznacza, iż jeden typ rdzenia nie zawsze jest najlepszym wyborem do wykonywania wszystkich tych zadań. W związku z tym Intel zobowiązał się już do zaoferowania własnej odpowiedzi na strategię AMD Zen 4 i Zen 4C, która obejmuje procesory Xeon z rdzeniami P-Core i E-Core.

Procesory z rdzeniami P-Core Xeon należą do rodziny Granite Rapids, która jest zoptymalizowana pod kątem intensywnych obliczeń i obciążeń związanych ze sztuczną inteligencją, podczas gdy procesory z rdzeniami E-Core Xeon należą do rodziny Sierra Forest i są zoptymalizowane pod kątem wydajności w obciążeniach o dużej gęstości i skalowalności. Obie rodziny procesorów mają wspólną podstawę platformy i wspólny stos oprogramowania, co oznacza, iż są one kompatybilne ze sobą na tych samych platformach.

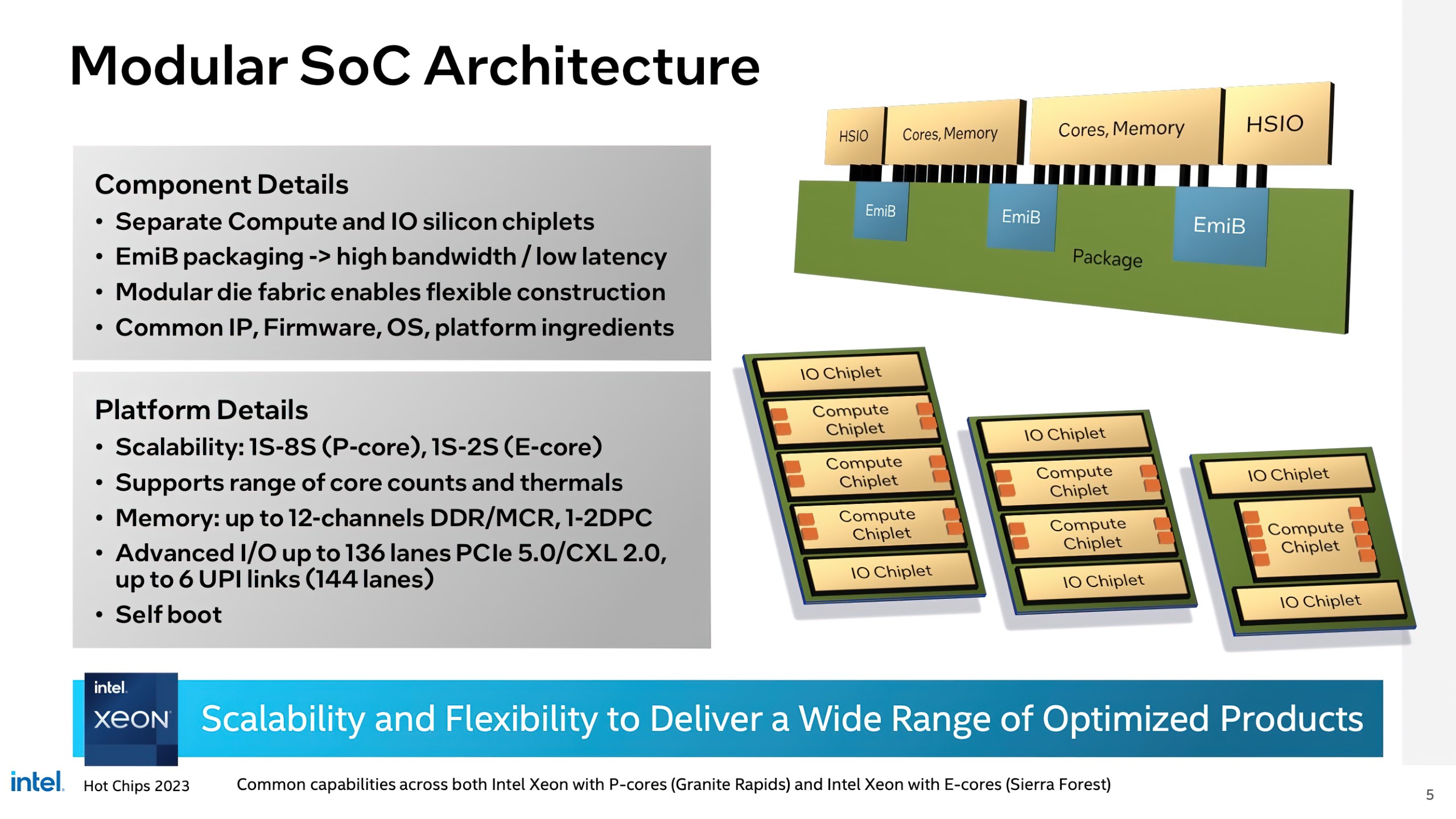

Zagłębiając się w aspekty modułowości nowej generacji architektury SoC, Intel szczegółowo opisuje, w jaki sposób procesory Xeon, zwłaszcza Granite Rapids, będą wyposażone w oddzielne chipy obliczeniowe i krzemowe IO. Chiplety te będą połączone ze sobą dzięki struktury EmiB w tym samym pakiecie, oferując wysoką przepustowość i niskie opóźnienia ścieżek.

Mówiąc o platformie, procesory Intel Granite Rapids-SP Xeon będą skalowane na platformach 1S i maksymalnie 8S, podczas gdy chipy Sierra Forest będą skalowane na rozwiązaniach 1S i maksymalnie 2S. Oba procesory będą miały szereg jednostek SKU ze zmienną liczbą rdzeni i docelowymi parametrami termicznymi. Platforma CPU Xeon nowej generacji będzie również obsługiwać do 12-kanałowej pamięci DDR/MCR (1-2DPC), do 136 ścieżek PCIe Gen 5 z 6 łączami UPI (CXL 2.0).

Niektóre jednostki SKU pokazane jako rendery dają nam wgląd w trzy możliwe konfiguracje, które obejmują pojedynczą jednostkę obliczeniową z dwoma chipletami IO, konfigurację z dwoma chipletami obliczeniowymi i dwoma chipletami IO, a także topową konfigurację z trzema chipletami obliczeniowymi i dwoma chipletami IO.

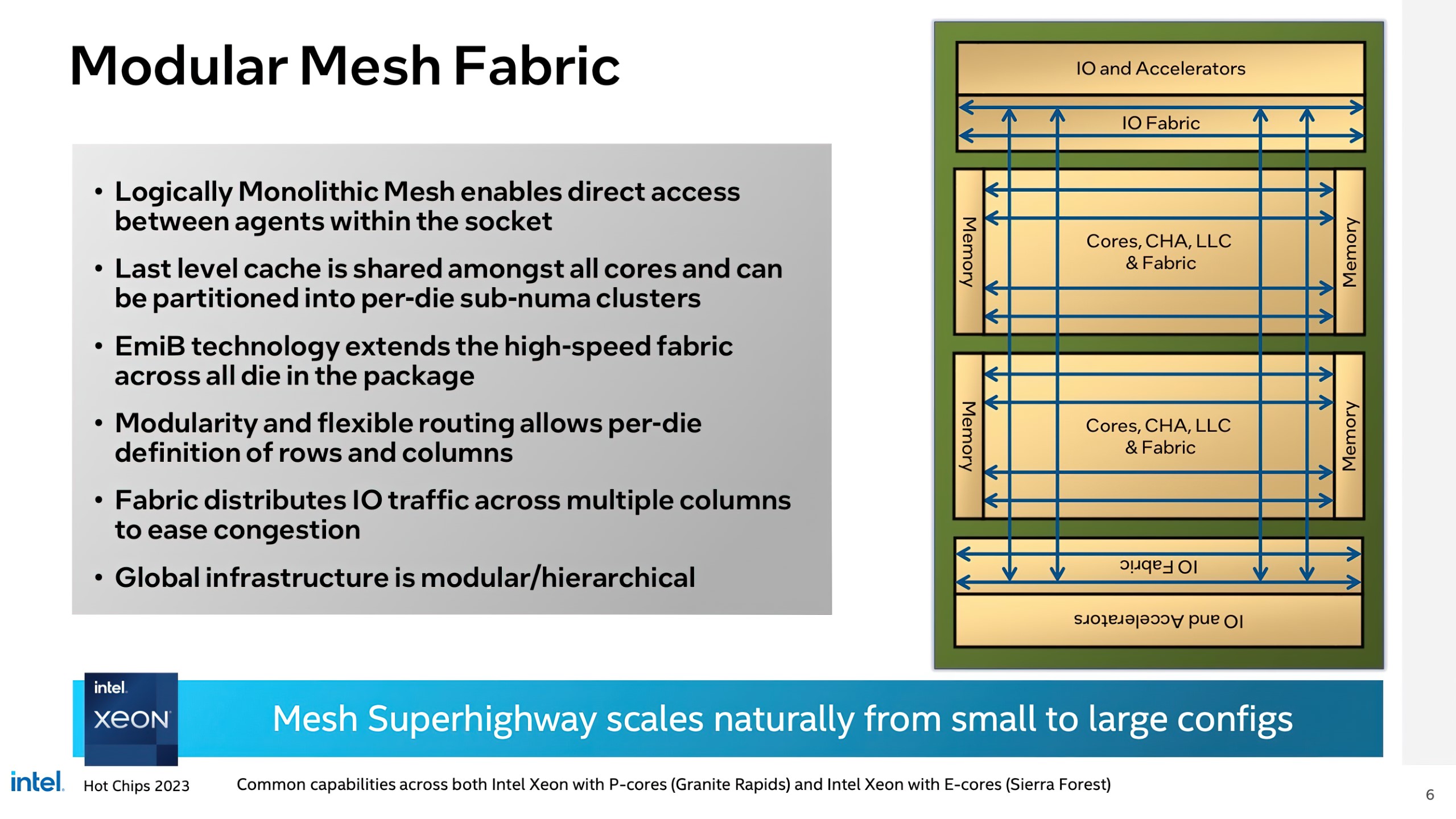

Intel będzie korzystał z modułowego systemu mesh, aby uzyskać dostęp do wszystkich chipletów:

- Logicznie monolityczna siatka umożliwia bezpośredni dostęp między modułami w gnieździe.

- Pamięć podręczna ostatniego poziomu jest współdzielona przez wszystkie rdzenie i może być podzielona na klastry per-die (jednostka obliczeniowa).

- Technologia EmiB rozszerza szybką strukturę na wszystkie matryce w pakiecie.

- Modułowość i elastyczny routing umożliwiają definiowanie wierszy i kolumn per-die.

- Wewnętrzna struktura dystrybucji rozdziela ruch IO na wiele kolumn, aby zmniejszyć przeciążenia.

- Globalna infrastruktura jest modułowa/hierarchiczna.

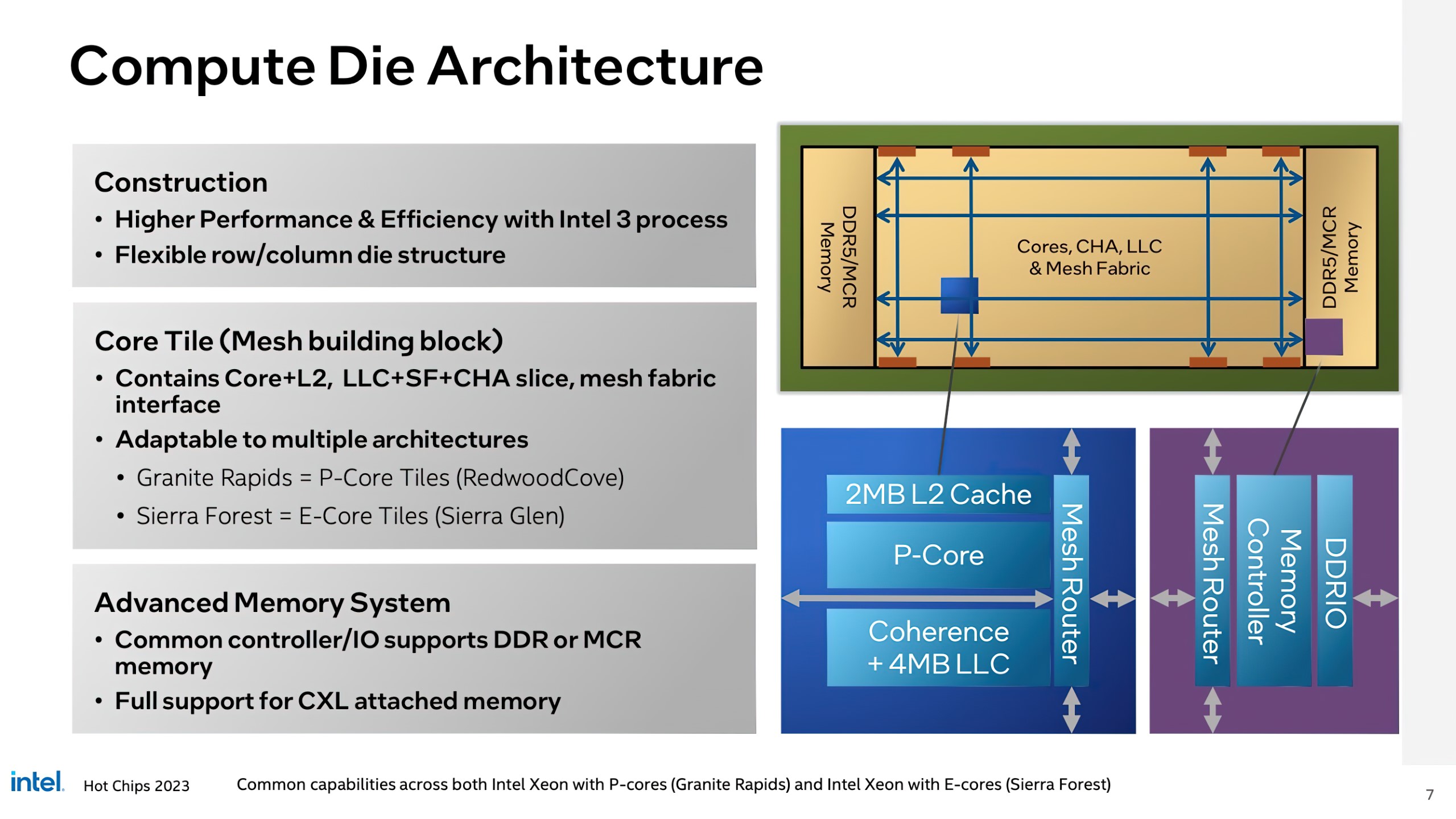

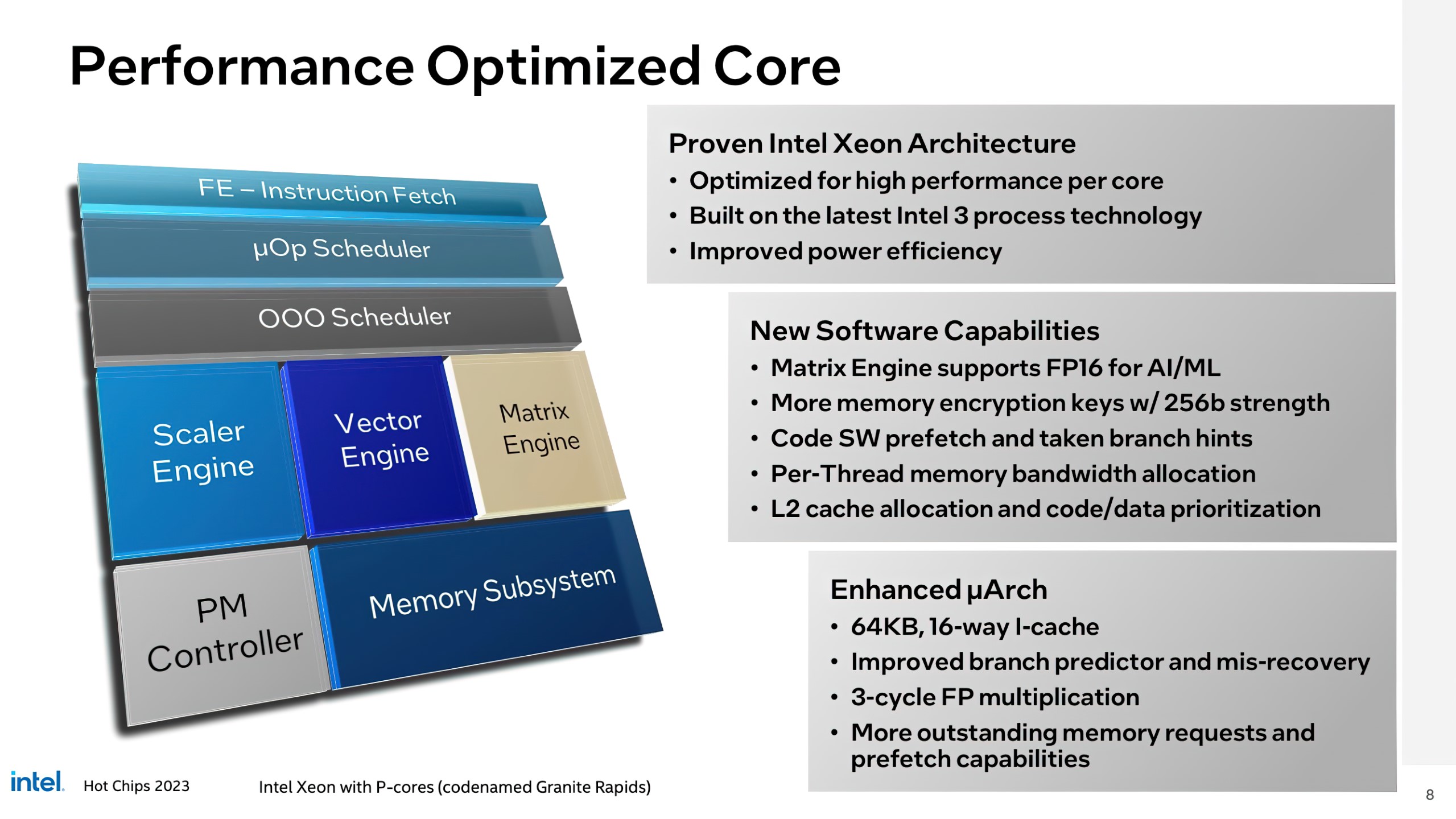

Jednostka obliczeniowa w układach Intel Xeon Granite Rapids ma na celu zwiększenie wydajności i efektywności poprzez wykorzystanie najnowszego węzła procesowego Intel 3, a także umożliwienie elastycznej struktury wierszy/kolumn. Sam Core Tile będzie składał się z rdzeni CPU opartych na architekturze Redwood Cove i pamięci podręcznej L2, LLC+SF+CHA slice oraz interfejsu mesh fabric.

Core Tile można dostosować zarówno do rdzeni P-Core, jak i E-Core. Ponadto, na tej samej jednostce znajduje się podsystem pamięci Advanced Memory, który oferuje wspólny kontroler/IO i pełne wsparcie dla pamięci CXL.

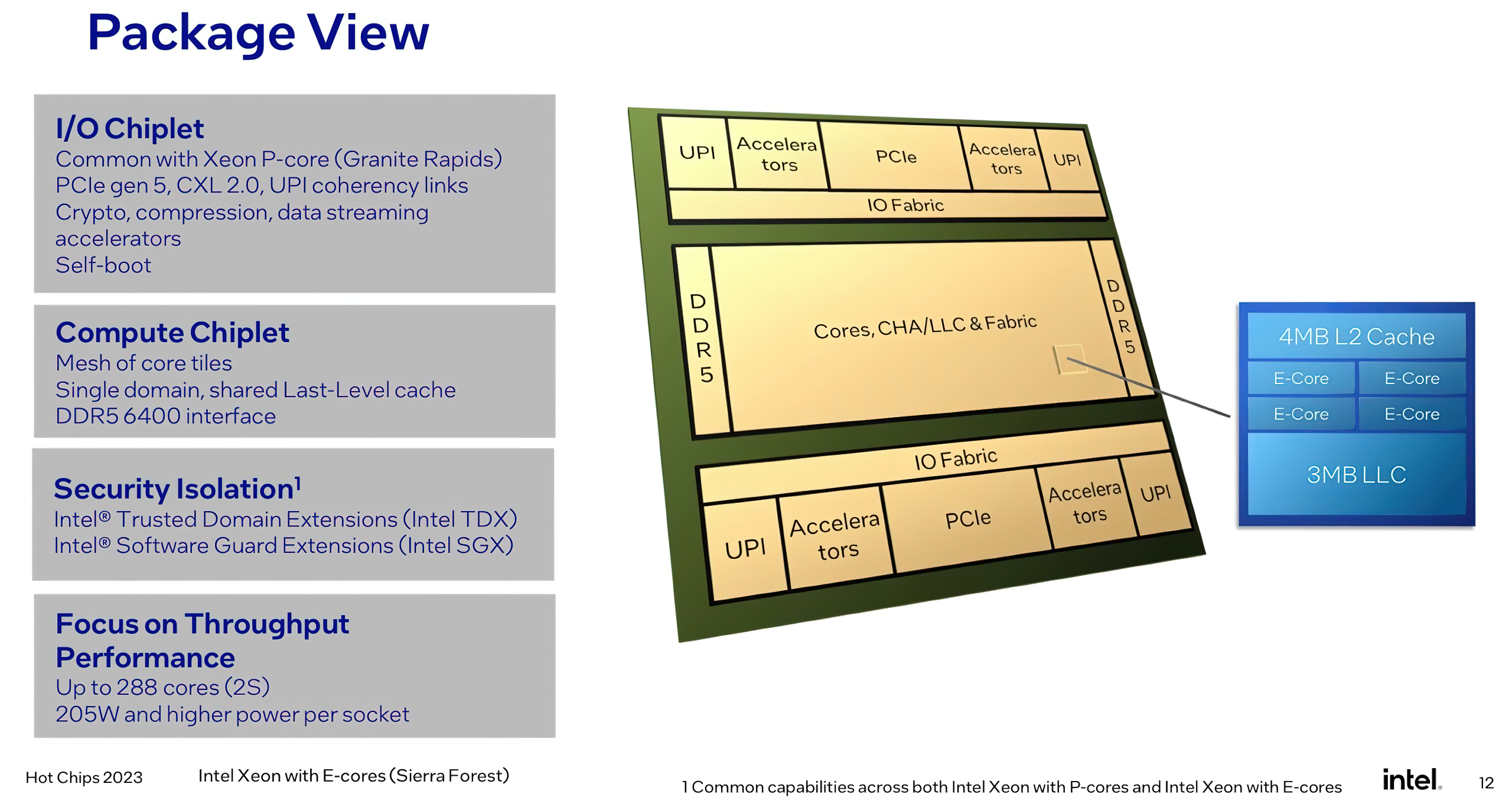

Procesory Intel Xeon z rdzeniami E (Sierra Forest) zostały udoskonalone, aby zapewnić obliczenia zoptymalizowane pod kątem gęstości w najbardziej energooszczędny sposób. Procesory Xeon z rdzeniami E zapewniają najlepszą w swojej klasie gęstość mocy i wydajności, oferując wyraźne korzyści dla obciążeń natywnych dla chmury i hiperskalowych.

- 2,5x lepsza gęstość w szafie i 2,4x wyższa wydajność na wat.

- Obsługa serwerów 1S i 2S, z maksymalnie 144 rdzeniami na procesor i TDP na poziomie zaledwie 200 W.

- Nowoczesny zestaw instrukcji z solidnymi zabezpieczeniami, wirtualizacją i AVX z rozszerzeniami AI.

- Podstawowe funkcje RAS pamięci, takie jak sprawdzanie maszynowe i ECC pamięci podręcznej danych w standardzie we wszystkich procesorach Xeon.

Procesory Intel Xeon z rdzeniami P (Granite Rapids) zaprojektowano z myślą o zapewnieniu najniższego całkowitego kosztu posiadania (TCO) w przypadku obciążeń wymagających wysokiej wydajności rdzeni i obciążeń obliczeniowych ogólnego przeznaczenia. w tej chwili Xeon zapewnia lepszą wydajność AI niż jakikolwiek inny procesor, a Granite Rapids jeszcze bardziej zwiększy wydajność AI. Wbudowane akceleratory zapewniają dodatkowy impuls dla ukierunkowanych obciążeń, zapewniając jeszcze większą wydajność i efektywność.

- 2-3x lepsza wydajność dla mieszanych obciążeń AI.

- Ulepszony Intel AMX z obsługą nowych instrukcji FP16.

- Większa przepustowość pamięci, liczba rdzeni i pamięć podręczna dla obciążeń wymagających dużej mocy obliczeniowej.

- Skalowalność gniazd od jednego do ośmiu.

W przypadku Sierra Forest, rodziny Intel E-Core Xeon, kafelki rdzenia procesora będą oferować 2-4 rdzenie na moduł, które będą wykorzystywać współdzieloną pamięć podręczną L2, współdzieloną matrycę częstotliwości/napięcia oraz współdzielony interfejs mesh fabric. Każdy rdzeń jest jednowątkowy, co daje nam 144 rdzenie i 144 wątki w topowej jednostce SKU Compute Tile upakowanej w 36 rdzeniowych kafelkach. Wycinek LLC jest współdzielony przez wszystkie rdzenie w gnieździe i oferuje potok o wysokiej przepustowości. Daje nam to do 144 MB pamięci podręcznej L2 i 108 MB LLC.

Zgodnie z aktualną strategią, procesory Intel Emerald Rapids Xeon 5. generacji zostaną wprowadzone na rynek w czwartym kwartale 2023 roku, a następnie Sierra Forest w pierwszej połowie 2024 roku, a niedługo po nich pojawi się rodzina Granite Rapids z rdzeniem P-Core.