Chcesz pogadać ze swoją kartą graficzną GeForce? Możesz uruchomić swojego osobistego chatbota AI na domowym komputerze i trenować LLM dzięki NVIDIA Chat With RTX. I to wszystko lokalnie, bez wysyłania cennych danych do chmury.

Układy odpowiedzialne za obliczenia związane z AI znajdziemy już nie tylko w kartach graficznych, ale i procesorach. Takie rozwiązanie ma wiele zalet, ale chyba najważniejsza jest taka, iż nie musimy naszych danych wysyłać do internetu. Bo co się z nimi później dzieje, tego nie wie chyba nikt. jeżeli więc trenowanie modeli AI dzięki narzędzi działających w chmurze nie wchodzi w rachubę, pozostaje nam tylko skorzystanie z systemu działającego lokalnie i wykorzystującego zasoby naszego komputera.

Z pomocą przychodzi firma NVIDIA ze swoim oprogramowaniem NVIDIA Chat With RTX, które to w pełni wykorzysta możliwości tkwiące w rdzeniach Tensor (obliczenia związane z AI). Jak na razie program dostępny jest w wersji demo i można go pobrać i używać całkowicie za darmo.

Dobra, ale co w ogóle potrafi NVIDIA Chat With RTX? Personalizować duże modele językowe GPT na podstawie twoich danych (dokumentów, tabel z danymi czy filmów). Chat With RTX wykorzystuje generowanie RAG i TensorRT-LLM. Po prostu nakarm chatbota danymi i zadawaj mu pytania.

NVIDIA Chat with RTX – wymagania i instalacja

Aplikacja stworzona przez firmę NVIDIA zadziała oczywiście tylko na kartach GeForce, a i to nie na wszystkich modelach. NVIDIA Chat with RTX wymaga karty GeForce RTX serii 3000 lub 4000 z co najmniej 8 GB pamięci graficznej. Ponadto na komputerze z co najmniej 16 GB pamięci musi być zainstalowany system Windows 11 oraz sterowniki GeForce w wersji 535.11 (lub nowsze).

Jeśli spełniasz te wymagania możesz się już udać na dedykowaną stronę NVIDIA Chat With RTX AI i pobrać oprogramowanie (rozmiar pliku to około 35 GB). Pamiętajcie, iż jest to wciąż wersja demo, ale mimo wszystko warto się z nią zapoznać już teraz.

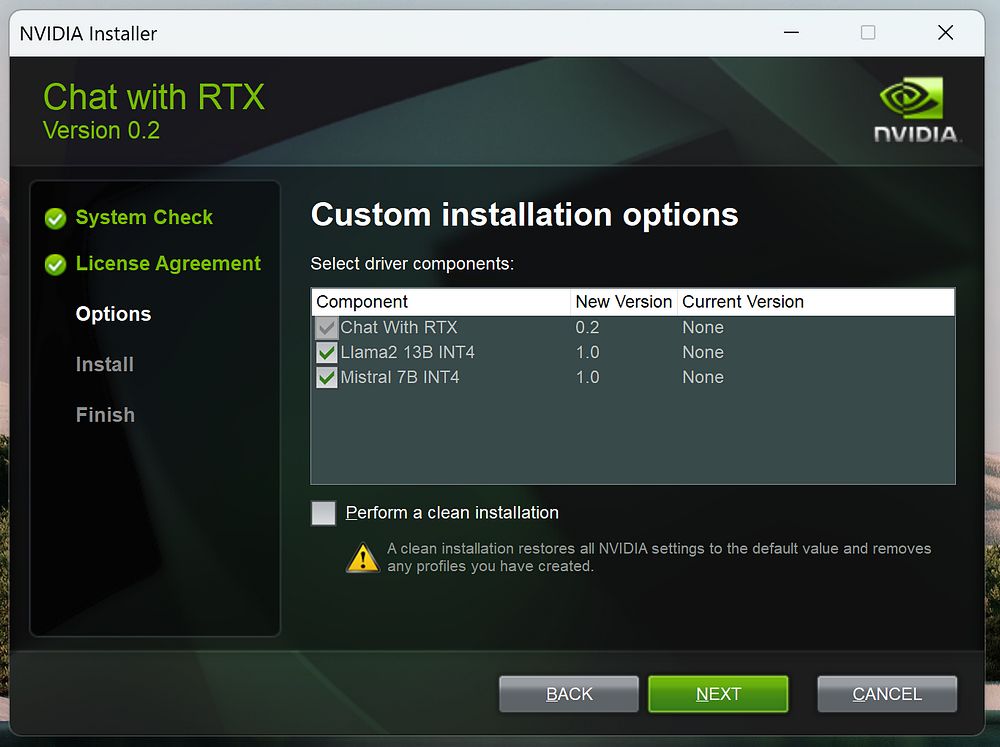

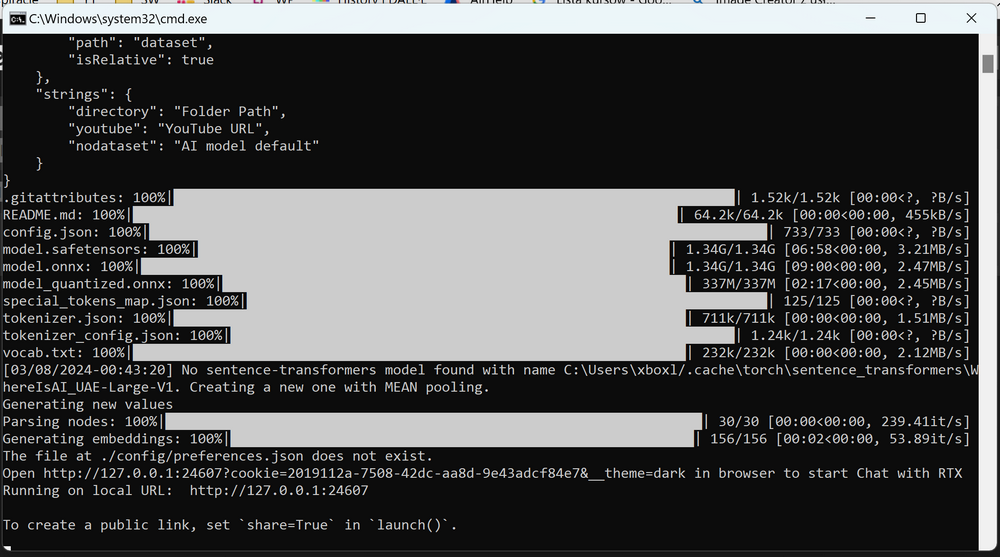

Chętnych na pobranie nowego narzędzia NVIDII jest chyba sporo, bo serwery wyglądają na mocno obciążone. Gdy już pobierzesz całe archiwum .zip należy je rozpakować i uruchomić instalator. To niestety nie koniec pobierania – w kolejce czekać będzie jeszcze choćby pakiet CUDA.

Gdy będzie ci się wydawać, iż jesteś już na końcu procesu, czekać cię będzie jeszcze krótka (czas prawdopodobnie zależy od twego sprzętu) przerwa na obliczenia i…

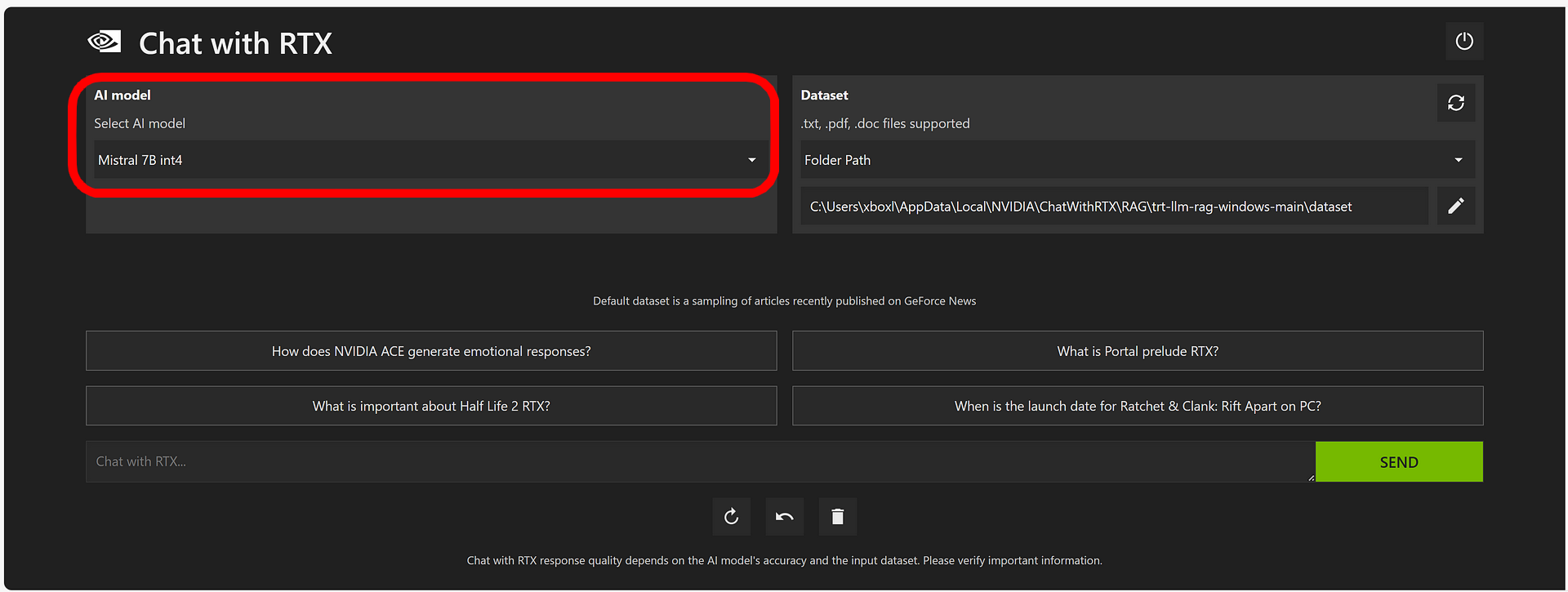

W końcu uruchomisz NVIDIA Chat With RTX. Program jest dopiero w wersji 0.2, a więc bardzo wczesnej. Jego obsługa nie należy do skomplikowanych – po lewej stronie wybiera się model AI (Mistral bądź Llama) a po prawej ścieżkę do danych z których ma korzystać bot..

Jakie rodzaje plików można podpiąć pod chatbota NVIDII? Jak na razie możliwe jest wykorzystanie plików PDF, DOC/DOCX oraz XML. Nie trzeba dodawać każdego pliku oddzielnie, wystarczy wskazać folder. Przy pierwszym uruchomieniu program automatycznie sięgnie do pobranych danych i podsunie przykładowe pytania jakie można zadać botowi (lub wpisać własne). Potem wystarczy kliknąć przycisk Send.

A co z obsługą wideo? W tym przypadku można podać adres filmu na YouTube i odpytywać chatbota z jego zawartości (jak na razie odbywa się to na podstawie transkrypcji).

Zobacz oprogramowanie w akcji na krótkim filmiku który udostępniła NVIDIA:

Zobacz inne tematy związane ze sztuczną inteligencją:

NVIDIA Chat With RTX to jedne z pierwszych narzędzi tego typu, ale niewątpliwie niedługo nadejdą następne – potrafiące choćby wykorzystać NPU (Neural Processing Unit) w procesorach Intel Core Ultra (Meteor Lake).

Twój lokalny bot AI na sprzęcie firmy AMD (Ryzen i Radeon)

Jeśli chodzi o NPU znajdujące się w procesorach AMD Ryzen (Phoenix) i rdzenie AI w kartach Radeon, to firma AMD umożliwiła już uruchomienie bota AI na tym sprzęcie. Po szczegóły odsyłamy na oficjalny blog AMD – instalacja nie jest specjalnie skomplikowana.