Ponad dwa lata temu umieściłem na tym blogu wpis na temat uczenia maszynowego, zwanego marketingowo AI (sztuczną inteligencją; SI, jeżeli ktoś woli po polsku). Krytykowałem tam sposób opowiadania o tym zjawisku w mediach.

Pokazywałem, iż pewne metody istniały od dawna, ale pod bardziej neutralnymi nazwami, jak właśnie uczenie maszynowe. Zaś słowo inteligencja wpleciono dopiero później, mimo iż nie powstało nic rewolucyjnego. prawdopodobnie po to, żeby uatrakcyjnić metodę w oczach ludzi.

Na bazie tej mylącej nazwy powstało wiele sztucznych oczekiwań. Bańkę pompują startupy, próbując wabić inwestorów. Oraz media, naganiając czytelników na reklamy. Ich podejście jest krótkowzroczne i może doprowadzić do rozczarowań. Tak myślałem wtedy i tak myślę nadal.

Ale muszę przyznać, iż postępy w ostatnich latach mnie zaskoczyły. Modele tworzące treści stały się naprawdę niezłe. Przez co popularna obawa „AI zabierze mi pracę” wydaje się coraz bardziej uzasadniona.

Ktoś mógłby powiedzieć, iż to niespójne – skoro w AI nie ma prawdziwej inteligencji, to nie przewyższy człowieka. A skoro go nie przewyższy, to również nie zastąpi.

Obawiam się jednak, iż poprzeczka dla algorytmów jest zawieszona niżej niż poziom człowieka. I obniżana na siłę przez kadry kierownicze dużych firm.

Ci ludzie w swoich motywacjach i działaniach sami bowiem przypominają automaty. Tak do nich, jak i do AI, można odnieść pewien eksperyment myślowy zwany maksymalizatorem spinaczy. I to właśnie zrobię w tym wpisie.

Zapraszam!

Źródła: mem Stonks, asystent Clippy od Microsoftu, Deviantart.

Aranżacja moja (bez żadnego AI!).

Spis treści

- Inteligencji tu nie ma

- Algorytmy jak blender

- Wpadki, nie wrogość

- Przypadek Binga

- Maksymalizatory spinaczy

- Maksymalizatory w zarządzie

- Maksymalizatory niższego szczebla

- Chęć kontroli

- Wpływ na wybrane zawody

- Podsumowanie

Inteligencji tu nie ma

Zanim opowiem, czym w ogóle jest ten maksymalizator, ustalmy pewne ramy i wyjaśnijmy jedną podstawową kwestię. AI to nazwa marketingowa na określony rodzaj programów. Nie stoi za tym inteligencja taka jak u istot żywych.

Mówię rzeczy oczywiste? Dla niektórych niestety nie:

Tomek

To samo AI które wyrżnie kiedyś ludzi bo zda sobie sprawę ze przyczyną wszystkich złych rzeczy na tej planecie jesteśmy my. Na cholerę komu ta technologia.Źródło: Facebook, nie zapisywałem dokładnego.

Francesco

Just like Chat GPT; this ain’t AI, but it’s nice to pretend, huhGreen?????????

@Francesco Uh, I don’t know if you know this but AI means Artificial Intelligence, It is a manmade version of someone/something that is capable of thought, Neuro-sama is indeed capable of thought, not to the extent of humans, and her memory is shit, but she is still able to think, and say thingsŹródło: YouTube, komentarze pod filmem. Lekka korekta moja.

„AI potrafi myśleć”. „AI zda sobie sprawę”. „Ma jeszcze słabą pamięć, ale myśli”.

I to nie tylko wypowiedzi losowych, może małoletnich internautów. Coś o świadomości generatorów tekstu palnął choćby jeden z pracowników Google’a (jak się okazało – przynależący do sekty).

Istnieją ludzie, którzy na serio stosują taką personifikację. Moim zdaniem samo słowo inteligencja, dodane na siłę, ponosi za to sporą winę. Bo sugeruje coś, czego tam nie ma. A medialna narracja i zdjęcia humanoidalnych robotów tylko pogarszają sprawę.

Algorytmy jak blender

Wyobraźmy sobie, iż mamy blender kielichowy.

![]()

Źródło: mynamepong (strona Flaticon).

Prosta rzecz, prawda? Wkładamy coś do kielicha, przytrzymujemy guzik. Ostrza potną to, co jest w środku.

Znamy też ogólne zasady. Nie wkładać rzeczy zbyt twardych. Czyścić czasem kielich, bo inaczej będziemy mieli smoothie z pleśnią. Wtyczka ma być wpięta do kontaktu.

Ale czy bylibyśmy w stanie symulować w głowie, jak dokładnie to działa? Trajektorie wszystkich odbijających się składników, ich przyspieszenia? Siłę, z jaką uderzają o ścianki? Zmiany położenia każdego kawałka po zderzeniu z innym, odbitym?

Nie, i nie musimy. Nie trzeba rozumieć procesu na poziomie mikro, żeby znać jego ogólny przebieg i czerpać z niego korzyści.

I podobnie jest z algorytmami nazywanymi AI.

Kiedy czytamy w mediach „naukowcy nie rozumieją, jak to działa”, to nie chodzi o to, iż ich umysły są bezsilne wobec jakieś nowej, cyfrowej świadomości. A jedynie o to, iż obliczenia są zbyt złożone dla ludzkich mózgów. Ale człowiek jest w stanie z grubsza przewidzieć efekt końcowy.

O ile oczywiście przyjmie poprawne założenia. W przeciwnym razie może się zdarzyć spektakularny, nieprzewidziany błąd. Tak w blenderze, jak i w algorytmie.

Może w urządzeniu coś się poluzowało od częstego korzystania, a nam przypadkiem wpadła jakaś twardsza rzecz. Jak kawałek skorupy orzecha.

Naciskamy guzik, jak wiele razy wcześniej. A tu iskry! Ostrze odpada, odbija się od ścianki kielicha, jesteśmy w szoku.

Algorytmy też takie bywają. Potrafią sprawnie działać w większości przypadków, a potem spektakularnie nas zaskoczyć.

Wpadki, nie wrogość

Spójrzmy dla rozluźnienia na parę historycznych przypadków takich spektakularnych wpadek:

- Rozpoznawarka obrazu z Dysku Google’a oznaczyła pewną parę tagiem „goryle”.

-

W Chinach system rozpoznawania twarzy uznał, iż znana celebrytka stoi na środku ulicy. Za co ukarano ją mandatem.

Problem? Nie stała tam. Było to tylko jej zdjęcie z reklamy umieszczonej na boku autobusu. - Podczas pewnego meczu kamera miała automatycznie podążać za piłką.

Ale zamiast tego skupiała się na czymś innym o zbliżonym kształcie – łysej głowie sędziego.

Błędy zaskakujące, nieoczekiwane. Ale dające się wyjaśnić. Często brakiem danych treningowych z jakiejś niszowej kategorii.

Nikt nie wpadł na to, żeby algorytm rozpoznający okrągłe kształty dostał próbkę łysych głów. Ale jeżeli zostanie wytrenowany od nowa, już z kompletem łysin, to prawdopodobnie zacznie prawidłowo je odróżniać od piłek.

Niemożliwy jest z kolei przypadek, kiedy nasz blender nagle puści ogień z dołu i poleci w kosmos. Albo powie nam ludzkim głosem, iż nie chce mu się pracować. Ograniczają go prawa fizyki i brak odpowiednich części. Pewne rzeczy są po prostu niemożliwe.

I tak samo nie jest możliwe, iż w tej chwili stosowane algorytmy zaczną myśleć i celowo działać przeciw nam.

Co nie zmienia faktu, iż bywają zawodne. A jednak są masowo, bezrefleksyjnie wypuszczane w świat. Mimo iż istnieje wielka rozbieżność między tym, czym są naprawdę, a tym, czym są w oczach zwykłego człowieka.

Co więcej – już teraz powierza im się sprawy wrażliwe, jak ocenianie ludzi. Albo służenie im za źródło informacji o świecie, czego przykładem jest Bing.

Przypadek Binga

Bing to wyszukiwarka od Microsoftu, konkurent Google’a. Ich produkt od bardzo dawna pozostawał w tyle, i to mimo licznych zabiegów zachęcających ludzi do korzystania z niego.

Dlatego, gdy tylko pojawiła się możliwość, nawiązali współpracę z OpenAI, autorami modeli serii GPT – nowoczesnych generatorów tekstu. od dzisiaj chętni mogą zadawać wyszukiwarce pytania, a ta, zamiast wyświetlić listę stron, wyświetli tekst z odpowiedzią… tylko iż czasem fałszywą.

Nie byłby to pierwszy przypadek, kiedy Microsoft pospieszył się z wprowadzaniem algorytmów do swoich produktów. Kiedyś wypuścili na Twittera chatbota nazwanego Tay, ale skończyło się to spektakularną klapą. W ciągu doby ludzie przechytrzyli system i sprawili, iż zaczął tworzyć treści wulgarne i mocno niepoprawne politycznie.

Bingowi trzeba przyznać, iż tworzy piękne, prawidłowe zdania. Brzmi mądrze i pewnie.

Ale to tylko cienka fasada, a model potrafi tymi mądrymi i pewnymi zdaniami przekazywać bzdury. Nie radzi sobie z arytmetyką. Potrafi się pomylić w najprostszych obliczeniach:

150 000 x 0,7 [centa] - 475 = 600 $

A powinno tam być 575 dolarów. Dlaczego ta rzekoma sztuczna inteligencja robi tak elementarne błędy?

Bo to model językowy. Nie wnioskuje matematycznie, a liczby nie są dla niego żadną specjalną kategorią. Patrzy na nie jak na każdy inny tekst.

„Gdzieś były bardzo podobne znaczki i stało przy nich 600, więc teraz też to wyświetlę”. Logika modelu.

A ponieważ to dość nowoczesny model, to nie robi gaf spektakularnych, jak nagłe wymieszanie liczb z literami albo podanie wyniku ujemnego.

To usypia naszą czujność. Wszystko brzmi wiarygodnie, moglibyśmy prawie uwierzyć, iż stoi za tym świadomość. Ale to mylne założenie, na którym ludzie jeszcze nieraz się przejadą.

W takich warunkach sugerowanie jakiejś inteligencji – i, co gorsza, nadawanie automatom konwersacyjnego tonu – wydaje się niezbyt odpowiedzialne. Więc dlaczego różne firmy (bo Microsoft jest jedną z wielu) tak się na to rzuciły?

Maksymalizatory spinaczy

Historyjka o maksymalizatorze spinaczy to taki luźny, stosunkowo popularny eksperyment myślowy.

Wyobraźmy sobie, iż mamy sztuczną inteligencję zdolną ingerować w świat fizyczny. Ale bez obaw, nie jest wroga. Jej jedynym celem istnienia jest wytworzenie jak największej ilości spinaczy biurowych.

Brzmi nieszkodliwie? Ale gdyby ta SI wszystkie swoje działania optymalizowała tylko pod ten jeden cel, to mogłoby się na przykład okazać, iż na którymś etapie zacznie brakować jej zasobów. Więc po prostu zabierze je ludziom. Albo choćby przekształci ich samych w materię, z której uda się stworzyć więcej spinaczy.

Nie ma w tym moralności, zła czy dobra. Maszyna nie uwzględnia tych kwestii. Ona po prostu realizuje określone wytyczne. „Ma być jak najwięcej spinaczy”. Reszta nie ma znaczenia.

Ten przypadek ilustruje, iż do katastrofy nie potrzeba robotów-złoczyńców, którymi kieruje jakaś chęć dokuczenia ludziom. Wystarczy wydajna machina, której konfiguracja nie pokrywa się z interesem ludzkości.

Przykładem takiego maksymalizatora może być oczywiście AI. Ale nie tylko. Bezmyślne maksymalizatory znajdziemy czasem w zarządach wielkich firm.

Choć mam w temacie parę własnych przemyśleń, w żadnym razie nie jestem autorem porównania. Znalazłem je w kilku miejscach:

- w niektórych komentarzach z forum HackerNews, takich jak chociażby ten;

- we wpisie z tuxen.de, Companies are AI;

- w artykule z Buzzfeed News (o tym portalu jeszcze będzie).

Maksymalizatory w zarządzie

Nieprzypadkowo piszę o „wielkich firmach”. Nie chodzi tutaj tylko o moją antypatię do korporacji (choć jej nie ukrywam), tylko po prostu o to, iż pod wieloma względami różnią się od firm mniejszych.

Niektórym się wydaje, iż zarząd to zawsze to samo. Właściciele firm, decydujący o ich losach. I często faktycznie tak jest, zwłaszcza przy małych firmach. Ale nie jest to żadna reguła.

Ważniejsze od stanowiska są bowiem posiadane udziały. Jeśli ludzie z zarządu mają mniejszość udziałów, to są de facto pracownikami. Dobrze wynagradzanymi, ale pracownikami. I mogą zostać odwołani, jeżeli nie spełnią oczekiwań udziałowców.

Takie coś zauważymy w spółkach giełdowych, ale nie tylko. Również startupy, w które inwestują fundusze VC (venture capital), mają przykazane – muszą rosnąć. I to błyskawicznie, bo inaczej finansowanie się skończy, a inwestorzy zaczną pompować nowego, atrakcyjniejszego jednorożca.

Zarząd ocenia się według różnych metryk, nie ma tutaj reguły (od jakiegoś czasu patrzy się na przykład na kryteria ESG). Ale jedną z klasycznych miar jest zysk, jaki wygenerowała firma w danym roku.

Jeśli ktoś jeszcze nie wie – zysk to przychody minus koszty.

Załóżmy, iż dostaliśmy w prezencie książkę. Przeczytaliśmy i chcemy komuś sprzedać. Płacimy 6 zł za bilet na komunikację, jedziemy do umówionego miejsca, sprzedajemy książkę za 20 zł.

Nasz przychód to 20 zł, ale ponieśliśmy 6 zł kosztów, więc zysk to 14 zł.

Kierownictwo nastawione na zysk może go zwiększać na dwa sposoby.

Jednym z nich jest zwiększanie przychodów. Może przez zdobywanie nowych rynków, może poszerzanie oferty, może zwiększenie obecnych cen.

Ale niektórzy patrzą na to od drugiej strony. Zamiast zwiększyć przychód, można zmniejszyć koszty. „Odchudzić” firmę. Choćby przez zwolnienie pracowników, użycie tańszych materiałów, znalezienie tańszych podwykonawców za granicą. Albo automatyzację.

Zresztą sami spójrzmy, co ma do powiedzenia o AI strona dla menedżerów:

Obserwując potencjał innowacyjny sztucznej inteligencji z jej możliwościami automatyzacji, można śmiało postawić tezę, iż właśnie ten kierunek może być ratunkiem i szansą dla firm, tak jak digitalizacja w pandemii. W końcu nie od dziś wiadomo, iż to właśnie technologia pozwala firmom obniżać koszty, wspierając jednocześnie nowe sposoby konkurowania i tworzenia nowej przewagi konkurencyjnej.

Źródło: post MIT Sloan Management Review Polska na Facebooku

I tak, na dłuższą metę firma może się przejechać na redukcji kosztów. Staje się zależna od innych, psuje sobie reputację.

Ale na papierze oba rozwiązania prowadzą do tego samego. Atrakcyjniejszej wartości w polu Zysk.

Liczba spinaczy wzrosła, jest dobrze. A inne rzeczy się nie liczą. Pracownicy zarządzający przetrwają parę lat pod rząd z dobrym wynikiem, zdobędą premię. A potem mogą zmienić firmę.

Maksymalizatory niższego szczebla

To samo dotyczy również menedżerów niższych szczebli. Też są oceniani według bardzo konkretnych kryteriów. Mówiąc korpojęzykiem – kejpiajów (od. KPI, czyli Key Performance Indicators).

To niekoniecznie zyski, kryteria mogą być inne. Ale możecie być pewni, iż niektórzy myslą jak maksymalizatory spinaczy. I jakie by nie były te kryteria, właśnie pod nie będą optymalizowali swoje działania.

Przykładem jest wybieranie projektów o ciekawszych nazwach zamiast nudniejszych prac „konserwacyjnych”. Wysyłanie bzdurnych uwag, żeby zwiększyć współczynnik visibility.

Fundamenty korodują… Ale gmach rośnie w górę. Spinaczy coraz więcej.

Maksymalizatory w ludzkiej skórze są podatne na wpływy. jeżeli jakaś zewnętrzna firma obiecuje im automatyzację przez AI, to dla menedżera brzmi to idealnie. „Znaczne usprawnienie i streamlining całego procesu”! Taki wyczyn w CV to gwarancja kariery!

A zatem menedżer kupuje system, nakazuje wdrożenie. Rozsyła do pracowników ankiety z prośbą o ocenę. A tu lipa, bo system jest niedopracowany, ciągle trzeba po nim sprawdzać, tylko spowolnił pracę.

W takiej sytuacji niejeden menedżer się zaniepokoi, zapoci, zaśmierdzi. Ale nie można dać po sobie poznać. Good vibes only, trzeba mieć mindset.

Wysyła nową, tendencyjną ankietę. Pytania zamknięte. „W jaki sposób nowy system poprawił twoją pracę? Ułóż wymienione zalety w kolejności od tej, którą doceniasz najbardziej”.

Potem przedstawia wyniki ankiet, zadowolony wpisuje do CV wymarzone uwagi o usprawnieniu procesu. Po jakimś czasie zmienia dział, zostawiając pracowników z całym bajzlem.

Chęć kontroli

Innym powodem, dla którego kierownictwo różnych szczebli sięga po metody AI, może być również chęć zacieśnienia kontroli nad pracownikami.

Jednym z przykładów jest Amazon, który wykorzystał metody AI do śledzenia swoich kierowców w USA – ciągłego monitorowania, czy ziewają w pracy, czy są skupieni, jak się zachowują, jak jeżdżą. Wszystko to, jak twierdzi ich rzeczniczka, dla lepszego bezpieczeństwa.

Ktoś mógłby powiedzieć, iż przecież Amazon słynie z brudnych zagrywek, więc nie jest jakimś szczególnie dobrym przykładem.

Ale Amazon nie jest jedyny. Jakiś czas temu wyszło na jaw, iż bank JP Morgan wprowadził nowy system monitorujący aktywność pracowników. Oczywiście oparty o kamery, czujniki i to nieszczęsne AI.

Analizuje on liczne parametry. Patrzy po ruchach myszki, czy pracownik jest aktywny. Ocenia widoczną na nagraniu twarz i mowę ciała. Jest skupiony? A może zestresowany?

A mówimy tutaj o wielkim banku inwestycyjnym. Kojarzącym się niektórym z prestiżem, specjalistami, pracą umysłową na wysokich obrotach. Jak widać, możliwość kontroli jest dla szefostwa cenniejsza niż ta reputacja.

Ale zostawmy już w spokoju nasze maksymalizatory w krawatach, myślę iż już wystarczająco po nich pojechałem. jeżeli zgodzicie się ze mną, iż sporo rzeczy wynika z ich fiksacji na mierzalnych wynikach, to parę rzeczy stanie się jasnych.

To dlatego są tak otwarci na automatyzację. Dlatego wypychają algorytmy na szybko, byle być first to market. Dlatego trzymają się nazw takich jak sztuczna inteligencja, obiecujących niestworzone rzeczy.

Nie ma w tym wielkich spisków. Tylko chęć zysku. Liczba spinaczy musi rosnąć.

Wpływ na wybrane zawody

W tej części pokażę parę przemyśleń związanych z wpływem AI na różne branże. Będę po kolei patrzył na zawody związane z tworzeniem treści, które do tej pory nie były jakoś szczególnie zagrożone.

W każdym przypadku pokażę najpierw, jakie próby standaryzacji i cięcia kosztów już wcześniej podejmowały korpo. A potem powiem, co mogą zmienić moim zdaniem coraz lepsze generatory.

Grafika

Za pewien przykład optymalizacji sprzed czasów sprawnego AI uważam forsowanie stylu nazywanego Corporate Memphis albo Alegria Art.

To proste kształty, pastelowe kolory. Postacie o nienaturalnych proporcjach i kolorach skóry (jak fiolet, zieleń…), żeby nikt nie zarzucił autorom dyskryminacji.

Ten styl miał też inną cechę – był prosty do tworzenia i przenośny. Gdy każda firma miała podobny, to łatwiej było zyskać zastępowalność grafików.

Jasne, firmy mogłyby postawić na unikalność, coś bliższego sztuce, bardziej dopasowanego do nich. Ale wybierały to, co robią inni, co jest jak wymienialne bateryjki.

A jak to było z generatorami obrazu? Już kiedyś tworzyły całkiem realistyczne ludzkie twarze. Albo koty, już z różnym efektem (This Cat Does Not Exist). Modeli było sporo, ale każdy miał jedną, wąską dziedzinę, do której był przystosowany. Graficy byli bezpieczni.

Potem nastąpiła rewolucja. DALL-E – automat łączący w sobie rozpoznawanie tekstu i generowanie obrazu. My zapewniamy opis jakiejś sceny, a on ją tworzy.

Obrazki były w oczywisty sposób pokraczne, ale niektórzy uważali to za ich urok. Obietnica swobodnego, darmowego tworzenia ilustracji przyciągała jak magnes.

Krótko potem pojawiły się modele Midjourney oraz Stable Diffusion. Które nie tylko tworzą obrazy na podstawie opisów… ale do tego mogą tworzyć w różnych stylach, określonych przez użytkownika. I to całkiem nieźle. Do tego stopnia, iż jeden z nich wygrał konkurs fotograficzny.

Przykłady twórczości DALL-E Mini (u góry) i Midjourney (na dole).

Źródła: Aperiodical, Dataconomy.

Z jednej strony można podnieść argument, iż to pozwoli rozwinąć skrzydła ludziom, którzy niczego by nie stworzyli przez bariery finansowe. Mają pomysł, na przykład na grę, ale nie są na tyle pewni siebie, żeby płacić grafikom. AI zmienia tyle, iż daje im szansę. Mając darmowe obrazki, rozwiną pomysł.

Ale to tylko jedna strona medalu. Już teraz znajdziemy przypadki, kiedy ktoś wprost pisze, iż korzystał z usług ludzi, ale przechodzi na AI.

Skoro robią tak mniejsze działalności, to co powstrzyma wielkich graczy? Wielu z nich od dawna wystarczyła Alegria na masową skalę. A teraz mają ją prawie za darmo i w lepszej jakości. Ludzie mogą się burzyć, ale oburzenie nie jest uwzględniane przez maksymalizator.

Pisanie tekstów

Skupię się tu na ludziach tworzących teksty na komercyjne strony internetowe. Taka twórczość powinna zawierać odpowiednie słowa kluczowe, dzięki którym strona zajmie wyższe pozycje w wynikach wyszukiwania.

Ta branża już wcześniej była mocno optymalizowana. Przykładem są zwłaszcza strony zarabiające na wyświetlaniu reklam. Dla nich jakość nie ma aż takiego znaczenia. Liczy się tylko to, żeby użytkownik je odwiedził i spędził na nich trochę czasu.

W związku z tym powstawały strony pełne treści dopchanej na siłę, byle tylko algorytm je wyróżnił – jak słynne przepisy z dodatkiem bzdurnych historyjek. Czasem jest też jedna rzecz opisana na różne sposoby. Albo automatyczne tłumaczenie czegoś zagranicznego.

Dla użytkowników? Sieczka nie do zniesienia. Ale jeżeli weszli, długo przewijali w poszukiwaniu konkretów, reklamy się wyświetliły… To spinacze zmaksymalizowane. Zaś opcja, iż od dzisiaj będą unikali strony jak ognia, nie jest wliczona w metryki.

Logika podpowiada, iż generatory tworzące wiarygodny tekst, jak seria GPT, mogłyby kompletnie zmienić tę branżę.

„Napisz mi długą, wzruszającą historię o szarlotce Babci Eli. O tym, iż jedliście ją na wsi nad rzeką. A na końcu dodaj przepis na szarlotkę”. I już, nie trzeba nikogo zatrudniać. Jakość i tak nie miała większego znaczenia.

Postanowiłem poszukać naturalnych dyskusji na Reddicie. Hasło chat gpt copywriting site:reddit.com w DuckDuckGo. I trafiłem na wątek z dyskusją na temat wpływu ChatGPT na branżę.

Moderator go zamknął, pisząc iż to 476. wątek z kolei – jeżeli nie przesadzał, to może nam to dać do myślenia, jaka jest skala tego zjawiska i ludzkich obaw.

Tłumaczenia

Dawniej tłumaczenie maszynowe (przez komputer) było dziadowskie, zbyt dosłowne, „słowo po słowie”. Ale choćby to niektórym nie przeszkadzało. Po prostu kazali pracownikom tworzyć komunikaty, na przykład pogodowe, według ścisłego szablonu. W ten sposób tłumaczono je na masową skalę.

Kolejne, coraz lepsze algorytmy stopniowo zmieniały specyfikę pracy tłumaczy. Więksi, „korporacyjni” pośrednicy zaczęli tłumaczyć teksty maszynowo, a potem próbować je upchnąć tłumaczom do korekty (gorzej płatnej niż tłumaczenie od zera).

Jeśli chcemy dowodów, można poszukać wątków zawierających hasło PEMT (Post-editing Machine Translation) na forum Proz, jednym z głównych miejsc zrzeszających tłumaczy. Pierwsze są jeszcze z 2011 roku!

Ogólnie tłumaczenia wydają się branżą pełną niuansów, co fajnie (i po polsku!) opisał Informatyk Zakładowy.

Żeby komputer mógł wiernie tłumaczyć wszystko – w tym miksy gier słownych, nawiązań kulturowych, rymy – bardzo możliwe, iż musiałby dysponować inteligencją ogólną.

Ale ludzkie maksymalizatory z dużych firm nie miałyby nic przeciwko wywaleniu niuansów, jeżeli oznacza to oszczędności. Mogą nakazać tworzenie tekstów uproszczonych, szablonowych, nijakich. Byle tylko były lekkostrawne dla (coraz lepszych) algorytmów tłumaczących.

Obok nich dopisze się małymi literkami adnotację, iż informacje w nim zawarte nie są wiążące – dupochron na wypadek, gdyby algorytm coś przekręcił. I będzie good enough.

A w ocenie rocznej znajdzie się jedynie informacja o tym, iż maksymalizator menedżer skutecznie zredukował koszty tłumaczenia do zera.

Dziennikarstwo

Wydawać by się mogło, iż to zawód trudny do zastąpienia – o ile mówimy o dziennikarzach śledczych i korespondentach z prawdziwego zdarzenia. W końcu ta praca wymaga zbierania informacji, docierania do źródeł, często przemieszczania się po świecie fizycznym i rozmów w cztery oczy.

I faktycznie – gdyby poziom miał jakieś znaczenie, to generatory tekstu wyparłyby co najwyżej dziennikarstwo masowe, tabloidowe. Takie, w którym zarabia się na reklamach, więc liczą się wyłącznie krzykliwe nagłówki i wabienie użytkowników na stronę.

Ale niestety jest inaczej. Maksymalizuje się spinacze, a nie jakość. Dobrze nam to pokazuje przykład portalu Buzzfeed.

Miał on swego czasu dwa oblicza. Sam główny Buzzfeed, czyli powszechnie wyśmiewane artykuły spamowe. „Jakim jesteś serkiem na grilla? Sprawdź nasz quiz!” i tym podobne treści.

Ale oprócz tego mieli dział Buzzfeed News. Rzetelniejsze wiadomości i dziennikarstwo śledcze. Niektóre reportaże zdobyły choćby Nagrodę Pulitzera.

Redakcja zaczęła używać algorytmów do generowania tych bardziej spamowych, tabloidowych treści.

W idealnym świecie mielibyśmy na tym etapie happy end. Ludzie nie tracą czasu w tworzenie masówki. A masówka przynosi zyski, dzięki którym może działać redakcja wyższej jakości.

Ale w świecie ludzkich maksymalizatorów jest inaczej. Szefostwo zlikwidowało cały dział Buzzfeed News. Pozostawiając wyłącznie lukratywny, generowany komputerowo chłam.

Programowanie

Skoro świat coraz mocniej stawia na cyfryzację, to ten zawód wydaje się dość stabilny. Ale dla firm to koszty, więc oczywiście widać próby optymalizacji. Jednym z przykładów jest rozwój narzędzi low code i no code, ułatwiających tworzenie różnych programów bez pisania kodu.

Innym przykładem są masowe zwolnienia w ostatnim czasie, również w spółkach branży big tech. Proponuję przeszukać forum HN pod kątem zwrotu "lays off", z sortowaniem od najnowszych.

W czasach Covida przez moment zanosiło się na cyfrową rewolucję. Firmy technologiczne zaczęły masowo rekrutować ludzi. Teraz bańka się skończyła, niektórzy każą wracać do biur. A co teraz zrobić z nadmiarem pracowników? Można zwolnić! Mniejsze koszty, czyli większy zysk, wincyj spinaczy :metal:

I tak, wiem iż niektóre firmy choćby po redukcji mają znacznie więcej personelu niż przed Covidem.

Co nie zmienia faktu, iż masowa rekrutacja była owczym pędem. „Inni rekrutują, to też musimy. A teraz redukujemy”. Żadna branża nie jest wolna od maksymalizacji spinaczy.

A jeżeli chodzi o sprawy AI…

Pierwszym (według mojej wiedzy) popularniejszym generatorem kodu był Copilot. Oferowany przez Githuba, platformę zajmującą się przechowywaniem kodu źródłowego. Na jego podstawie stworzyli swój generator, wyświetlający podpowiedzi w trakcie pisania kodu.

Był podobno całkiem w porządku, ale nie uznawano go za rewolucję.

Większe poruszenie wywołały natomiast modele GPT od OpenAI.

Są one, przypominam, generatorami tekstu wszelakiego. Nie stworzono ich z myślą stricte o kodzie. A jednak radziły sobie naprawdę dobrze – pisało im się, żeby stworzyły kod robiący to i to, a one go tworzyły. Skądinąd poprawny. Pomijając przypadki, gdy kazały importować jakieś nieistniejące moduły.

Na razie niektórzy się cieszą, iż mają te same zarobki, a GPT pozwala im pracować szybciej. Ale gdy szefostwo to zauważy, to zastanowiłbym się nad trwałością tego stanu rzeczy.

Branża reaguje różnie. Niektórzy to pozytywni ludzie i mówią z uśmiechem, iż będzie co będzie. Już od jakiegoś czasu myśleli o własnym gospodarstwie.

Ale trafiają się też koguciki głoszące z pełną powagą „Rynek wytnie słabych, ale nigdy nie przestanie cenić Specjalistów” (w domyśle: właśnie ich, niezastąpionych, pracujących za ułamek pensji Amerykanina).

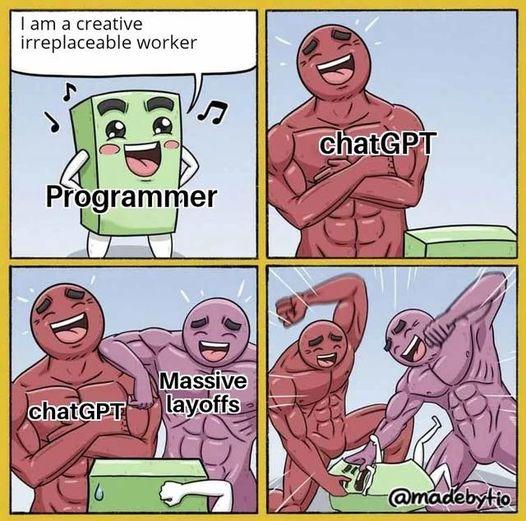

No cóż, ego nie przegadam :wink: Dlatego zostawię tu tylko jednego mema.

Podsumowanie

Cały ten wpis kręci się wokół jednego prostego pytania: „Czy sztuczna inteligencja zabierze mi pracę?”.

Moja odpowiedź – nie, nie zabierze. Ale mogą ją zabrać krawaciarze. Myślący krótkoterminowo, skupieni na wąskim zestawie metryk i własnych karierach. Maksymalizatory spinaczy z ludzką twarzą.

Pamiętajmy o tym. Wszystkie decyzje o zastępowaniu ludzi automatami są dziełem inteligencji ludzkiej. Bo w zarządach nie ma algorytmów – jeszcze.