Microsoft uruchomił największy w historii klaster GPU dla sztucznej inteligencji. Nowa infrastruktura Azure oparta na ponad 4 600 systemach Nvidia GB300 NVL72 z procesorami Blackwell Ultra ma wspierać obliczenia OpenAI i umożliwić trenowanie modeli z setkami bilionów parametrów w zaledwie kilka tygodni.

Największy klaster GPU w historii Microsoftu

Microsoft uruchomił pierwszy na świecie produkcyjny klaster Nvidia GB300 NVL72 na dużą skalę. W jego skład wchodzi ponad 4 600 systemów wyposażonych w układy Blackwell Ultra GPU połączone najnowszą siecią Nvidia Quantum-X800 InfiniBand o przepustowości 800 Gb/s na GPU.

To dopiero początek. Firma zapowiada, iż w ciągu najbliższych miesięcy liczba wdrożonych akceleratorów Blackwell Ultra sięgnie setek tysięcy, obejmując wszystkie globalne centra danych Azure. Celem jest radykalne skrócenie czasu trenowania modeli sztucznej inteligencji, z miesięcy do tygodni, oraz umożliwienie obsługi modeli liczących choćby setki bilionów parametrów.

„To ekscytujący krok w rozwoju tzw. frontier AI. System współprojektowany przez Microsoft i Nvidię ustanawia nowy standard w dziedzinie obliczeń przyspieszonych” – komentuje Ian Buck, wiceprezes ds. hyperscale i HPC w Nvidii.

Od Blackwell do Blackwell Ultra

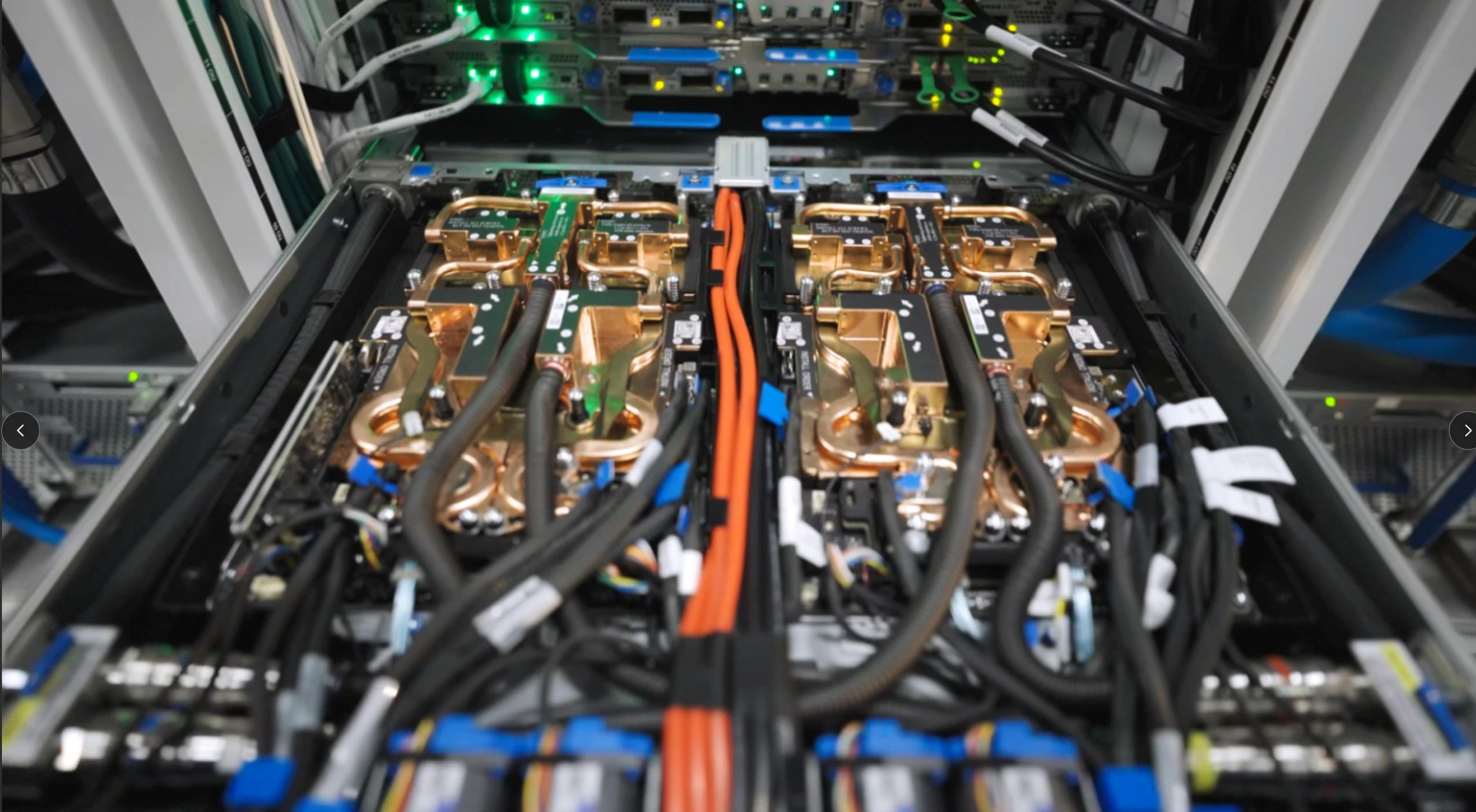

Każdy z serwerów GB300 NVL72 mieści 72 procesory graficzne Nvidia Blackwell Ultra oraz 36 procesorów Grace Arm, oferując do 1 440 petaflopsów mocy FP4 oraz 37 TB ultraszybkiej pamięci. Wewnątrz jednego racka NVLink i NVSwitch zapewniają przepustowość do 130 TB/s, co znacząco zmniejsza opóźnienia w dostępie do danych i zwiększa efektywność trenowania modeli multimodalnych oraz agentowych.

Każdy rack funkcjonuje jako spójna jednostka obliczeniowa o poborze mocy 142 kW, a połączenia między szafami oparte są na pełnej architekturze fat-tree, co gwarantuje minimalne opóźnienia i maksymalne wykorzystanie GPU. Microsoft podkreśla, iż opracował autorskie protokoły sieciowe i biblioteki kolektywne, które dodatkowo optymalizują komunikację między procesorami i zwiększają efektywność treningu dużych modeli.

Źródło: Microsoft

Nowe standardy chłodzenia i zasilania

Tak duże zagęszczenie mocy wymagało przeprojektowania infrastruktury od podstaw. Azure stosuje niezależne wymienniki ciepła oraz zaawansowane układy chłodzenia cieczą, które minimalizują zużycie wody, utrzymując stabilność termiczną przy ekstremalnych obciążeniach. Firma opracowała również nowe modele dystrybucji energii zdolne do obsługi dynamicznego bilansowania mocy w środowiskach o wysokiej gęstości energetycznej.

Równolegle z modernizacją sprzętu zaktualizowano też warstwy oprogramowania, systemy przechowywania danych, a orkiestrację i harmonogram zadań zoptymalizowano do pracy w skali superkomputera. Dzięki temu klaster osiąga niespotykaną wcześniej wydajność przy wysokiej efektywności energetycznej.

Globalna infrastruktura AI

Microsoft od lat inwestuje w rozwój infrastruktury AI, ale wdrożenie GB300 NVL72 jest przełomowe pod względem skali i tempa rozbudowy. W ciągu nadchodzących miesięcy podobne klastry mają zostać uruchomione w innych regionach świata. Według Microsoftu, nowa generacja maszyn Azure ND GB300 v6 stanie się standardem dla aplikacji AI wymagających ogromnej mocy obliczeniowej, od generatywnych modeli językowych po systemy rozumowania agentowego.

Dzięki współpracy z Nvidią i OpenAI, Azure umacnia swoją pozycję jako główna platforma do rozwoju tzw. frontier AI, czyli systemów zdolnych do przetwarzania i analizy danych w skali zarezerwowanej dotąd wyłącznie dla superkomputerów.