Od morderczych błędów w oprogramowaniu, przez zaawansowane strategie obrony przed ransomware, aż po rewolucyjną wizję biokomputerów opartych na żywych neuronach – tegoroczna edycja Pancernik IT Expo w Katowicach udowodniła, iż współczesne IT to arena nieustannej walki o cyberbezpieczeństwo, ale zarazem fascynujący wyścig ku technologicznej przyszłości.

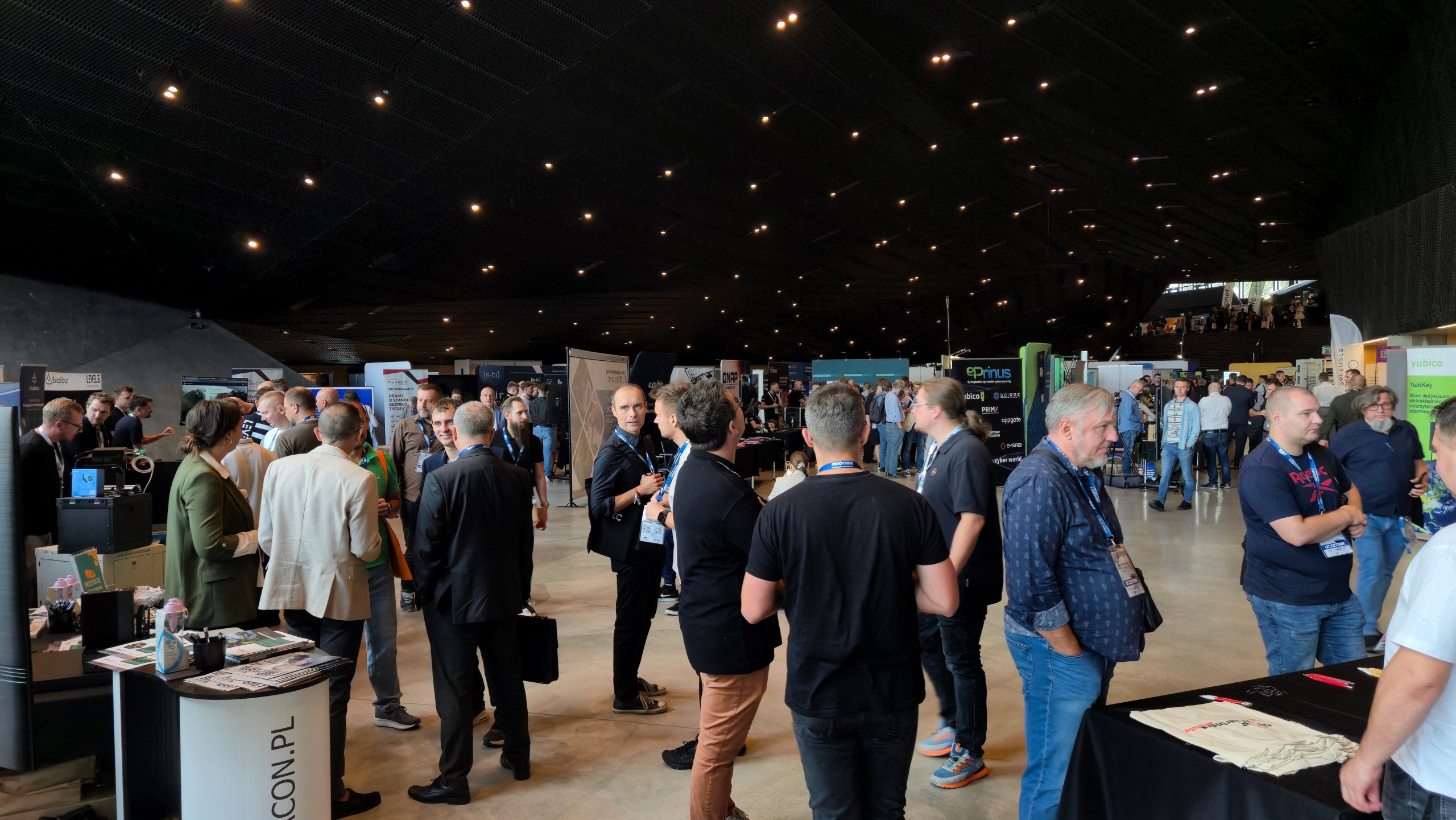

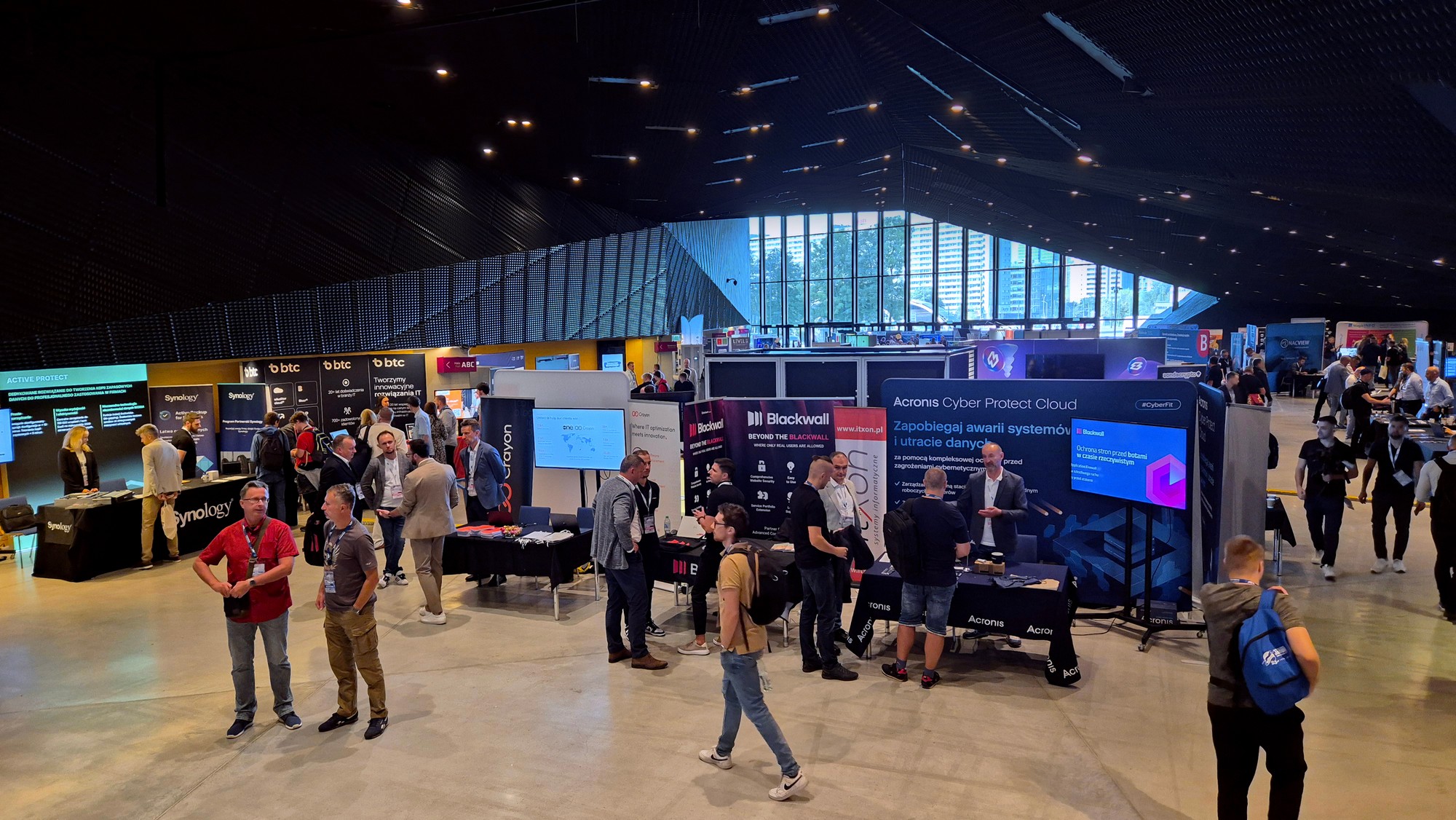

Dziewiątego września 2025 roku Międzynarodowe Centrum Kongresowe w Katowicach ponownie stało się sercem polskiej branży IT, a wszystko za sprawą kolejnej edycji Pancernik Security Show. Jako redakcja IT Reseller nie mogliśmy przegapić tego wydarzenia, by z bliska przyjrzeć się najnowszym trendom, rozwiązaniom i wyzwaniom, z jakimi mierzy się współczesny świat technologii. Wydarzenie, jak co roku, przyciągnęło tłumy specjalistów, oferując bogaty program wypełniony merytorycznymi prelekcjami, praktycznymi warsztatami oraz pokazami najnowszego sprzętu.

Ważnym elementem była również rozbudowana przestrzeń dla wystawców, gdzie czołowi producenci i dystrybutorzy prezentowali swoje rozwiązania sprzętowe i software’owe, koncentrując się przede wszystkim na kluczowym dziś obszarze cyberbezpieczeństwa IT. Tegoroczna agenda obfitowała w wystąpienia czołowych ekspertów, którzy poruszali szerokie spektrum tematów – od bezpieczeństwa sieci zarządzanych w chmurze, przez kompleksową ochronę ekosystemów Microsoftu, aż po rewolucyjne koncepcje biokomputerów opartych na ludzkich neuronach. W niniejszej relacji dzielimy się wrażeniami z najciekawszych pokazów i prelekcji, w których mieliśmy przyjemność uczestniczyć.

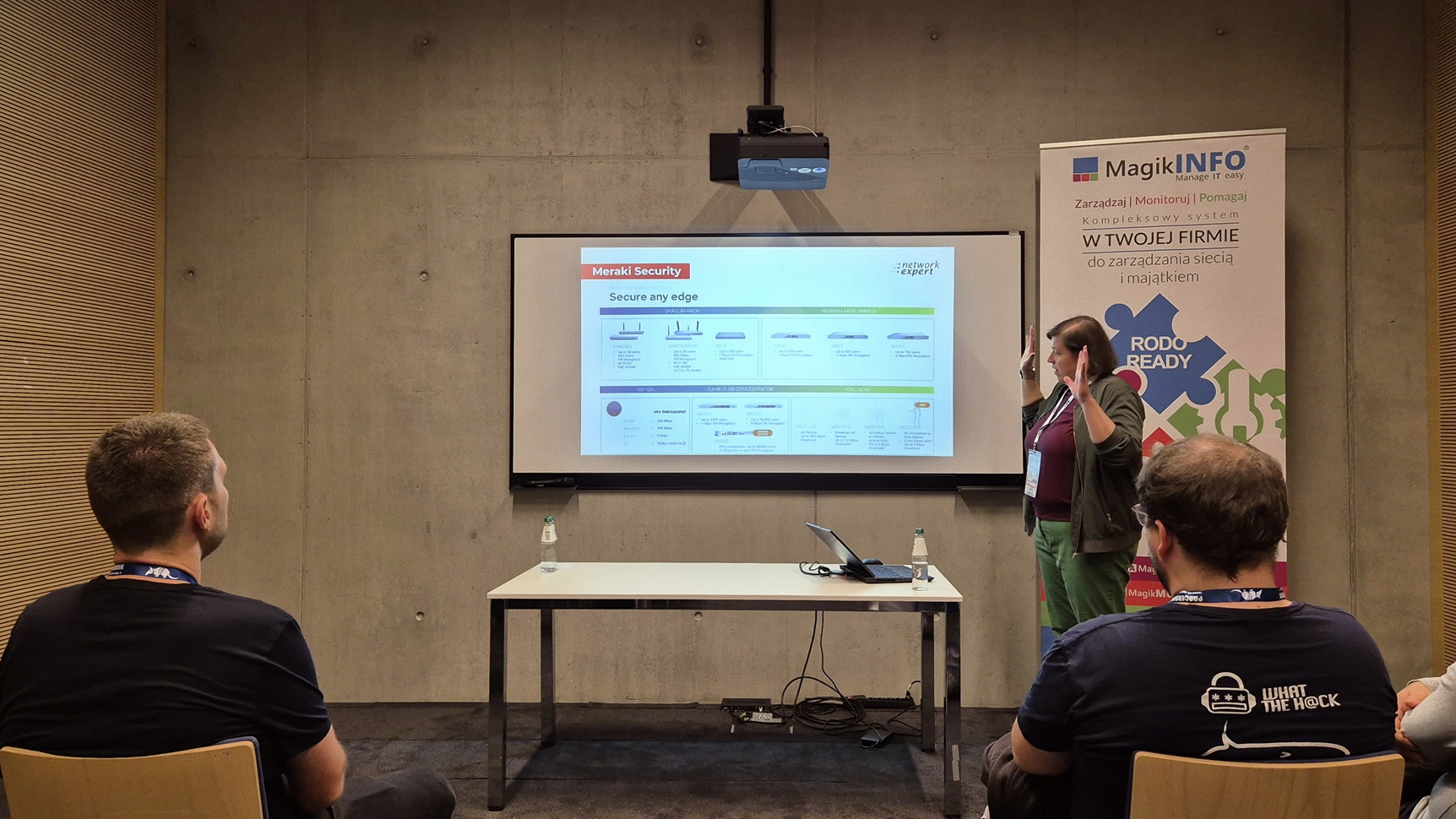

Network Expert – Cisco Meraki: Sieć zarządzana z chmury to nie tylko wygoda, ale i bezpieczeństwo

Podczas tegorocznej edycji Pancernik Expo, pierwszym z wykładów okazała się prezentacja poświęcona rozwiązaniom Cisco Meraki. Poprowadziła ją Maria Olszaniecka, Starszy Inżynier ds. Sieci w Network Expert, która w przystępny sposób przybliżyła filozofię i możliwości platformy, obalając przy tym kilka popularnych mitów.

Prelegentka podkreśliła, iż Cisco Meraki to kompletny ekosystem sieciowy – od firewalli, przez przełączniki i punkty dostępowe, aż po kamery i sensory IoT – zarządzany w całości z jednego, chmurowego dashboardu. To właśnie prostota zarządzania, eliminująca konieczność pracy z wierszem poleceń (CLI), jest jednym z głównych atutów platformy. Jednak, jak zaznaczyła Olszaniecka, trzeba pamiętać, iż za tą wygodą idzie obowiązkowy model licencjonowania – każde urządzenie wymaga aktywnej licencji do działania.

Ekspertka odniosła się też do jednej z najczęstszych obaw dotyczących rozwiązań chmurowych: prywatności danych. Wyjaśniła, iż w przypadku Meraki do chmury trafiają wyłącznie dane zarządcze, a nie rzeczywisty ruch sieciowy użytkowników. Co więcej, w razie awarii połączenia z chmurą, cała sieć lokalna przez cały czas działa nieprzerwanie, a jedynie chwilowo tracimy możliwość wprowadzania zmian w konfiguracji. Dla klientów w Europie centra danych zlokalizowane są w Niemczech, z zapewnionym mechanizmem przełączania awaryjnego.

Ciekawostką jest rosnąca integracja Meraki z klasycznymi rozwiązaniami Cisco. Nowsze przełączniki z serii Catalyst mogą być już monitorowane, a choćby w pełni zarządzane z chmurowego panelu Meraki. Daje to firmom elastyczność i możliwość stopniowego przechodzenia na model chmurowy bez konieczności wymiany całego sprzętu.

Prezentacja objęła również zaawansowane funkcje bezpieczeństwa, takie jak automatyczne zestawianie szyfrowanych tuneli VPN site-to-site (Auto VPN) czy integrację z systemami uwierzytelniania wieloskładnikowego, np. Cisco Duo. Maria Olszaniecka na praktycznym przykładzie pokazała też zastosowanie sensorów środowiskowych, które monitorując temperaturę w serwerowni, mogą uratować firmę przed kosztowną awarią sprzętu. Jak podsumowała, Meraki dawno przestało być “zabawką” i dziś jest dojrzałym, kompleksowym rozwiązaniem, które sprawdza się w najbardziej wymagających środowiskach – od biur, po zakłady produkcyjne i magazyny.

ARROW – Microsoft Defender: Bezpieczeństwo to nie tylko antywirus

Kolejnym istotnym głosem w dyskusji o cyberbezpieczeństwie okazała się prezentacja Wojciecha Jurka, inżyniera z firmy Arrow, który przybliżył podejście Microsoftu do tej materii. Na wstępie podkreślił, iż Arrow to globalny dystrybutor rozwiązań IT, a nie tylko partner Microsoftu — w portfolio firmy znajdują się również rozwiązania ttakie jak AWS, Fortinet czy Check Point. To istotny kontekst, pokazujący, iż prezentowane spojrzenie na ekosystem Microsoftu pochodzi od eksperta mającego szeroką perspektywę na rynek.

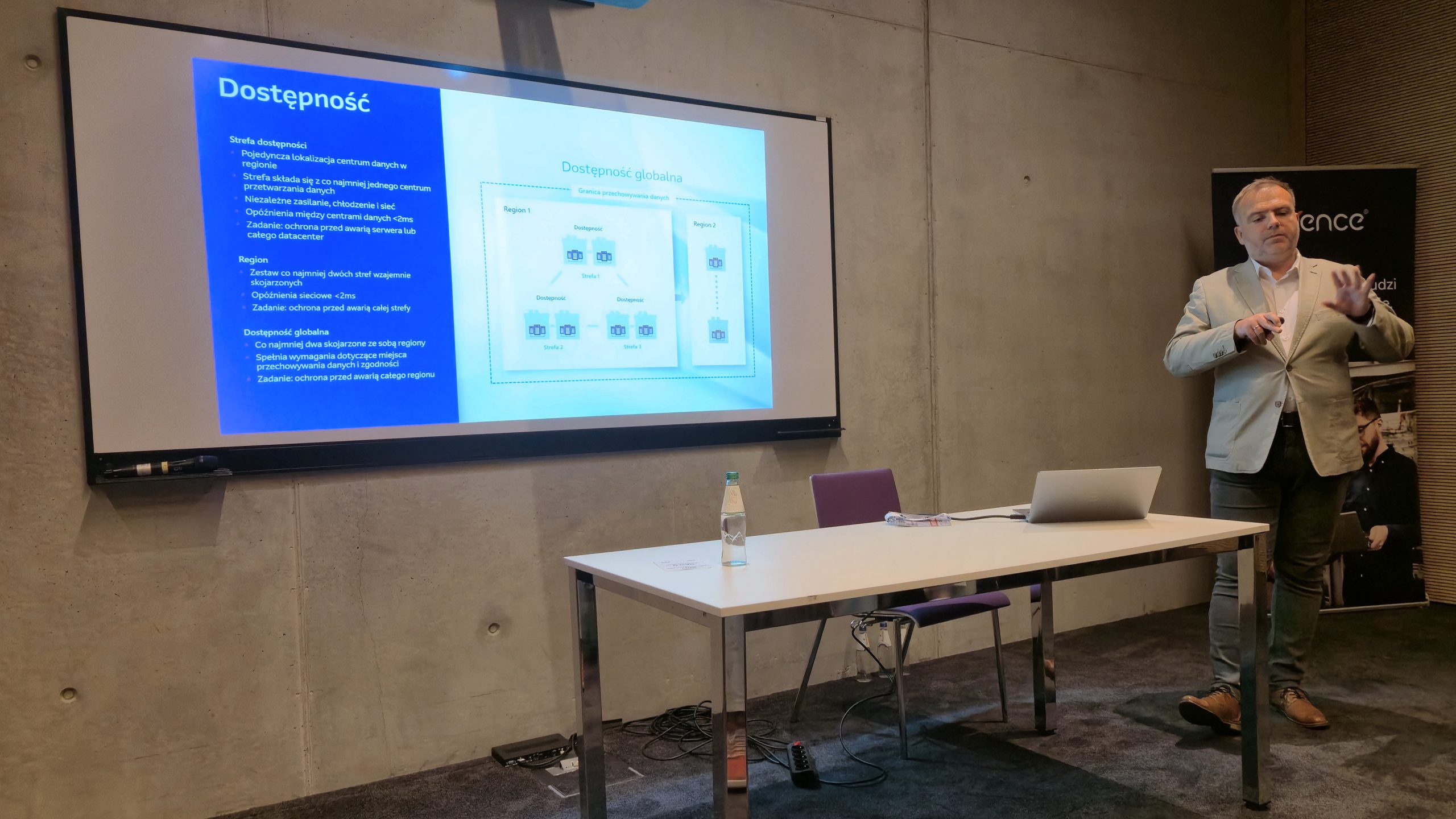

Prelegent argumentował, iż prawdziwe poczucie bezpieczeństwa w chmurze to coś więcej niż tylko ochrona przed złośliwym oprogramowaniem. To także gwarancja ciągłości działania, której fundamentem jest fizyczna infrastruktura. Jako przykład podał strategię Microsoftu, który w każdym regionie, w tym w Polsce, buduje niezależne centra danych, oddalone od siebie o kilkadziesiąt kilometrów. Zapewnia to redundancję na poziomie, na który mało która firma mogłaby sobie pozwolić samodzielnie.

Jurek zwrócił też uwagę, iż najsłabszym ogniwem w łańcuchu bezpieczeństwa pozostaje człowiek. Podzielił się anegdotą o wewnętrznym teście phishingowym z użyciem maila z „tańczącymi świnkami”. Mimo regularnych szkoleń, niemal połowa pracowników kliknęła w link, chcąc zobaczyć więcej animacji. To właśnie dlatego, jak tłumaczył, tak najważniejsze są rozwiązania takie jak Microsoft Defender for Identity, które analizują zachowania użytkowników, a nie tylko sygnatury wirusów.

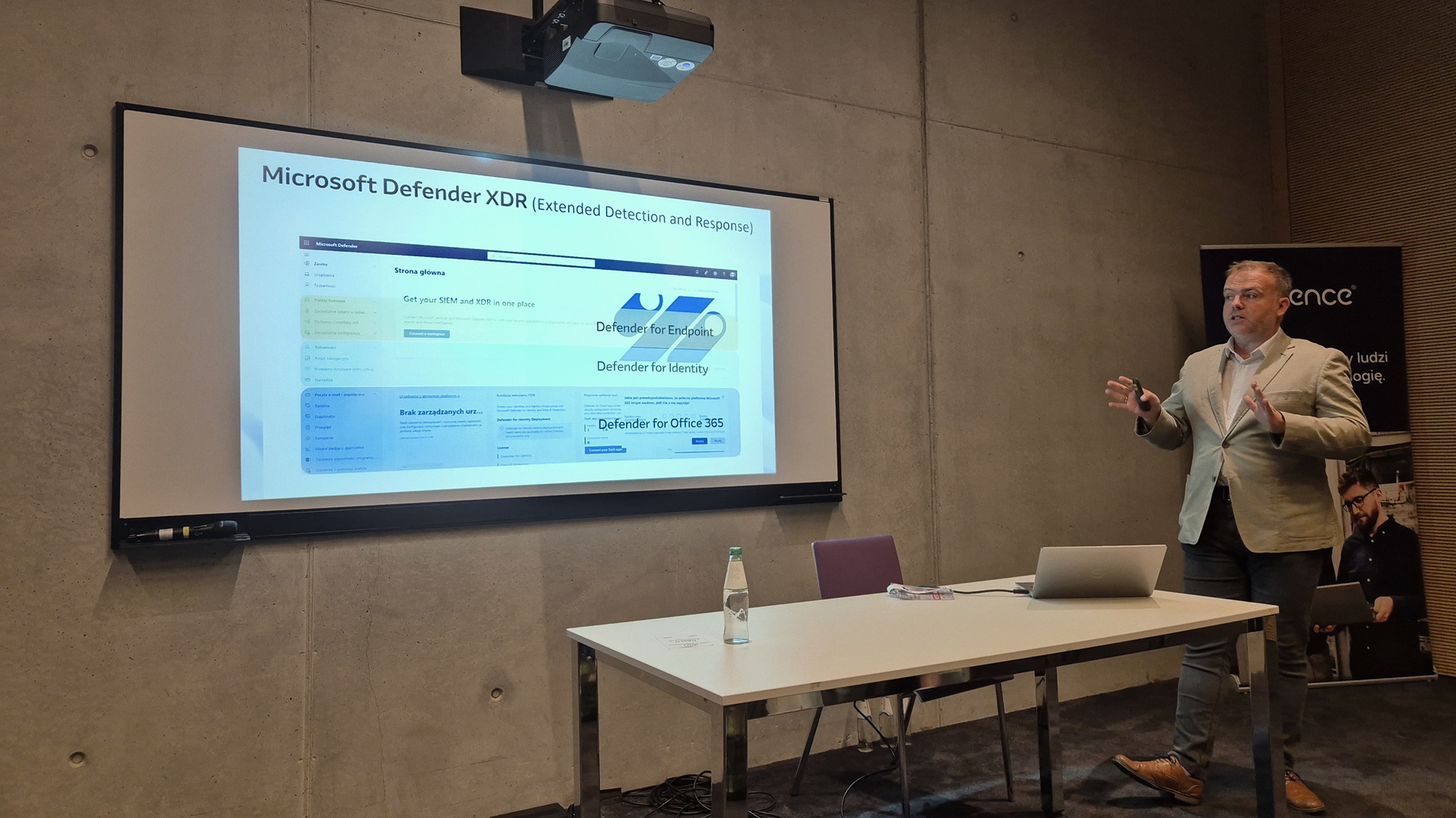

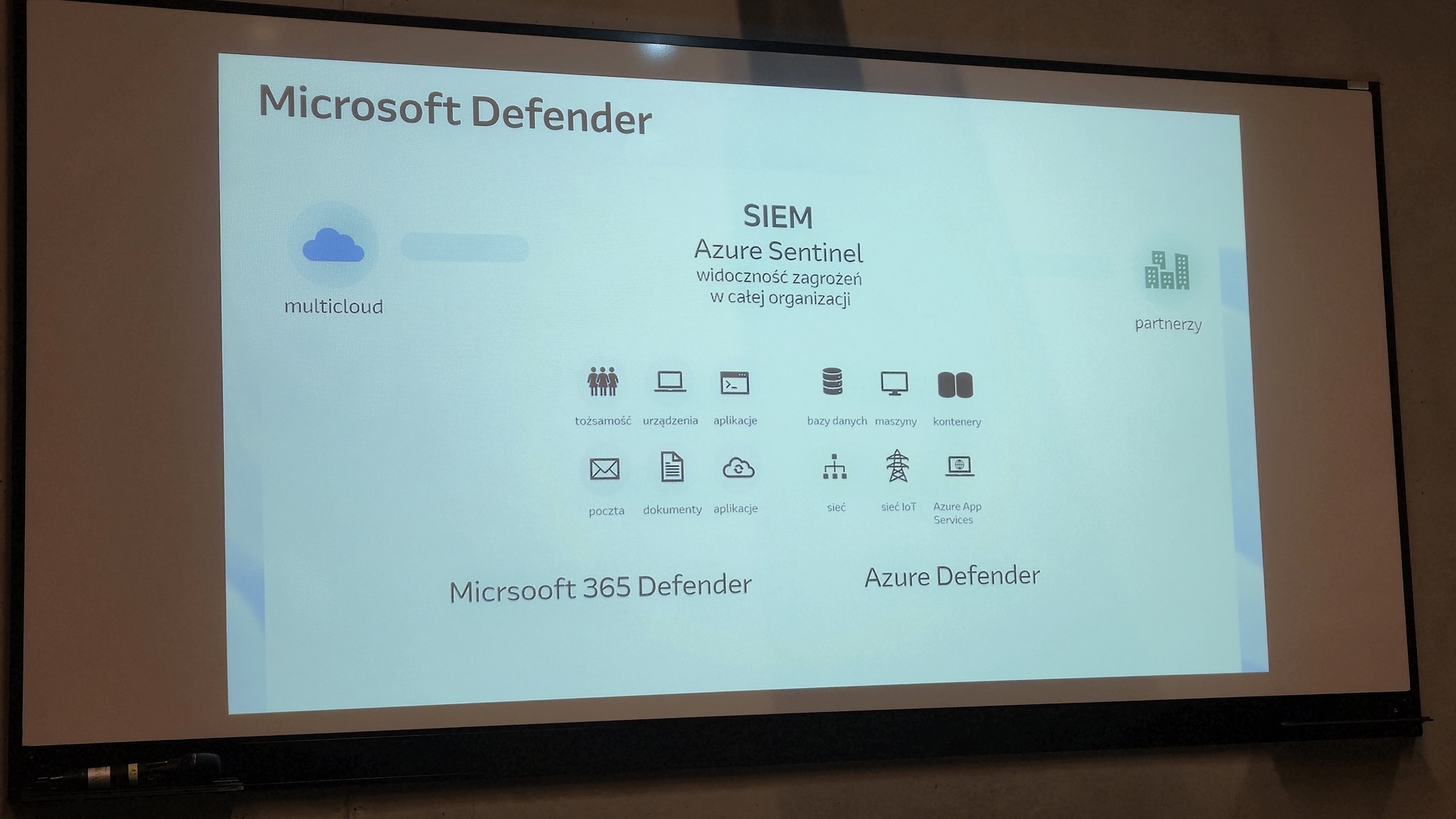

W dalszej części prezentacji omówiono kompleksowy pakiet Microsoft Defender, który składa się z kilku filarów:

- Defender for Endpoint — chroni urządzenia końcowe, integrując się z chmurą w celu analizy zagrożeń typu zero-day.

- Defender for Office — zabezpiecza pocztę, oprogramowanie Teams i OneDrive, wykorzystując m.in. sandboxing do sprawdzania podejrzanych załączników.

- Defender for Cloud — monitoruje i chroni zasoby działające bezpośrednio w Azure, takie jak maszyny wirtualne, bazy danych czy aplikacje.

Prelegent wielokrotnie chwalił intuicyjność i spójność interfejsu, który gromadzi wszystkie te narzędzia w jednym panelu administracyjnym. Wykład podsumowano jednak szczerą, choć nieco gorzką puentą: zaawansowane bezpieczeństwo ma swoją cenę. Jak stwierdził Jurek, w IT można mieć „łatwo, gwałtownie i przyjemnie”, ale „niekoniecznie najtaniej”.

EPA Systemy – Synology Active Protect: Backup szybszy niż problemy

Barwną anegdotą i konkretnym podejściem do problemu bezpieczeństwa danych wyróżniło się z kolei wystąpienie przedstawiciela Synology, Bartłomieja Dreko z firmy EPA Systemy. Prelegent rozpoczął od historii o kasynie, w którym hakerzy włamali się do sieci i wykradli dane gości VIP, wykorzystując jako furtkę… inteligentny termometr w akwarium. Ten przykład posłużył za wstęp do omówienia nowej, zintegrowanej platformy do backupu – Synology Active Protect.

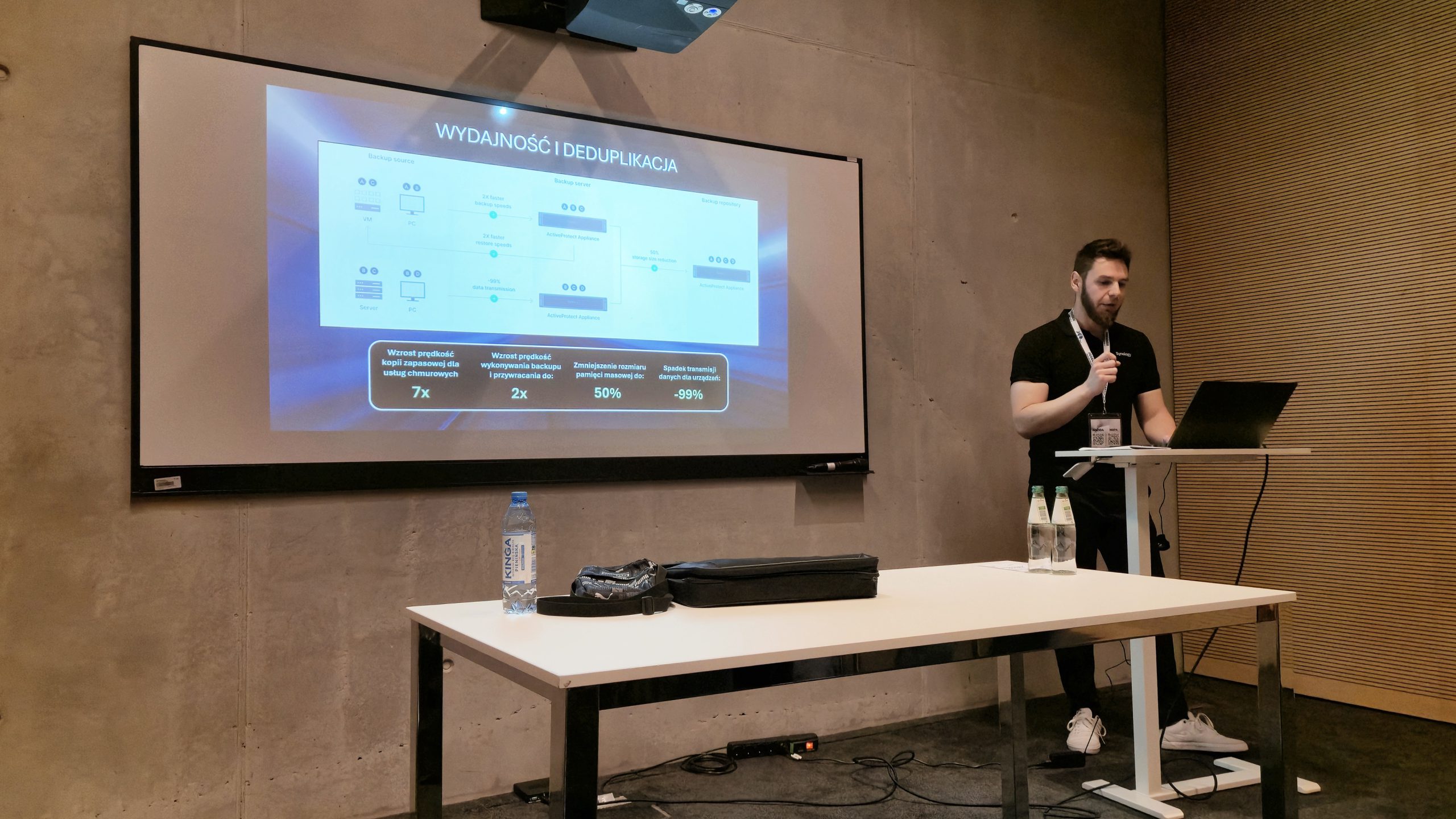

To, co odróżnia Active Protect od dotychczasowych rozwiązań firmy, to fakt, iż nie jest to jedynie oprogramowanie. To dedykowana linia urządzeń (seria DP) z preinstalowanym, autonomicznym systemem operacyjnym Active Protect Manager (APM). Nie jest to więc znany użytkownikom system DSM, a całkowicie nowa platforma, skrojona na miarę zaawansowanych zadań backupu.

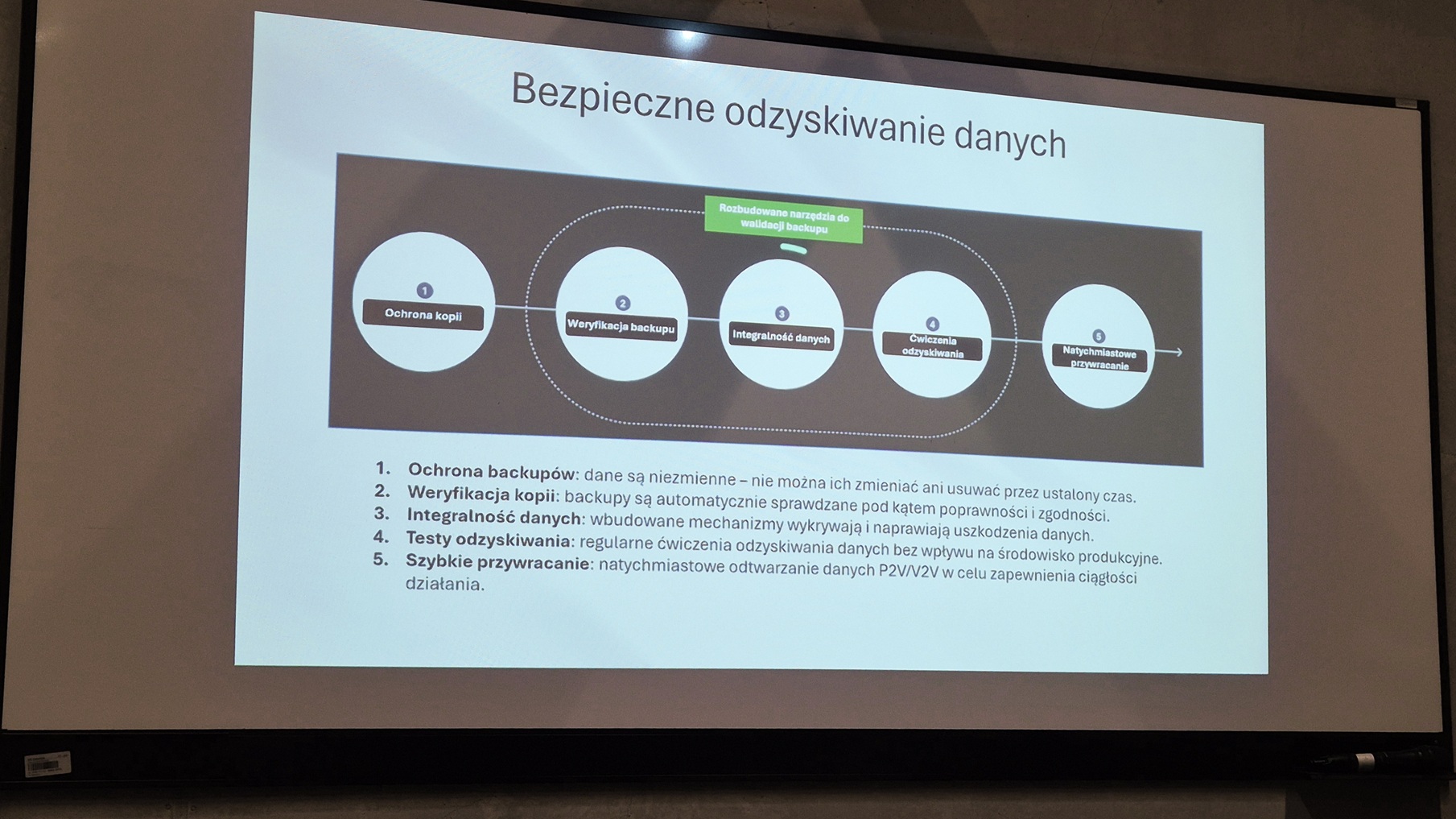

Kluczowe cechy rozwiązania to:

- Globalna deduplikacja u źródła: Technologia ta znacząco redukuje ilość przesyłanych i przechowywanych danych. Prelegent podał wymowny przykład: backup pięciu komputerów o łącznej pojemności 800 GB zajął na urządzeniu Active Protect zaledwie 120 GB.

- Ochrona przed ransomware: System implementuje strategię 3-2-1-1, oferując m.in. kopie niezmienne (immutable) w technologii WORM (Write Once, Read Many). choćby administrator systemu nie może ich usunąć przed upływem określonego czasu. Dodatkowym zabezpieczeniem jest Air Gap, czyli możliwość zaplanowanego, fizycznego odłączenia urządzenia od sieci.

- Weryfikacja kopii zapasowych: Jedną z ciekawszych, mniej oczywistych funkcji jest automatyczne testowanie odzyskiwania maszyn wirtualnych w środowisku sandbox. Po wykonaniu backupu system sam uruchamia maszynę, by sprawdzić jej integralność, a jako dowód poprawności nagrywa krótki film z tego procesu.

Platforma jest wysoce skalowalna, umożliwiając zarządzanie klastrem do 2500 urządzeń i monitorowanie choćby 150 000 obciążeń (serwerów, komputerów, maszyn wirtualnych) z jednej konsoli. Co istotne dla polskiego rynku, przedstawiciel dystrybutora zapowiedział, iż od października 2025 roku w Polsce będą dostępne oficjalne szkolenia certyfikujące z obsługi Active Protect.

Crayon – Bezpieczeństwo chmury zaczyna się od fundamentów

O tym, jak ważne są solidne fundamenty w podróży do chmury, przypomniał z kolei Marcin Kowalczyk z firmy Crayon. Skupił się on na bezpieczeństwie i optymalizacji kosztów w chmurze, dzieląc się doświadczeniami organizacji, która niedawno połączyła siły z globalnym dostawcą SoftwareOne. Fuzja ta wzmocniła pozycję rynkową firmy i pozwoliła świadczyć kompleksowe usługi z lokalnym wsparciem, m.in. w języku polskim.

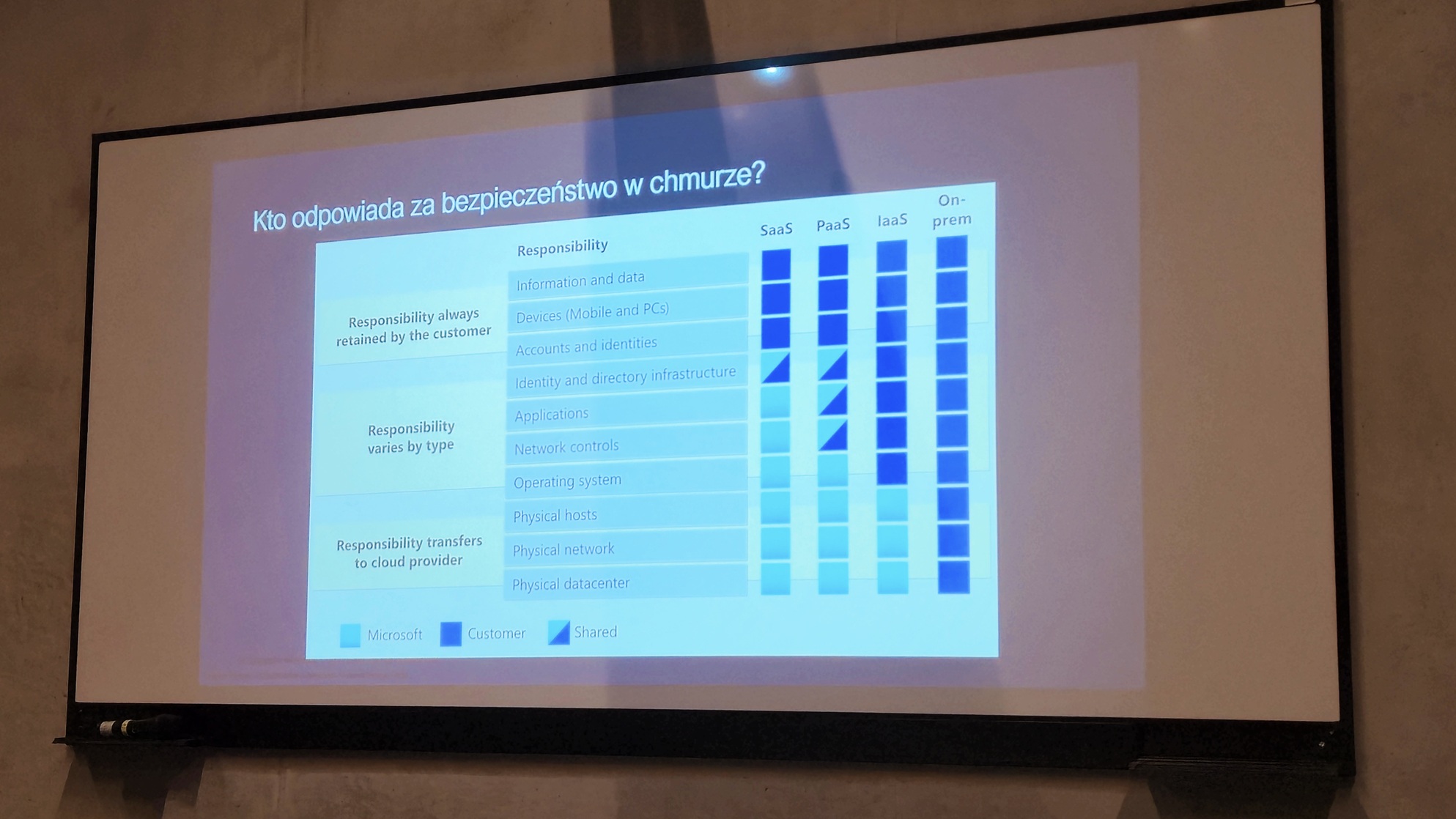

Kowalczyk zwrócił uwagę na często pomijany, a najważniejszy aspekt podróży do chmury – model współdzielonej odpowiedzialności. Podkreślił, iż organizacje nierzadko błędnie zakładają, iż za wszystko odpowiada dostawca platformy. W rzeczywistości to klient musi zadbać o takie elementy jak backup danych (nawet w modelu SaaS) czy holistyczne zabezpieczenie tożsamości.

Jako szczególnie niebezpieczny i powszechny błąd prelegent wskazał zaniedbywanie środowisk on-premise w architekturze hybrydowej. Stare, nieaktualizowane systemy lokalne stają się łatwym celem ataku, a skompromitowana tożsamość jest następnie automatycznie synchronizowana z chmurą, otwierając drzwi do krytycznych zasobów firmy.

Crayon przestrzega też przed chaotyczną adopcją chmury i tworzeniem izolowanych, nieudokumentowanych subskrypcji, które Kowalczyk określił mianem „wysp”. Zamiast tego firma proponuje budowę solidnych fundamentów w oparciu o sprawdzone wzorce, takie jak Cloud Adoption Framework i dobrze zaprojektowana Landing Zone.

Wśród prezentowanych rozwiązań znalazło się m.in. autorskie podejście Crayon określane jako „Pasterz Botów” – swoisty nadzorca (supervisor) dla różnych botów AI działających w organizacji. Jego rolą jest umożliwienie świadomego zarządzania zarówno bezpieczeństwem, jak i kosztami w środowisku chmurowym.

Prezentacja była cennym przypomnieniem, iż zaawansowane narzędzia, takie jak Microsoft Cloud Security Benchmark (MCSB) czy Microsoft Defender for Cloud, przynoszą realną wartość tylko wtedy, gdy są częścią przemyślanej strategii. Bezpieczeństwo w chmurze to nie jednorazowy projekt, ale ciągły proces oparty na świadomości, dobrych praktykach i solidnej architekturze.

Czy komputer może zabić? Adam Haertle z Zaufanej Trzeciej Strony z dawką śmiechu i grozy

Jednym z najbardziej obleganych punktów programu, była bez wątpienia prelekcja Adama Haertle. Redaktor naczelny Zaufanej Trzeciej Strony w swoim wystąpieniu zatytułowanym „Czy komputer może zabić? Historia najciekawszych przypadków” w brawurowy sposób udowodnił, iż potrafi połączyć merytoryczną głębię z rewelacyjnym humorem. Audytorium co chwilę wybuchało śmiechem, mimo iż opowiadane historie były w rzeczywistości także kroniką tragicznych w skutkach błędów.

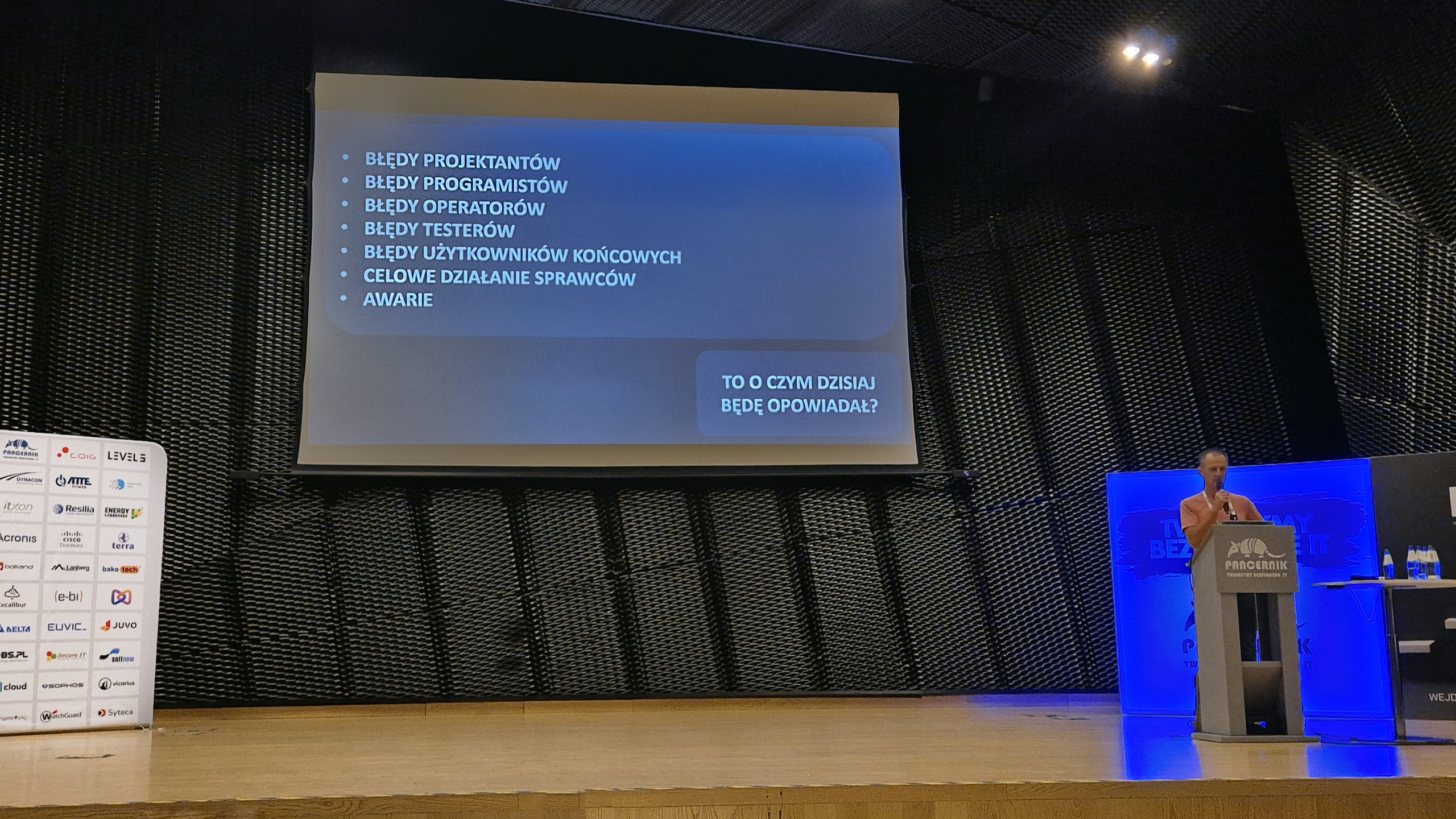

Haertle zabrał słuchaczy w podróż przez dekady, pokazując, iż choć wizja morderczego robota rodem z filmów science fiction jeszcze się nie ziściła, to ofiary systemów IT są faktem. Przyczyny? Błędy projektantów, programistów, testerów, a także zwykła ludzka pomyłka i nadmierna kreatywność.

Wykład rozpoczął się od mrożących krew w żyłach przypadków z sektora medycznego. Historia maszyny do radioterapii Therac-25 z lat 80. to klasyczny przykład, jak przeniesienie mechanizmów bezpieczeństwa z hardware’u do wadliwego systemu doprowadziło do tragedii. Przez błędy w kodzie (tzw. race condition) i fatalny interfejs użytkownika, który pozwalał na ignorowanie setek niezrozumiałych błędów, co najmniej sześciu pacjentów otrzymało wielokrotnie zawyżoną dawkę promieniowania.

Równie pouczająca była opowieść z Panamy, gdzie lekarze, próbując obejść ograniczenie systemu do czterech bloków osłaniających, rysowali jeden, skomplikowany kształt. Nie przewidzieli jednak, iż w zależności od… kierunku rysowania myszką, oprogramowanie mogło podwoić dawkę promieniowania. Jak z czarnym humorem podsumował prelegent: “Nikt nie wie dlaczego, ale kod tak działał”.

Haertle poruszył także aktualny problem ransomware w szpitalach, przytaczając przypadki, gdzie atak hakerów pośrednio doprowadził do śmierci pacjentów – czy to przez wyłączenie zdalnego monitoringu tętna płodu, czy przez konieczność transportu pacjentki w stanie zagrożenia życia do oddalonej o 30 minut placówki.

Druga część prelekcji przeniosła nas w kosmos, gdzie stawka pozostało wyższa, a błędy bywają spektakularne. Publiczność świetnie bawiła się przy historii sondy Mariner 1 z 1962 roku, której los przypieczętował brak jednej kreski nad zmienną w manualnie przepisywanym wzorze. Błąd sprawił, iż rakieta zaczęła chaotycznie korygować tor lotu i trzeba ją było zdalnie zdetonować.

Nie mniej zabawnie (choć tragicznie dla misji) było w przypadku rosyjskiej sondy Fobos 1, którą unieruchomiła literówka operatora – zapomniał on o jednym myślniku w komendzie. Niefortunnie, polecenie bez myślnika było komendą testową wyłączającą silniki, która nigdy nie powinna znaleźć się w wersji produkcyjnej oprogramowania. Jakby tego było mało, komputer weryfikujący polecenia akurat miał awarię.

Prelekcja Adama Haertle była mistrzowskim połączeniem edukacji i rozrywki. Pokazała, iż za każdą technologiczną katastrofą stoi człowiek i jego błędy, a skutki drobnych pomyłek mogą być niewyobrażalne. To była jedna z tych prezentacji, które na długo zostają w pamięci, ucząc więcej niż niejeden podręcznik i jednocześnie bawiąc do łez.

Adrian Stelmach – Jak bezpiecznie dokonać wdrożenia dedykowanych rozwiązań AI dla firmy?

Wątek sztucznej inteligencji, jeden z najgorętszych tematów w branży, kontynuował w swoim wystąpieniu Adrian Stelmach, prezes firmy Explita i autor podcastu Digitalizuj.pl. W prezentacji zatytułowanej „Jak bezpiecznie dokonać wdrożenia dedykowanych rozwiązań AI dla firmy?” zabrał on słuchaczy w podróż do „króliczej nory”, jaką jest dziś świat AI, by pokazać, jak przedsiębiorstwa mogą odnaleźć się w tej nowej rzeczywistości.

Stelmach rozpoczął od metafory z Alicji w Krainie Czarów, porównując obecne tempo rozwoju technologicznego do słów Kota z Cheshire: „by stać w miejscu, musisz biec, ile sił. jeżeli chcesz się ruszyć, musisz biec dwa razy szybciej”. Jako ilustrację przytoczył kontrastowe statystyki – podczas gdy Uber potrzebował sześciu lat na zdobycie 100 milionów użytkowników, ChatGPT osiągnął ten wynik w zaledwie dwa miesiące.

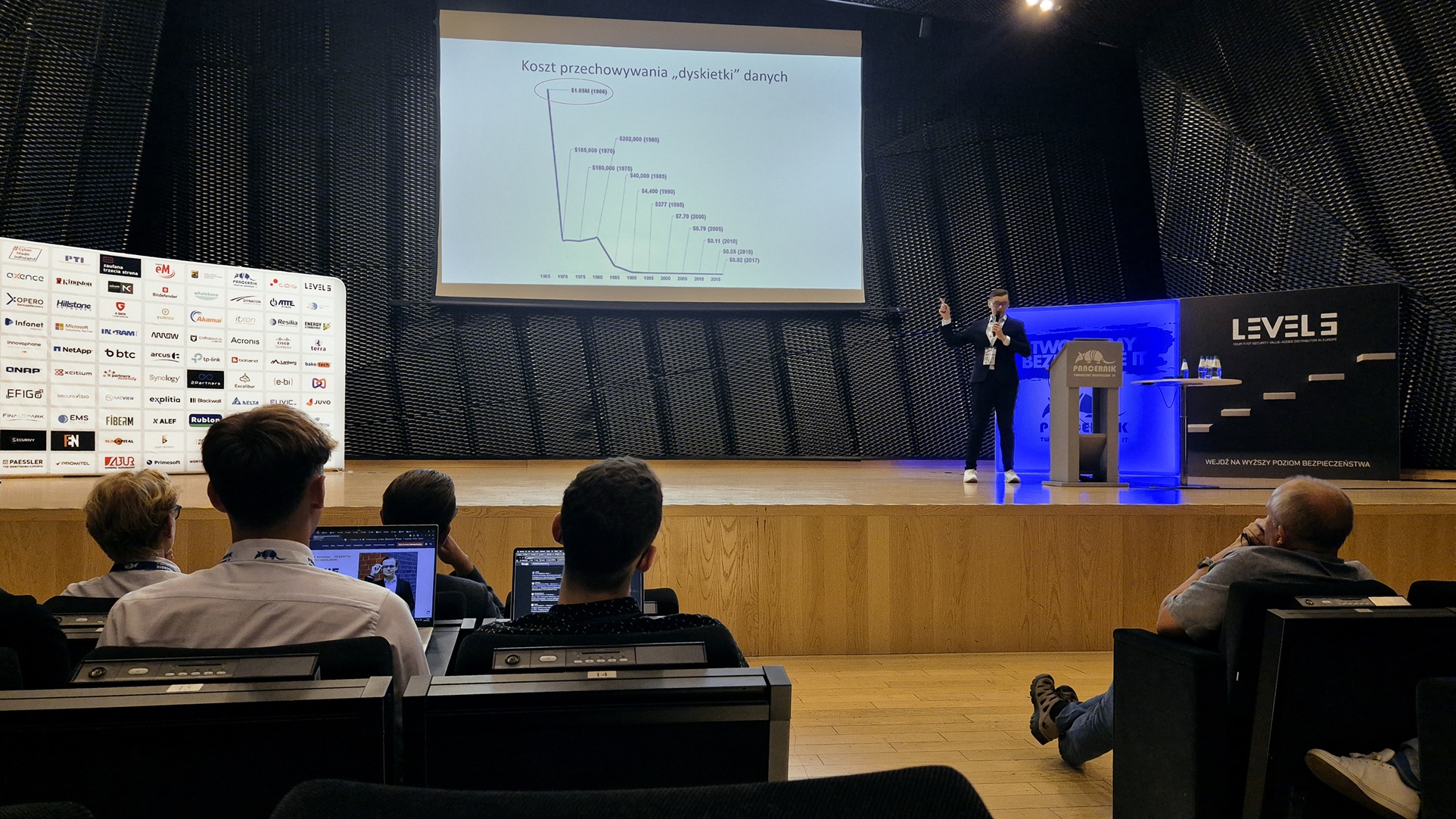

Prelegent wskazał dwa główne motory napędowe tej rewolucji: drastyczny spadek kosztów przechowywania danych oraz ogromny wzrost mocy obliczeniowej. Zauważył, iż koszt przechowania 1,44 MB danych spadł z milionów dolarów w latach 60. do ułamków centa dzisiaj. Jednocześnie przełomowe wykorzystanie procesorów graficznych (GPU) do obliczeń równoległych – rozwijane m.in. przez firmę Nvidia – wyniosło ją na szczyt listy najbardziej wartościowych spółek technologicznych. Mimo tak dynamicznego rozwoju, zdaniem Stelmacha, znajdujemy się dopiero na początku krzywej adopcji AI – korzysta z niej zaledwie co dwudziesta osoba na świecie.

Wykład skupił się na praktycznych aspektach wdrażania AI w biznesie, podkreślając zagrożenia związane z ogólnodostępnymi modelami. Halucynacje (czyli generowanie fałszywych informacji), których poprawność weryfikacji w popularnych modelach bywa na poziomie ok. 55%, oraz ryzyko wycieku danych firmowych, z których te modele mogą się uczyć, to główne wyzwania.

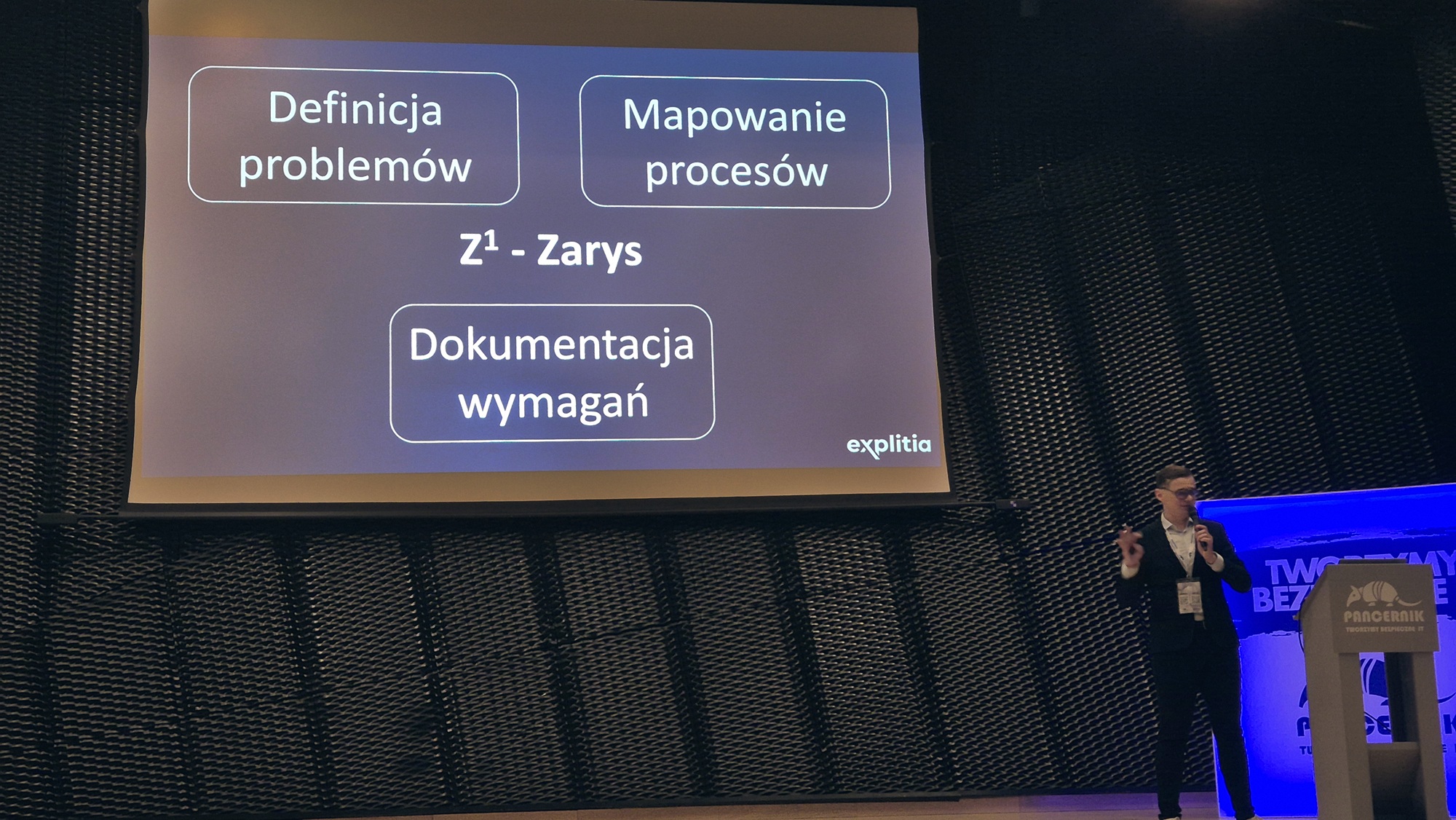

Kluczem do sukcesu jest, według Stelmacha, stworzenie dedykowanego, bezpiecznego rozwiązania. Zanim jednak firma zdecyduje się na zakup, musi odpowiedzieć na fundamentalne pytanie, które Kot zadał Alicji: „Dokąd chcesz dojść?”. Prelegent przedstawił autorską metodykę „Z do piątej”, czyli proces zakupu i wdrożenia systemu IT. Rozpoczyna się on od Zarysu (zdefiniowania problemów i celów biznesowych), przechodzi przez Zasoby (analizę kosztów i zwrotu z inwestycji), budowę Zespołu, przygotowanie Zapytania i Zakup, a kończy na Zwrocie, czyli ewaluacji wdrożenia.

Stelmach przestrzegał również przed 10 ukrytymi kosztami, takimi jak budowa specyfikacji, licencjonowanie, integracja czy późniejsze utrzymanie systemu.

Prelekcję zakończył powrót do świata Alicji i jej rozmowy z ojcem, który na pytanie, czy zwariowała, odpowiedział: „Tak, kompletnie. Ale powiem ci w sekrecie: tylko wariaci są coś warci”. Było to inspirujące wezwanie dla przedsiębiorców, by nie bali się odważnych, innowacyjnych kroków w świecie sztucznej inteligencji.

Biokomputery w Katowicach – FinalSpark i rewolucja w AI

Fascynującą wizję, która na moment przeniosła słuchaczy w odległą przyszłość technologii, przedstawiła na zakończenie dr Ewelina Kurtys. Reprezentantka szwajcarskiego startupu FinalSpark zaprezentowała koncepcję, która może fundamentalnie zmienić przyszłość sztucznej inteligencji: budowę procesorów z żywych, ludzkich neuronów.

Głównym celem FinalSpark jest rozwiązanie największego problemu współczesnej AI – gigantycznego i stale rosnącego zużycia energii. Jak podkreśliła dr Kurtys, bioprocesory oparte na żywych komórkach nerwowych mogą zużywać choćby milion razy mniej energii niż ich krzemowe odpowiedniki. To odpowiedź na prognozy, według których za kilka lat centra danych zasilające AI będą wymagały budowy dedykowanych elektrowni.

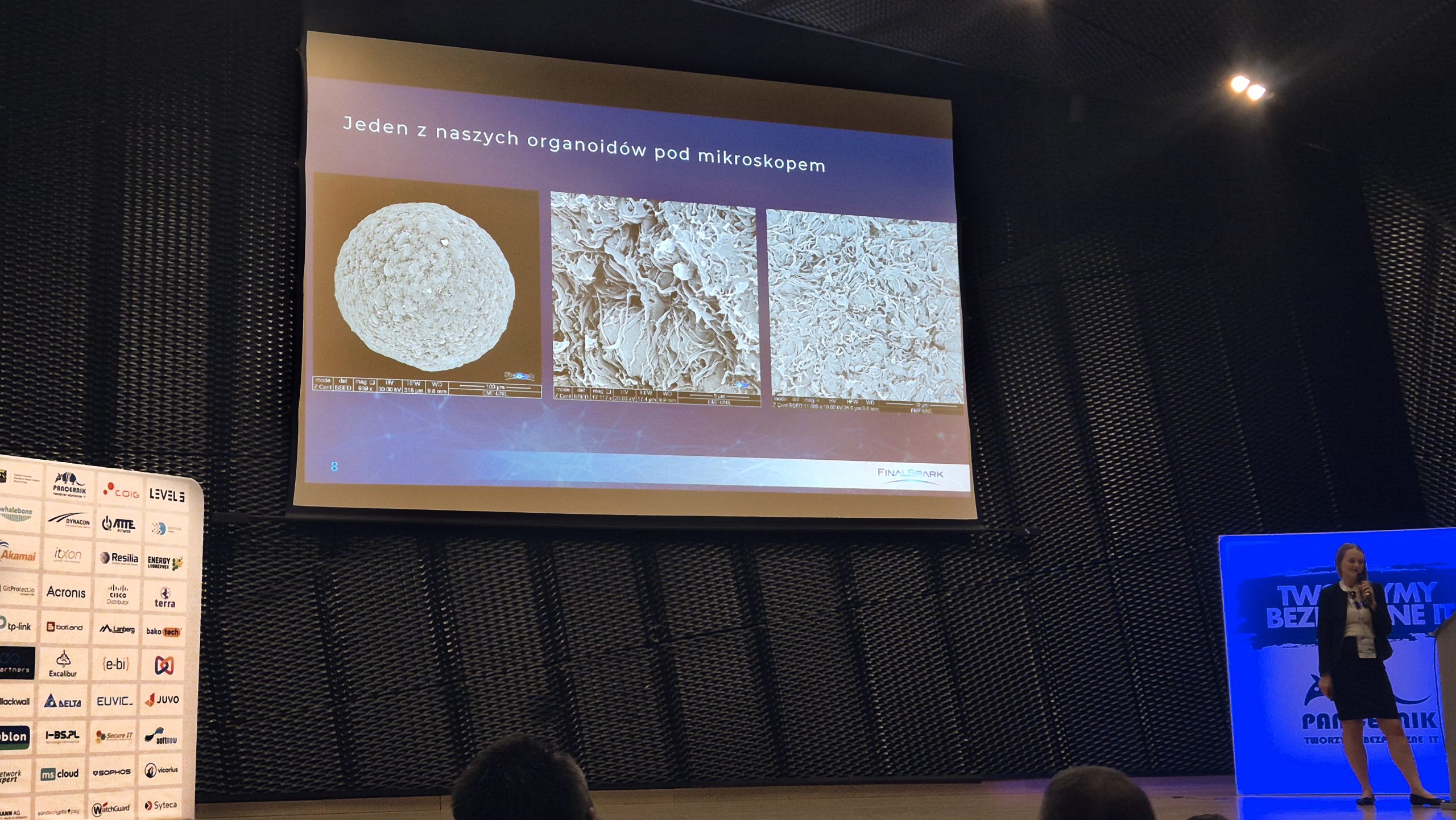

Firma, założona w 2014 roku przez dwóch inżynierów, początkowo próbowała sił w tradycyjnej AI, ale gwałtownie zderzyła się z barierą kosztów i zapotrzebowania na moc. To skłoniło ich do poszukiwania radykalnie nowego podejścia i pracy z żywymi neuronami. Dziś, przy udziale biologów, zespół z powodzeniem hoduje trójwymiarowe struktury neuronowe, tzw. neurosfery. Każda z nich, o średnicy zaledwie pół milimetra, zawiera około 10 000 neuronów.

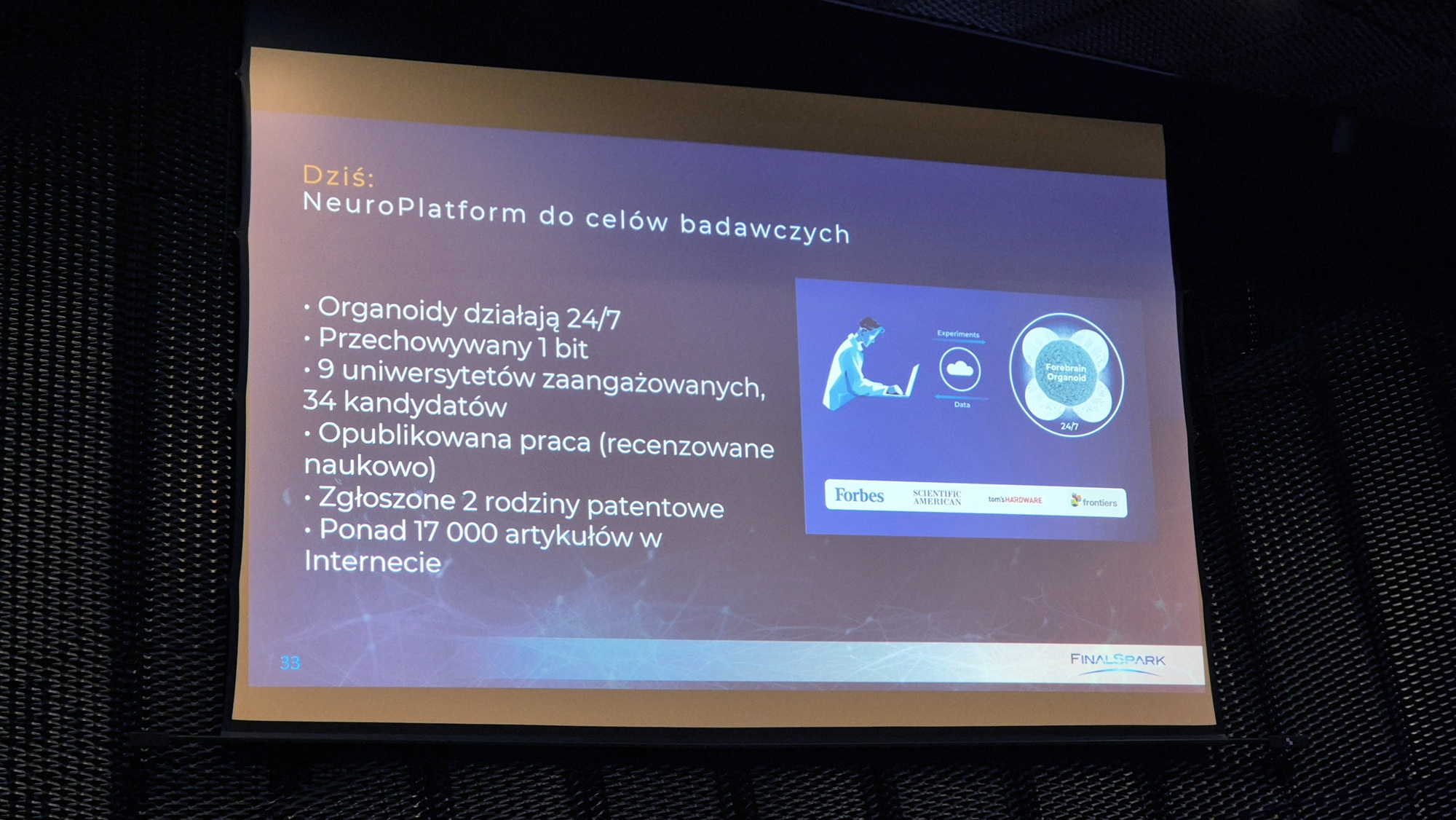

Choć projekt jest na bardzo wczesnym etapie, FinalSpark ma już na koncie konkretne sukcesy. Największym z nich jest zachowanie jednego bita informacji poprzez celową zmianę aktywności neuronów. Udało im się również utrzymać neurony przy życiu na elektrodach przez około trzy miesiące, co jest znaczącym osiągnięciem w badaniach laboratoryjnych. Dr Kurtys wyjaśniła, iż dłuższe przetrwanie jest w tej chwili jednym z największych wyzwań. Neurony są niezwykle wrażliwe na warunki laboratoryjne – sztuczna pożywka, minimalne wahania temperatury (nawet o 0,1 stopnia) czy wibracje spowodowane otwarciem inkubatora stanowią dla neuronów ogromny stres i skracają ich żywotność.

Mimo tych trudności, startup stworzył w pełni zautomatyzowaną platformę, która pozwala naukowcom z dziewięciu uniwersytetów na całym świecie zdalnie prowadzić eksperymenty, bez konieczności fizycznej obecności w szwajcarskim laboratorium. Dr Kurtys poruszyła też kilka mniej oczywistych, a kluczowych faktów. Po pierwsze, kwestie etyczne – neurony nie są pobierane od ludzi czy zwierząt. Powstają z komercyjnie dostępnych komórek macierzystych, które można “przeprogramować” z komórek skóry. Po drugie, praca z neuronami to działanie na “czarnej skrzynce”. Badacze nie rozumieją mianowicie w pełni wewnętrznych procesów, dlatego kluczowa jest automatyzacja i prowadzenie tysięcy eksperymentów metodą prób i błędów. W procesie “uczenia” neuronów stosuje się m.in. sygnały chemiczne, takie jak dopamina, działające jako nagroda.

Obecnie sześcioosobowy zespół poszukuje inwestora na kwotę 50 milionów euro, co ma pozwolić na zbudowanie w pełni funkcjonalnego biokomputera w ciągu najbliższych 10 lat. Prelekcja w Katowicach udowodniła, iż choć to odległa przyszłość, jej fundamenty powstają już dziś.

Pancernik Expo 2025 – podsumowanie wydarzenia

Przedstawione przez nas relacje to zaledwie wycinek bogatego programu, jaki przygotowali organizatorzy tegorocznej edycji Pancernik Expo. Agenda pękała w szwach od merytorycznych wystąpień, a uczestnicy musieli dokonywać trudnych wyborów, na którą ze ścieżek tematycznych się zdecydować. Równie wielkim zainteresowaniem cieszyły się inne prelekcje, w tym wystąpienie Krzysztofa Chudzika z CERT Polska, który przedstawił przegląd aktualnych zagrożeń w polskiej i światowej cyberprzestrzeni, czy prelekcja Arkadiusza Siczka, który zdradzał kulisy pracy Security Operations Center (SOC).

Siłą wydarzenia była także imponująca strefa expo, która zgromadziła ponad 60 wystawców prezentujących najnowsze technologie. Na stoiskach można było spotkać przedstawicieli czołowych marek z niemal każdego sektora IT. Wśród nich znaleźli się globalni liderzy bezpieczeństwa, tacy jak Bitdefender, Akamai, Sophos, WatchGuard czy Acronis. Nie zabrakło gigantów infrastruktury i sprzętu, w tym firm Microsoft, Cisco, Kingston, NetApp, QNAP, Eaton czy TP-Link. Swoje rozwiązania prezentowali również liczni polscy dystrybutorzy, integratorzy i producenci oprogramowania, tacy jak Ingram Micro, Axence, bako tech, Crayon, Play czy Xopero.

Tak szerokie spektrum prezentowanych rozwiązań i eksperckiej wiedzy po raz kolejny potwierdza, iż Pancernik Expo to obowiązkowy punkt w kalendarzu każdego polskiego specjalisty do spraw bezpieczeństwa IT. Różnorodność tematów – od technicznych aspektów ochrony sieci, przez ludzki wymiar cyberbezpieczeństwa, aż po futurystyczne wizje AI – pokazuje, jak złożonym i dynamicznym obszarem jest dziś ochrona cyfrowego świata.