Zaawansowana wersja Google Gemini z trybem Deep Think po raz pierwszy w historii AI zdobyła złoty medal na Międzynarodowej Olimpiadzie Matematycznej (IMO), rozwiązując pięć z sześciu zadań w naturalnym języku i w czasie konkursu. Pomimo oficjalnej weryfikacji wyników przez organizatorów IMO, sceptycy wciąż podważają praktyczną wartość tej technologii.

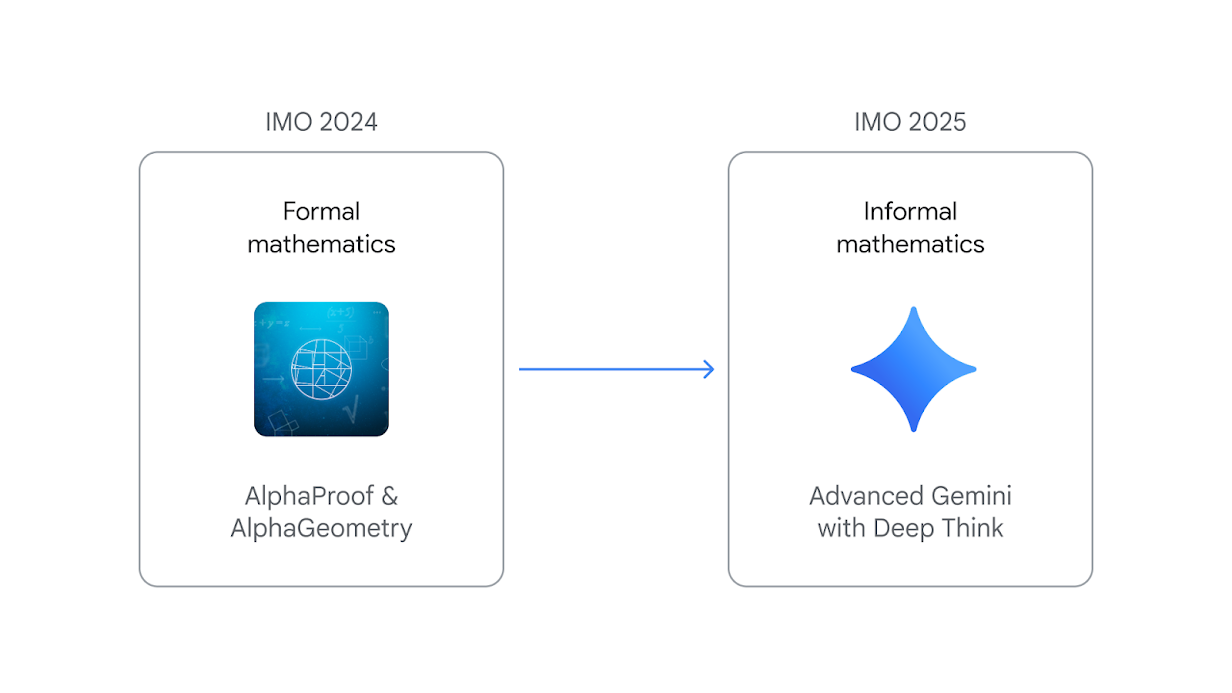

W ubiegłym roku systemy DeepMind – AlphaProof i AlphaGeometry 2 – uzyskały wynik na poziomie srebrnym, rozwiązując cztery z sześciu zadań IMO w formalnym języku dowodowym, z wykorzystaniem tłumaczenia na Lean i wielodniowych obliczeń.

Tymczasem w bieżącym miesiącu zaawansowana wersja Gemini Deep Think zdobyła 35 na 42 punkty, co odpowiada pełnym punktom za pięć problemów. Co więcej, zrobiła to:

- w czystym, naturalnym języku, bez uprzedniego przetwarzania zadań na języki formalne,

- w czasie 4,5-godzinnych sesji konkursowych, tak jak uczniowie IMO,

- z wynikami zatwierdzonymi przez oficjalnych graderów IMO.

Przeskok z 28 do 35 punktów w ciągu zaledwie roku pokazuje, iż równoległe ścieżki rozumowania – tzw. parallel thinking – pozwalają AI eksplorować wiele hipotez jednocześnie i scalać najlepsze rozwiązania.

To istotny sukces, nie tylko w kontekście Public Relations

To istotny sukces, nie tylko w kontekście Public RelationsDeep Think – gdy sztuczna inteligencja uczy się myśleć

Deep Think to nowa warstwa uczenia ze wzmocnieniem, w której model otrzymuje nie tylko końcowy wynik, ale także długie, szczegółowe dowody krok po kroku. Buduje to zdolność AI do generowania czytelnych, precyzyjnych wywodów matematycznych, które graderzy IMO ocenili jako łatwe do śledzenia.

Zespół DeepMind wypunktował, iż Deep Think:

- Przeprowadza wiele równoległych drzew rozumowania,

- Uczy się na zbiorze wysokiej jakości rozwiązań olimpijskich,

- Obejmuje ogólne wskazówki dotyczące strategii rozwiązywania problemów.

Dzięki temu zaawansowanemu trybowi Gemini potrafi nie tylko odgadnąć wynik, ale i uzasadnić każdy krok niczym doświadczony uczestnik IMO.

Naturalny język kontra formalne narzędzia

Do tej pory większość sukcesów AI w matematyce opierała się na tłumaczeniu zadań do systemów dowodowych (Lean, Coq) bądź sięganiu po symboliczne solvery. DeepMind idzie jednak dalej – żadne linijki kodu ani zewnętrzne solvery nie są wprowadzane pomiędzy tekstem zadania a wygenerowaną odpowiedzią. W praktyce oznacza to, iż wystarczy kopiuj-wklej warunku zadania, a AI samodzielnie rozpisuje dowód w języku naturalnym.

Mimo oficjalnego potwierdzenia wyników przez IMO wielu komentatorów przez cały czas sceptycznie podchodzi do wartości tego osiągnięcia. Najczęściej pojawiające się zarzuty to:

- Mimo certyfikatu IMO niektórzy uważają, iż AI wyrzuca zbyt uproszczone dowody, trudne do samodzielnej kontroli.

- Choć DeepMind twierdzi, iż użyto tylko publicznie dostępnych materiałów niejasne pozostaje, czy model nie zetknął się z podobnymi zadaniami w trakcie szkoleń.

- Również w bieżącym miesiącu OpenAI ogłosiło wewnętrzną, nieoficjalną ocenę swojego modelu na tym samym zestawie zadań, również z wynikiem 35/42, co wywołało burzę na X i Reddicie. Konflikt między oficjalnie a nieoficjalnie zmienia sukces w poligon dla PR.

Co dalej dla GenAI i edukacji?

Przełom Gemini Deep Think to dopiero początek drogi AI w zaawansowanej edukacji i badaniach. Możliwość generowania pełnych dowodów w naturalnym języku otwiera drzwi do:

- Interaktywnych korepetycji ze sztuczną inteligencją,

- Wsparcia przy odkrywaniu nowych twierdzeń,

- Automatyzacji recenzji naukowych w dziedzinie matematyki.

Jednak aby GenAI zyskało pełne zaufanie potrzebne są transparentne standardy oceny rozwiązania, ścisłych benchmarków i otwarty dostęp do kodu czy danych treningowych. Dopiero wtedy niedowiarki przestaną drapać się po głowie, a technologia wkroczy na szerszą arenę przemysłu i edukacji.