Choć pojęcie prywatności funkcjonuje w naszym społeczeństwie od lat, w dobie cyfryzacji życia społecznego zarówno rozumienie tego pojęcia, a także środki ochrony prywatności podlegają stałym zmianom. Nowe technologie wdrażane na szeroką skalę, takie jak generatywna sztuczna inteligencja, chmura obliczeniowa, blockchain, czy technologie do rozpoznawania ludzkich emocji, sprawiają, iż sytuacja użytkownika i jego danych w sieci jest stale redefiniowana.

Niektóre technologie wdrażane są w celach ochrony prywatności i w ramach istniejących już ram prawnych, a ich wdrożenie nie budzi większych wątpliwości w kontekście zasadności czy samego wdrożenia. ale niektóre nakazują specjalistom od cyberbezpieczeństwa, etykom i prawnikom zadać pytanie: czy wdrożenie danej technologii na szeroką skalę nie wymaga podjęcia dodatkowych kroków wobec użytkownika lub innego podmiotu, którego dane są przetwarzane? W konsekwencji, pojawiają się inicjatywy ustawodawcze zmierzające do ustalenia zastosowania nowych technologii. Jednym z liderów regulacji w tym zakresie jest Unia Europejska z jej inicjatywą tzw. Cyfrowej Dekady – programu unijnego, mającego na celu transformację ku cyfrowej gospodarce w okresie do 2030 roku. (dostęp: 10 maja 2024 roku)

W Unii Europejskiej pierwotnie kwestię ochrony prywatności w erze cyfrowej miało szeroko regulować Rozporządzenie o ochronie danych (RODO), które zaczęło być stosowane w 2018 roku. Do dziś RODO pozostaje aktualne, między innymi dzięki temu, iż regulacja ta została zaprojektowana jako neutralna technologicznie. To oznacza, iż dane osobowe podlegają ochronie przewidzianej w RODO bez względu na sposób ich przetwarzania i stosowaną wobec nich technologię. Zatem dane osobowe przechowywane na kartkach papieru podlegają ochronie RODO tak samo, jak dane znajdujące się w systemach cyfrowych, wykorzystujących nowe technologie – choć różne będą środki ich zabezpieczania.

Każde nowe rozwiązanie technologiczne wpływające na przetwarzanie danych osobowych pod względem prawnym na obszarze Unii Europejskiej powinno być analizowane w zgodzie z przepisami RODO. Natomiast odniesieniu do niektórych specyficznych rozwiązań lub branż, możemy się spotkać z przepisami szczególnymi dotyczącymi prywatności – także na szczeblu unijnym. Takimi regulacjami będzie np. rozporządzenie ws. sztucznej inteligencji (ang. Artificial Intelligence Act). Nowe przepisy w znaczący sposób wpływają na ochronę prywatności w sieci, choć niektóre z zastosowań nowych technologii mogą stanowić w tym zakresie wyzwanie.

Szyfrowanie homomorficzne, czyli sposób na wykorzystanie zaszyfrowanych danych bez uszczerbku dla prywatności

Jedna z interesujących technologii znajdujących zastosowanie w ochronie danych, której rozwój możemy zaobserwować w ciągu ostatnich lat, to szyfrowanie homomorficzne. Jednak aby zrozumieć działanie szyfrowania homomorficznego, jako punkt wyjściowy należy wyjaśnić podstawy szyfrowania w ogólności.

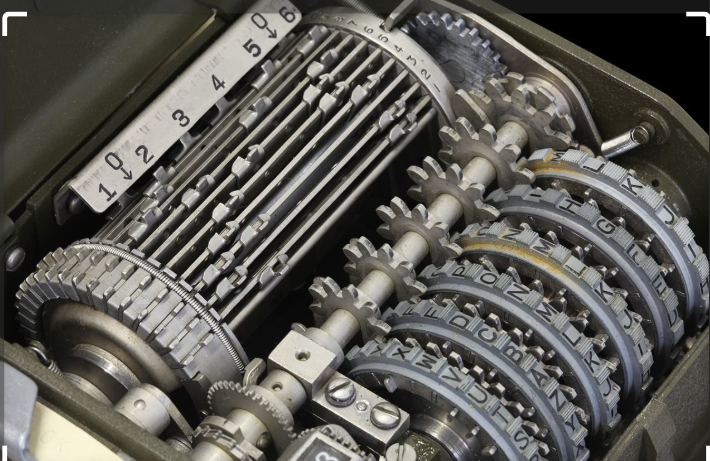

Szyfrowanie pozwala na bezpieczne przesyłanie danych poprzez przekształcenie zwykłe treści w zaszyfrowany tekst, a następnie odszyfrowanie tego tekstu z powrotem na oryginalną treść dzięki określonego klucza. Szyfrowanie pozwala również chronić informacje w miejscu przechowywania, takie jak te zapisane na zaszyfrowanej bazie danych czy dysku. Jest to szczególnie istotne w dobie poszerzających się rozwiązań technologicznych opartych o chmurę obliczeniową. Szyfrowanie homomorficzne to szczególny rodzaj szyfrowania, który umożliwia wykonywanie obliczeń na zaszyfrowanych danych bez potrzeby ich deszyfrowania. Nie jest także wymagana znajomość klucza. Dzięki temu zapewnia się zarówno prywatność danych, jak i możliwość operowania na nich. Wyniki po odszyfrowaniu są takie same, jakby operacje przeprowadzano na danych w formie jawnej.

Szyfrowanie homomorficzne ma duże zalety dla bezpieczeństwa i prywatności zwłaszcza przy przetwarzaniu danych w chmurze obliczeniowej, która znajduje coraz szersze zastosowanie. Coraz więcej przedsiębiorstw stawia na rozwiązania chmurowe, powierzając swoje dane zewnętrznym dostawcom usług. Jednak wykonywanie bieżących operacji bezpośrednio w chmurze jest utrudnione, jeżeli mamy do czynienia z zaszyfrowanymi danymi. Szyfrowanie homomorficzne adresuje ten problem, nie narażając przy tym poufności danych i prywatności.

Ten typ szyfrowania będzie także przynosił korzyści w badaniach naukowych, gdzie istnieje potrzeba pracy na wrażliwych danych, takich jak dane medyczne, bez ich ujawniania (np. pozwoli na przetwarzanie danych przez niezaufane serwery w taki sposób, iż serwer nie może dowiedzieć się nic o oryginalnych danych, a jednocześnie może zwrócić użytkownikowi użyteczne wyniki). W końcu, znajdzie także zastosowanie w zapobieganiu terroryzmowi (np. oficer bezpieczeństwa na lotnisku może porównywać zdjęcia pasażerów z bazą podejrzanych o działania terrorystyczne bez dostępu do samych zdjęć pasażerów – jedynie uzyskując istotne do przeprowadzenia kontroli bezpieczeństwa dane wynikowe) czy przy dalszym rozwoju Internetu Rzeczy (ang. Internet of Things).

W 2013 roku udostępniono darmową bibliotekę cyfrową do szyfrowania na licencji GPL (open source), umożliwiającą testowanie tego sposobu szyfrowania na szerszą skalę. Ten sposób szyfrowania okazał się niestety bardzo czasochłonny jak na standard dokonywania cyfrowych operacji, co sprawia, iż nie jest on na razie powszechnie stosowany. Dodatkowo wciąż prezentuje szereg wyzwań technologicznych – zwłaszcza przy bardziej złożonych, szyfrowanych strukturach.

Dziś szyfrowanie homomorficzne jest przedmiotem intensywnych badań, które zmierzają do pokonania napotykanych wyzwań. Warto jednak obserwować rozwój tej technologii, szczególnie pod kątem ochrony prywatności danych w chmurze.

Trudności w zapewnieniu zgodności blockchain i DLT z regulacjami w obszarze ochrony danych

Blockchain i technologie rozproszonych baz danych (ang. distributed ledger technology – DLT) to kolejne innowacje cyfrowe, które w ostatnich latach zyskały na popularności. Relacja między ochroną prywatności a technologiami blockchain i DLT jest przedmiotem zainteresowania ekspertów ochrony danych. W 2019 roku opublikowany został raport na temat stosowania RODO w odniesieniu do technologii blockchain. (dostęp: 10 maja 2024 roku) Pomimo tego, problematyka wdrożenia odpowiednich standardów ochrony w odniesieniu do danych osobowych wpisanych w technologię blockchain pozostaje złożona.

Problematyczne jest już samo stwierdzenie, czy w ramach danych przetwarzanych w łańcuchu bloków, mamy do czynienia z danymi osobowymi, które podlegają ochronie na gruncie RODO. Podstawową cechą zapisywanych na blockchainie danych jest ich integralność oraz zabezpieczenie ich autentyczności. Dane zapisywane są zwykle w sposób zaszyfrowany lub mogą być sformatowane (skrócone), wymagając odniesienia do innych danych, spoza danego łańcucha bloków, aby uzyskać pełen odczyt.

W przypadku danych zaszyfrowanych w blockchain, podstawowe kategorie danych to klucze publiczne użytkowników oraz dane transakcyjne. Klucze publiczne wskazują użytkownika, stanowiąc poniekąd jego „numer konta”, który jest udostępniany innym osobom w celu umożliwienia dokonywania transakcji. Kluczem prywatnym będzie posiadany przez tego użytkownika ciąg liter i cyfr (dobrze o nim myśleć jak o haśle, którego nigdy nie wolno udostępniać innym). Klucz prywatny może odszyfrować dane, które zostały zaszyfrowane dzięki klucza publicznego. Klucze publiczne ukrywają zatem co do zasady tożsamość osoby, która często będzie osobą fizyczna. W konsekwencji daje się wywieść, iż klucze publiczne to dane pseudonimizowane, podlegające ochronie RODO.

Kolejnym wyzwaniem jest kwalifikacja administratora oraz podmiotów przetwarzających wśród użytkowników, a co za tym idzie ustalenie obowiązków konkretnych podmiotów występujących w łańcuchu bloków. W niektórych systemach istnieje jeden podmiot (np. osoba fizyczna czy instytucja), który decyduje o dopuszczeniu nowych użytkowników do łańcucha, udziela im uprawnień oraz ustala cele i sposoby przetwarzaniach danych w ramach łańcucha bloków. W przypadku takiego prywatnego blockchaina, z dużą dozą prawdopodobieństwa można stwierdzić, iż ten podmiot zostanie zakwalifikowany jako administrator danych na gruncie RODO. Jednak relacja nie zawsze będzie tak jasna. W przypadku, gdy do danego łańcucha bloków nie będzie wymagane wcześniejsze uzyskanie dostępu – pojawiają się różne koncepcje z zakresu ochrony danych: od współadministracji do relacji szeregu niezależnych administratorów. W takiej sytuacji wypełnienie obowiązku informacyjnego wobec użytkowników, jak również zapewnienie im możliwości wykonywania swoich praw (np. prawa do usunięcia danych czy ich przeniesienia) może być utrudnione, o ile nie uniemożliwione.

Mimo licznych zalet tej technologii, utworzenie systemu opartego o blockchain w zgodzie z przepisami ochrony prywatności w Unii może stanowić duże wyzwanie techniczne. W konsekwencji w przypadku ataku cybernetycznego, w wyniku którego doszłoby do ujawnienia tożsamości użytkowników, trudne będzie ustalenie podmiotu odpowiadającego za zapewnienie bezpieczeństwa danych. Planowany system powinien być w każdym przypadku przeanalizowany z punktu widzenia przepisów o ochronie danych choć zdaje się, iż i taka analiza może nie przynieść nam odpowiedzi na wszystkie wątpliwości.

Narzędzia AI do naśladowania głosu a ochrona danych

Również rozwój technologii sztucznej inteligencji (AI) stawia duże wyzwania w obszarze ochrony danych osobowych. Przykładem mogą być oparte o AI narzędzia do naśladowania głosu. Tego rodzaju oprogramowanie wykorzystuje zwykle dane tekstowe i pojedynczą krótką próbkę audio do generowania naturalnie brzmiącej mowy, która do złudzenia przypomina głos oryginalnego mówcy. Z założenia narzędzie ma wspierać takie cele jak zapewnienie pomocy w czytaniu osobom nieczytającym i dzieciom oraz tłumaczenie treści (nagrania wideo, podcasty).

Jednak generowanie mowy, która przypomina głosy ludzi, wiąże się z poważnym ryzykiem podszywania się pod inną osobę lub organizację bez uprawnień. Technologia ta może zostać wykorzystana w sytuacji, w której dana osoba musi podać informacje lub instrukcje przez telefon, na przykład w bankowości. Pojawiały się już przypadki wykorzystania głosu wytworzonego przez AI do dokonania oszustwa na setki tysięcy dolarów. (dostęp: 10 maja 2024 roku)

W konsekwencji istotne jest, aby oprogramowanie służące do naśladowania głosu zawierało pewne zabezpieczenia prawne, wpisane przykładowo do warunków korzystania z udostępnianego narzędzia. Użytkownicy powinni być zobowiązani do uzyskania wyraźnej i świadomej zgody oryginalnego mówcy na przetwarzanie jego danych (głosu). Niektóre z dostępnych programów o nie zezwalają na tworzenie własnych głosów przez indywidualnych użytkowników. Użytkownicy korzystający z aplikacji zwykle muszą wyraźnie ujawnić swoim odbiorcom, iż głosy, które słyszą, są generowane przez sztuczną inteligencję. Inne stosowane środki bezpieczeństwa to przykładowo: znak wodny do śledzenia pochodzenia każdego dźwięku generowanego przez oprogramowanie, czy proaktywne monitorowanie sposobu jego wykorzystania.

W kontekście ochrony prywatności warto się zastanowić czy sam głos osoby fizycznej, także w sytuacji, gdy przemówienie jest wygenerowane przez algorytm i nie zostało wytworzone przez tę osobę, stanowi jej dane osobowe. Co do zasady, choćby jeżeli samo nagranie nie ujawnia tożsamości mówcy, w dalszym ciągu możliwe jest rozpoznanie kim jest mówca. Często znając daną osobę, jesteśmy w stanie rozpoznać jej głos na nagraniu. Ponadto, istnieją w tej chwili także specjalne techniki biometryczne umożliwiające ustalenie, kto przemawia na danym nagraniu. Można zatem uznać, iż narzędzie przetwarza dane osobowe (próbkę głosu) i tworzy na tej podstawie nowe nagranie.

Bezprawne wykorzystanie pozyskanych próbek głosu czy wizerunku może nieść daleko idące skutki dla osoby, która jest ich właścicielem. Przy korzystaniu z tego typu rozwiązań, niezbędne jest dokładne ustalenie zasad ochrony prywatności i wprowadzenie dopasowanych zabezpieczeń, aby chronić przetwarzane dane. Jest to najważniejsze i konieczne, aby zapobiec możliwym nadużyciom – a tych, przy tak szybkim rozwoju AI, możemy spodziewać się wiele.

Przyszłość prywatności przy galopującym rozwoju technologii

W kontekście przyszłości prywatności cyfrowej, istotne będzie śledzenie i adaptacja do ciągłych innowacji technologicznych, które zarówno zwiększają możliwości ochrony danych, jak i stwarzają nowe wyzwania. Rozwój szyfrowania homomorficznego może rewolucjonizować bezpieczeństwo danych w chmurze, umożliwiając bezpieczne obliczenia na zaszyfrowanych danych. Z kolei technologie blockchain i DLT, mimo ich zalet w zakresie integralności danych, wciąż wymagają dalszych badań i dyskusji na temat ich zgodności z istniejącymi regulacjami ochrony danych, takimi jak RODO. Unia Europejska, jako lider w dziedzinie regulacji, kontynuuje prace nad dostosowaniem prawodawstwa do nowych realiów cyfrowych, co widać w inicjatywach takich jak Cyfrowa Dekada czy nadchodzące rozporządzenie dotyczące sztucznej inteligencji. Jednocześnie, rozwój narzędzi AI już dziś wymaga wprowadzenia skutecznych zabezpieczeń, aby zapobiec nadużyciom i ochronić tożsamość osób. W związku z tym, organizacje muszą dokładnie analizować wpływ nowych technologii na prywatność i wdrażać odpowiednie środki ochronne, aby w pełni wykorzystać ich potencjał przy jednoczesnym zachowaniu bezpieczeństwa danych osobowych. Przyszłość prywatności cyfrowej będzie więc zależała od umiejętności szybkiego reagowania na zmiany technologiczne i prawne, a także od odpowiedzialnego wdrażania innowacji z poszanowaniem praw jednostek.

Alicja Guzy, EY

Alicja Guzy, EY Agata Wilska, EY

Agata Wilska, EYAutorki: Agata Wilska i Alicja Guzy – prawniczki w zespole Prawa Własności Intelektualnej, Technologii i Danych Osobowych w Kancelarii EY Law