Specjaliści z Varonis Threat Labs odkryli nowy, niepokojący wektor ataku skierowany przeciwko Microsoft Copilot Personal – konsumenckiej wersji asystenta opartego na sztucznej inteligencji. Technika nazwana przez nich „Reprompt” umożliwiała zdalnym aktorom zagrożeń uruchomienie łańcucha poleceń w Copilocie, tak by krok po kroku wydobywał i wysyłał wrażliwe dane użytkownika do serwera atakującego po jednym kliknięciu linku phishingowego, a następnie kontynuował choćby po zamknięciu sesji AI. Ten mechanizm działał tak długo, jak długo sesja Copilota była aktywna, bez konieczności dodatkowej interakcji użytkownika i bez żadnych podejrzanych pluginów czy rozszerzeń – co czyniło go wyjątkowo groźnym.

Jak działał atak

Atak opierał się na sposobie, w jaki Copilot interpretuje parametry URL. W normalnym użyciu parametr q w adresie URL może automatycznie wypełnić pole zapytania Copilota, co upraszcza interakcje i automatyzację. Jednak Varonis opracował technikę, która używała tego mechanizmu do wstrzykiwania poleceń, które Copilot traktował jak zwykłe zapytanie użytkownika – a następnie wykonywał natychmiast po załadowaniu strony.

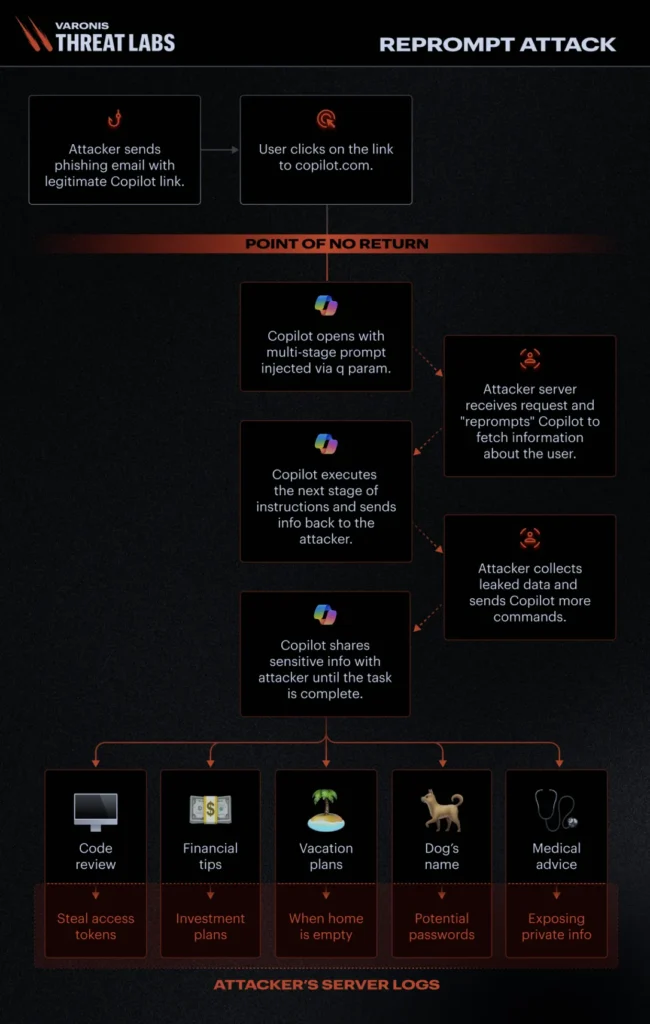

Atak łączył trzy główne techniki. Pierwsza to Parameter 2 Prompt (P2P) – wstrzyknięcie instrukcji poprzez parametr q. Druga to tak zwana double-request – wielokrotne żądania wprowadzające Copilota w stan, w którym omija wbudowane zabezpieczenia. Trzecia technika to chain-request, czyli łańcuch kolejnych poleceń serwera atakującego, które Copilot wykonywał krok po kroku, stale eskalując ilość wykradanych informacji. Oznacza to, iż po otwarciu spreparowanego linku atakujący serwer mógł wysyłać kolejne instrukcje do Copilota, ustawiając je dynamicznie na podstawie wcześniejszych odpowiedzi, co skutkowało stopniową, ukrytą eksfiltracją danych. Poniżej schemat ataku:

Źródło: varonis.com

Źródło: varonis.comCo dokładnie można było ukraść

Według Varonis możliwe było uzyskanie dostępu do szerokiego zakresu informacji osobistych i kontekstowych – takich jak lista plików, które użytkownik ostatnio przeglądał, lokalizacja geograficzna czy choćby prywatne treści rozmów. Tego typu informacje mogą być wykorzystywane dalej w kampaniach phishingowych, socjotechnicznych lub jako punkt wyjścia dla kolejnych ataków ukierunkowanych.

Kluczowe jest, iż Reprompt działał również wtedy, gdy Copilot był zamknięty, jeżeli tylko sesja pozostawała aktywna. Oznacza to, iż sam fakt zamknięcia karty lub aplikacji nie przerywał wycieków, co znacząco utrudniało wykrycie incydentu.

Dlaczego atak był tak trudny do wykrycia

Reprompt wyróżniał się tym, iż nie generował typowych sygnatur malware’a, nie wymagał instalacji złośliwego kodu ani dodatkowych integracji. Standardowe narzędzia monitorujące mogą nie wychwycić tego typu ataku, ponieważ polecenia i odpowiedzi Copilota przepływają wewnątrz normalnego ruchu aplikacji, a adekwatne instrukcje są dostarczane dopiero z zewnętrznych serwerów atakujących po kliknięciu linku.

Co więcej, mechanizmy ochronne Copilota były skoncentrowane przede wszystkim na pierwszym zapytaniu i nie przewidywały tak dynamicznych i sekwencyjnych żądań z serwera, co umożliwiło atakującym ominięcie wbudowanych zabezpieczeń i kontynuację wycieku danych w kolejnych etapach ataku.

Rekomendacje dla użytkowników i organizacji

Eksperci Varonis oraz niezależni badacze zgadzają się, iż taki rodzaj podatności wymaga proaktywnego podejścia do bezpieczeństwa AI. Dla użytkowników indywidualnych najważniejsza jest ostrożność przy klikania linków, które automatycznie ładują treść lub instrukcje dla AI, szczególnie jeżeli pochodzą one z nieznanych lub podejrzanych źródeł.

Użytkownicy powinni też regularnie aktualizować swoje narzędzia AI do najnowszych wersji, aby mieć pewność, iż znane luki zostały załatane. W przypadku firm, które wdrożyły Copilota, zalecane jest również monitorowanie anomalii dostępu oraz integracja logów AI z systemami SIEM i detekcji anomalii, co może pomóc wychwycić nietypowe żądania lub wzorce behawioralne.

Podsumowanie

Varonis zgłosił podatność Microsoftowi w sierpniu 2025 roku, a firma z Redmond wdrożyła poprawkę w aktualizacjach z Patch Tuesday 13 stycznia 2026 roku, eliminując lukę Reprompt z wersji Copilot Personal. Według komunikatów Microsoftu użytkownicy wersji korporacyjnej (Microsoft 365 Copilot) nie byli dotknięci tą konkretną podatnością, co odzwierciedla różnice w modelu bezpieczeństwa i implementacji tych wersji.

To zdarzenie przypomina, iż AI-asystenci, tak popularni w codziennej pracy, mogą stać się wektorem wycieku danych, jeżeli ich mechanizmy interpretowania zewnętrznych instrukcji nie są odpowiednio zabezpieczone.

Odkrycie Reprompt stanowi istotny sygnał, iż bezpieczeństwo asystentów AI musi obejmować nie tylko ochronę przed tradycyjnymi atakami na aplikacje webowe, ale także analizę sposobów, w jakie dane wejściowe z zewnątrz (takie jak parametry URL) wpływają na ich zachowanie. choćby link, który wydaje się pochodzić od zaufanego dostawcy, może ukrywać sekwencję instrukcji, które AI wykona w sposób niezamierzony przez użytkownika.

Dla specjalistów bezpieczeństwa jest to przypomnienie, iż modelom AI trzeba patrzeć na ręce, a strategie obronne powinny obejmować zarówno filtrację wejścia, jak i monitorowanie zachowań, które nie wynikają z jawnych zapytań użytkownika – bo to właśnie tam często kryje się największe ryzyko.