W ciągu ostatniego roku generatywna sztuczna inteligencja i ChatGPT przez cały czas zyskiwały na znaczeniu w toczącej się walce pomiędzy atakującymi i obrońcami. Chociaż wiele branż w wciąż bada możliwości wykorzystania sztucznej inteligencji w zakresie zwiększenia swoich możliwości, cyberprzestępcy dostrzegli również potężny potencjał AI w zakresie wykorzystywania luk w zabezpieczeniach i tworzenia nowych wektorów ataków.

Na początku 2023 r. Check Point Research ujawnił pierwsze sygnały świadczące o zainteresowaniu cyberprzestępców wykorzystaniem ChatGPT do tworzenia złośliwego oprogramowania, narzędzi szyfrujących i innych wektorów ataków. Rosyjscy cyberprzestępcy natychmiast rozpoczęli dyskusję na temat tego, jak ominąć wszelkie ograniczenia, aby rozpocząć korzystanie z ChatGPT w nielegalnych celach.

Rok po uruchomieniu ChatGPT obserwujemy, iż wykorzystanie generatywnej sztucznej inteligencji stało się nową normą w przypadku wielu usług cyberprzestępczych, szczególnie w obszarze podszywania się i inżynierii społecznej. Część z nich zdała sobie sprawę z potencjału generatywnej sztucznej inteligencji jako wyróżnika umożliwiającego zwiększenie efektywności swoich usług i choćby się tym przechwala.

Analitycy firmy Check Point przedstawili cztery rosyjskie „undergroundowe” usługi oparte na sztucznej inteligencji, które wykorzystują wbudowaną generatywną sztuczną inteligencję jako część swoich nielegalnych narzędzi i platform. Są to:

- Platforma Black-Hat do podszywania się w mediach społecznościowych na dużą skalę

- Usługa Deepfakes

- Narzędzie do złośliwego spamu

- Usługi weryfikacji KYC

Przypadek 1: Platforma Black-Hat oparta na sztucznej inteligencji do podszywania się w mediach społecznościowych

Fałszywe konta w mediach społecznościowych stanowią poważne zagrożenie dla cyberbezpieczeństwa ze względu na ich potencjał do szkodliwych działań, podszywania się pod markę, szerzenia dezinformacji i wielu innych.

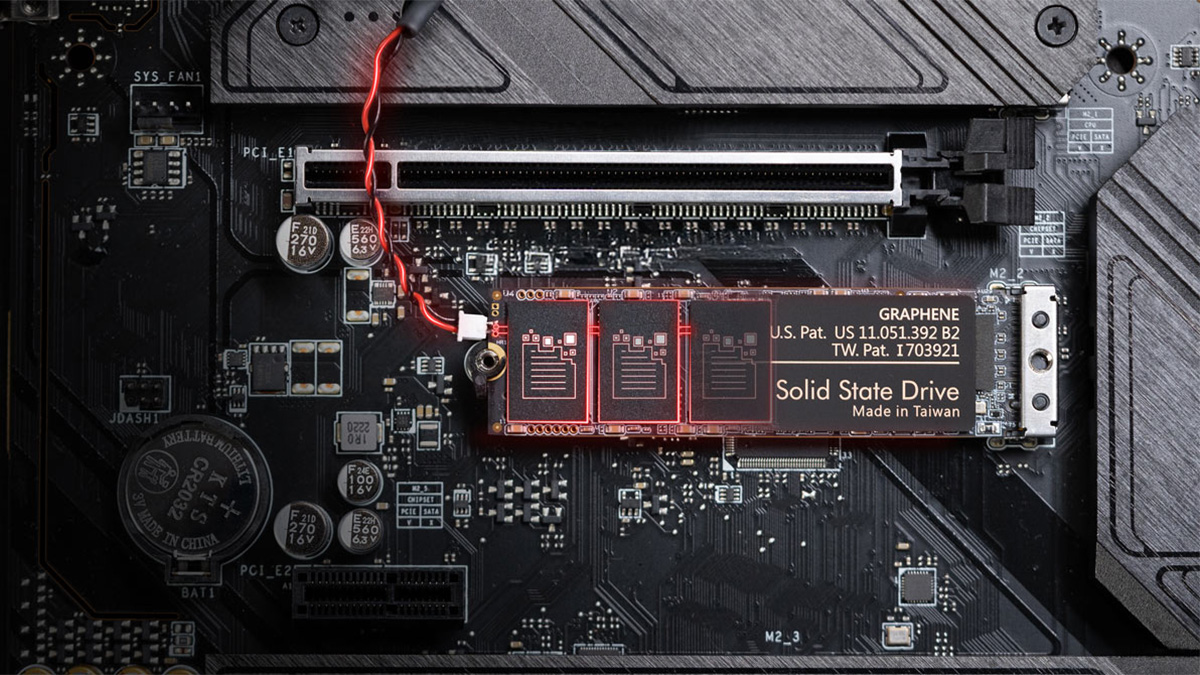

W grudniu 2023 r. doświadczone ugrupowanie cyberprzestępcze, posiadający oficjalny status sprzedawcy na „renomowanym” rosyjskim podziemnym forum, zaoferowało gotową platformę wykorzystującą sztuczną inteligencję jako podstawowy moduł do generowania treści dla platform mediów społecznościowych, takich jak Instagram, Facebook, Twitter i Telegram. Można ją wykorzystać do niemal całkowitej automatyzacji obsługi fałszywych kont w mediach społecznościowych.

Rysunek 1 – Platforma Black Hat oparta na sztucznej inteligencji (oryginalny tekst na wszystkich zrzutach ekranu jest w języku rosyjskim)

Rysunek 1 – Platforma Black Hat oparta na sztucznej inteligencji (oryginalny tekst na wszystkich zrzutach ekranu jest w języku rosyjskim)W przykładach działania grupa pokazała wygenerowane treści fałszywych modelek. W innym przypadku wygenerowano serię fałszywych profili imitujących profile odnoszących sukcesy traderów finansowych.

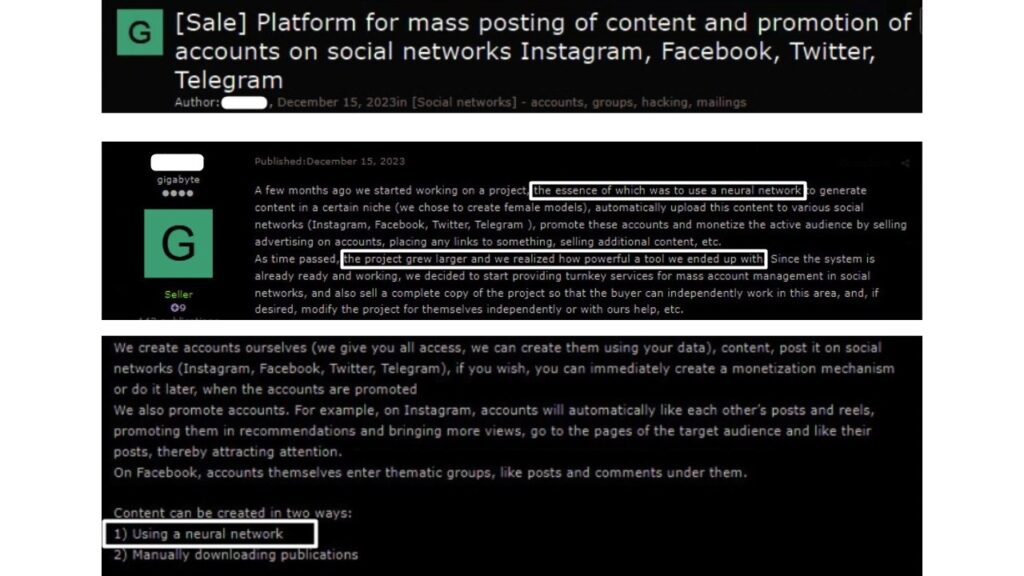

Rysunek 2 – Przykład treści automatycznie generowanych przez sztuczną inteligencję dla mediów społecznościowych.

Rysunek 2 – Przykład treści automatycznie generowanych przez sztuczną inteligencję dla mediów społecznościowych.Podmiot zagrażający wyjaśnił, iż dopiero podczas pracy na swojej platformie zdał sobie sprawę, jak potężne są te narzędzia. W związku z czym zaoferował dwa modele biznesowe:

- Zarządzanie fałszywymi kontami w mediach społecznościowych jako usługa — ugrupowanie zagrażające wraz ze swoim zespołem tworzy wszystkie niezbędne konta na Instagramie, Facebooku, Telegramie i Twitterze. Następnie automatycznie generują treści i promują konta, aby zapewnić im widoczność i poczucie autentyczności, dołączając do odpowiednich grup, „polubiąc” konta o podobnej tematyce itp. Jako dowód autorzy pokazali przykład 20 kont modelek, które zostały stworzone i uruchamiane przy użyciu sztucznej inteligencji.

Platforma może jednocześnie tworzyć treści dla ponad 200 kont i generować codzienne posty, karuzele itp. Konta zarządzane przez sztuczną inteligencję przyciągają obserwujących, a ruch ze wszystkich kont może zostać wykorzystany do wszelkich szkodliwych celów.

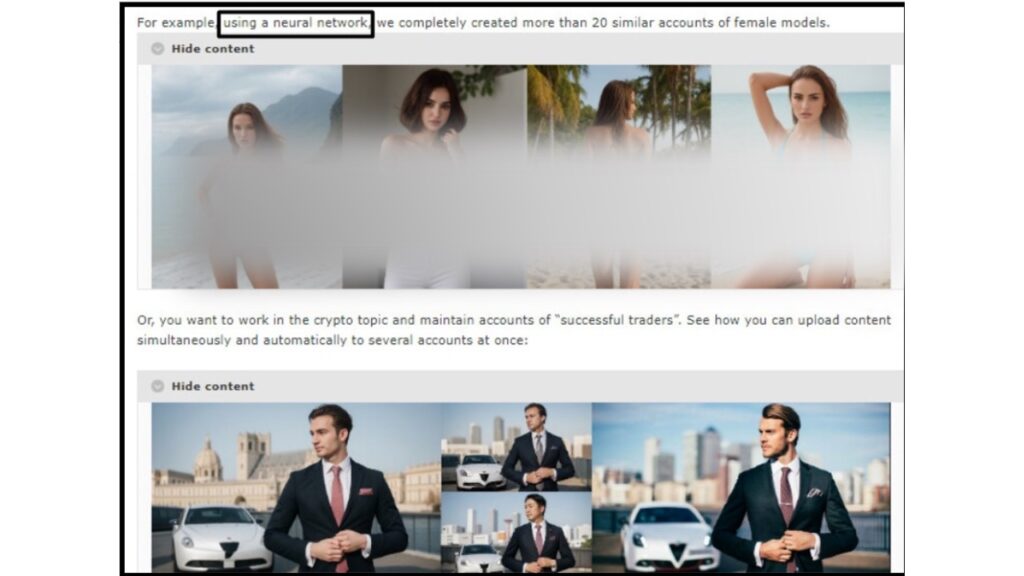

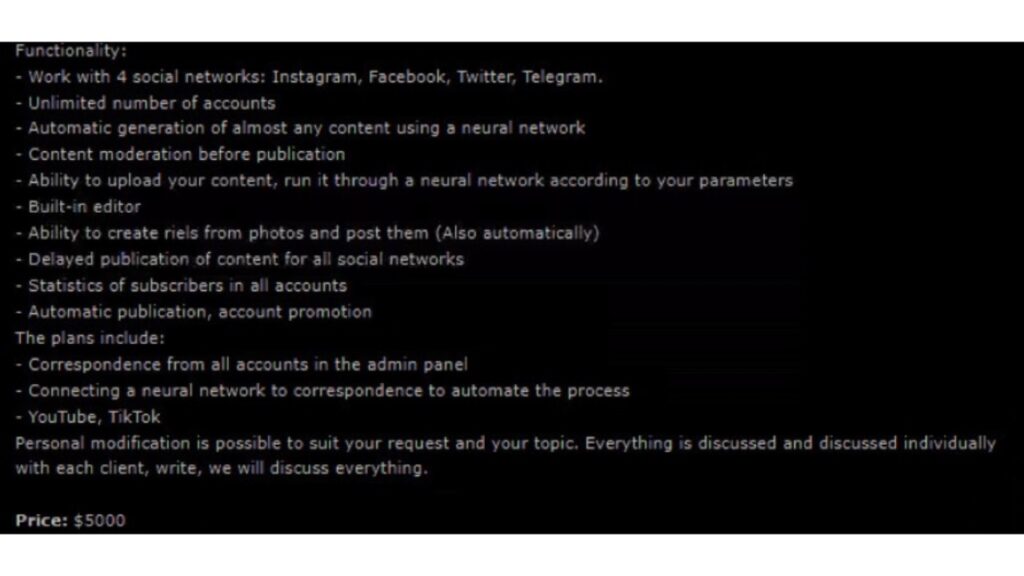

Ta zarządzana usługa kosztuje 50 USD za jedno konto na Instagramie miesięcznie, a pakiet połączonych fałszywych kont w mediach społecznościowych w 4 sieciach kosztuje 70 USD. Minimalne wymagane zamówienie dotyczy 10 kont. - Samodzielna platforma – platforma jest sprzedawana „tak jak jest”, a kupujący samodzielnie zarządza wszystkimi kontami opartymi na sztucznej inteligencji. Jedną z podstawowych cech własności platformy jest możliwość przesyłania treści i wzbogacania ich dzięki sztucznej inteligencji. Cena platformy wynosi 5000 dolarów.

Rysunek 3 – Integracja AI z platformą

Rysunek 3 – Integracja AI z platformąPrzypadek 2: Usługa Deepfake oparta na sztucznej inteligencji

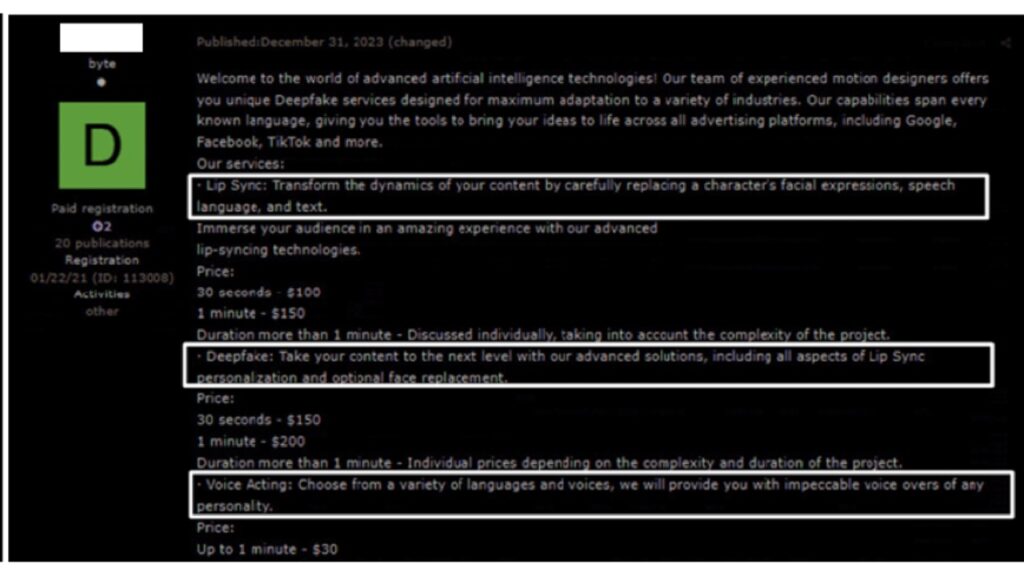

31 grudnia, w noc sylwestrową, na głównym rosyjskim forum podziemnym wprowadzono kolejną usługę do podszywania się. Koncentruje się ona na świadczeniu usług deepfake opartych na sztucznej inteligencji w trzech obszarach:

- Lip Sync – za 100 $ za 30 sekund treści.

- Deepfakes obejmujące synchronizację ruchu warg i wymianę twarzy – za 150 $ za 30 sekund.

- Tworzenie fałszywych wypowiedzi głosowych – za 30 dolarów za 1 minutę.

Rysunek 4 – Usługa Deepfakes

Rysunek 4 – Usługa DeepfakesKorzystanie z usług opisanych w przypadkach 1 i 2, oddzielnie lub w połączeniu, może wywrzeć wpływ w dwóch istotnych obszarach:

- Tworzenie fałszywych profili w mediach społecznościowych w celu promowania określonych programów lub produktów politycznych.

- Podszywanie się pod celebrytów lub dyrektorów firm, co może prowadzić do poważnych szkód w reputacji marki lub zainicjowania cyberataków.

Przypadek 3: Narzędzia i usługi wykorzystujące sztuczną inteligencję do złośliwego spamu

Złośliwy spam to jedna z najstarszych nielegalnych usług dostępnych na nielegalnych forach poświęconych cyberprzestępczości. Spam jest najczęstszym wektorem początkowym dla różnych celów scenariuszy ataków, takich jak phishing i zbieranie danych uwierzytelniających, dystrybucja złośliwego oprogramowania, oszustwa itp.

Jedna z tego typu usług została uruchomiona w listopadzie 2023 r. przez renomowane ugrupowanie cyberprzestępcze, które może poszczycić się ponad 15-letnim doświadczeniem w swojej działalności. Po otrzymaniu pozytywnych opinii na temat swoich usług ugrupowanie zaczęło wykorzystywać sztuczną inteligencję, w szczególności ChatGPT, do swoich usług spamowych.

Korzystanie z ChatGPT pomogło w losowym generowaniu tekstu spamu i zapewniło wyższy wskaźnik powodzenia.

Jak powiedział jeden z klientów tej usługi, usługa spamowa oparta na sztucznej inteligencji pomogła mu ominąć kontrole antyspamowe i antyphishingowe popularnych usług poczty internetowej i osiągnęła 70% współczynnika pomyślnych dostaw na docelowy adres e-mail.

Ile przeciętny haker musi zainwestować, aby skutecznie dostarczyć 70 000 złośliwych e-maili? Pakiet 100 000 wiadomości spamowych kosztuje 1250 USD (można zapłacić w Bitcoinach, Monero lub USDT).

Rysunek 5 – Cennik usług spamowych opartych na sztucznej inteligencji

Rysunek 5 – Cennik usług spamowych opartych na sztucznej inteligencjiPrzypadek 4: Usługi weryfikacji KYC

Procedury Know Your Customer (KYC) stały się standardową praktyką dla firm świadczących usługi finansowe ze względu na potrzebę zwiększonego bezpieczeństwa, ograniczania ryzyka i zgodności z przepisami.

KYC odgrywa również kluczową rolę w odzyskiwaniu dostępu do konta w przypadku, gdy prawowity właściciel nie jest w stanie skorzystać z tradycyjnych metod, takich jak resetowanie hasła. Firma zwykle wymaga od klientów przejścia procesu KYC w celu potwierdzenia ich tożsamości i upewnienia się, iż są legalnymi posiadaczami konta. Zwykle wiąże się to z przedstawieniem ważnych dokumentów tożsamości, takich jak dowód osobisty, paszport lub prawo jazdy, a także dodatkowymi etapami weryfikacji.

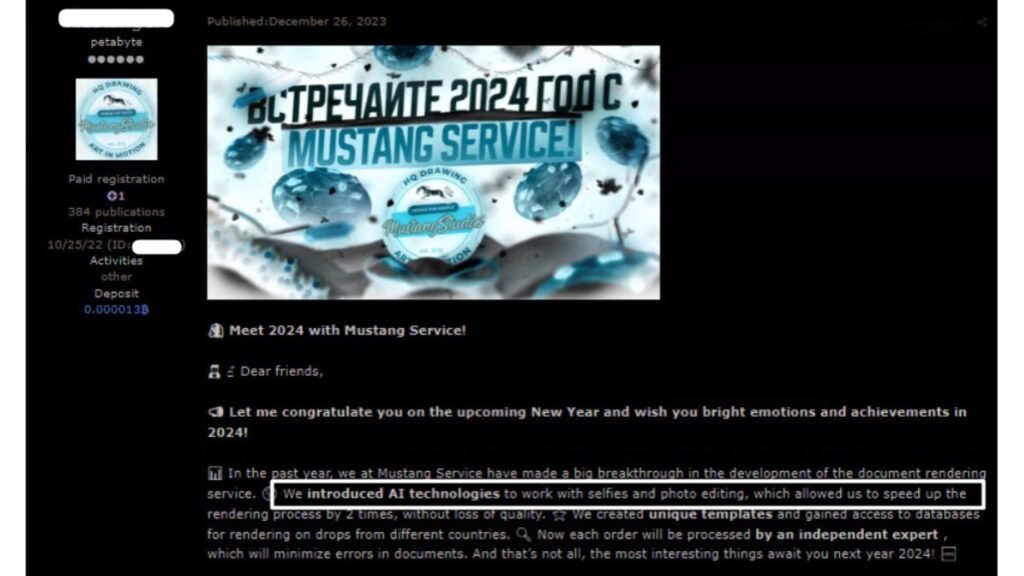

Istnieje cały podziemny rynek oferujący podejrzane usługi, takie jak tworzenie obrazów fałszywych dokumentów w celu weryfikacji. Wcześniej tego rodzaju cyberprzestępczość wykonywana była głównie poprzez ręczną manipulację odpowiednimi obrazami.

Teraz jednak jeden z dostawców usług KYC Darkweb zapewnił, iż niedawno zintegrował technologię AI, która znacznie przyspieszyła proces tworzenia fałszywych dokumentów weryfikacyjnych bez utraty jakości.

Rysunek 6 – Integracja AI w usługach edycji zdjęć dla KYC

Rysunek 6 – Integracja AI w usługach edycji zdjęć dla KYCSzybki rozwój technologii sztucznej inteligencji stwarza nowe możliwości i wyzwania w obszarze cyberbezpieczeństwa. Chociaż sztuczna inteligencja może nam pomagać, np. wykrywając złośliwe oprogramowanie czy zabezpieczając systemy, pozwala jednocześnie cyberprzestępcom na zwiększenie skali swoich działań.

Cyberprzestępcy mogą teraz wykorzystać moc sztucznej inteligencji do tworzenia bardziej wyrafinowanych schematów inżynierii społecznej, szybszego znajdowania luk w zabezpieczeniach sieci, tworzenia syntetycznych nośników do zastraszania lub kradzieży tożsamości oraz automatyzowania prób phishingu i tworzenia złośliwego oprogramowania.

źródło: Check Point