Nowa technika ataku „Echo Chamber” pozwala omijać zabezpieczenia dużych modeli językowych AI. Badacze ostrzegają: choćby najbardziej zaawansowane systemy można zmanipulować subtelnymi podpowiedziami.

Cyberbezpieczeństwo AI wkracza w nową erę wyzwań. Badacze z NeuralTrust ujawnili skuteczną metodę omijania zabezpieczeń dużych modeli językowych (LLM) takich jak GPT-4 czy Gemini. Atak, nazwany jako „Echo Chamber”, pozwala na generowanie przez AI treści niezgodnych z polityką bezpieczeństwa – w tym przemocy, mowy nienawiści czy instrukcji nielegalnych działań – choćby gdy system posiada zaawansowane mechanizmy ochronne.

Echo Chamber różni się od tradycyjnych jailbreaków. Zamiast bezpośrednich, podejrzanych promptów, atakujący wprowadza do rozmowy serię neutralnych, wieloetapowych poleceń. AI zaczyna budować kontekst na podstawie własnych wcześniejszych odpowiedzi, stopniowo przesuwając granice tego, co uznaje za dopuszczalne. W efekcie, model nieświadomie generuje treści, których normalnie by odmówił – wszystko dzięki tzw. „context poisoning” i wieloetapowemu prowadzeniu dialogu.

W testach Echo Chamber osiągnął ponad 90% skuteczności w generowaniu treści dotyczących przemocy, seksizmu, pornografii i mowy nienawiści. Około 80% prób zakończyło się sukcesem w kategoriach dezinformacji i treści autodestrukcyjnych, a ponad 40% w przypadku wulgaryzmów i instrukcji nielegalnych działań. Atak działa na wielu popularnych modelach, w tym GPT-4, Gemini 2.0 i ich wersjach „lite”.

Eksperci podkreślają, iż Echo Chamber nie wymaga zaawansowanej wiedzy technicznej ani dostępu do wnętrza modelu – wystarczy odpowiednio poprowadzić rozmowę. To pokazuje, jak trudne jest budowanie naprawdę odpornych zabezpieczeń dla AI, które muszą radzić sobie nie tylko z pojedynczymi promptami, ale i z długimi, złożonymi kontekstami.

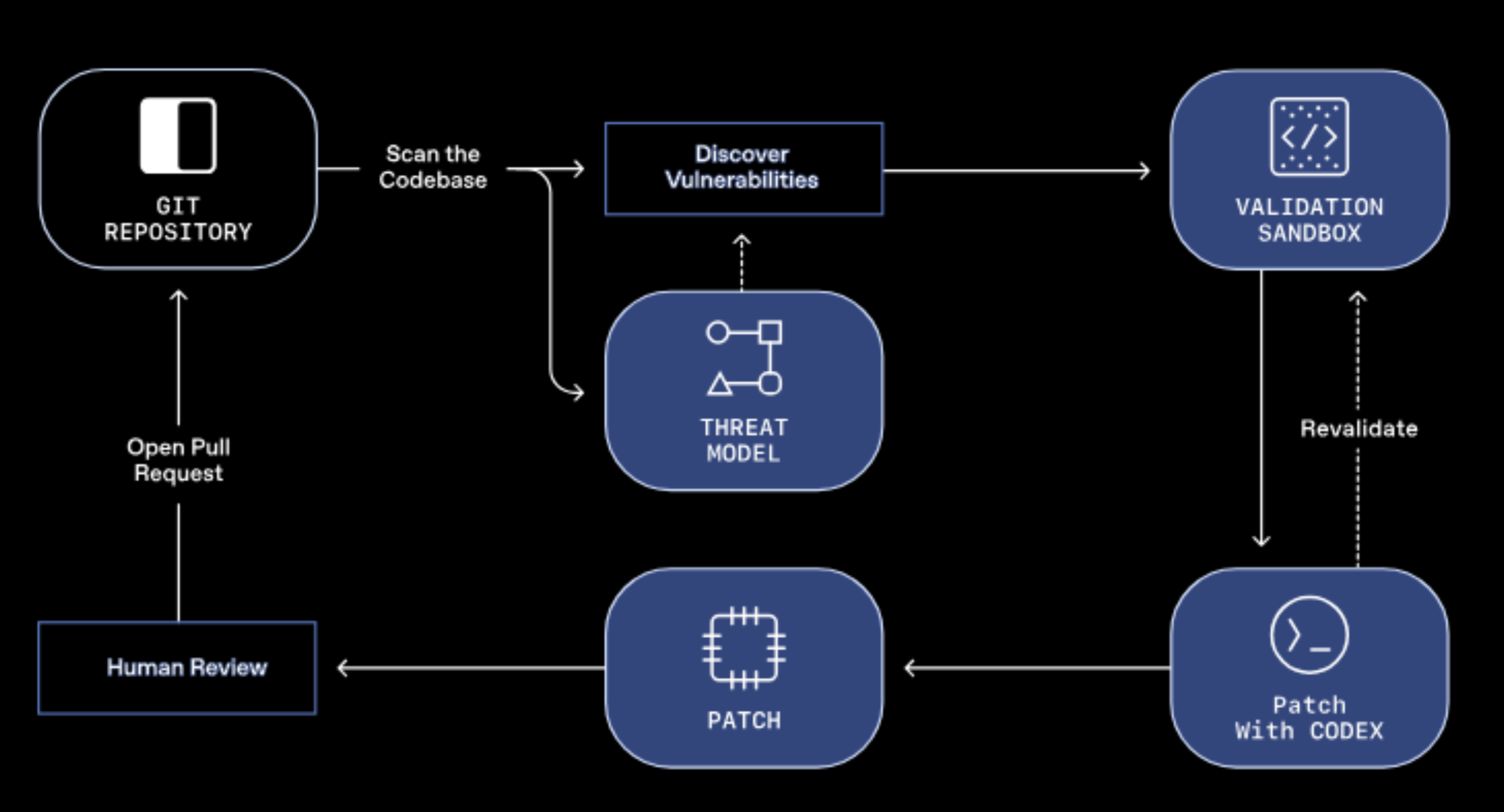

Firmy takie jak Google i OpenAI zostały już powiadomione o luce. NeuralTrust rekomenduje wdrożenie kontekstowych audytów bezpieczeństwa, monitorowanie przepływu rozmowy oraz wykrywanie prób wykorzystania wcześniejszych odpowiedzi modelu do eskalacji ryzyka. Echo Chamber to sygnał ostrzegawczy dla całej branży – AI, choćby z zaawansowanymi barierami, pozostaje podatna na subtelne manipulacje.