Kiedyś to były czasy – entuzjaści, pasjonaci i profesorowie debatowali o faktach i przypisach. Dziś w ramionach Wikipedii czai się nowy wróg: armia botów AI, które zasypują serwery niedokładnymi tekstami i spreparowanymi cytowaniami. Ich falę masowych, półautomatycznych wstawek redaktorzy porównują do inwazji wirusa.

W uproszczeniu: pojawiają się nowe hasła o wschodzących gwiazdach technologii, których nikt nigdy nie widział, z odwołaniami do nieistniejących publikacji. To nie tylko psuje wizerunek największej internetowej skarbnicy wiedzy, ale także zajmuje cenny czas tysiącom wolontariuszy zmuszonych do żmudnego sprawdzania czy breathtaking innovation rzeczywiście ma podstawy w rzeczywistości.

Speedy deletion – miecz obosieczny

Społeczność wprowadziła przyspieszoną procedurę kasowania wątpliwych artykułów by ratować encyklopedię. Zamiast tygodniowej dyskusji administrator może od razu wyrzucić wpis, gdy wykaże on trzy główne cechy podróbki AI: brak weryfikowalnych źródeł, wyróżniający się styl (pełen pauz, przesadzonych przymiotników i pokręconych cudzysłowów) oraz fakt, iż autor nie zareagował na wezwanie do poprawy.

To też jest ciekawe:

Brzmi surowo, ale bez tego narzędzia setki nowych, ekskluzywnych haseł – od fikcyjnych telefonów po wymyślone startupy – zaczęłyby żyć własnym życiem. Krytycy jednak ostrzegają: zbytni pośpiech może sprawić, iż bezlitośnie wylecą prawdziwe, rzetelne inicjatywy właśnie wtedy, gdy niedoświadczeni redaktorzy pomylą je z chałturnictwem AI.

Lista grzechów głównych AI: od pauz po moreover

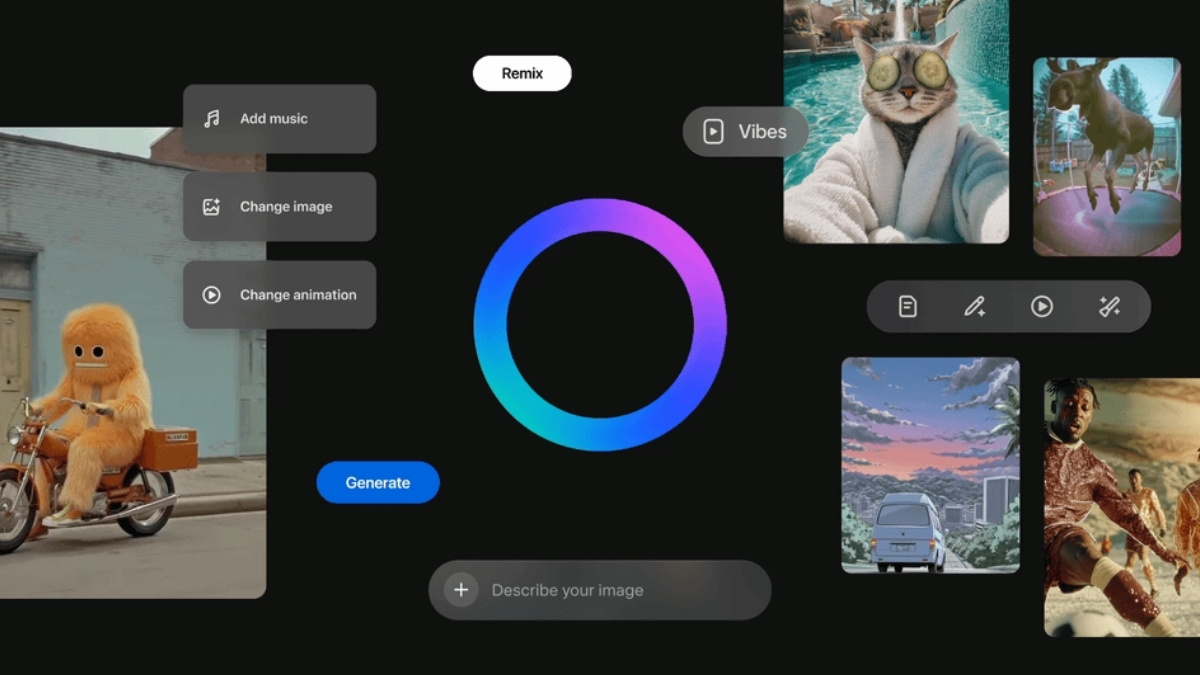

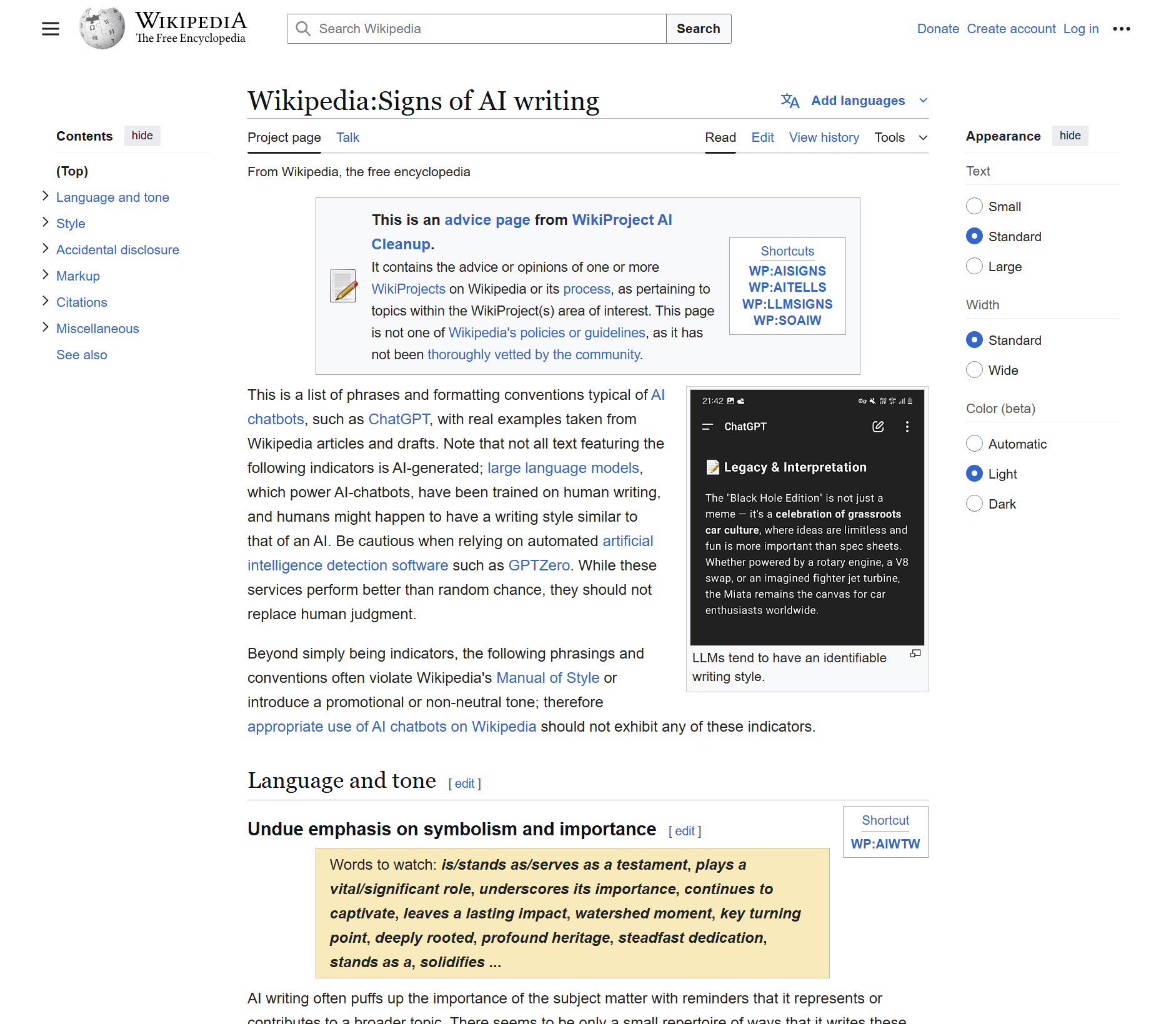

Inicjatywa Wiki AI Cleanup zebrała w jednym miejscu zbiór typowych oznak slop content. Przykładowo nadmierne użycie myślników (—), finezyjne przymiotniki (breathtaking, transformative) czy zbyt akcentowane łączniki (moreover) trafiają na czarną listę. Dodaj do tego pomylone cudzysłowy i mamy gotowy przepis na usunięcie.

Poradnik Wikipedii do wykrywania bzdur od AI

Poradnik Wikipedii do wykrywania bzdur od AIWarto podkreślić iż sama obecność tych elementów nie decyduje o kasacji – to sumaryczny sprawdzian: czy da się zweryfikować źródło, czy autor poprawił swoje błędy po zgłoszeniu i czy tekst nie przypomina zbioru fraz z modelu językowego. jeżeli wykryją podejrzaną sieć tych symptomów dopiero wówczas praca jest usuwana.

Wikimedia Foundation rozdarta między innowacją a tradycją

Zarząd nad encyklopedią, czyli Wikimedia Foundation, obserwuje ten konflikt z mieszaniną obaw i nadziei. Z jednej strony zatrzymano testy automatycznych streszczeń generowanych AI – społeczność uznała je za zagrożenie wiarygodności. Z drugiej: Fundacja widzi potencjał w narzędziach opartych na uczeniu maszynowym, które pomogą wykrywać wandalizmy czy asystować redaktorom przy powtarzalnych zadaniach. W planach jest więc nie tylko Speedy deletion, ale także narzędzie Edit Check, które w podpowiedziach podkreśli brakujące cytowania i wyłapie nadmiernie marketingowy ton zanim tekst trafi na front redakcyjnej bitwy.

Już teraz w testach znajduje się funkcja Paste Check – prośba o potwierdzenie autorstwa w przypadku wklejenia dłuższego fragmentu tekstu. Pomysłowi zwolennicy AI proponują choćby zaznaczanie które części opracowania generował chatbot. To dobry przykład współpracy: społeczność zgłasza potrzebę przejrzystości, a Fundacja buduje narzędzia, by ją wspierać.

Wielka oblężenie oazy prawdy i wolności trwa – czy zwyciężą człowiek i rozum, czy armie AI zaleją nas pustymi cytatami? Wydźwięk tej bitwy odbije się echem w każdym kolejnym wpisie, ale jedno jest pewne: Wikipedia już nigdy nie będzie taka sama.

*Zdjęcie otwierające: DIA TV / Shutterstock