Wdrożenie generatywnej wersji sztucznej inteligencji (AI) powoduje gwałtowny wzrost popytu na energię przez tę formę nowych technologii. To obciąża sieci elektroenergetyczne i generuje emisję CO2, co może opóźnić zieloną transformację. Generowanie odpowiedzi przez ChatGPT zużywa znacznie więcej energii niż dotychczasowe aktywności w internecie, takie jak zapytania w wyszukiwarkach lub przechowywanie w chmurze. AI pochłania energię? – jak rozwiązać ten problem?

Według raportu Goldman Sachs, zapytanie ChatGPT zużywa prawie 10 razy więcej energii elektrycznej niż wyszukiwanie informacji w Google. Ta pierwsza aktywność konsumuje mniej więcej tyle energii, ile żarówka zużywa przez ok. 20 minut. Kalkulacje te potwierdza Międzynarodowa Agencja Energetyczna. Instytucja szacuje, iż pojedyncze zapytanie ChatGPT wymaga zużycia 2,9 watogodzin energii elektrycznej, podczas gdy wyszukiwanie w Google tylko 0,3 watogodziny.

Energochłonne jest też wytrenowanie algorytmów. W przypadku Chat GPT-3 odpowiadało to rocznemu zużyciu energii przez 130 gospodarstw domowych w USA, ale dla GPT-4 było to już 50 razy więcej.

Energochłonne centra danych

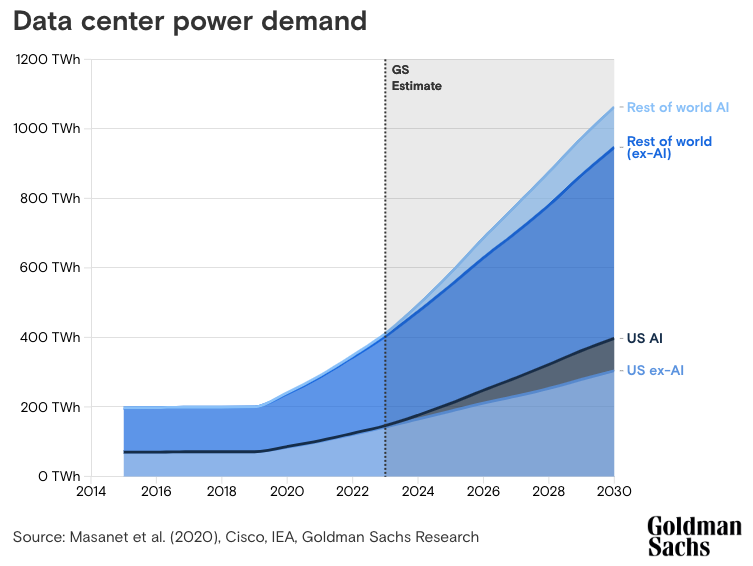

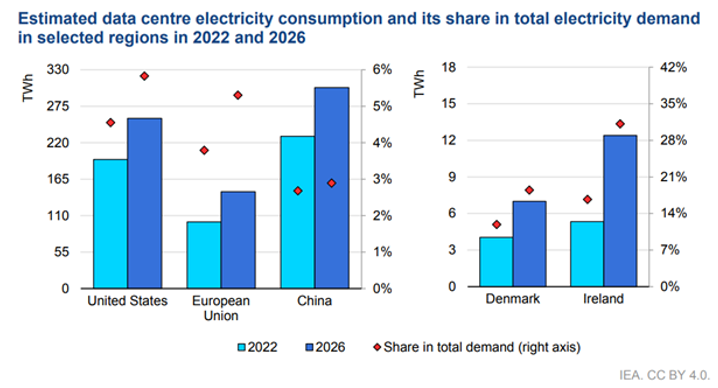

Sztuczna inteligencja oparta jest na przetwarzaniu dziesiątek a choćby setek miliardów danych, więc największym ich konsumentem stały się centra danych. w tej chwili zużywają one 1–2% całkowitej energii na świecie, ale ten odsetek może wzrosną do 3–4% do końca dekady. W USA i Europie zwiększony popyt napędzać będzie wzrost zużycia energii elektrycznej.

W odniesieniu do USA Goldman Sachs przewiduje, iż w roku 2030 centra danych zużywać będą 8% całkowitej energii w kraju, w porównaniu z 3% w 2022 roku. To przełoży się na dwukrotny wzrost emisji dwutlenku węgla. Społeczny koszt emisji CO2 szacowany jest choćby na 140 mld dolarów pod koniec obecnej dekady. Do tego należy dodać hektolitry wody zużywane na chłodzenie centrów danych.

Na grafice Goldman Sachs poniżej widać, jak bardzo wzrośnie w perspektywie końca obecnej dekady zużycie energii w związku z wprowadzeniem na rynek pod koniec 2022 r. ChatGPT, a potem kolejnych modeli generatywnej sztucznej inteligencji:

Molochy wciąż głodne energii

Za tymi niepokojącymi danymi stoi głównie rozwój sztucznej inteligencji przez wielkie amerykańskie firmy technologiczne. Na początku lipca firma Google opublikowała obszerny raport dotyczący zrównoważonego rozwoju firmy.

Gigant technologiczny przyznaje, iż emisja gazów cieplarnianych wzrosła w zeszłym roku o niemal połowę od 2019 r. Wynika to ze wzrostu zużycia energii w centrach danych i większych emisji w łańcuchach dostaw, czyli u producentów infrastruktury. Firma twierdzi jednak, iż przez cały czas dąży do osiągnięcia celu zerowej emisji netto w 2030 r. Może to jednak okazać się trudne.

Inny technologiczny olbrzym, promotor start-upu OpenAI, Microsoft w swoim raporcie z maja jest bardziej ambitny. Firma deklaruje, iż do 2030 r. osiągnie wręcz… ujemną emisję dwutlenku węgla. Oznacza to działania zmierzające do usuwania dwutlenku węgla z atmosfery. Firma twierdzi też, iż jest mniej emisyjna od Google, gdyż jej emisje od 2020 r. wzrosły o niecałe 30%.

Wydajniejsza infrastruktura

Sztuczna inteligencja ma jednak możliwości oszczędzania zużycia energii i redukcji emisji gazów cieplarnianych. Firma konsultingowa BCG przewiduje, iż dzięki zastosowaniu AI emisja może spaść od 5% do 10% do końca tej dekady. Ma za tym stać wiele działań, które obniżą konsumpcję energii przez sztuczną inteligencję i infrastrukturę, która za nią odpowiada.

Projektowany jest specjalistyczny sprzęt jak nowe akceleratory, układy scalone 3D. Nowe urządzenia mają oferować znacznie lepszą wydajność oraz nowe techniki chłodzenia. Ich najważniejszy producent – Nvidia – twierdzi, iż nowy superchip zapewni osiągnięcie aż 30-krotnej poprawy wydajności podczas uruchamiania generatywnych usług AI. Zużyje przy tym 25 razy mniej energii.

Centra danych stają się również coraz bardziej wydajne. Nowe technologie chłodzenia i lokalizacje mogą wykonywać więcej obliczeń, gdy energia jest tańsza, bardziej dostępna i bardziej zielona. To pozwoli na lepsze planowanie zadań i rozlokowanie obciążeń. Operatorzy centrów danych powinni mieć pewność, iż ich ośrodki wykorzystują energię elektryczną ze źródeł odnawialnych. To zapewni optymalną stabilność sieci, wydajność i czystą energię w trybie 24/7.

Małe model językowe

Mniejsze zużycie energii można także osiągnąć poprzez racjonalizację zastosowań generatywnej AI. Nie wszystkie realizowane zadania wymagają bowiem jej stosowania. Zamiast używania wielkich modeli językowych (LLM) w wielu przypadkach można ograniczyć się do tych mniejszych (SLL).

Mają one znacznie mniej parametrów, zwykle mieszczących się w przedziale od kilku milionów do kilku miliardów, w porównaniu do modeli LLM, w których parametry wynoszą setki miliardów, a choćby więcej. Dysponują one mniejszą mocą obliczeniową, nie są więc tak energochłonne i mogą być stosowane na mniejszych urządzeniach.

Optymalizacja zużycia energii

AI może być sama stosowana do zarządzania podażą i popytem na energię elektryczną w wielu miejscach. Szacunki podawane przez Międzynarodową Agencję Energetyczną (IEA) sugerują, iż sztuczna inteligencja obsługuje już ponad 50 różnych zastosowań w systemie energetycznym, a rynek technologii w tym sektorze może być wart choćby 13 mld dolarów.

Wprowadzane inteligentne liczniki w sieciach elektroenergetycznych już generują i wysyłają do zakładów użyteczności publicznej kilka tysięcy razy więcej danych niż ich analogowe poprzedniczki. W ten sposób, w połączeniu z technologiami modelowania cyfrowego, sztuczna inteligencja oferuje niezrównaną widoczność dodatkowej mocy, która istnieje w liniach energetycznych na całym świecie. To droga do optymalizacji zużycia energii i jej przesyłu. Także w odniesieniu do energii odnawialnej.

Bardziej zielone bigtechy

W coraz większym stopniu korzystają z niej także Big Techy. Aby zmniejszyć emisję CO2, firmy technologiczne zawierają umowy na zakupy zielonej energii lub same inwestują w rozwój jej mocy. Google pierwszą umowę na zakup energii odnawialnej podpisał w 2010 roku. W zeszłym roku globalna średnia zużycia energii bezemisyjnej przez firmę wyniosła 64%. Co najmniej 10 regionalnych centrów danych firmy, w tym w Brazylii, we Francji, Wielkiej Brytanii i Szwajcarii, a także w Polsce działa wykorzystując w ponad 90%. energię bezemisyjną.

W 2023 r. gigant z Redmont podpisał rekordową umowę na rozwój projektów energetycznych o mocy 14 gigawatów. Także w zeszłym roku Google wraz i innymi firmami zagranicznymi działającymi w Polsce zaapelował do rządu o przyspieszenie rozwoju odnawialnych źródeł energii. Jej niewystarczająca podaż może hamować zagraniczne inwestycje w naszym kraju.

W Europie w związku z rozbudową centrów danych w ciągu 10 lat popyt na energię może wzrosnąć choćby o 40%. Niedostosowane są do tego linie przesyłowe, jedne z najstarszych na świecie a w tej chwili na naszym kontynencie ulokowanych jest 15% spośród wszystkich światowych centrów danych.

Przydatne dane z turbin

Tymczasem Google coraz bardziej interesuje się energią wiatrową. Globalna flota turbin wiatrowych produkuje ponad 400 mld danych rocznie. Korzysta z nich Google, który podpisał umowy na dostawy energii z farm wiatrowych offshore w Szkocji i Niderlandach. Jednak odchylenia w sile i kierunku wiatru mogą prowadzić do odmiennych od oczekiwanych poziomów mocy wyjściowej, co zwiększa koszty operacyjne turbin.

Aby temu zaradzić, spółka zależna Google – DeepMind – zajmująca się sztuczną inteligencją, opracowała sieć neuronową, aby zwiększyć dokładność prognoz dla floty odnawialnych źródeł energii. Technologiczny gigant może dzięki temu również sprzedawać z wyprzedzeniem swoją moc, zwiększając wartość finansową energii wiatrowej o 20%.

Więcej zastosowań AI, ale bilans ujemny

Sztuczna inteligencja może też pomagać w zarządzaniu efektywnością energetyczną wielu wysokoemisyjnych branż, od modelowania budynków w celu przewidywania zużycia energii i optymalizacji wydajności ogrzewania i klimatyzacji po poprawę energetycznej efektywności produkcji przemysłowej.

Na razie jednak trudno mówić o neutralnym bilansie energetycznym i ekologicznym sztucznej inteligencji. Być może taki neutralny bilans będzie osiągalny pod koniec obecnej dekady. Choć – niemal wykładniczy wzrost zapotrzebowania na moc przez AI nie napawa zbytnim optymizmem. Na razie AI pochłania energię w sposób nieopanowany…

Czytaj też: GenAI to walka gigantów z Doliny Krzemowej? Europejskie start-upy wchodzą do gry!

Czytaj też: Dziennikarstwo opierało się już dawno na zbiorach danych. Co zmienia ChatGPT?

Źródło zdjęcia: Matthew Henry/Unsplash