Firmowe bazy wiedzy bywają ogromne, rozproszone i trudne w wykorzystaniu. W ostatnich miesiącach mieliśmy okazję wdrażać asystentów AI opartych na LLM w różnych organizacjach — od ubezpieczeń, przez budownictwo i energetykę, aż po edukację. Dzięki temu zebraliśmy zestaw praktycznych lekcji, które są równie ważne dla inżynierów, jak i dla liderów biznesowych.

Podczas wystąpienia opowiem o tym, jak:

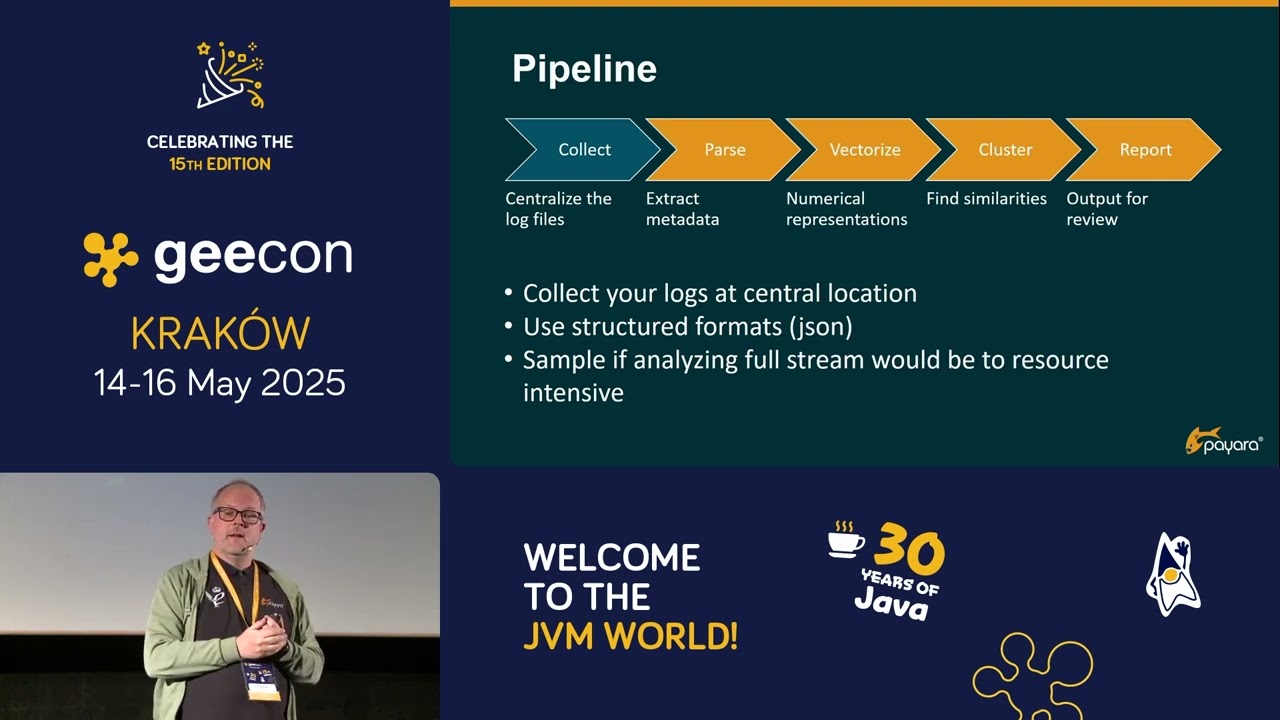

przygotować i uporządkować wiedzę pod kątem Retrieval-Augmented Generation (RAG),

dobrać konfigurację LLM i mechanizmów RAG, by odpowiedzi były trafne i użyteczne,

monitorować asystenta AI i oceniać jakość odpowiedzi

zadbać o bezpieczeństwo, zgodność i „guardrails”,

monitorować i optymalizować koszty (FinOps) tak, aby rozwiązanie było skalowalne.

Będzie to spojrzenie zarówno techniczne, jak i biznesowe — pokazujące, jak przełożyć nowe możliwości AI na realną wartość w organizacji.