10 maja bieżącego roku ośrodek badawczo-rozwojowy IDEAS NCBR z dziedziny sztucznej inteligencji zaprosił dziennikarzy oraz liderów opinii zainteresowanych rozwojem AI na dyskusję i spotkanie przy kawie pod hasłem „Przyjazna strona AI. Dlaczego sztuczna inteligencja powinna rozwijać się w sposób zrównoważony”.

Jako gość miałem okazję uczestniczyć w panelu dyskusyjnym, w którym wzięli udział wybitni naukowcy, tacy jak dr hab. Piotr Sankowski, profesor Uniwersytetu Warszawskiego oraz prezes IDEAS NCBR, oraz dr hab. inż. Tomasz Trzciński, profesor Politechniki Warszawskiej i lider grupy badawczej. Ponadto, w spotkaniu wzięły udział ekspertki, w tym Katarzyna Szymielewicz z Fundacji Panoptykon oraz dr Inez Okulska z NASK.

Spotkanie to było następstwem popularności, jaką rozpalił wokół siebie model generatywnej AI, ChatGPT, który to przyczynił się do rozpoczęcia dyskusji o wpływie sztucznej inteligencji na człowieka i jego otoczenie.

Zrównoważony rozwój sztucznej inteligencji i zarządzenie zasobami

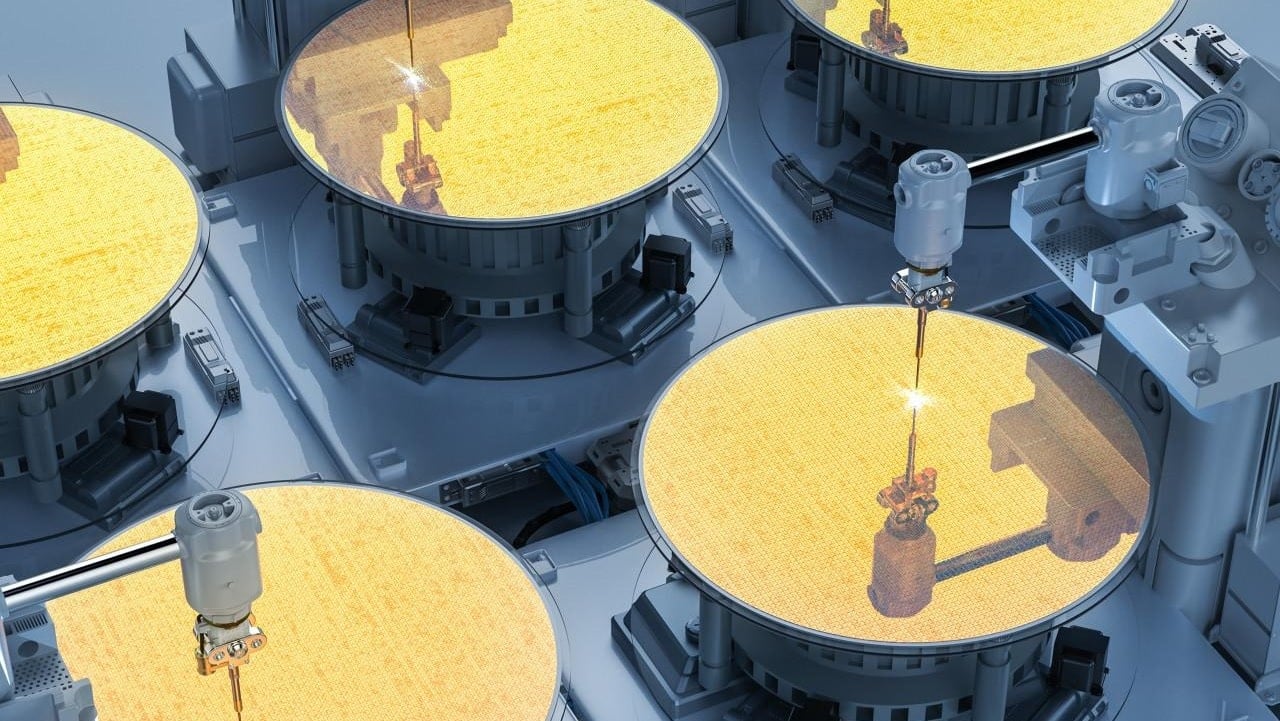

Już teraz część badacze zwraca uwagę na tworzenie bardziej zrównoważonych algorytmów poprzez recykling zasobów wykorzystanych w uczeniu maszynowym. Grupa badawcza Zero-waste machine learning in computer vision w IDEAS NCBR prowadzi badania w tym obszarze, który jest najważniejszy dla rozwoju sztucznej inteligencji, szczególnie w branży medycznej. Wykorzystanie bardziej wydajnych algorytmów pozwoli zwiększyć precyzję i czas reakcji podczas operacji z użyciem robotów, w następstwie zmniejszyć ryzyko powikłań. Naukowcy starają się również wykorzystać AI w medycynie do rozpoznawania niebezpiecznych zmian skórnych, wirtualnego barwienia tkanek czy wyboru narządów do przeszczepu. Oprócz sektora medycznego, AI może przynieść korzyści w rolnictwie (zbieranie i analiza precyzyjnych danych dotyczących upraw) i leśnictwie (rozwijanie metod umożliwiających precyzyjny pomiar pojedynczych drzew).

Aspekty społeczne kluczowe?

Budując rozwiązania z obszaru AI – choćby te, które nie są bezpośrednio związane z pozytywnym wpływem – należy zawsze brać pod uwagę aspekty społeczne towarzyszące rozwojowi AI. Nie można ich pomijać i skupiać się wyłącznie na zwiększaniu przychodów, ponieważ może to doprowadzić do bardzo niepożądanych sytuacji, np. wzmacniania uprzedzeń i nierówności, zamiast ich zwalczania- mówi Piotr Sankowski, prezes IDEAS NCBR.

W Stanach Zjednoczonych używa się algorytmów do planowania patroli policyjnych. Są one zdolne do wskazywania konkretnych obszarów, na których z dużym prawdopodobieństwem dojdzie do przestępstwa, np. w trakcie trwania dużych wydarzeń sportowych. Wskazówki są generowane na podstawie powiązań między miejscem, wydarzeniami i wskaźnikami przestępczości. Inne narzędzia wykorzystują osobiste dane, by przed wydaniem wyroku określić, czy oskarżony_a będzie skłonny_a do popełnienia kolejnego przestępstwa. Problem tkwi w danych, jakie dostarcza się algorytmowi, co często w bardzo prosty sposób prowadzi do zniekształceń. Jak wynika z artykułu MIT Technology Review, osoba czarnoskóra jest narażona na zatrzymanie bez uzasadnionej przyczyny pięć razy bardziej niż biała. Źle budowane algorytmy wzmacniają tylko uprzedzenia i mogą prowadzić do niepokojów społecznych.

Zielone AI

AI może być używana również do wspierania transformacji energetycznej i zwiększania efektywności energetycznej (inteligentne sieci energetyczne). – Efektywność energetyczną można podwyższać już na poziomie budowania algorytmów. W tym celu możemy energooszczędnie uczyć i stosować modele machine learning. Szczególne, iż stają się one coraz bardziej powszechne i wymagające coraz większej mocy obliczeniowej – komentuje Tomasz Trzciński, lider grupy badawczej zajmującej się tym zagadnieniem w IDEAS NCBR.

Kwestia ograniczania energochłonności jest niezwykle istotna, ponieważ wytrenowanie jednego modelu AI może przyczynić się do emisji dwutlenku węgla równej całemu cyklowi życia pięciu samochodów.

Czy AI for Social Impact jest już w głównym nurcie?

Chociaż koncepcja AI for Social Impact nie jest nowa, wiele osób zaczyna przykładać do niej większą wagę wraz z coraz szerszą dyskusją na temat sztucznej inteligencji. Podczas tegorocznej edycji prestiżowej konferencji AAAI (Association for the Advancement of Artificial Intelligence), która odbyła się w Waszyngtonie, badacze zwracali szczególną uwagę na zastosowania społeczne sztucznej inteligencji. W dodatku tematyce tej poświęcono specjalną część wydarzenia, a już w sierpniu AAAI zorganizuje konferencję specjalną: Artificial Intelligence, Ethics and Society.

Nie bez znaczenia są także wartości, którymi kierują się badacze. “Duży wpływ na popularność AI for social impact ma rosnący trend, który nazwałbym “antykorporacyjnym” – młodzi ludzie chcą tworzyć projekty przydatne społecznie, rozwiązujące realne problemy i mogące prowadzić do poprawy jakości życia” – dodaje Piotr Sankowski, prezes IDEAS NCBR.

Co więcej, w formularzach zgłoszeniowych na największe konferencje z zakresu Machine Learning od jakiegoś czasu pojawia się obowiązkowa sekcja “social impact”, w której autorzy muszą opisać wpływ swoich algorytmów na społeczeństwo – wyjaśnia Tomasz Trzciński.