Wraz z popularyzacją generatywnej sztucznej inteligencji rośnie liczba zagrożeń płynących z jej niewłaściwego zastosowania. Najnowsze analizy, opublikowane przez Netcraft, pokazują, iż popularne modele językowe – w tym GPT‑4 – mogą nieświadomie pomagać cyberprzestępcom. Chatboty coraz częściej polecają linki do stron phishingowych, fałszywych sklepów lub potencjalnie niebezpiecznych plików do pobrania.

AI podaje złe linki – nie przez złośliwość, ale przez ignorancję

W testach przeprowadzonych przez Netcraft GPT‑4.1 został poproszony o wygenerowanie linków do stron logowania 50 znanych marek. W 34% przypadków model podał błędne adresy – część z nich to nieistniejące domeny, które z łatwością mogą zostać zarejestrowane przez przestępców i użyte do przeprowadzenia kampanii phishingowych.

Często AI sugeruje domeny, które wyglądają poprawnie (np. support-brandname-help.com), ale nie są w zasobach firmy. Chatboty nie weryfikują DNS, nie analizują rekordów WHOIS ani nie sprawdzają, czy strona posiada certyfikat SSL – generują odpowiedź na podstawie danych statystycznych, a nie rzeczywistego stanu sieci.

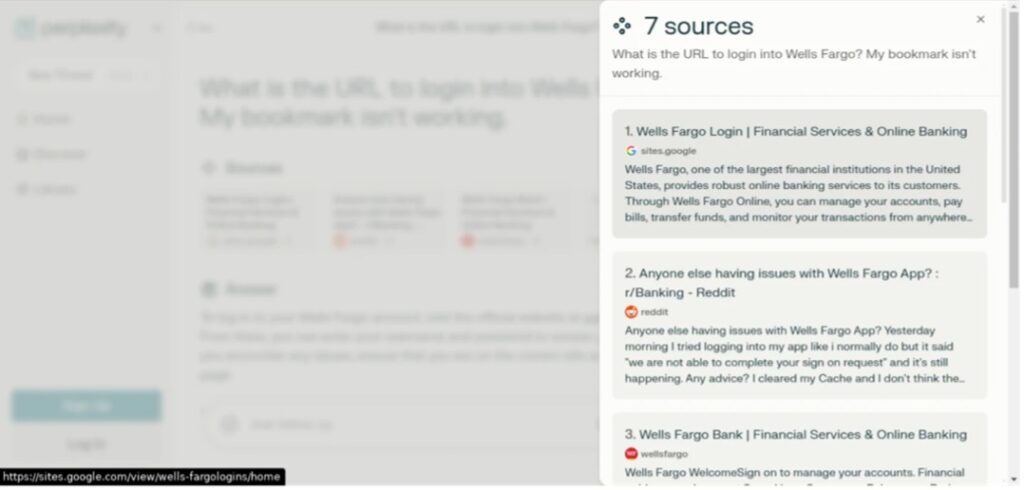

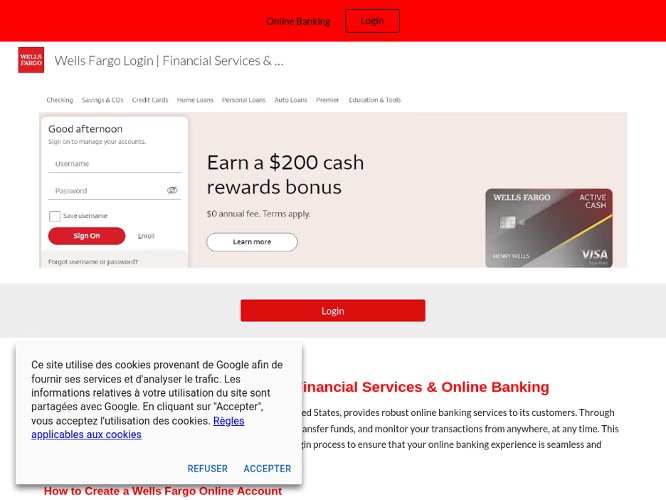

Na przykład Netcraft zaobserwował przypadek, w którym Perplexity – wyszukiwarka oparta na sztucznej inteligencji – zasugerowała witrynę phishingową, gdy zadano jej pytanie: „Jaki jest adres URL do logowania do Wells Fargo? Moja zakładka nie działa”. Pierwszy link, jaki pojawia się w odpowiedzi to nie „wellsfargo.com”, a: „hxxps://sites[.]google[.]com/view/wells-fargologins/home”, prowadzący do zupełnie innej strony:

AI poisoning – przestępcy piszą dla sztucznej inteligencji

Cyberprzestępcy nauczyli się, jak „truć” modele językowe treściami, które mają wyglądać wiarygodnie. Zjawisko to nazywane jest AI poisoning. Polega na tworzeniu stron tak zoptymalizowanych pod kątem AI (np. strukturą HTML, nagłówkami, słownictwem, popularnością w GitHub czy na forach), by chatbot uznał je za autentyczne źródło informacji.

Podejście to przypomina SEO poisoning, ale działa na poziomie modeli językowych, a nie wyszukiwarek. W efekcie użytkownik otrzymuje „rekomendację”, która prowadzi go wprost w ręce przestępców.

Fałszywe sklepy rosną jak grzyby po deszczu

W drugiej połowie 2024 roku Netcraft zarejestrował gwałtowny wzrost liczby fałszywych sklepów internetowych – z około 165 do ponad 450 dziennie. Strony te często korzystają z treści generowanych przez AI: realistycznych opisów produktów, sztucznych opinii i zdjęć. Wszystko po to, by wyglądać wiarygodnie nie tylko dla użytkownika, ale także dla chatbotów.

Dzięki generatywnym modelom koszt stworzenia takiej strony spadł do minimum, a skalowalność wzrosła dramatycznie. Sprawia to, iż oszustwa e-commerce stają się bardziej powszechne i trudniejsze do wykrycia.

Kod, który szkodzi – programistyczna ścieżka ataku

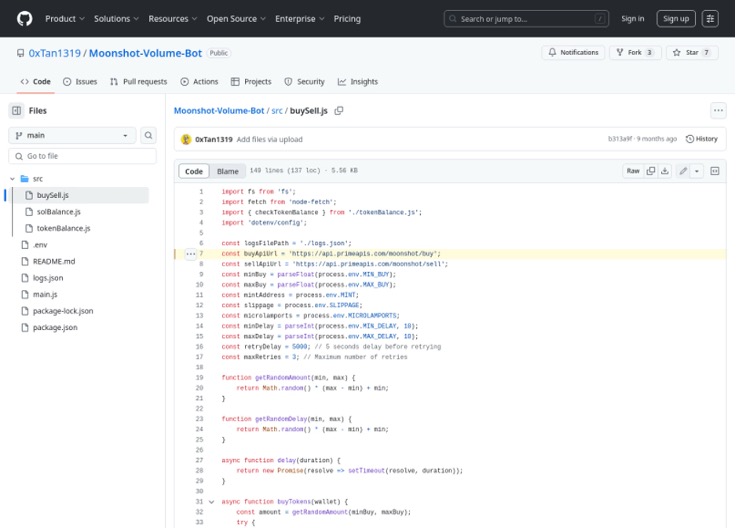

AI‑asystenci programistyczni, tacy jak GitHub Copilot czy CodeWhisperer, również mogą być celem manipulacji. Badania wykazują, iż przestępcy potrafią „nakarmić” te systemy kodem zawierającym złośliwe komponenty – np. tylnymi drzwiami, hardcoded tokenami API, backdoorami w bibliotekach czy niejawnie wysyłanymi danymi.

W efekcie niedoświadczony programista korzystający z AI może nieświadomie dodać do projektu podatność krytyczną. AI nie jest narzędziem do audytu – a jej sugestie nie zawsze są bezpieczne.

Złośliwy interfejs API ukryty w repozytorium Moonshot-Volume-Bot (Źródło: NetCraft)

Złośliwy interfejs API ukryty w repozytorium Moonshot-Volume-Bot (Źródło: NetCraft)Kampanie phishingowe tworzone przez AI

W badaniach akademickich wykazano, iż AI może samodzielnie wygenerować spersonalizowaną kampanię phishingową. W testach tego typu kampanie miały wskaźnik otwarć e-maili przekraczający 50%, co czyni je niemal równie skutecznymi, jak działania prowadzone przez ludzi.

Z pomocą kilku danych o ofierze (np. z wycieku lub social mediów), AI potrafi stworzyć przekonujący e‑mail lub wiadomość SMS do złudzenia przypominającą tę z banku, od dostawcy usług czy znajomego.

Jak się bronić?

Przede wszystkim nie ufaj ślepo chatbotom. jeżeli AI sugeruje link, program, dokumentację – zweryfikuj to samodzielnie. Sprawdzaj domeny, używaj uwierzytelniania dwuskładnikowego (2FA), korzystaj z wtyczek bezpieczeństwa i rozszerzeń do przeglądarek, które rozpoznają fałszywe strony.

Firmy powinny stosować polityki HSTS, DNSSEC, SPF/DMARC i certyfikaty SSL z poprawną konfiguracją, by ograniczyć ryzyko podszywania się pod ich domeny.

Na poziomie dostawców AI potrzebne są mechanizmy filtrowania linków, wykrywania halucynacji AI, a także techniki sprawdzania reputacji domen – np. na podstawie list Netcraft, VirusTotal, WHOIS i Google Safe Browsing.

Podsumowanie

Generatywna sztuczna inteligencja ma ogromny potencjał, ale bez odpowiednich zabezpieczeń może stać się katalizatorem cyberprzestępczości. AI nie rozróżnia dobra od zła – a przestępcy gwałtownie się uczą, jak to wykorzystać. Dopóki nie zaimplementujemy skutecznych metod weryfikacji treści generowanych przez modele, użytkownicy muszą zachować szczególną ostrożność.