Amazon Web Services ogłosił uruchomienie projektu Project Rainier, jednego z największych klastrów obliczeniowych dla sztucznej inteligencji na świecie. System oparty na niemal 500 000 chipów Trainium2 ma napędzać modele językowe Anthropic, w tym Claude’a. Do końca roku AWS planuje podwoić tę liczbę, osiągając milion własnych układów AI.

AWS stawia na własne układy Trainium2

Amazon oficjalnie uruchomił superklaster Project Rainier, zbudowany w oparciu o opracowane wewnętrznie procesory Trainium2. Według komunikatu AWS klaster jest już w pełni operacyjny i obejmuje blisko pół miliona chipów, co czyni go największą infrastrukturą AI w historii firmy.

Projekt Rainier został zaprojektowany z myślą o obsłudze modeli językowych Anthropic, w tym systemu Claude. AWS planuje do końca 2025 roku rozbudować klaster do ponad miliona chipów Trainium2, które będą wykorzystywane zarówno do trenowania, jak i inferencji dużych modeli językowych.

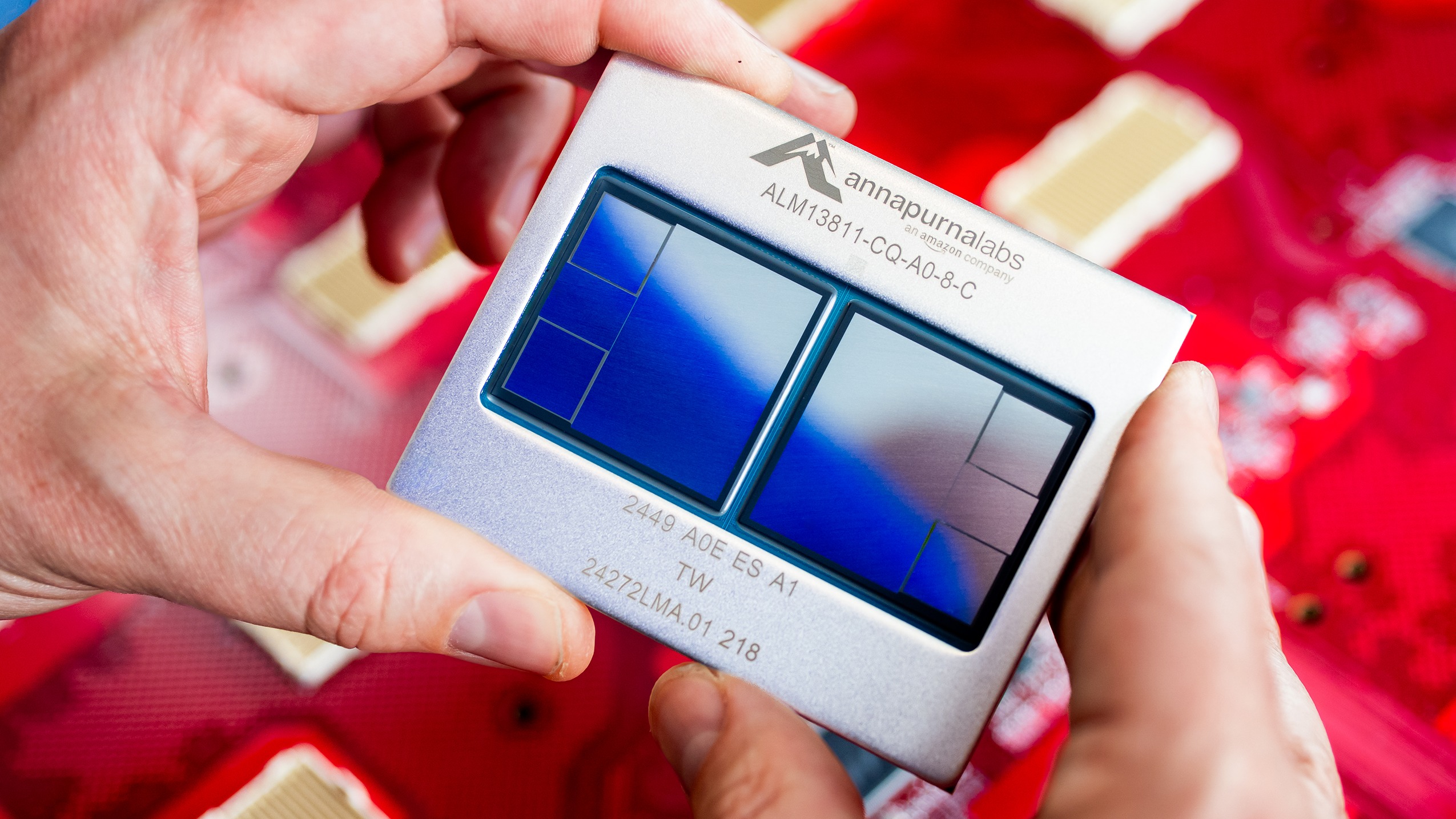

Trainium2 to druga generacja autorskich układów AWS przeznaczonych do obliczeń AI. Każdy z tzw. UltraSerwerów łączy cztery serwery fizyczne z 16 chipami Trainium2, co daje łącznie 64 procesory w jednym module. Cała infrastruktura wykorzystuje trzecią generację sieci Elastic Fabric Adapter (EFA) o petabitowej przepustowości i bardzo niskich opóźnieniach.

Jednym z kluczowych centrów danych projektu jest obiekt w hrabstwie St. Joseph w stanie Indiana, gdzie Amazon inwestuje 11 mld USD. Budowa rozpoczęła się w październiku 2024 roku, a lokalizacja ma pełnić funkcję głównego węzła obliczeniowego.

Jak podkreślił Ron Diamant, główny architekt Trainium w AWS, Project Rainier to jedno z najbardziej ambitnych przedsięwzięć w historii firmy. Jego zdaniem to „masywna, jedyna w swoim rodzaju infrastruktura, która otworzy drogę do następnej generacji modeli sztucznej inteligencji”.

Źródło: AWS

Anthropic korzysta z wielu dostawców

Choć Rainier powstał z myślą o Anthropic, firma nie ogranicza się wyłącznie do ekosystemu AWS. W październiku 2025 roku podpisała z Google kontrakt o wartości ponad 1 GW mocy obliczeniowej, zapewniający dostęp do choćby miliona procesorów Tensor Processing Unit (TPU). Równolegle Anthropic przez cały czas wykorzystuje układy graficzne Nvidia do trenowania i wdrażania swoich modeli Claude.

Amazon jest jednym z największych inwestorów w Anthropic, z łącznym zaangażowaniem sięgającym 8 mld USD. Wiosną 2025 roku firma pozyskała kolejną rundę finansowania o wartości 5 mld USD, która wywindowała jej wycenę do około 170 mld USD.

Rywalizacja pomiędzy Anthropic, OpenAI i Google DeepMind sprawia, iż wyścig o największe i najbardziej efektywne centra danych AI nabiera tempa. Dla AWS uruchomienie Project Rainier to nie tylko wzmocnienie pozycji wobec konkurencji, ale również demonstracja możliwości własnego ekosystemu sprzętowo-programowego, obejmującego chipy Trainium i Inferentia, sieć EFA oraz środowisko Trn1 w Amazon EC2.

Według AWS Rainier już jest o 70% większy niż jakakolwiek wcześniejsza platforma AI w historii spółki. W połączeniu z inwestycjami w rozwój chmur prywatnych i specjalizowanych instancji dla klientów korporacyjnych ma on stanowić fundament pod rozwój kolejnej generacji modeli generatywnych oraz aplikacji opartych na uczeniu głębokim.