O tym, jak migrować do chmury i z jakimi kosztami się trzeba liczyć rozmawialiśmy pierwszego dnia kwietniowych Google Cloud Days, cyklicznego wydarzenia budowanego na praktycznym podejściu do chmury. Polityka Zero Trust, konfiguracje dostępów, klucze sprzętowe i ataki na łańcuch dostaw systemu to tematy, na których skupili się eksperci branży cyberbezpieczeństwa podczas drugiego dnia prelekcji oraz warsztatów.

Partnerem wydarzenia była Fundacja Dajemy Dzieciom Siłę, na rzecz której zebrano 25,347 zł podczas dwóch dni Google Cloud Days. Środki zostaną przeznaczone na profilaktykę cyberprzemocy wśród dzieci w wieku wczesnoszkolnym oraz zasilą projekt edukacyjny dla dzieci Sieciaki.pl.

„Chciałbym bardzo podziękować każdej osobie, która dołożyła swoją cegiełkę. Jestem bardzo szczęśliwy iż przy okazji zdobywania wiedzy i robienia biznesu mogliśmy zrobić coś dobrego”. – podsumował Piotr Wieczorek, CEO FOTC, organizatora Google Cloud Days.

Jak migrować do chmury…

Każda organizacja w pewnym momencie zadaje sobie pytanie: czy to już czas na migrację do chmury, czy też lepiej zainwestować we własny sprzęt do przetwarzania danych? Jaką wartość dodaną daje chmura publiczna, typu Google Cloud, za co konkretnie płacę i jak kontrolować koszty.

Dla firmy Sabre, rozwiązania chmurowe były najtańszym rozwiązaniem w krótkim terminie.

„Google było katalizatorem zmian dla Sabre 3 lata temu, kiedy postanowiliśmy zmigrować. … Postanowiliśmy przejść na single cloud, przenieść wszystko do Google”. – powiedział Mateusz Nowakowski, Senior Principal Software Engineer, Sabre.

Oprócz automatyzacji procesów i zmniejszenia kosztów, o wyborze Google Cloud zadecydował stack technologiczny chmury.

„Google Cloud jest unikalny. Trzeba wiedzieć, w czym dany cloud jest lepszy. Kubernetes jest konceptem Google i to Google decyduje o tym, jak się rozwija”. – dodał Mateusz Nowakowski.

szybko…

Na gotowe rozwiązania chmurowe zwrócił również uwagę Paweł Mrówka, DevOps Engineer z firmy Shoper, przytaczając studium przypadku migracji firmy Apilo do Google Cloud.

„Warto wybierać usługi gotowe, z pudełka, mimo iż wydają się droższe. Gdy policzyć koszt dostosowania własnego rozwiązania, okazuje się iż jest to droższe”. – stwierdził.

Migracja Apilo wiązała się z przeniesieniem wszystkich klientów platformy Apilo, ich subdomen i baz danych, z których każda obejmowała około 3 TB danych w postaci zdjęć czy faktur klientów.

Zdaniem Pawła Mrówki dobrze zaplanowana i zorganizowana migracja może przejść bardzo sprawnie. „Wszyscy nowi klienci od 6-tego miesiąca migracji byli od razu w chmurze. Do 8-go miesiąca przenieśliśmy wszystkich klientów”.

Paweł

Rosada i Paweł Mrówka z firmy Shoper podczas Google Cloud Days

Paweł

Rosada i Paweł Mrówka z firmy Shoper podczas Google Cloud DaysWedług Pawła Rosady Technical Leadera z firmy Shoper, jednym z kamieni milowych migracji była dolaryzacja, aby można było uruchomić infrastrukturę w środowisku kubernetesowym.

W ostatecznym rozliczeniu projektu, ważna jest analiza potrzeb.

„Warto przeanalizować, czy warto migrować i czy jest to kosztowne. Dla nas był to strzał w dziesiątkę. Architektura chmurowa wyszła kosztowo bardzo podobnie do on-premisowej, ale koszty utrzymania były dużo, dużo niższe”. – podsumował Paweł Rosada.

i niedrogo…

Pytanie o koszty migracji i utrzymania infrastruktury chmurowej jest jednym z pierwszych, jakie się pojawia przy wyborze dostawcy.

„Nasza migracja stosu danych jest na ukończeniu i jeden z naszych wniosków to to, iż chmura kosztuje”. – zauważył Wojciech Smolak, Senior Data Platform Engineer, Allegro.

Trzeba mieć na uwadze, iż przechodząc do chmury każdy krok dewelopera niesie ze sobą koszty. Nic więc dziwnego, iż w przypadku firmy takiej jak Allegro, gdzie dzienny przyrost danych sięga 7 TB, koszty są nadrzędnym kryterium wyboru.

Wojciech Smolak zwrócił uwagę na narzędzia kontroli kosztów, możliwości przypisywania budżetów lub automatyki alertów kosztowych na poziomie projektów.

„W usługach user-managed jest możliwość samodzielnego zaprogramowania autostopu maszyn, np. Vertex AI notebooks. Zawsze warto zbadać, czy jest lepsze wyjście niż usługa na wirtualnej maszynie. Istnieje wiele rozwiązań, np. Serverless”.

ABC migracji do chmury

Pobierz ebook i dowiedz się jak przeprowadzić migrację do chmury

Pokazał również możliwości optymalizacji dzięki wyboru typu maszyn wirtualnych, a także regionów chmurowych.

„W różnych regionach w chmurze koszt procesora jest różny. Np. różnica między kosztów kosztów maszyny 4 GB w Belgii a taką samą w Warszawie to 5 $. Maszyny typu standard a spot to czterokrotna różnica w cenie. Trzeba sobie umieć poradzić z tym, iż taka maszyna typu spot może nam być odebrana, i wówczas można sporo zaoszczędzić”. – powiedział ekspert Allegro.

O korzyściach związanych z używaniem narzędzi hurtowni danych Big Query przekonywał Wojciech Sznapka, CTO, STS Gaming Group.

„Klastrowanie drastycznie obniża rachunki. jeżeli macie adekwatną strukturę tabeli i zapytań, różnica może być wielka. Za każdego dolara włożonego BI Engine, wyciągnięcie dwa. Natomiast Big Query ML świetnie nadaje się do szybkiego prototypowania. Ma bardzo niski próg wejścia”. – stwierdził Wojciech Sznapka.

Automatyka i AI

Automatyczne rozwiązania są jednym z największych atutów rozwiązań chmurowych, zwłaszcza w okresie dynamicznego wzrostu, o czym opowiedział Krzysztof Sprawnik, Customer Engineer, Google Cloud.

Krzysztof Sprawnik i Katarzyna Siedlarek, Customer Engineers, Google Cloud

Krzysztof Sprawnik i Katarzyna Siedlarek, Customer Engineers, Google Cloud

„Autoskalowanie serwisy dają możliwość wysłania komunikatu jednocześnie na dużą skalę.

Wiemy co trzeba zrobić, kiedy wysyłamy sto komunikatów na sekundę, tysiąc komunikatów na sekundę, czy choćby milion na sekundę”. – powiedział.

Big Query pozwala na skalowanie na dowolnym poziomie złożoności i wielkości danych, natomiast dzięki rozwiązaniom Business Intelligence (np. Looker) możemy dostrzec wzorce w gromadzonych danych.

„Co jeszcze pomoże nam zobaczyć więcej? Chmura nam może pomóc, aby sztuczna inteligencja była dla wszystkich i na wyciągnięcie ręki”. – powiedziała Katarzyna Siedlarek, Customer Engineer, Google Cloud.

Na korzyści płynące z automatyki dostępnej w chmurze zwrócił także uwagę Marcel Dybalski, Sales operations manager, Growbots.

„Jeśli zależy nam na stabilności, to warto skorzystać z Business Intelligence, Data Studio”. – powiedział i dodał, iż dzięki hurtowni danych firma zaoszczędziła 72% kosztów. “Udało nam się zmniejszyć awaryjność całej struktury o 90%”.

Szybkie skalowanie w chmurze

Wśród prelegentów pojawił się również nasz klient Revolut, którego reprezentował Wojciech Ptak, Head of Engineering. Pokazał on jak łatwe może być szybkie skalowanie, jeżeli przyjąć odpowiednie założenia.

Wojciech Ptak, Head of Engineering, Revolut

Wojciech Ptak, Head of Engineering, Revolut„Jeśli skalujemy się szybko, pytanie powstaje pod co się optymalizujemy. Revolut się optymalizuje pod szybkość zmian na rynku. Early overoptimisation jest większym problemem niż legacy. Często podejmujemy decyzje wcześniej, które nie są do odwrócenia. Warto odwlekać decyzje tak długo, jak to możliwe”. – powiedział.

Dodał także, iż dzięki odpowiedniej architekturze, firma nie potrzebuje rzeszy inżynierów do utrzymania infrastruktury.

„W Revolut jest 15 osób odpowiedzialnych za infrastrukturę. I to w zupełności wystarcza, żeby utrzymać sporą infrastrukturę banku”.

Bezpieczeństwo przede wszystkim

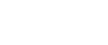

O podejściu Zero Trust do bezpieczeństwa infrastruktury organizacji mówił Przemysław Tadeusz, Customer Engineer, Google Cloud. Podejście, w którym organizacja jest postrzegana jak zamek za murem obronnym jest już niewystarczające.

„Rozproszone zespoły, zagrożenia od wewnątrz, liczni zewnętrzni dostawcy usług oraz ogromna liczba urządzeń sprawiają, iż podejście do bezpieczeństwa jak do obwarowania zamku już nie wystarcza. Kiedy mówimy o Zero Trust, to mówimy o infrastrukturze za ‘murem obronnym’. Jak już się dostaniemy za ten mur, np. poprzez VPN, to już jesteśmy traktowani jako bezpieczni. To nie jest najlepsze rozwiązanie”. – stwierdził.

Ekspert Google Cloud omówił również znaczenie polityk kontekstowych do nadawania uprawnień użytkownikom.

„Zero Trust zakłada brak domniemanego zaufania, które dajemy zasobowi tylko na podstawie tego, gdzie się znajduje. Google jest jedną z największych firm, które stosują podejście Zero Trust”. – podsumował.

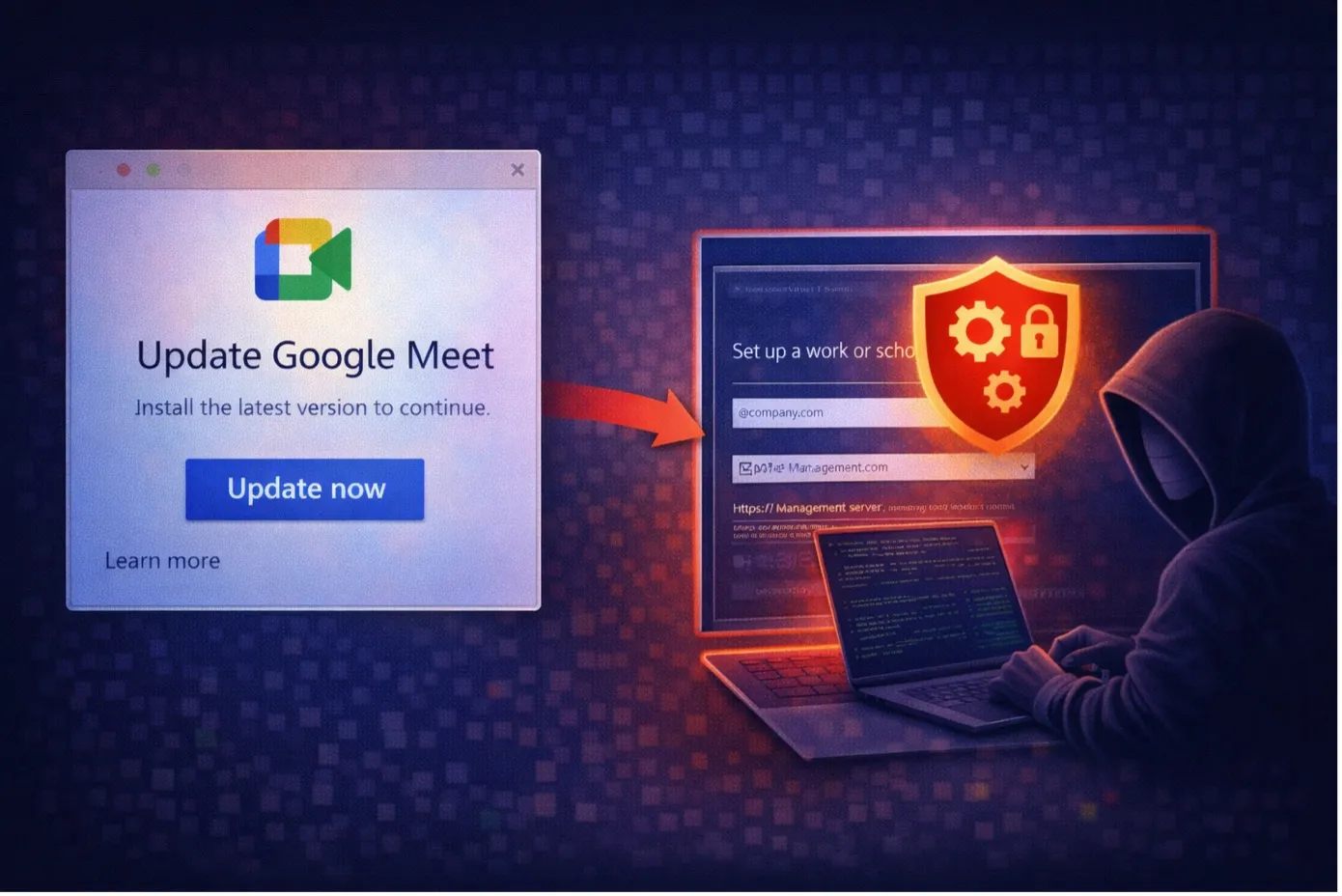

Ataki na proces wytwórczy

Ograniczone do minimum zaufanie dotyczy nie tylko dostępu dla użytkowników końcowych infrastruktury firmy. w tej chwili jednym z najczęstszych ataków są ataki nie na końcowy produkt, ale na oprogramowanie w trakcie jego tworzenia, czyli ataki na tzw. „supply chain”.

Artur Kuliński, Security Specialist, Google Cloud oraz Konrad Bogusz,

FOTC

Artur Kuliński, Security Specialist, Google Cloud oraz Konrad Bogusz,

FOTC„Kiedyś mieliśmy do czynienia głównie z atakami w run time. Teraz jest trudne zaatakowanie w run time. Ale proces wytwórczy jest tak skomplikowany i złożony, iż łatwo tam coś zaatakować”. – powiedział Artur Kuliński, Security Specialist, Google Cloud.

Pokazał również inicjatywy ze strony Google służące zabezpieczeniu procesu tworzenia oprogramowania.

„Uruchomiliśmy Assured OSS, w ramach którego sprawdzamy repozytoria open sourcowe i udostępniamy je klientom Google w Cloud. W tej chwili mamy 250 bibliotek javowych. Ma to zapobiec wstrzykiwaniu back doorów i kodu z podatnościami do kodu”. – tłumaczył.

Zasobocentryczność Google Cloud

O tym, iż adekwatne polityki i zarządzanie grupami raczej niż pojedynczymi użytkownikami opowiadał Łukasz Bobrek, Head of Cloud Security, Securing. Pokazał jak choćby małe błędy konfiguracyjne mogą doprowadzić choćby do przejęcia całej infrastruktury chmurowej.

Łukasz Bobrek, Head of Cloud Security, Securing

Łukasz Bobrek, Head of Cloud Security, Securing„Pierwsze pytanie jakie zadajemy sobie: jak to można zepsuć. Następnie analizujemy: kto, po co i jak może chcieć się dostać do naszej chmury. “Spotykaliśmy się z nadawaniem uprawnień na poziomie całego projektu lub organizacji”. – powiedział.

Według eksperta firmy Securing, zasobocentryczność architektury Google Cloud jest jego zaletą: „Jeśli mamy zasób, łatwo możemy sprawdzić kto ma do niego dostęp. Nie jest jednak łatwo sprawdzić, do czego dany użytkownik może mieć dostęp. To utrudnia atakującemu przejęcie infrastruktury”.

Nieaktualne ustawienia i wymogi regulacyjne

Jak pokazał Maciej Wojnarowicz, Support Specialist, FOTC, jednym z najczęstszych błędów wykrywanych podczas audytów bezpieczeństwa są błędy ustawień dostępu i uprawnień. „Może się okazać, iż na 15 adminów, 14 ma uprawnienia superadmina. Tego typu ustawienia są niebezpieczne i należy to zmienić”. – wyjaśnił.

Maciej Wojnarowicz oraz Dawid Adamczyk, Support Specialists, FOTC

Maciej Wojnarowicz oraz Dawid Adamczyk, Support Specialists, FOTCEkspert FOTC omówił niektóre spośród 100 reguł ochrony danych dostępnych w ramach Google Data Loss Prevention. Reguły te wykrywają wrażliwe dane, np. PESEL, czy numer karty kredytowej i tym samym pozwalają uniknąć naruszania przepisów danego kraju lub obszaru.

Potrzebę spełniania prawnych wymagań bezpieczeństwa poruszył również Tomasz Stawarski, Head of Tech Operations, Shares. Według eksperta “Google Workspace pomaga sprostać 80% wymagań regulacyjnych dotyczących bezpieczeństwa i technologii”.

„Do autoryzacji dwuczynnikowej korzystamy z Google. Integracja z innego APi jest chyba najprostsza”. – dodał.

Alternatywne metody autoryzacji

O ochronie użytkowników przed atakami phishingowymi i typu „Man In The Middle” opowiadał Rafał Rosłaniec, Dyrektor wsparcia technicznego, ePrinus oraz Yubico.

„Hackerzy nie hackują, oni się logują. Najtańsza kampania mailingowa kosztuje kilkanaście dolarów i prawie na pewno ktoś się w niej da złapać”. – powiedział.

Jako alternatywę wobec haseł, które uznawane są często za najsłabszy element zabezpieczenia przedstawił standard uwierzytelniania FID\O, wspólną inicjatywę Yubico i Google.

„FIDO niesie infrastrukturę klucza publicznego. Klucz publiczny trzyma Google, klucz prywatny jest na FIDO. Pośrednikiem jest np. przeglądarka, która pokazuje specjalne okno do logowania. Musimy nacisnąć przycisk na kluczu, aby wstrzyknąć klucz.” – tłumaczył Rafał Rosłaniec.

Dołącz do nas na kolejne Google Cloud Days

Google Cloud Days to cykliczne wydarzenie zrzeszające praktyków i ekspertów chmury obliczeniowej organizowane przez FOTC, partnera premium Google Cloud, w warszawskiej siedzibie Google. Kolejne Google Cloud Days będą ogłoszone już niedługo. Zapraszamy.

Bądź na bieżąco z newsletterem

Otrzymuj materiały premium oraz nowości w Google Workspace!