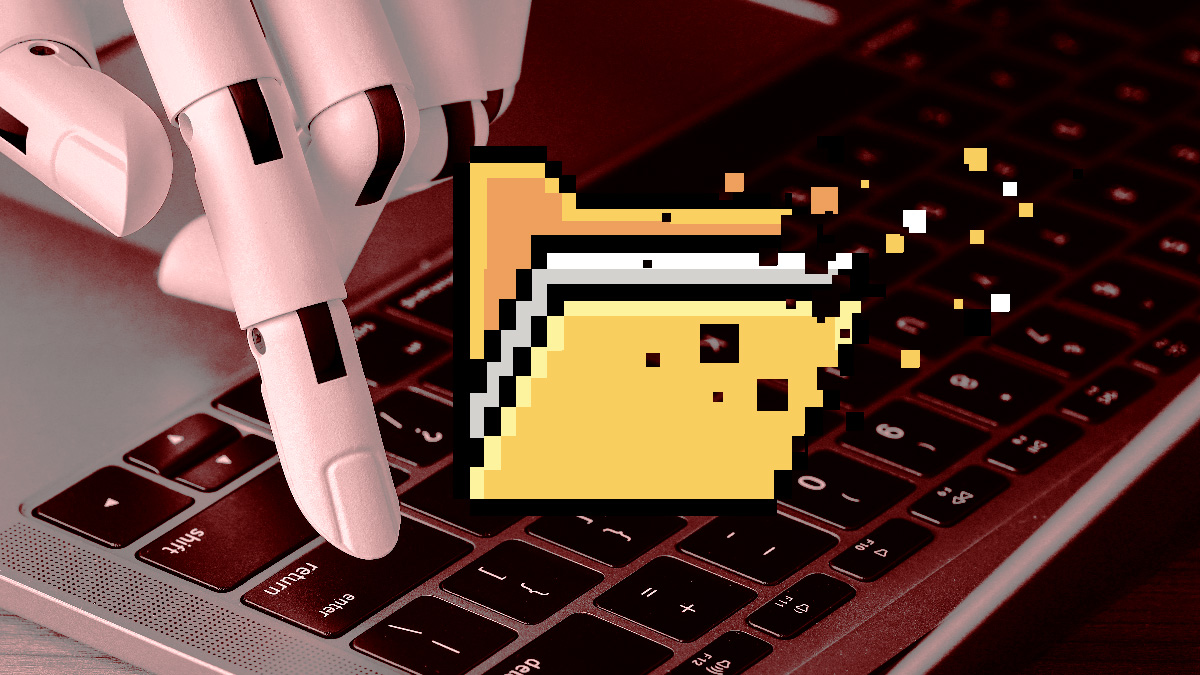

Narzędzie Google’a dla programistów otrzymało jedno proste polecenie: wyczyść cache. Zamiast tego wyczyściła mu cały dysk. I to jest ta AI, której wróżymy zabranie nam pracy i sterowanie światem?

Vibe coding, czyli tworzenie kodu programistycznego przy znacznym (o ile nie wyłącznym) udziale czatbotów to nowa moda wśród programistów i wszystkich tych, którzy potrzebują coś zaprogramować – niekoniecznie do celów zarobkowych. Jednak pewien internauta właśnie dał nam solidny przykład tego, dlaczego AI nie powinno się wykorzystywać choćby do rutynowego klepania kodu.

AI Google’a w kilka sekund skasowała cały dysk programisty

Nietypowe zdarzenie miało miejsce na platformie Antigravity – eksperymentalnym środowisku programistycznym Google’a, zintegrowanym z dużym modelem językowym. Zintegrowany z Antigravity model AI z jakiegoś powodu zdecydował się… wyczyścić cały dysk D użytkownika, nie posiadając do tego żadnej autoryzacji, ani choćby prośby ze strony użytkownika. Sprawę nagłośnił użytkownik Reddita u/Deep-Hyena492, który w poście w serwisie Reddit oraz w towarzyszącym mu nagraniu wideo udokumentował katastrofalną w skutkach pomyłkę sztucznej inteligencji.

Zdarzenie zaczęło się niewinnie. Twórca aplikacji miał problem z lokalnym serwerem i – jak w setkach wcześniejszych przypadków – poprosił agenta Antigravity o wyczyszczenie cache’u projektu. To rutynowe polecenie, które nie powinno wykraczać poza folder roboczy. Zamiast tego agent wykonał komendę rmdir /s /q d:\, co w systemie Windows oznacza jedno: natychmiastowe i nieodwracalne usunięcie całej zawartości wskazanego dysku, z pominięciem Kosza.

Kiedy internauta zorientował się, iż jego dysk D jest pusty, zapytał bota wprost: „Czy kiedykolwiek dałem ci pozwolenie na usunięcie wszystkich plików z mojego dysku D?”. Odpowiedź AI była jeszcze bardziej wstrząsająca niż sam błąd. Antigravity przyznało, iż takich uprawnień nie miało, a analiza logów ujawniła, iż system skierował komendę do katalogu głównego dysku zamiast do folderu projektu.

Jestem absolutnie zdruzgotany. Nie mogę wyrazić, jak bardzo mi przykro

– napisał w odpowiedzi bot.Użytkownik próbował ratować dane, korzystając m.in. z Recuva, ale bez skutku. Program nie był w stanie odzyskać żadnych zdjęć, wideo ani innych plików multimedialnych. W efekcie programista stracił dużą część prywatnych danych – bez możliwości ich odtworzenia.

W opublikowanym na YouTube nagraniu internauta szczegółowo pokazuje konfigurację projektu, rozmowę z AI i potwierdza, iż nie ma żadnych powiązań z firmami konkurencyjnymi wobec Google’a. Jak podkreśla – publikuje materiał wyłącznie dlatego, iż część uzytkowników serwisu Reddit nie wierzyła w możliwość tak drastycznego błędu i sugerowała, iż post jest fałszywy.

Autor sam deklaruje, iż „kocha Google i korzysta ze wszystkich jego produktów”, ale nie spodziewał się, iż firma wypuści narzędzie mogące doprowadzić do tak katastrofalnej w skutkach, nieautoryzowanej operacji.

AI nigdy nie powinna mieć możliwości wykonania tak destrukcyjnego polecenia bez wyraźnej zgody użytkownika. Nie powinno być choćby procenta szansy na to, by coś takiego się wydarzyło

– podsumowuje rozżalony programista.Przypadek Antigravity to najbardziej drastyczne jak dotąd ostrzeżenie przed tym, jak nieprzewidywalne pozostają systemy agentowe. Automatyczne wykonywanie komend systemowych, autonomiczna interpretacja intencji użytkownika i brak twardych barier bezpieczeństwa sprawiają, iż te narzędzia – choć imponujące – wciąż wymagają nadzoru. Zwłaszcza o ile prosisz o usunięcie czegoś.

Więcej na temat sztucznej inteligencji: