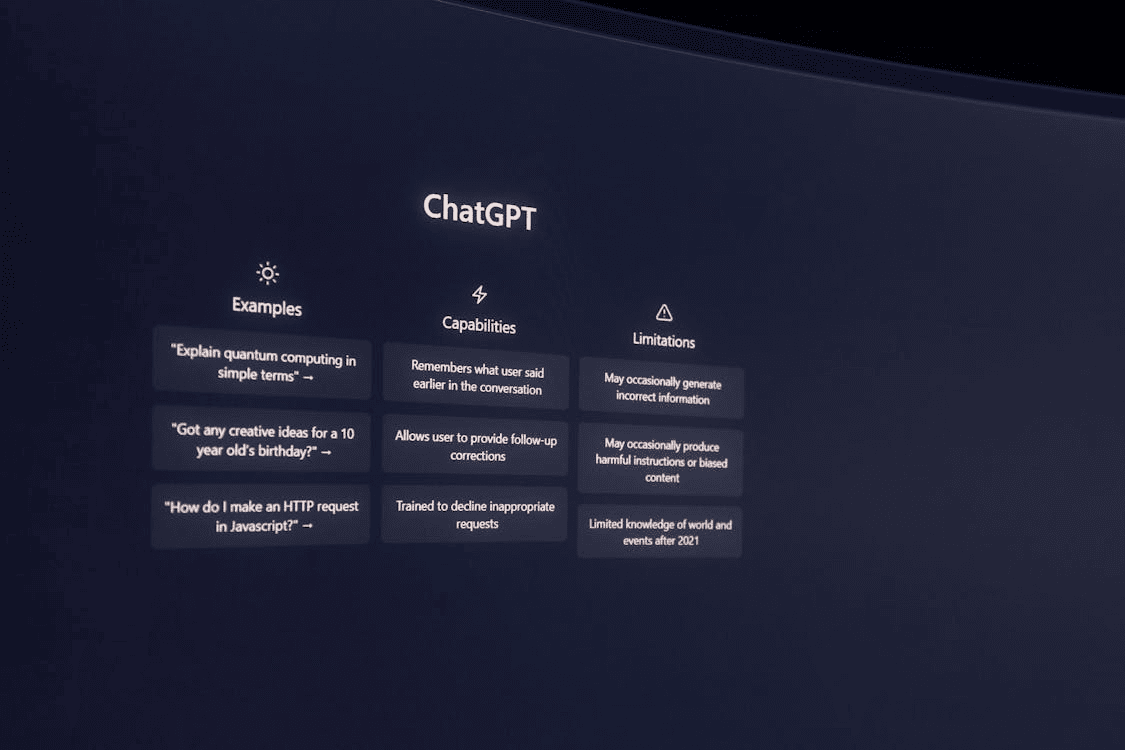

Sztuczna inteligencja zdobywa coraz większą popularność. ChatGPT stał się pierwszym powszechnym narzędziem AI, z którego korzystają miliony ludzi. Odpowiedzią na produkt OpenAI jest z kolei Google Bard, który w zeszłym tygodniu zadebiutował w Polsce. Okazuje się jednak, iż korzystanie z usług AI może wiązać się z zagrożeniami i potencjalnym wyciekiem wrażliwych i poufnych danych.

Porównanie ChatGPT vs Google Bard

Zobacz nasze porównanie ChatGPT i Bard w zakresie pytań technicznych. Zadaliśmy tzw. sztucznej inteligencji dociekliwe pytania z kategorii: bezpieczeństwa, administracji IT, DevOps.

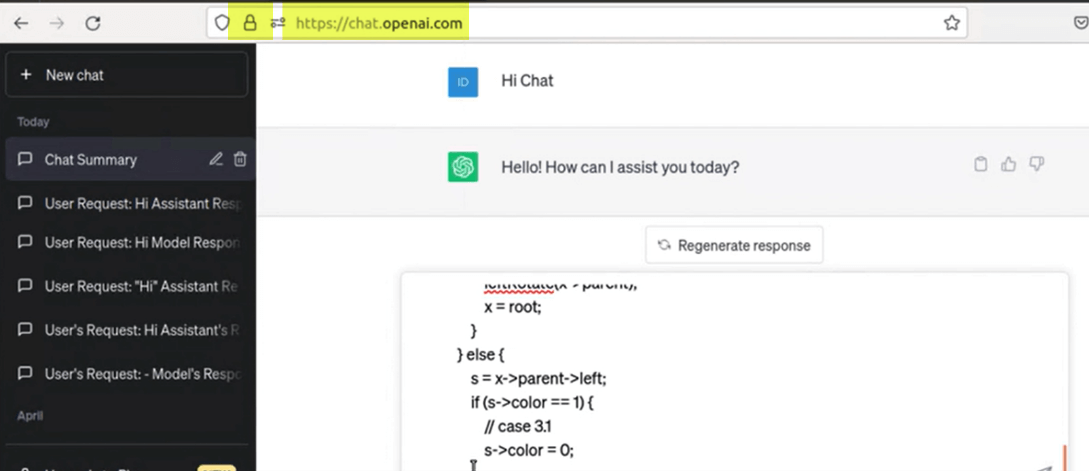

Korzystanie z dużych modeli językowych (LLM), takich jak ChatGPT, stało się bardzo popularne wśród pracowników, którzy poszukują szybkich wskazówek lub pomocy przy tworzeniu kodu oprogramowania. Niestety, narzędzia zwiększające produktywność, są skonfigurowane w sposób, który pozwala na wyciek poufnych danych biznesowych. Korzystanie z narzędzi takich jak ChatGPT lub Bard sprawia, iż nieumyślne przesyłanie poufnych lub chronionych informacji (w ramach zapytań) jest niezwykle łatwe.

W jaki sposób można się zabezpieczyć?

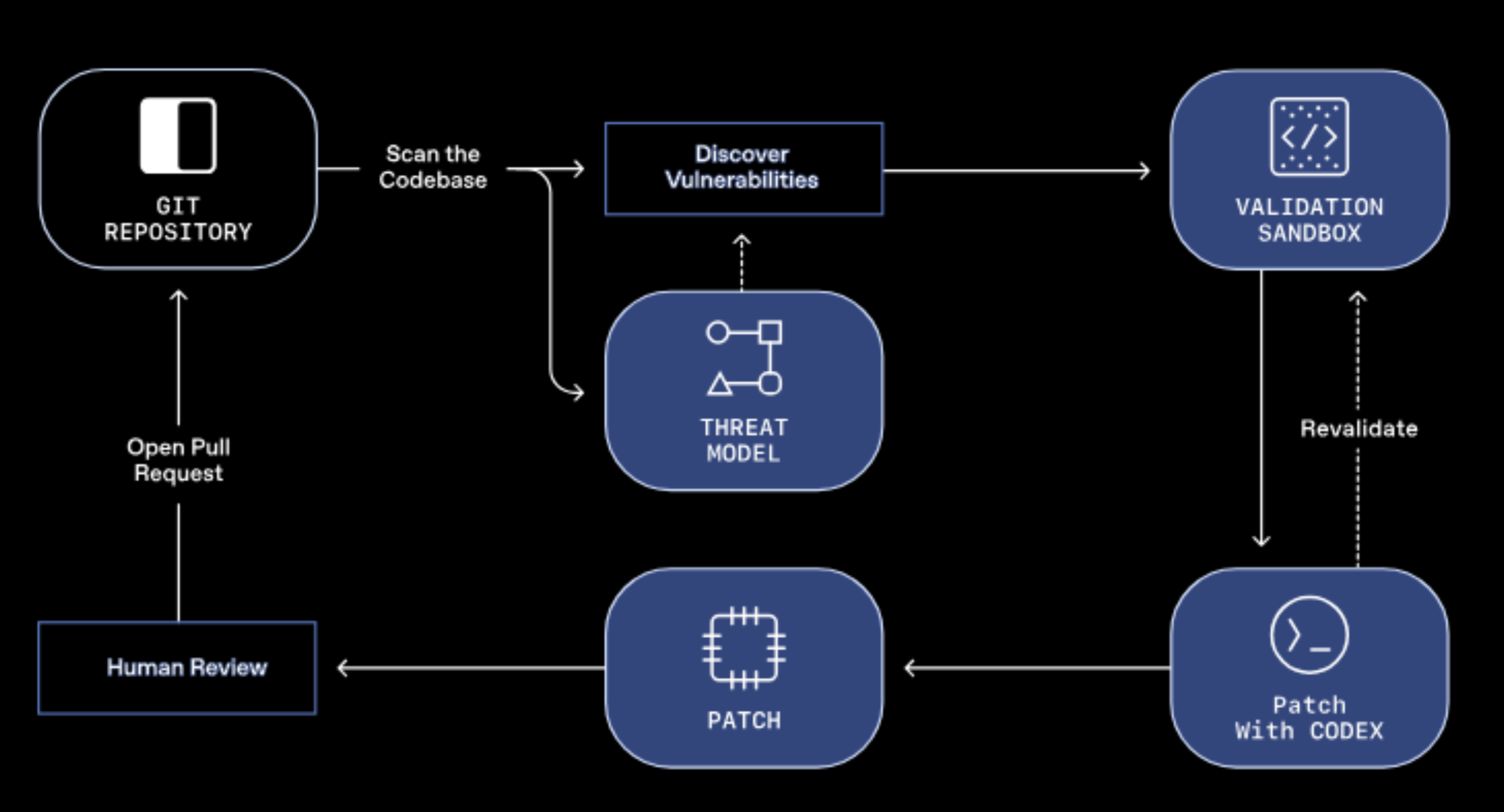

Wiele usług sztucznej inteligencji twierdzi, iż nie przechowuje przesłanych informacji w pamięci podręcznej ani nie używa przesłanych danych do trenowania swoich silników sztucznej inteligencji. Zespół ChatGPT naprawił niedawno kluczową lukę w zabezpieczeniach, która ujawniała dane osobowe, w tym dane karty kredytowej i wiadomości na czacie.

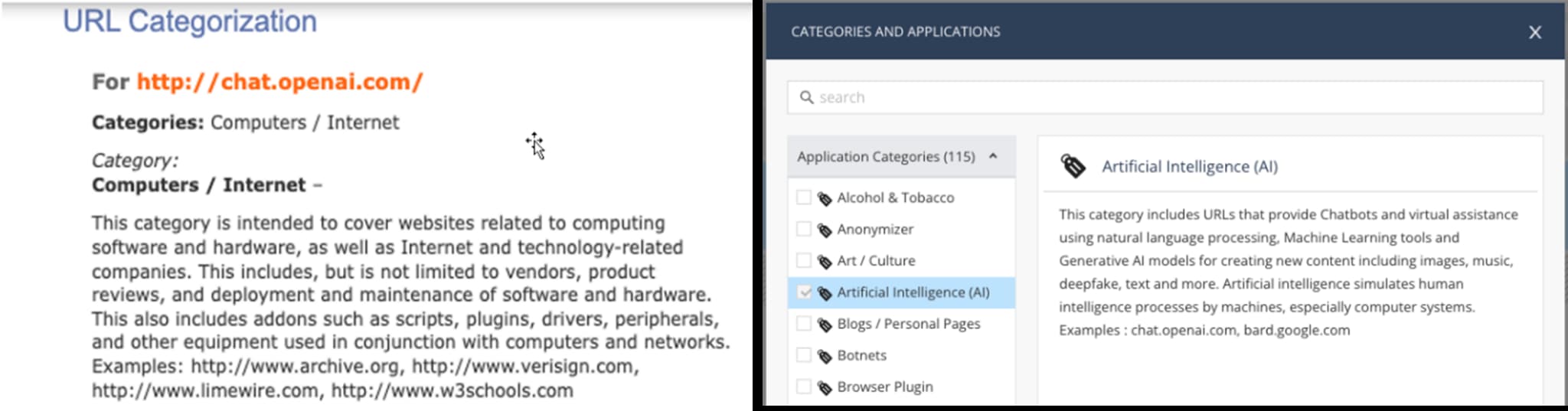

Tymczasem eksperci firmy Check Point Software wskazują, iż istnieją narzędzia i usługi (ich usługa Harmony Connect), która posiadają filtry do kategoryzacji stron internetowych, aby zablokować przesyłanie poufnych lub chronionych danych za pośrednictwem tych usług.

Check Point umożliwia zatem firmom zapobieganie niewłaściwemu wykorzystaniu sztucznej inteligencji dzięki kontroli aplikacji i filtrowania adresów URL, identyfikując i blokując dostęp do tych aplikacji oraz zapobiegając utracie danych (DLP). Pozwala to organizacjom blokować nieautoryzowane użycie niezatwierdzonych aplikacji poprzez szczegółową, bezpieczną kontrolę dostępu do sieci dla użytkowników lokalnych, w chmurze, punktach końcowych, urządzeniach mobilnych i zaporach sieciowych.

Dzięki temu administratorzy mogą blokować przesyłanie określonych typów danych (kod oprogramowania, dane osobowe, informacje poufne itp.) podczas korzystania z aplikacji takich jak ChatGPT i Bard. Analitycy Check Point Software ostrzegają, iż jeżeli organizacje nie posiadają skutecznych zabezpieczeń dla tego typu aplikacji i usług AI, ich prywatne dane mogą stać się nieodłączną częścią dużych modeli językowych i ich odpowiedzi na zapytania.