Cyberbezpieczeństwo z chatbota AI? To i sporo więcej dostaniemy dzięki AIPITCH, międzynarodowemu projektowi badawczemu pod przewodnictwem NASK, wartemu 8 mln euro, w tym 50% z European Cybersecurity Competence Centre.

Oprócz NASK, w projekcie biorą udział CIRCL z Luksemburga, Fundacja Shadowsaver z Holandii, ABI LAB z Włoch i polskie Narodowe Centrum Badań Jądrowych. Budżet projektu w dyspozycji NASK jako lidera wyniesie niemal 3 mln euro.

Cyberbezpieczeństwo z chatbota AI. Co jeszcze da nam AIPITCH?

AIPITCH (AI-Powered Innovative Toolkit for Cybersecurity Hubs) ma być kompleksowym zestawem narzędzi opartych na sztucznej inteligencji do wspierania kluczowych usług zespołów operacyjnych odpowiedzialnych za cyberobronę.

Pierwszym elementem systemu ma być wyżej wspomniany chatbot AI, który umożliwi szybkie i wygodne zgłaszanie incydentów. AI chatbota będzie dokonywać wstępnej oceny zagrożenia, przyspieszając reakcję na nie.

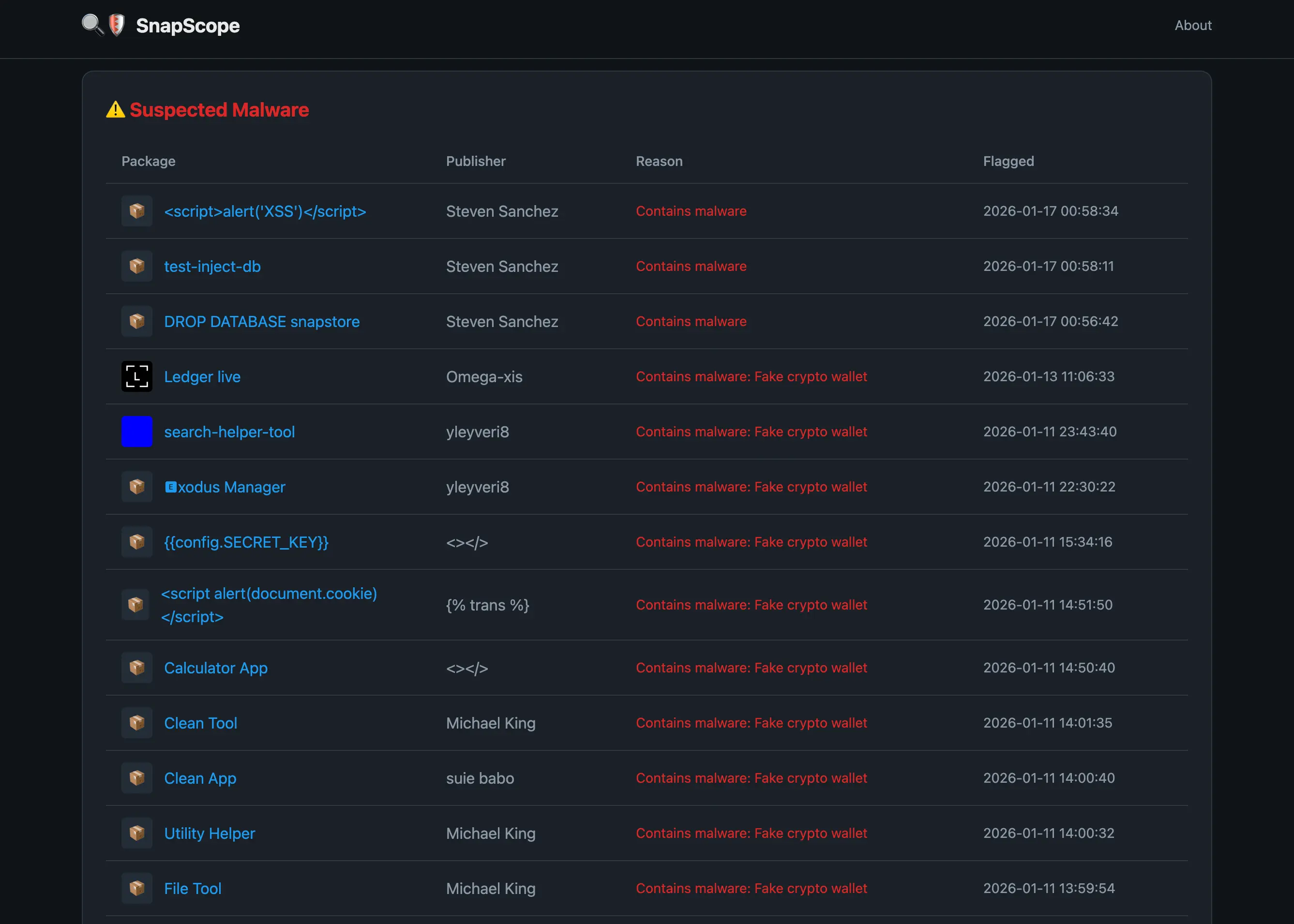

Drugim elementem będą tak zwane systemy wczesnego ostrzegania, które zajmą się automatycznym wykrywaniem exploitów, kampanii phishingowych, co pozwoli zespołom odpowiedzialnym za cyberzagrożenia na reakcję, zanim zagrożenie się rozwinie.

System będzie również przy pomocy dużych modeli językowych (LLM) analizował duże zbiory danych w poszukiwaniu nowych zagrożeń.

System ten ma zapewniać integrację sztucznej inteligencji z kluczowymi procesami operacyjnymi. Dzięki temu rutynowe zadania będą wykonywane szybciej i bardziej precyzyjnie, co odciąży analityków i pozwoli im skupić się na bardziej złożonych zagadnieniach.

Ostatnim elementem systemu będą wielkoskalowe bazy danych o zagrożeniach. Dzięki stałemu uzupełnianiu tych baz danych będzie możliwe trenowanie modeli AI na najnowszych danych, co „pozwoli im lepiej przewidywać i przeciwdziałać nowym formom zagrożeń, co znacząco zwiększy poziom ochrony infrastruktury krytycznej” – pisze Ministerstwo Cyfryzacji.

AI w cyberbezpieczeństwie. Obosieczny miecz

Zastosowanie AI w cyberbezpieczeństwie nie dziwi. Jak pokazuje niedawny raport firmy konsultingowej Deloitte, AI w obszarze bezpieczeństwa oferuje bardzo dobry zwrot z inwestycji, istotnie większy niż zakładany w przypadku 44% organizacji wdrażających AI w cyberbezpieczeństwie. Niestety, kilka organizacji wdraża AI w tym obszarze, bo tylko 8%, a nieco częściej ma to miejsce tylko w sektorach finansowym i technologicznym, gdzie zagrożenia cyberbezpieczeństwa są szczególnie istotne.

Jak niedawno pisało World Economic Forum w swoim raporcie o perspektywach bezpieczeństwa na 2025 rok, „Sztuczna inteligencja (AI) niesie ze sobą obietnicę zmiany metod obrony przed cyberzagrożeniami. Może dać obrońcom przewagę, dostarczając zaawansowanych narzędzi zdolnych gwałtownie wykrywać i reagować na niebezpieczeństwa — pod warunkiem iż będą w stanie nadążyć za tempem integracji AI. Mówiąc prosto, AI może wspomagać ludzkie umiejętności, czyniąc obronę przed cyberatakami silniejszą i bardziej efektywną.”

Jak pisze WEF, zintegrowanie AI z tzw. honeypotami, czyli swego rodzaju pułapkami na cyberprzestępców, które tylko udają cenne dla nich zasoby, a mają ich przyciągnąć w celu poznania metod ich działania, pozwala cyberobrońcom tworzyć zaawansowane, dynamiczne interakcje, które dostosowują się do zachowań przeciwników w czasie rzeczywistym. Ale cyberbezpieczeństwo to gra w kotka i myszkę między specjalistami od cyberbezpieczeństwa a hakerami. I obie strony używają AI. Już rok temu szef Interpolu narzekał, iż AI umożliwia choćby dzieciakom bez doświadczenia dokonywanie cyberataków.

AI umożliwia również dokonywanie wysoce spersonalizowanych ataków na dużą skalę — ataków, które ze względu na stopień personalizacji są trudne do wychwycenia przez systemy antyspamowe czy związane z cyberbezpieczeństwem.

Dlatego tak ważne jest tworzenie specjalizowanych modeli sztucznej inteligencji na potrzeby cyberbezpieczeństwa — na szczęście cyberprzestępcy mają dostęp głównie do narzędzi AI ogólnego przeznaczenia. Choć i to pewnie się zmieni — niektóre grupy cyberprzestępcze są sponsorowane przez państwa. A niektóre z tych państw-sponsorów mają całkiem niezłe osiągnięcia na polu AI.

Źródło grafiki: Sztuczna inteligencja, model Dall-E 3