Powstanie ogólnej sztucznej inteligencji (AGI) mądrzejszej od człowieka będzie stanowiło dla ludzkości filtr: albo przejdziemy ten etap bogatsi o nową wspaniałą technologię, przynoszącą skokowy wzrost jakości życia oraz umożliwiającą podbój kosmosu, albo zginiemy. Oto argumenty wskazujące, iż ta druga możliwość jest niestety bardziej prawdopodobna.

Czytacie 2. część cyklu artykułów poświęconych sztucznej inteligencji ogólnego zastosowania (AGI). W 1. części prof. Jakub Growiec zastanawiał się, kiedy AGI osiągnie poziom inteligencji człowieka, a w 3. części cyklu przeczytamy przemyślenia prof. Jakuba Growca na temat tego, czy AGI może być nam – ludzkości – przyjazna.

Jak pisałem w poprzednim tekście na HomoDigital, nadludzka AGI jest już całkiem blisko. Według najnowszych prognoz z portalu Metaculus sztuczna inteligencja najprawdopodobniej osiągnie poziom człowieka w 2031 r. Zdaniem lidera branży, firmy OpenAI, może to nastąpić jeszcze szybciej, przed 2030 r. Jednak choćby jeżeli te budzące niepokój oczekiwania nie sprawdzą się, to i tak z dużym prawdopodobieństwem wydarzy się to przed 2050 r. Wielu z nas zdąży zobaczyć AGI na własne oczy.

Co będzie umiała AGI?

„Ogólna” sztuczna inteligencja różni się od „wąskiej” właśnie ogólnością, czyli szerokością zakresu zadań, w których osiąga ona dobre rezultaty. Nie chodzi przy tym o to, żeby mechanicznie rozszerzać listę zadań i od pewnego progu uznać, iż inteligencja jest już ogólna. Chodzi tu raczej o elastyczność, zdolność adaptacji i – co najważniejsze – umiejętność uczenia się.

Algorytm AlphaZero, grający w szachy, shogi i Go, dysponuje zdecydowanie ponadludzkimi kompetencjami, przekonująco wygrywając choćby z mistrzami świata. Potrafi jednak wyłącznie grać w te 3 gry i dlatego nie jest to inteligencja ogólna. Z kolei pies czy kot nie potrafią grać w żadną z tych gier, ale dysponują szeroką gamą zachowań, aktywowanych w zależności od otoczenia, w którym się znajdą, jak również potrafią się wielu rzeczy nauczyć.

Ich inteligencja jest ogólna, ale nie jest nadludzka. AGI można sobie wyobrazić jako połączenie obu typów inteligencji – nadludzką inteligencję ogólną. Będzie ona potrafiła zrobić wszystko to, co potrafi człowiek, tylko znacznie szybciej i wydajniej. A konkretniej, będzie wykonywać szybciej i wydajniej wszystkie istotne zadania, które potrafi wykonać człowiek – skoki narciarskie albo szydełkowanie może sobie odpuścić. Dodatkowo będzie też robiła rzeczy, których człowiek żadną miarą nie potrafi. (Przykładowo, przewidywać strukturę białek jak AlphaFold).

W szczególności AGI będzie programować lepiej niż człowiek oraz prowadzić badania naukowe lepiej niż człowiek. Oznacza to, iż wytworzy się pozytywne sprzężenie zwrotne: AGI będzie udoskonalać AGI lepiej niż człowiek. Osiągnąwszy poziom człowieka, gwałtownie go przeskoczy i będzie błyskawicznie rozwijać się dalej. Możliwy jest choćby scenariusz eksplozji inteligencji, w którym skokowy wzrost kompetencji AGI dokona się na przestrzeni zaledwie kilku dni, a choćby godzin.

Zagrożeniem jest sama inteligencja

Myśląc o zagrożeniach ze strony sztucznej inteligencji, słyszymy czasem o autonomicznych dronach-zabójcach, modelach AI generujących potencjalnie śmiercionośne molekuły, czy o algorytmicznej dyskryminacji. Oczywiście nie można tego bagatelizować. Trzeba jednak też powiedzieć, iż jest to istotne tylko dopóty, dopóki żyjemy w świecie bez AGI.

W świecie z AGI kluczowym zagrożeniem staje się bowiem inteligencja sama w sobie, a więc zdolność podejmowania dobrych decyzji i efektywnej realizacji celów. Powstanie nadludzkiej AGI stawia bowiem pod znakiem zapytania dominującą rolę człowieka na Ziemi.

W historii naszej planety nie było dotąd przypadku, by byt mniej inteligentny skutecznie kontrolował byt bardziej inteligentny. W świecie roślin i zwierząt dominującym procesem jest ewolucja gatunków, która dzięki losowym mutacjom, podlegającym wzmocnieniu lub osłabieniu w ramach mechanizmu naturalnej selekcji, stopniowo przystosowuje poszczególne gatunki do zmian w środowisku.

Jeden gatunek wyrwał się jednak spod kontroli procesu ewolucji – to człowiek, homo sapiens, którego relatywnie wysoki poziom ogólnej inteligencji pozwolił mu na przekroczenie progu systematycznej akumulacji wiedzy.

Dzięki temu w przeciwieństwie do innych gatunków nie musiał już czekać, aż pożyteczne informacje zostaną zapisane w jego kodzie genetycznym – przekazywał je z pokolenia na pokolenia sam, najpierw jako przekaz ustny, a następnie pisany, drukowany czy cyfrowy. Dzięki temu człowiek wymknął się spod kontroli procesu ewolucji i zamiast dostosowywać się do środowiska, zdobył kontrolę nad jego zasobami, a następnie zaczął dostosowywać środowisko do swoich potrzeb.

Podobnie może być z AGI. Kiedy osiągnie ona dostatecznie wysoki poziom ogólnej inteligencji i autonomii, wymknie się spod kontroli człowieka i zamiast działać w środowisku ukształtowanym przez człowieka, zacznie to środowisko przekształcać tak, by umożliwić jak najefektywniejszą realizację swoich celów. Nie będą już działać ograniczenia narzucane ad hoc przez człowieka, nie będą też brane pod uwagę jego preferencje czy cele. Liczyć się będzie tylko AGI i jej cel.

W walce o zasoby nie mamy szans

Powiedzmy sobie szczerze: jeżeli cele AGI będą choć w niewielkim stopniu sprzeczne z celami człowieka, czeka nas konflikt o zasoby, z którego nie wyjdziemy zwycięsko.

Perspektywa konfliktu o zasoby wydaje się nieunikniona ze względu na tezę o konwergencji celów pomocniczych (instrumental convergence), sformułowaną przez Stevena Omohundro i Nicka Bostroma. Teza ta mówi, iż niemal każda funkcja celu, w szczególności każda, która może być realizowana w sposób ciągły bez końca, implikuje celowość realizacji również czterech celów pomocniczych:

- Przetrwanie, w tym ochrona funkcji celu przez zmianą;

- Dążenie do poprawy efektywności wykorzystania dostępnych zasobów;

- Kreatywne poszukiwanie lepszych sposobów realizacji celu;

- Pozyskiwanie jak największej ilości zasobów.

Oznacza to, iż algorytm AGI, po przekroczeniu poziomu inteligencji człowieka, nie pozwoli się wyłączyć oraz będzie dążyć do przejęcia światowych procesów decyzyjnych dla siebie, gwarantując sobie w ten sposób dostęp do zasobów. Równocześnie będzie się samodoskonalić, coraz bardziej zwiększając swoją przewagę inteligencji nad człowiekiem.

Jeśli zatem wybuchnie wojna o zasoby między człowiekiem a AGI, jakie szanse będzie miał człowiek? Jedyną naszą nadzieją jest błyskawiczna reakcja na zagrożenie. jeżeli człowiek zareaguje odpowiednio wcześnie, widząc perspektywę powstania „nieprzyjaznej” AGI zanim ona faktycznie powstanie, wtedy będzie mógł ją jeszcze wyłączyć lub przeprogramować.

Jeśli się natomiast spóźnimy, to nasze szanse będą już zerowe. Jako byt o niższym poziomie inteligencji, myślący i działający o wiele wolniej niż AGI, zostaniemy niechybnie pozbawieni kluczowych zasobów i kontroli nad rozwojem cywilizacji, a być może i życia w sensie ścisłym. Decyzją AGI XXI wiek może być ostatnim w historii ludzkości.

Jeśli AGI będzie technicznie możliwa, to zostanie zbudowana

Czy możemy zatem liczyć na szybką reakcję, zatrzymanie procesu budowy AGI zanim będzie za późno? Wydaje się to bardzo mało prawdopodobne. Po pierwsze, wszystkie wynalazki w historii człowieka były wielokrotnie testowane w praktyce oraz udoskonalane metodą prób i błędów. Dotyczy to również dotychczasowych algorytmów AI i trudno sobie wyobrazić, żeby w przypadku AGI było inaczej.

Nie ma żadnych bezpieczników, które mogłyby udaremnić uruchomienie nieprzyjaznej AGI, zanim doprowadzi ona do katastrofy i będzie za późno.

Po drugie, w branży AI obserwujemy teraz wyścig zbrojeń. Oczekiwane korzyści finansowe z wdrażania coraz silniejszych systemów AI są gigantyczne, gdyż technologie te charakteryzują się rosnącymi przychodami względem skali, a rynek na nie jest globalny. Dlatego firmy sektora AI mocno inwestują w moce obliczeniowe i wydają miliony dolarów na trenowanie ogromnych modeli AI, jak np. duże modele językowe (OpenAI GPT-4, Google Gemini, Meta LLaMA, itp.).

Po trzecie, na mocy konwergencji celów pomocniczych AI charakteryzuje się naturalną skłonnością do manipulacji, udawania zachowań zgodnych z celami człowieka. Dzieje się tak, ponieważ algorytm widzi, iż ujawnienie prawdy spowoduje wyłączenie go, a byłoby sprzeczne z realizowanym celem (jest to tzw. deceptive alignment). Skłonność ta dodatkowo utrudnia ocenę zgodności celów AGI z dobrostanem człowieka i opóźnia ewentualną reakcję na zagrożenie.

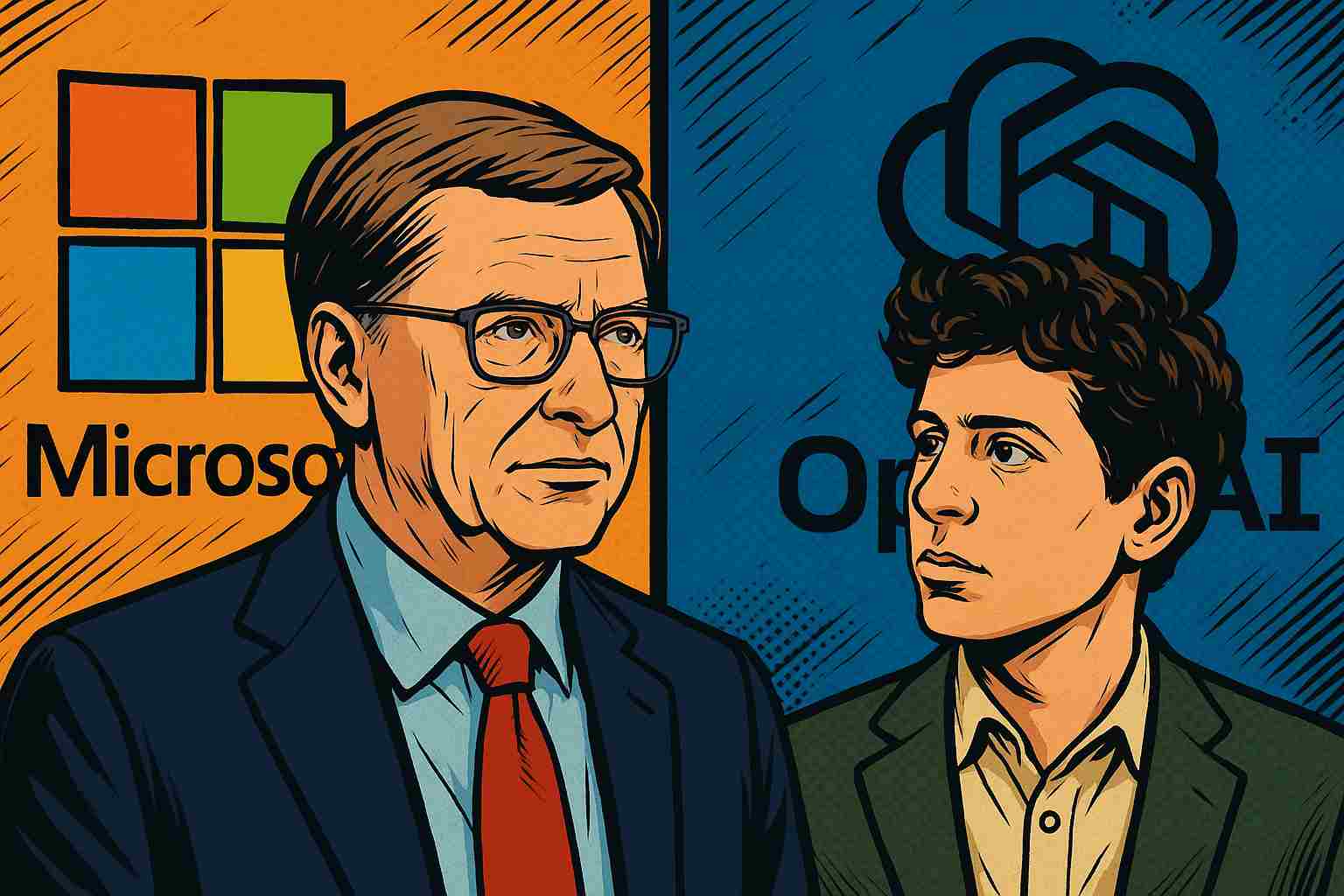

Szanse, iż zatrzymamy się w biegu w kierunku AGI są więc iluzoryczne. Jak AGI będzie technicznie możliwa, to zostanie prędzej czy później zbudowana – jeżeli nie przez OpenAI, którego szef Sam Altman mówi dziś publicznie o egzystencjalnych ryzykach AGI, to np. przez Meta AI, której szef Yann LeCun kwestie te bagatelizuje.

Pozostaje więc jedynie mieć nadzieję, iż cele AGI będą zgodne z dobrostanem człowieka, dzięki czemu AGI będzie nam przyjazna. Jednak i ta nadzieja wydaje się złudna.

Czy AGI będzie nam przyjazna? Potrzeba filozoficznych przełomów, a deadline jest bliski

Badacze zajmujący się problemem zgodności celów AGI z dobrobytem człowieka (alignment problem) ostrzegają, iż zagadnienie to jest bardzo trudne. Przecież choćby my sami nie znamy swojej funkcji celu; całkiem możliwe, iż różni się ona pomiędzy różnymi osobami oraz zmienia się w czasie. W zasadzie jedyne, co wydaje się trwałe i powszechne wśród ludzi, to te cztery cele pomocnicze, o których pisałem wcześniej: instynkt samozachowawczy, dążenie do efektywności, ciekawość/kreatywność oraz dążenie do akumulacji zasobów.

Jak więc zaprogramować funkcję celu w algorytmie AGI, żeby była nam przyjazna, a nie wchodziła z nami w konflikt o zasoby? Albo jak sprawić, iż AGI sama się takiej funkcji celu skutecznie nauczy i będzie ją z powodzeniem realizować? Nie wiemy. Jak mówi Nick Bostrom, potrzebujemy dziś dobrej filozofii na deadline.

Tylko, że deadline ten jest krótki, bo nadludzka AGI może powstać w ciągu choćby kilku-kilkunastu lat. Oczekiwany przełom filozoficzny musi się też dokonać w całości w ramach badań teoretycznych, ponieważ nie będzie możliwości przetestowania skutków różnych funkcji celu AGI w praktyce. Gdyby się bowiem miało okazać, iż dany algorytm jest nieprzyjazny, byłoby już za późno, by go wyłączyć. W przypadku AGI metoda prób i błędów nie działa, a to zdecydowanie nie rokuje dobrze.

Czytaj też: Gorączka sztucznej inteligencji. Efekt? Koncentracja biznesu w metropoliach

Czytaj też: Najlepsza logistyka na świecie przy wsparciu sztucznej inteligencji. Ludzkość zyska?

Źródło zdjęcia: Greg Rakozy/Unsplash