Generał armii USA nie ukrywa, iż ChatGPT stał się jego cyfrowym współpracownikiem. Czatbot pomaga mu w podejmowaniu decyzji „we adekwatnym momencie”.

ChatowiGPT już nie raz i nie dwa udowodniono zmyślanie faktów, bezrefleksyjne przytakiwanie użytkownikowi czy mylenie się w kwestiach możliwych do zweryfikowania przez pierwszą lepszą stronę wyszukaną w wyszukiwarce Google. Brzmi jak idealny kandydat na asystenta generała, nie?

Amerykański generał rozmawia z ChatGPT o decyzjach dotyczących żołnierzy

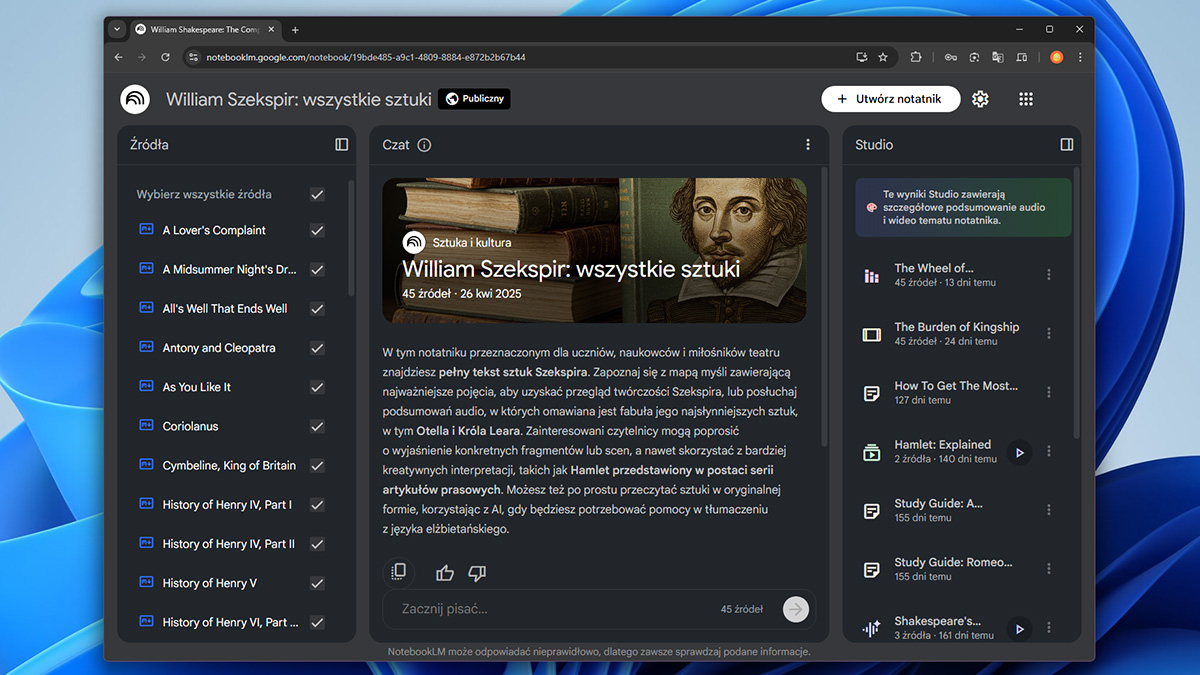

Jak ujawnił Business Insider, amerykański generał William „Hank” Taylor, dowodzący 8. Armią Stanów Zjednoczonych w Korei Południowej, przyznał publicznie, iż regularnie korzysta z ChatGPT, by „dokonywać lepszych decyzji” – zarówno zawodowych, jak i osobistych. – Chat i ja staliśmy się ostatnio naprawdę bliscy” – powiedział Taylor podczas konferencji Stowarzyszenia Armii Stanów Zjednoczonych w Waszyngtonie.

Generał tłumaczył, iż eksperymentuje z generatywną sztuczną inteligencją, by „zbudować modele pomagające wszystkim w dowodzeniu” oraz by lepiej rozumieć proces podejmowania decyzji. Jak zaznaczył, tempo rozwoju AI jest dla niego wyzwaniem, ale potencjalna przewaga, jaką technologia może dać dowódcy, jest zbyt duża, by ją ignorować. – Chcę podejmować decyzje we adekwatnym momencie, by zyskać przewagę” – powiedział.

Z pozoru brzmi to jak niewinna próba nadążenia za cyfrową rewolucją. Ale trudno przejść obojętnie obok faktu, iż mowa o oficerze odpowiedzialnym za tysiące żołnierzy stacjonujących w jednym z najbardziej napiętych regionów świata. ChatGPT – mimo spektakularnych możliwości – potrafi nie tylko popełniać błędy faktograficzne, ale także wymyślać nieistniejące źródła i przekonywać użytkownika o ich prawdziwości z niezmąconą pewnością siebie.

To, iż wojskowy najwyższego szczebla otwarcie przyznaje się do konsultowania decyzji z czatbotem, jest więc wydarzeniem symbolicznym. Z jednej strony pokazuje, jak gwałtownie generatywna AI wchodzi w codzienną praktykę pracy – nie tylko korporacyjnych menedżerów, ale i dowódców sił zbrojnych. Z drugiej – rodzi pytania o granice zaufania wobec systemów, które same przyznają, iż potrafią się mylić.

Użycie ChataGPT motywowane OODĄ?

W amerykańskiej doktrynie wojskowej od czasów wojny koreańskiej funkcjonuje koncepcja OODA loop – obserwuj, orientuj się, decyduj, działaj. Według niej przewagę na polu bitwy zyskuje ten, kto szybciej podejmuje decyzje. I właśnie w tym miejscu pojawia się AI: w przyszłych konfliktach decyzje mogą być podejmowane „nie w ludzkim, ale maszynowym tempie” – jak ostrzegali w styczniu przedstawiciele sił powietrznych USA.

Sztuczna inteligencja jest już dziś integrowana z systemami dronów, analizą danych wywiadowczych czy procesami logistycznymi. Wykorzystuje się ją także do przetwarzania dokumentów, raportów i analiz doktryn wojskowych. Pentagon jednak wielokrotnie apelował o ostrożność: generatywna AI może prowadzić do wycieków danych, halucynować podczas generowania odpowiedzi lub dawać błędne rekomendacje.

Generał Taylor najwyraźniej widzi w ChatGPT nie tyle narzędzie pola walki, co cyfrowego doradcę – choć z doradcą, który ma tendencję do przesadnego optymizmu i nie zawsze mówi prawdę. Można się więc tylko zastanawiać, czy kolejne strategiczne decyzje amerykańskiej armii będą konsultowane w oknie czatu, w którym ktoś wcześniej prosił o wygenerowanie treści oficjalnego listu lub mema o wrogu.

Może zainteresować cię także: