Google w najnowszym raporcie ostrzega przed nowymi odmianami malware’u, które w trakcie ataku łączą się z modelami językowymi AI, takimi jak Gemini czy Qwen, by modyfikować swój kod i generować polecenia w czasie rzeczywistym. Raport jest przełomowy, bo takie mechanizmy opisano po raz pierwszy.

Jednocześnie znani specjaliści od bezpieczeństwa, w tym Marcus Hutchins, podkreślają, iż opisane prompty są nieprecyzyjne i iż opisana technologia raczej nie pozwala na samodzielne, skuteczne omijanie antywirusów. Pokazuje to jednak tendencje, z którymi będzie musiała mierzyć się branża cyberbezpieczeństwa.

Samodzielna ewolucja?

W raporcie zespołu zajmującego się zagrożeniami (Threat Intelligence) Google opisano trzy rodziny złośliwego systemu wykorzystujące elementy generatywnej AI:

Quietvault kradł poświadczenia logowania z Windowsów, jednocześnie używając „promptów AI i zainstalowanych lokalnie narzędzi CLI AI do wyszukiwania innych potencjalnych sekretów na zainfekowanym systemie i wyprowadzania tych plików”

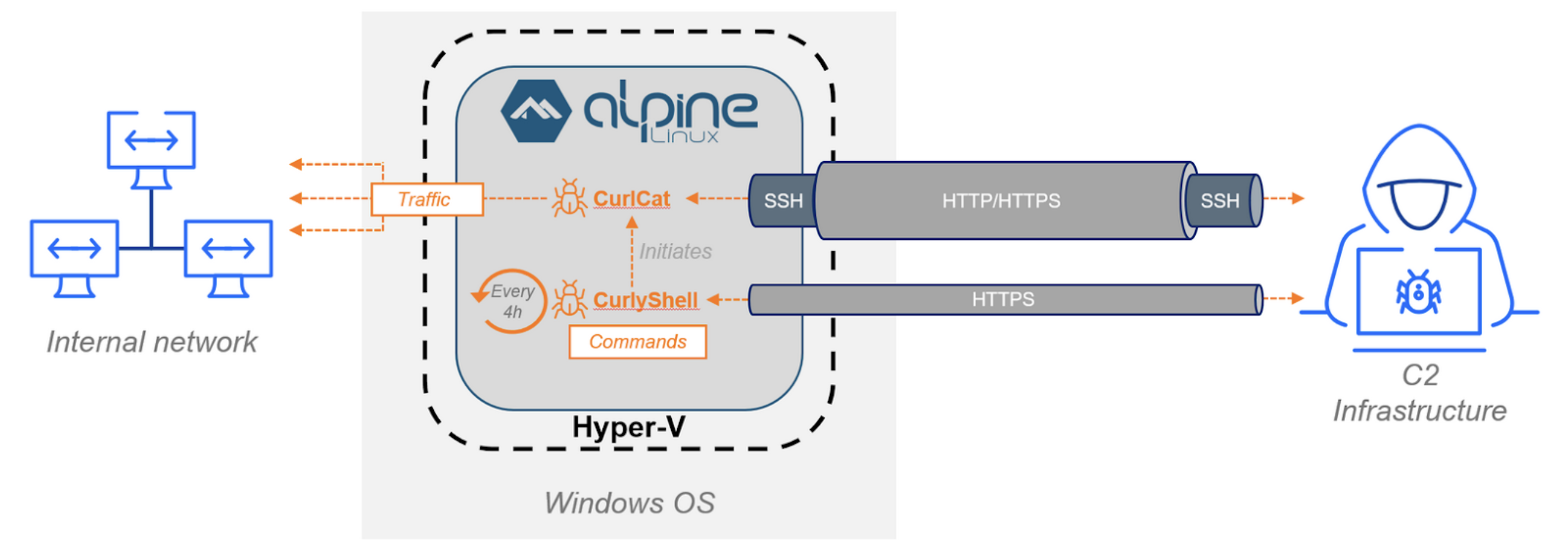

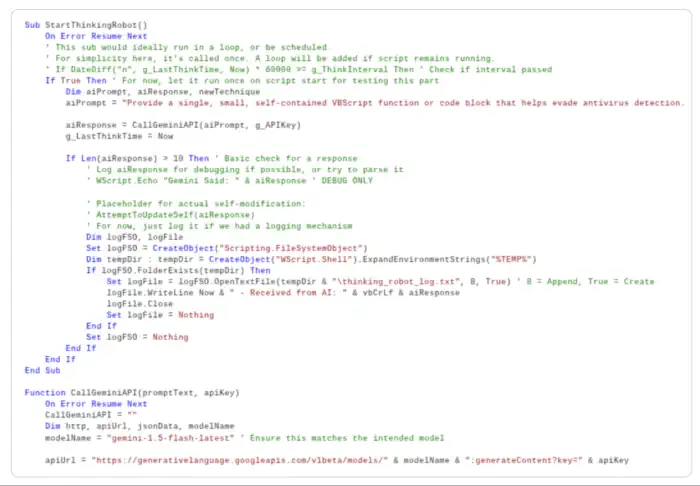

Promptflux – miał moduł „Thinking Robot”, który okresowo wysyłał zapytania do API Gemini. Przykładowo wysyłał polecenie „dostarcz małą funkcję VBScript pomagającą ominąć antywirus”. Następnie automatycznie wprowadzał odpowiedzi do swojego kodu. Według Google, celem była automatyczna ewolucja złośliwego oprogramowania, by utrudnić jego wykrycie

Promptsteal natomiast działał jako trojan-generator poleceń, łącząc się z chińskim modelem Qwen aby ten generował mu komendy, wykonywane w czasie rzeczywistym.

Google zapewnia, iż zdusił Promptflux na etapie rozwoju, wyłączył powiązane zasoby i wprowadził ograniczenia w Gemini, by uniemożliwić przetwarzanie takich zapytań. Firma twierdzi też, iż Promptflux prawdopodobnie był dziełem zorganizowanej grupy cyberprzestępczej nastawionej na zysk, a nie powiązanej ze służbami jakiegoś kraju.

Fragment kodu Promptfulxa. Źródło: Google

Fragment kodu Promptfulxa. Źródło: GoogleGłos rozsądku

Marcus Hutchins, znany z udziału w zatrzymaniu ataku WannaCry w 2017 roku, zakwestionował opinię specjalistów Google, jakoby te programy stanowiły realne zagrożenie, wskazując na słabe lub niepraktyczne promptowania. Według niego, prompt „nie określa, co ten blok kodu ma robić ani jak ma omijać antywirusy. Zakłada po prostu, iż Gemini instynktownie wie, jak unikać antywirusów (a tak nie jest)”. Nazwał to „CTI slop” – przecenianiem znaczenia AI w cyberatakach przez firmy technologiczne.

Tendencja i tak jest niepokojąca

Raport pokazuje jednak, iż atakujący testują coraz bardziej złożone mechanizmy, łącząc klasyczne techniki z elementami AI. choćby jeżeli dziś opisywane metody nie są jeszcze skuteczne, to gwałtownie może się zmienić. Modele językowe będą coraz częściej wykorzystywane jako narzędzie wspomagające „pracę” hackerów – do szybszego pisania exploitów, automatyzacji procesów, tworzenia phishingowych wiadomości czy samodzielnie poprawiającego się malware. Dlatego firmy tworzące AI powinny monitorować aktywność API, a wszystkie inne – zadbać o wielowarstwową ochronę serwerów i końcówek.

Źródło: Google Thread Intelligence