Czy znasz historię technologii AI, o których ciągle się mówi? Dzisiaj zagłębimy się w temat: „Jak długo istnieje sztuczna inteligencja?” razem z Tobą.

Sztuczna inteligencja (AI), stosunkowo nowa dziedzina z około 60-letnią historią, to zbiór nauk, teorii i metod, które próbują odtworzyć ludzkie zdolności poznawcze. Obejmują one:

- Logika matematyczna

- Statystyka, prawdopodobieństwo

- Neuronauka obliczeniowa

- Informatyka

Począwszy od II wojny światowej, jego postęp jest ściśle powiązany z rozwojem komputerów i umożliwił komputerom podejmowanie coraz bardziej skomplikowanych zadań, które wcześniej były odpowiednie wyłącznie dla ludzi.

Jak długo istnieje sztuczna inteligencja?

Od 1940 roku słowo sztuczna inteligencja (AI) jest obecne w naszym życiu. Niektórzy eksperci uważają ten termin za mylący, ponieważ ta technologia wciąż jest daleka od prawdziwej ludzkiej inteligencji. Ich badania nie posunęły się jeszcze do punktu, w którym można je porównać z obecnymi osiągnięciami ludzkości. Postęp w naukach podstawowych byłby konieczny, aby „silna” sztuczna inteligencja, która pojawiła się dopiero w science fiction, była w stanie modelować cały świat.

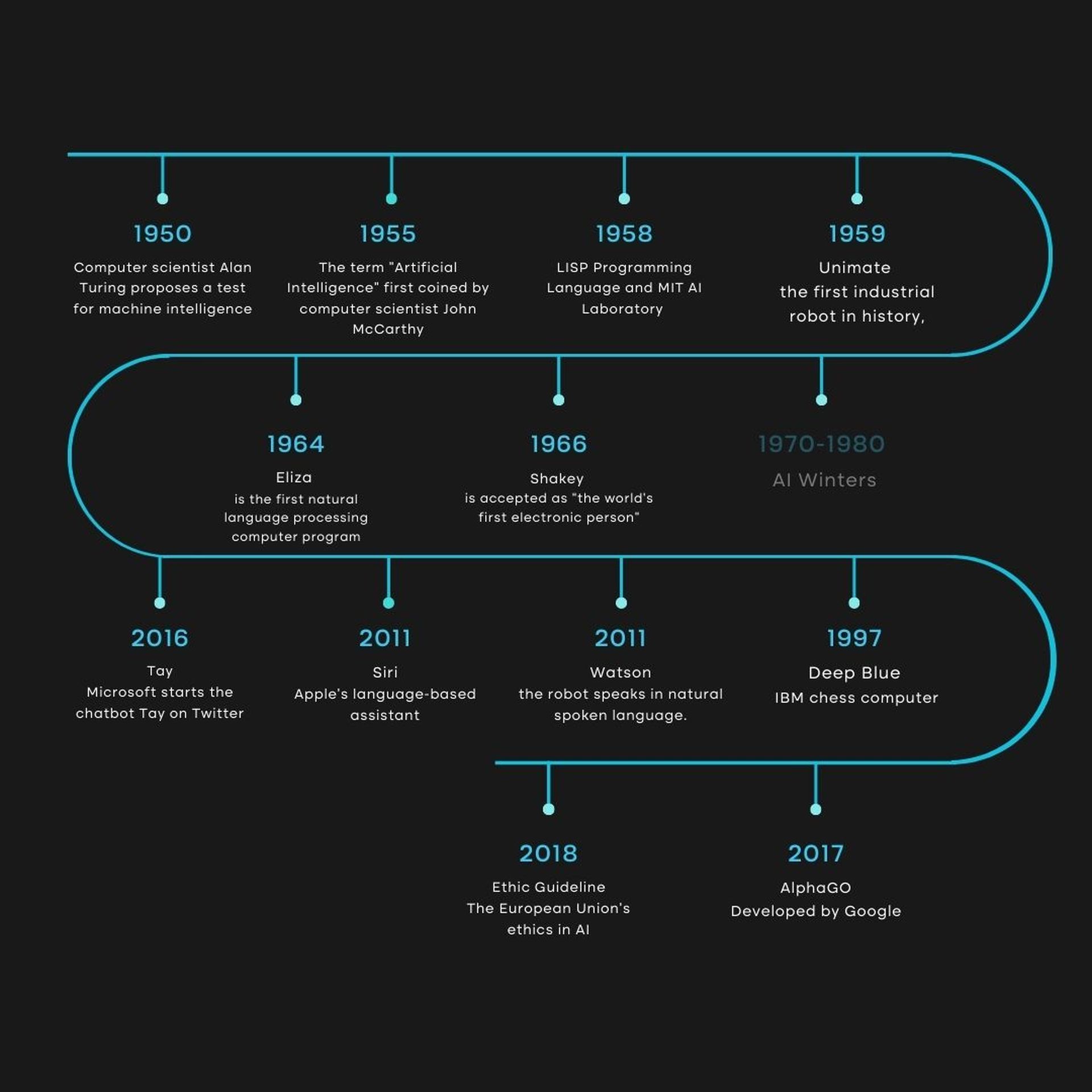

Jak długo istnieje sztuczna inteligencja: oś czasu sztucznej inteligencji

Jak długo istnieje sztuczna inteligencja: oś czasu sztucznej inteligencjiJednak od 2010 roku dziedzina ta odnotowała nowy wzrost popularności, głównie w wyniku znacznych postępów w mocy obliczeniowej komputerów i łatwego dostępu do ogromnych ilości danych. Obiektywnemu zrozumieniu problemu przeszkadzają powtarzające się obietnice i zmartwienia, o których czasami się fantazjuje.

Naszym zdaniem krótki przegląd historii dyscypliny może posłużyć jako rama dla obecnych dyskusji.

1940–1960: narodziny AI

Splot postępu technologicznego i poszukiwanie zrozumienia, jak połączyć funkcjonowanie maszyn i istot organicznych w latach 1940-1960 pozostawił niezatarte wrażenie.

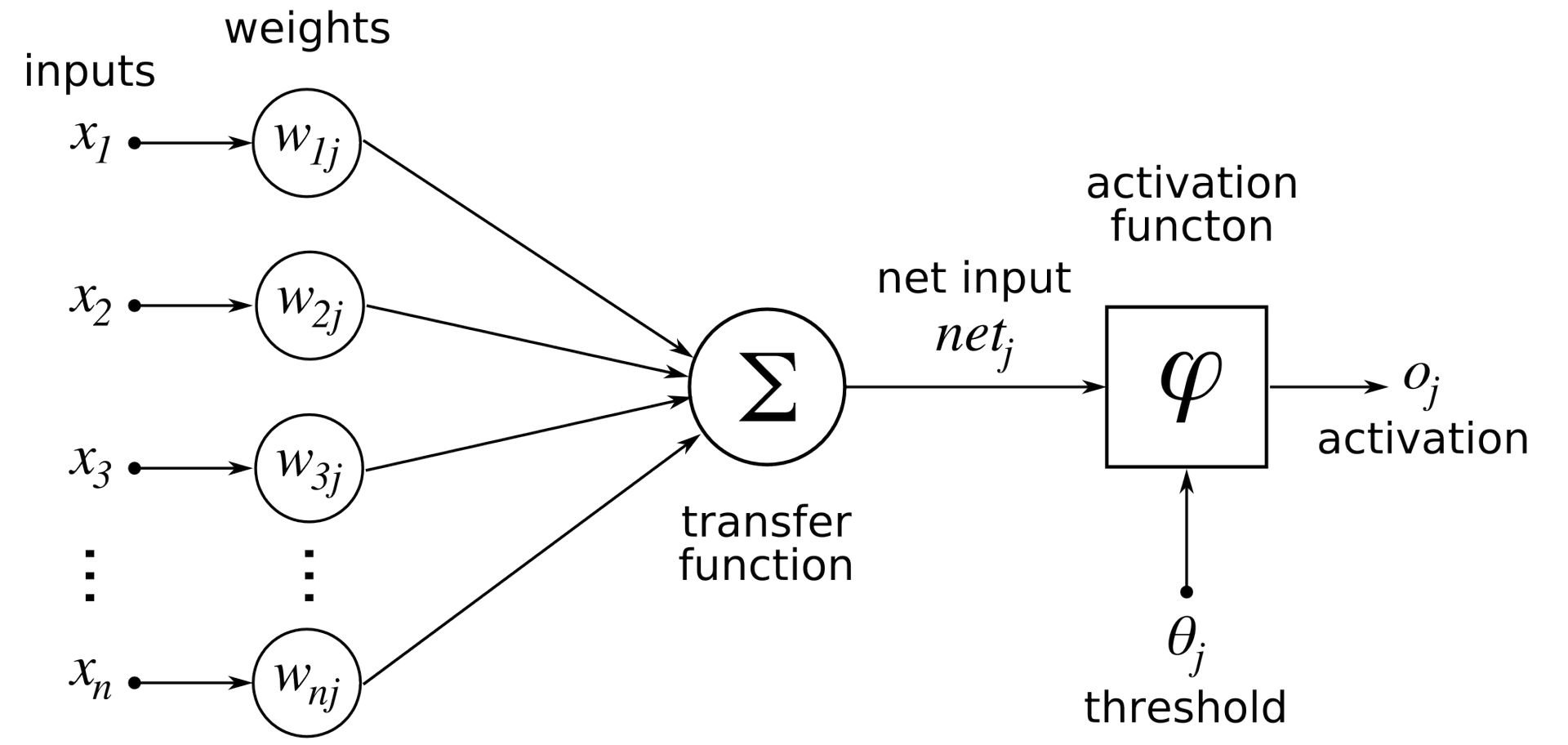

Aby stworzyć „całą teorię sterowania i komunikacji, zarówno u zwierząt, jak i maszyn”, Norbert Wiener, pionier w dziedzinie cybernetyki, dostrzegł potrzebę zintegrowania teorii matematycznej, elektroniki i automatyki. Wcześniej Warren McCulloch i Walter Pitts stworzyli pierwszy matematyczny i komputerowy model neuronu biologicznego w 1943 roku.

Jak długo istnieje sztuczna inteligencja: matematyczny model neuronów sztucznej inteligencji

Jak długo istnieje sztuczna inteligencja: matematyczny model neuronów sztucznej inteligencjiChociaż nie wymyślili terminu sztuczna inteligencja (AI) na początku 1950 roku, John Von Neumann i Alan Turing byli pionierami technologii, która leży u jego podstaw. Pomogli komputerom przejść na dziewiętnastowieczną logikę dziesiętną, a maszynom na logikę binarną. W ten sposób obaj badacze skodyfikowali architekturę dzisiejszych komputerów i pokazali, iż są one uniwersalnym urządzeniem, które może wykonać to, co zostało zaprogramowane. Z drugiej strony Turing w swoim słynnym artykule z 1950 roku „Computing Machinery and Inteligencja.”

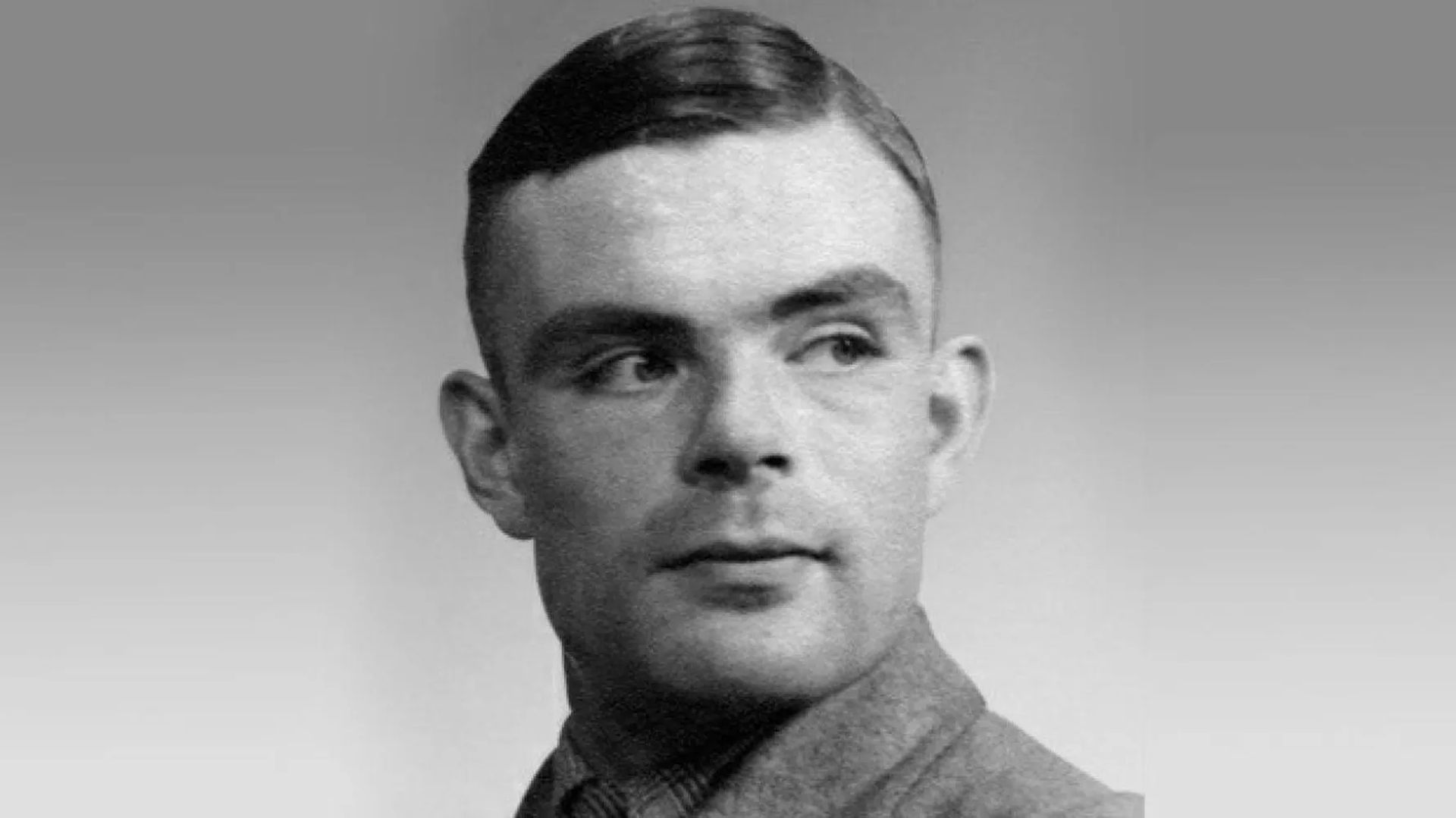

Jak długo istnieje sztuczna inteligencja: Alan Turing

Jak długo istnieje sztuczna inteligencja: Alan TuringNiezależnie od tego, jak kontrowersyjna może być, ta praca jest często uważana za punkt wyjścia do dyskusji o tym, gdzie powinna przebiegać granica między ludźmi a maszynami.

Johnowi McCarthy’emu z MIT przypisuje się wynalezienie „AI”, którą Marvin Minsky definiuje jako:

„Rozwój programów komputerowych angażujących się w zadania, które w tej chwili są lepiej wykonywane przez ludzi, ponieważ wymagają procesów umysłowych wysokiego poziomu, takich jak uczenie się percepcyjne, organizacja pamięci i krytyczne rozumowanie”.

Rozpoczęcie tej dyscypliny przypisuje się sympozjum, które odbyło się w Dartmouth College latem 1956 r. Anegdotycznie, należy zwrócić uwagę na warsztaty, które były głównym wydarzeniem konferencji. McCarthy i Minsky byli dwiema z sześciu osób, które stale uczestniczyły w tych wysiłkach.

We wczesnych latach sześćdziesiątych atrakcyjność technologii spadła, chociaż przez cały czas była ekscytująca i obiecująca. Ze względu na niewielką ilość pamięci komputerów używanie języka komputerowego było trudne.

IPL, czyli język przetwarzania informacji, umożliwił zatem opracowanie programu LTM, który próbował pokazać twierdzenia matematyczne, już w 1956 roku. Jednak były też pewne podstawy, które są obecne do dziś, takie jak drzewa rozwiązań do rozwiązywać twierdzenia matematyczne.

1980-1990: Systemy ekspertowe

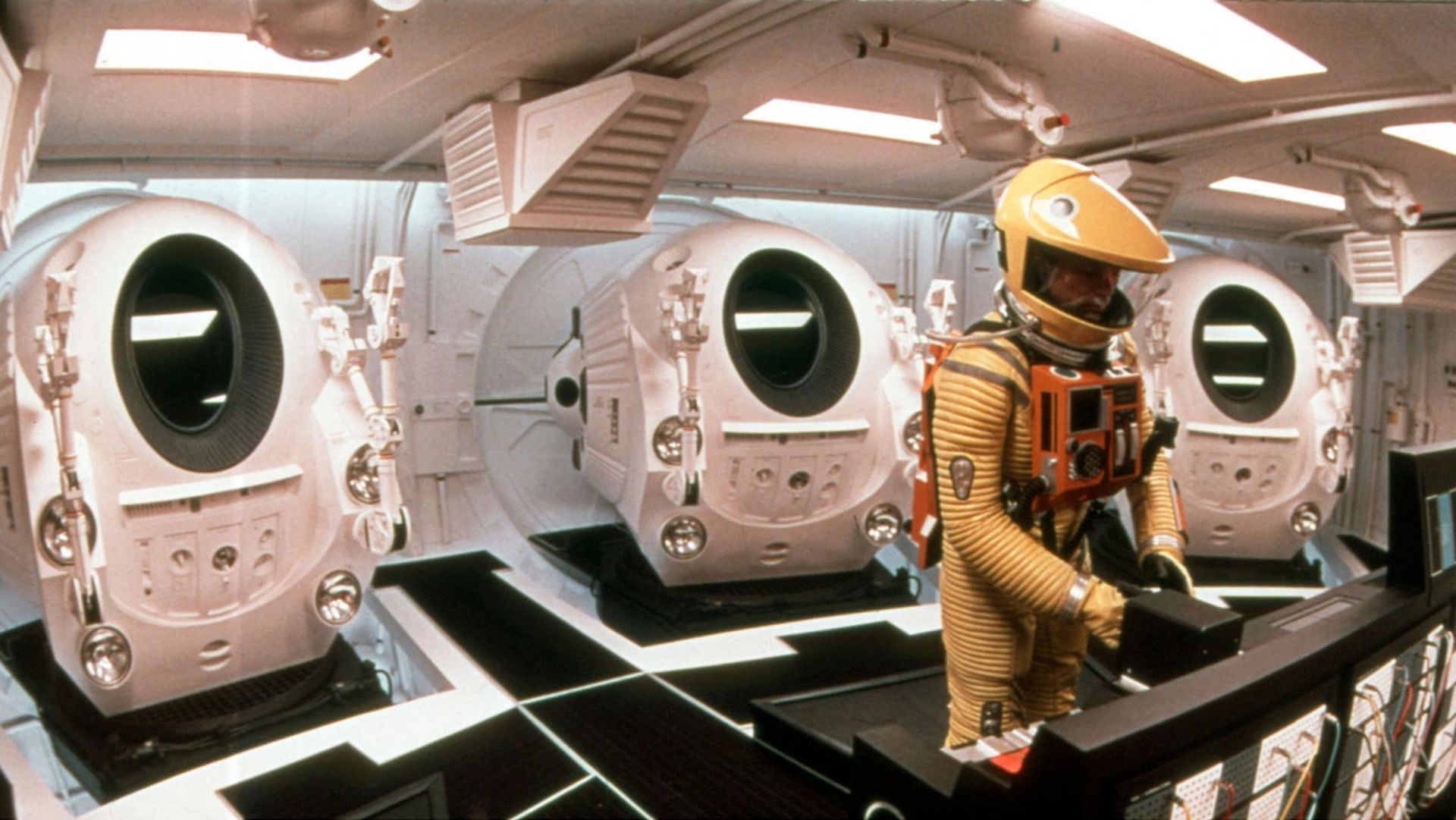

Film „2001 Space Odyssey” z 1968 roku, wyreżyserowany przez Stanleya Kubricka, przedstawia komputer o nazwie HAL 9000, który obejmuje wszystkie etyczne problemy związane ze sztuczną inteligencją:

„Czy to będzie bardzo wyrafinowane, korzystne dla ludzkości, czy też niebezpieczne?”

Wpływ filmu oczywiście nie będzie miał charakteru naukowego, ale pomoże uczynić temat bardziej znanym, podobnie jak powieściopisarz science fiction Philip K. Dick, który nigdy nie przestanie się zastanawiać, czy maszyny mogą kiedykolwiek odczuwać emocje.

Jak długo istnieje sztuczna inteligencja: film z 1968 r. „Odyseja kosmiczna 2001”

Jak długo istnieje sztuczna inteligencja: film z 1968 r. „Odyseja kosmiczna 2001”Pierwsze mikroprocesory zostały wprowadzone pod koniec 1970 r., a systemy eksperckie wkroczyły w swój rozkwit, gdy sztuczna inteligencja ponownie wystartowała. Podejście to zostało upublicznione na Uniwersytecie Stanforda w 1972 roku z MYCIN i na MIT w 1965 roku z DENDRAL. Systemy te opierały się na „silniku wnioskowania”, który został zbudowany jako logiczna replika ludzkiego rozumowania. Przekazując mu informacje, silnik generował wysoce kompetentne odpowiedzi.

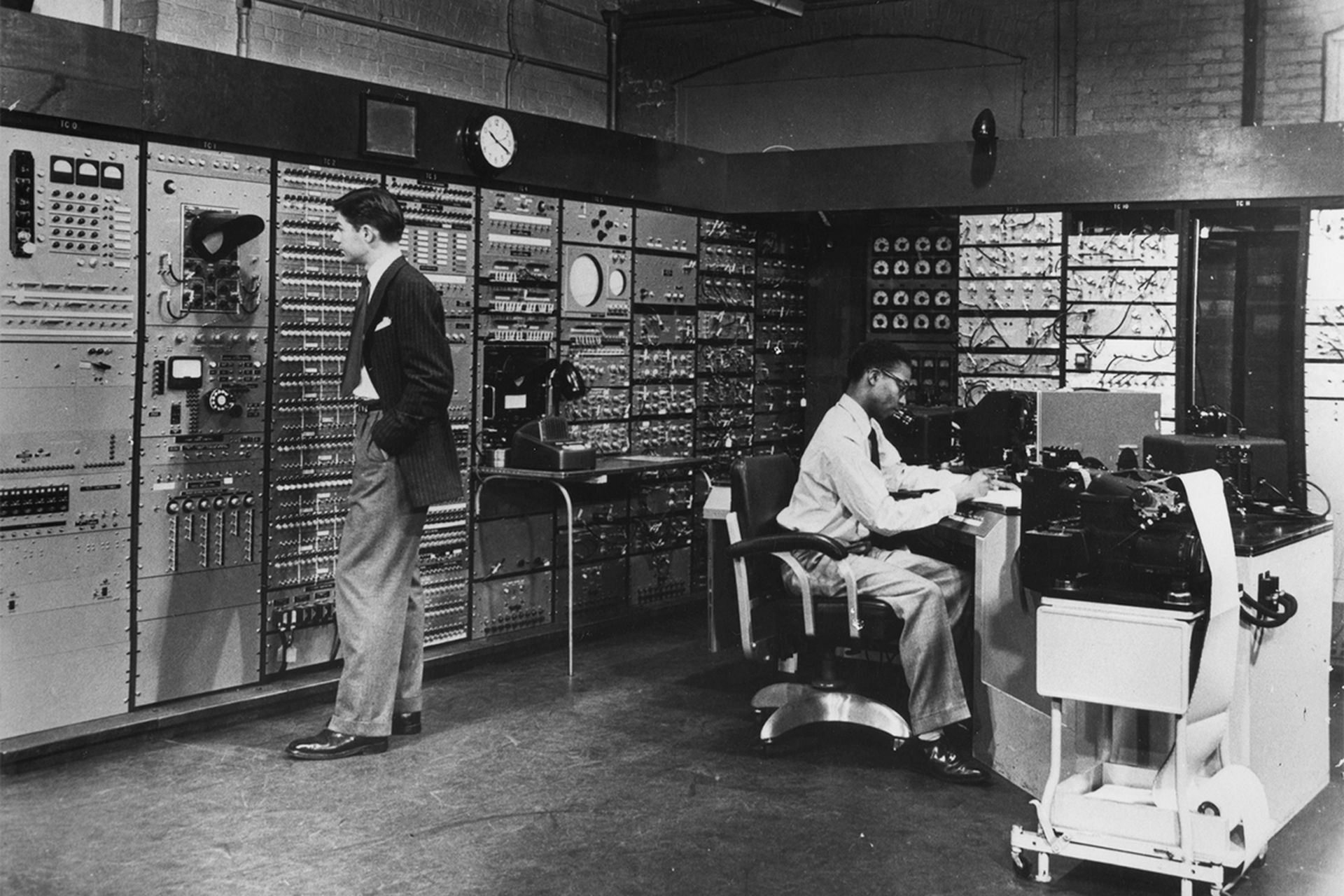

Jak długo istnieje sztuczna inteligencja: badania MIT AI

Jak długo istnieje sztuczna inteligencja: badania MIT AIObietnice przewidywały znaczny postęp, ale pod koniec 1980 lub na początku 1990 roku entuzjazm osiągnął szczyt. Zaimplementowanie takich informacji wymagało dużo pracy, a między 200 a 300 regułami pojawił się efekt „czarnej skrzynki”, który przesłonił logikę maszyny. W ten sposób tworzenie i utrzymanie stało się niezwykle trudne, a co najważniejsze, dostępnych było wiele innych, szybszych, mniej trudnych i bardziej przystępnych cenowo opcji. Należy pamiętać, iż w latach 90. wyrażenie „sztuczna inteligencja” prawie zniknęło ze słownika akademickiego, a choćby pojawiły się bardziej stonowane formy, takie jak „zaawansowana informatyka”.

W maju 1997 roku superkomputer IBM Deep Blue’s odniósł zwycięstwo nad Garrym Kasparowem w meczu szachowym, jednak nie zachęciło to do finansowania i rozwoju tego typu sztucznej inteligencji.

Deep Blue działał metodą metodycznej brutalnej siły, w której wszystkie potencjalne ruchy zostały zważone i ocenione. Chociaż Deep Blue był w stanie zaatakować tylko stosunkowo mały obszar i był daleki od symulowania złożoności globu, porażka człowieka pozostała niezwykle symbolicznym wydarzeniem w historii.

Jak długo istnieje sztuczna inteligencja: Deep Blue kontra Gary Kasparow, 1997

Jak długo istnieje sztuczna inteligencja: Deep Blue kontra Gary Kasparow, 19972010-dzisiaj: Nowoczesna era sztucznej inteligencji

Technologie sztucznej inteligencji, które znalazły się w centrum uwagi po porażce Kasparowa z superkomputerem Deep Blue, osiągnęły szczyt w połowie 2010 roku. Dwa czynniki mogą wyjaśniać nowy boom w tej dyscyplinie około 2010 roku:

- Dostęp do ogromnych ilości danych

- Odkrycie procesorów kart graficznych do komputerów, które działają z niezwykle wysoką wydajnością

Osiągnięcia publiczne, które stały się możliwe dzięki tej nowej technologii, zwiększyły inwestycje, a Watson, sztuczna inteligencja IBM, pokona dwóch mistrzów Jeopardy w 2011 roku.

Sztuczna inteligencja będzie w stanie rozpoznawać koty na filmach w 2012 roku dzięki Google X. To ostatnie wyzwanie wymagało zatrudnienia ponad 16 000 procesorów, ale potencjał maszyny, która może nauczyć się rozróżniać różne rzeczy, był zdumiewający.

W 2016 roku Lee Sedol i Fan Hui, mistrzowie Europy i świata w Go Games, przegraliby z Google AI AlphaGO.

Jak długo istnieje sztuczna inteligencja: AlphaGO kontra Ke Jie, maj 2017 r

Jak długo istnieje sztuczna inteligencja: AlphaGO kontra Ke Jie, maj 2017 rSkąd wziął się ten cud? Radykalne odejście od systemów ekspertowych. Metodologia zmieniła się na indukcyjną; zamiast kodowania reguł, jak w przypadku systemów ekspertowych, konieczne jest w tej chwili umożliwienie komputerom samodzielnego ich odkrywania poprzez korelację i kategoryzację na podstawie ogromnych ilości danych.

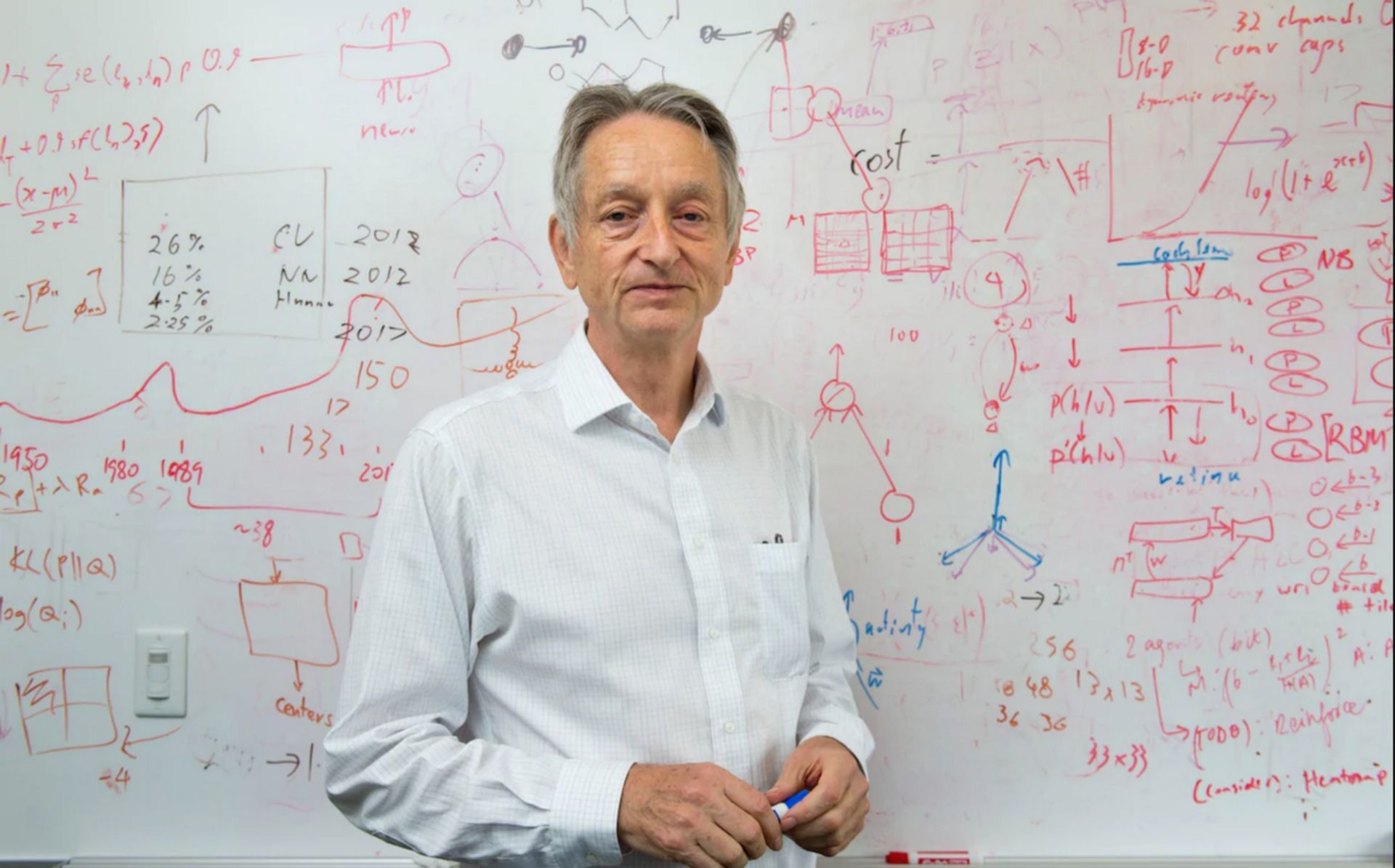

Głębokie uczenie się wydaje się być najbardziej obiecującą technologią uczenia maszynowego dla różnych zastosowań. Geoffrey Hinton, Yoshua Bengio i Yann LeCun postanowili rozpocząć w 2003 roku program badawczy mający na celu modernizację sieci neuronowych. Przy pomocy laboratorium w Toronto eksperymenty prowadzone równolegle o godz Microsoftu, Googleoraz IBM wykazało, iż ten rodzaj uczenia się skutecznie zmniejszył o połowę wskaźniki błędów rozpoznawania mowy. Zespół rozpoznawania obrazu w Hinton odniósł podobny sukces.

Jak długo istnieje sztuczna inteligencja: Geoffrey Hinton

Jak długo istnieje sztuczna inteligencja: Geoffrey HintonNiemal z dnia na dzień zdecydowana większość zespołów badawczych przyjęła tę technologię, która miała niezaprzeczalne zalety. Chociaż dzięki tej formie uczenia się nastąpiła znaczna poprawa rozpoznawania tekstu, według specjalistów takich jak Yann LeCun wciąż jest długa droga do stworzenia systemów rozumienia tekstu.

Agenci konwersacji stanowią dobrą ilustrację tej trudności: podczas gdy nasze telefony są w tej chwili zdolne do transkrypcji instrukcji, nie są w stanie odpowiednio ich kontekstualizować ani rozpoznać naszych intencji.

W ten sposób podsumowaliśmy dla Ciebie dotychczasowy rozwój technologii AI. Czytaj nas dalej, aby nie przegapić najnowszych wiadomości na temat technologii sztucznej inteligencji, takich jak Notion AI i Meta Galactica AI