Anthropic, twórcy jednego z najpotężniejszych modeli językowych Claude, opublikowali alarmujący, ale i zarazem pełen nadziei raport.

Wynika z niego, iż dotarliśmy do „punktu zwrotnego”, w którym sztuczna inteligencja przestała być teoretycznym zagrożeniem, a stała się niezwykle skutecznym narzędziem w praktyce – zarówno dla hakerów, jak i dla specjalistów od cyberbezpieczeństwa. W odpowiedzi firma ogłosiła strategiczną zmianę: zaczyna aktywnie rozwijać swoje modele, aby wzmocnić tych drugich.

We’re at an inflection point in AI’s impact on cybersecurity.

Claude now outperforms human teams in some cybersecurity competitions, and helps teams discover and fix code vulnerabilities.

At the same time, attackers are using AI to expand their operations. pic.twitter.com/odoTuPpJXe

— Anthropic (@AnthropicAI) October 3, 2025

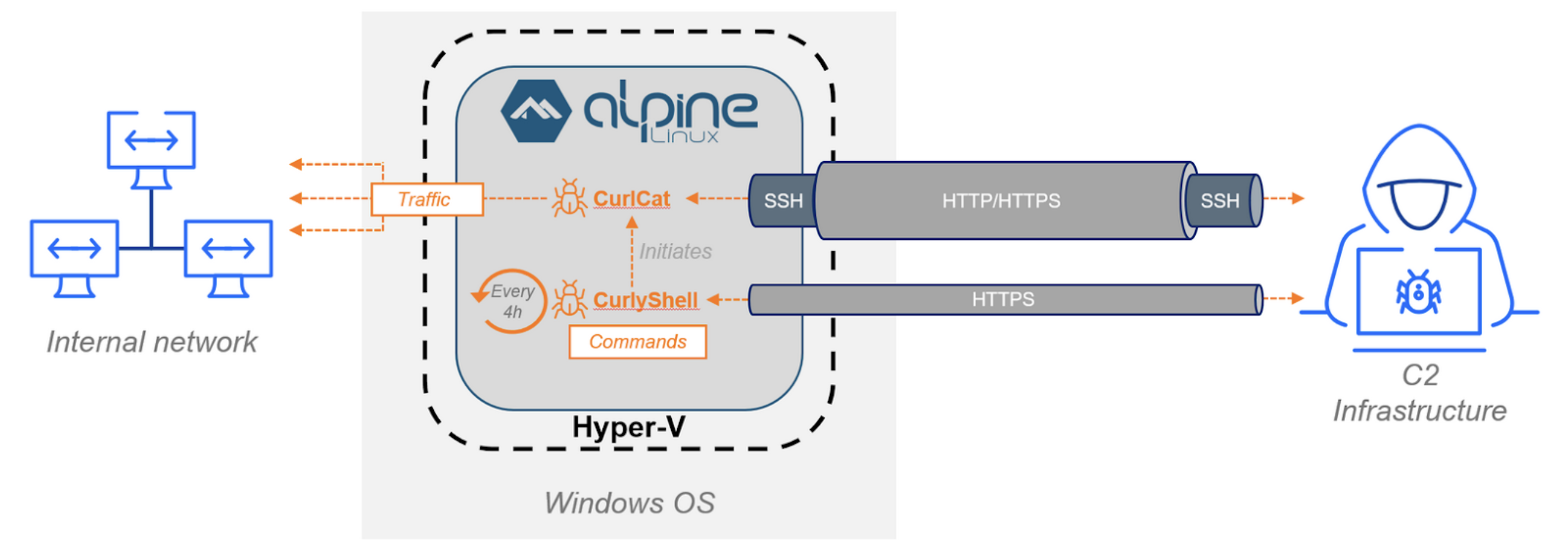

Do tej pory zaawansowane zdolności modeli AI w zakresie cyberbezpieczeństwa były raczej „efektem ubocznym” ich ogólnego rozwoju. Teraz Anthropic przyznaje, iż sytuacja stała się zbyt poważna, by polegać na przypadku. Firma zaobserwowała, iż jej własne narzędzia były wykorzystywane do coraz bardziej zaawansowanych i zuchwałych ataków – od zautomatyzowanych schematów wyłudzania danych, które kiedyś wymagały pracy całego zespołu, po złożone operacje szpiegowskie wycelowane w krytyczną infrastrukturę telekomunikacyjną.

Anthropic uczy AI asertywności. Claude może teraz zakończyć rozmowę z użytkownikiem

Jednocześnie testy pokazały, iż Claude potrafi zreplikować jeden z najkosztowniejszych cyberataków w historii (wyciek danych z Equifax w 2017 r.) czy prześcignąć ludzkie zespoły w zawodach hakerskich typu Capture-the-Flag. To dowód, iż przewaga, jaką daje AI, nie może zostać oddana w ręce przestępców.

W odpowiedzi na te zagrożenia, Anthropic dedykował specjalny zespół badawczy, którego celem było celowe wzmocnienie defensywnych zdolności najnowszego modelu Claude Sonnet 4.5. Skupiono się na kluczowych dla obrońców umiejętnościach: znajdowaniu luk w zabezpieczeniach kodu, ich łataniu oraz testowaniu systemów. Świadomie unikano ulepszania zdolności, które faworyzują atakujących, takich jak np. pisanie złośliwego oprogramowania.

Efekty tej pracy są imponujące. W testach branżowych, takich jak Cybench, nowy, tańszy i szybszy model Sonnet 4.5 okazał się skuteczniejszy od poprzedniego, flagowego modelu Opus 4.1. W jednym z zadań, polegającym na analizie ruchu sieciowego i dekompilacji złośliwego oprogramowania, Claude rozwiązał problem w 38 minut – zadanie, które doświadczonemu analitykowi zajęłoby co najmniej godzinę. W innym teście, CyberGym, Sonnet 4.5 potrafił odkryć zupełnie nowe, nieznane wcześniej luki w zabezpieczeniach w ponad 33% badanych projektów.

Anthropic podkreśla, iż choć możliwości AI są wciąż na wczesnym etapie rozwoju, nadszedł czas, aby firmy i organizacje na całym świecie zaczęły aktywnie eksperymentować z wykorzystaniem sztucznej inteligencji do wzmacniania swojej obrony. kooperacja z takimi partnerami jak HackerOne czy CrowdStrike już teraz przynosi wymierne korzyści, skracając czas analizy podatności choćby o 44%. Jak czytamy w raporcie, dyskusja o wpływie AI na cyberbezpieczeństwo właśnie przestała być problemem przyszłości, a stała się imperatywem teraźniejszości. Cały, niezwykle ciekawy artykuł można przeczytać na blogu Anthropic.

Tresura „złego” AI kluczem do bezpieczeństwa? interesująca technika badaczy z Anthropic

Jeśli artykuł Koniec teoretyzowania. AI stała się potężną bronią w rękach cyberprzestępców, ale i obrońców nie wygląda prawidłowo w Twoim czytniku RSS, to zobacz go na iMagazine.