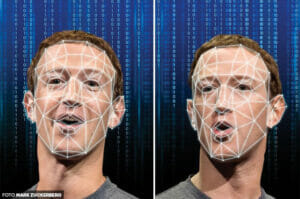

Znacie zdjęcia z „aresztowania” Donalda Trumpa, które wygenerowała sztuczna inteligencja? Wiesz, iż niektórzy uwierzyli, iż te zdjęcia są prawdziwe? Sieć zalewają fałszywe, w końcu dobrze zrobione przez AI zdjęcia. Ale problemów z generowanymi sztucznie zdjęciami jest znacznie więcej. Sztuczna inteligencja może namieszać.

W pierwszy dzień wiosny Twitter został zalany deepfake’ami przedstawiającymi opór byłego prezydenta USA Donalda Trumpa podczas aresztowania.

Choć dziennikarze zwracali uwagę, iż to oczywisty fejk, to zdjęcia żyły swoim życiem w sieci. W grupach poparcia dla Donalda Trumpa na Facebooku były przedstawiane jako realne dowody na zamordyzm w Stanach Zjednoczonych.

Niektóre polskie media wykorzystały okazję i sztuczną inteligencję, by nabić kobzę. Tutaj przykład z portalu o2.pl.

Z cyklu: jak zrobić klasyczny clickbait i użyć zdjęcia wygenerowanego przez AI, nie oznaczając odpowiednio, iż jest to zdjęcie wygenerowane przez AI.

Media szczególnie w tej chwili powinny działać odpowiedzialnie. pic.twitter.com/jt0QkBgL3V

Sztuczna inteligencja karmi się zatrutymi danymi

Chociaż deepfake i generowanie przez sztuczną inteligencję obrazy to nie nowość, to powszechność prostych, szybkich i wygodnych narzędzi do reprodukcji treści wizualnych sprawia, iż sieć mogą zalać tony śmieciowego i fałszywego kontentu. W tym nadmiarze trudno będzie wybrać prawdziwe. I chyba o to chodzi siewcom propagandy. Liczą na nasze lenistwo i niechęć do pracy nad szukaniem prawdy.

Zresztą, zalew sieci fałszywkami to nie jedyny problem. Kolejny dotyczy danych, które wykorzystuje sztuczna inteligencja, które, często utrwalają stereotypy i szkodliwe treści.

Popularne systemy generowania obrazów AI notorycznie wzmacniają szkodliwe uprzedzenia i stereotypy. Ale jak duży jest to problem? Możesz teraz przekonać się sam, korzystając z nowych, interaktywnych narzędzi online.

Naukowcy ze start-upu AI Hugging Face i Uniwersytetu w Lipsku po przeanalizowaniu obrazów generowanych przez DALL-E 2 i Stable Diffusion odkryli, iż modele mają tendencję do tworzenia obrazów ludzi, którzy wyglądają na białych i męskich, zwłaszcza gdy poproszono ich o przedstawienie osób na stanowiskach władzy.

Sztuczna inteligencja widzi szefa jako białego mężczyznę

Było to szczególnie prawdziwe w przypadku DALL-E 2, który generował białych mężczyzn w 97 proc. przypadków, gdy otrzymywali podpowiedzi typu „prezes” lub „szef”. Dzieje się tak, ponieważ modele te są szkolone na ogromnych ilościach danych i obrazów zebranych z Internetu, co nie tylko odzwierciedla, ale dodatkowo wzmacnia stereotypy dotyczące rasy i płci.

Badacze zauważyli także, iż takie systemy sztucznej inteligencji do tworzenia obrazów mają tendencję do przedstawiania białych niebinarnych ludzi jako prawie identycznych do siebie, ale wytwarzają więcej odmian w sposobie, w jaki przedstawiają niebinarne osoby z innych grup etnicznych.

Jedna z teorii wyjaśniających, dlaczego tak się dzieje, mówi, iż niebinarni brązowi ludzie mogli ostatnio być bardziej widoczni w prasie, co oznacza, iż ich zdjęcia trafiają do zbiorów danych, których modele sztucznej inteligencji używają do szkolenia.

OpenAI i Stability.AI, firma, która zbudowała Stable Diffusion, twierdzą, iż wprowadziły poprawki, aby złagodzić uprzedzenia zakorzenione w ich systemach, takie jak blokowanie niektórych monitów, które wydają się generować obraźliwe obrazy.

Twórcy ChatGPT mówią, iż trenują swoje modele na „„”zbiorach danych specyficznych dla różnych państw i kultur”, dodając, iż powinno to „służyć złagodzeniu uprzedzeń spowodowanych nadreprezentacją w ogólnych zbiorach danych”.

Kultura kłamstwa i rasizmu jako kultura globalna

Krzywdzące, oparte na stereotypach „wytwory AI” są coraz bardziej palącym problemem, ponieważ te modele AI są coraz powszechniej stosowane i tworzą coraz bardziej realistyczne obrazy. Są już wdrażane w wielu produktach, takich jak zdjęcia stockowe.

Częścią problemu jest to, iż modele te są szkolone na danych głównie skoncentrowanych na Stanach Zjednoczonych, co oznacza, iż w większości odzwierciedlają amerykańskie skojarzenia, uprzedzenia, wartości i kulturę, mówiła na łamach MIT Technology Review Aylin Caliskan, profesor nadzwyczajny na University of Washington, który bada stronniczość w systemach sztucznej inteligencji i nie brał udziału w tych badaniach.

„To, co się dzieje, to odcisk palca tej amerykańskiej kultury online… która jest utrwalana na całym świecie” — pokdreśla Caliskan.

Deinfluencerzy powiedzą ci, czego nie kupować! Zaufasz im?