Google mierzy się z rekordowym popytem na własne układy Tensor Processing Unit (TPU). Jak ujawnił Amin Vahdat, wiceprezes i dyrektor generalny ds. AI i infrastruktury w Google, zapotrzebowanie na chipy do przetwarzania sztucznej inteligencji jest tak duże, iż firma musi odrzucać część zamówień. Co więcej, choćby ośmioletnie generacje TPU pracują dziś z pełnym obciążeniem.

Wykorzystanie pełnej mocy TPU

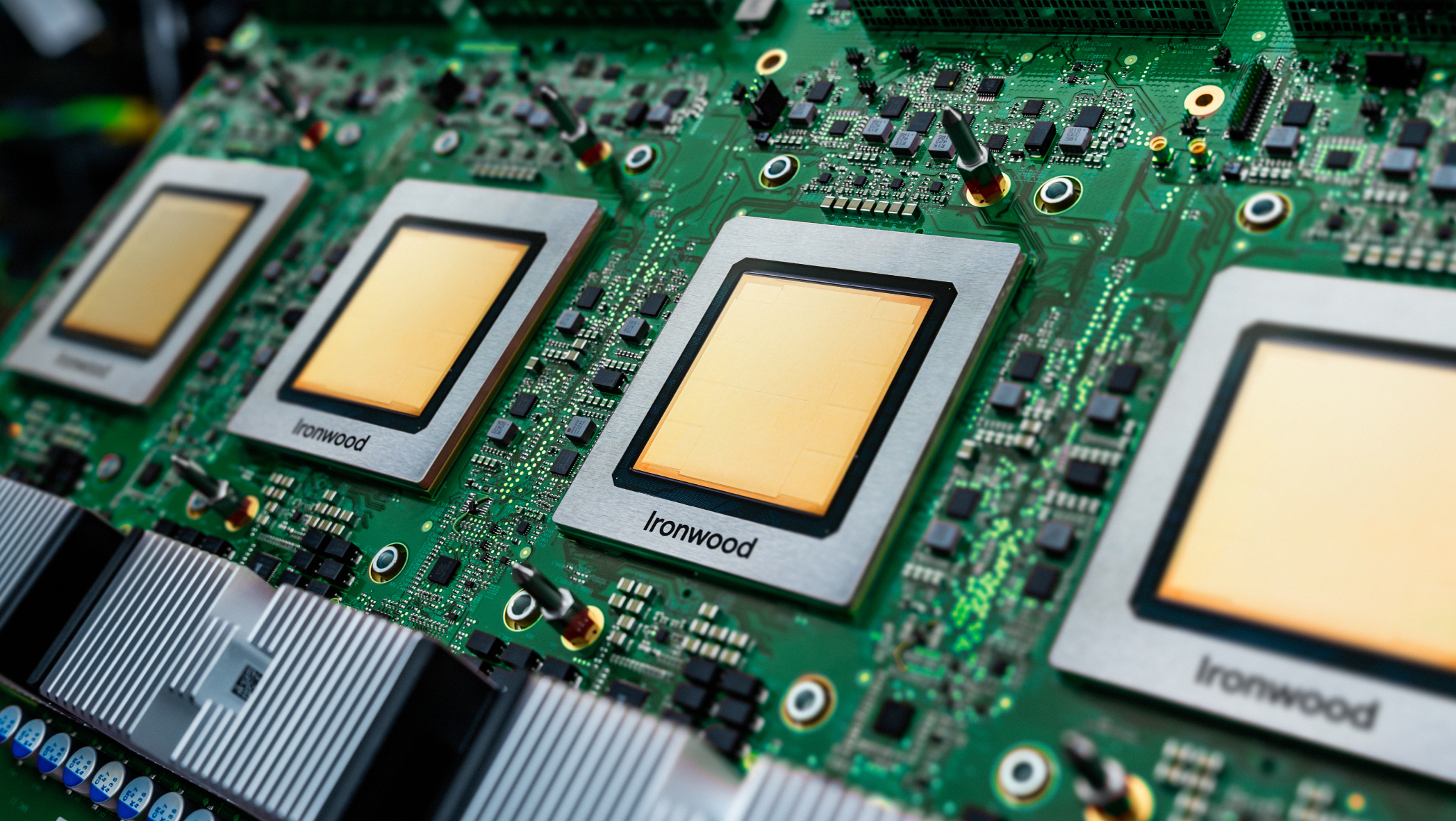

Podczas wystąpienia na konferencji Andreessen Horowitz Runtime Amin Vahdat poinformował, iż w centrach danych Google’a działa już siedem generacji TPU, a choćby najstarsze z nich, mające siedem i osiem lat, osiągają 100% wykorzystania. Najnowsza generacja, TPU Ironwood, została zaprezentowana w kwietniu 2025 r., ale popyt na nią przerasta możliwości produkcyjne.

„To pokazuje, jak ogromne jest zapotrzebowanie. Jesteśmy dopiero na początku cyklu inwestycji, przynajmniej w stosunku do tego, co widzimy po stronie popytu” – powiedział Vahdat.

Google przyznaje, iż rosnąca liczba klientów korzystających z modeli generatywnych i agentowych AI powoduje gwałtowny wzrost zużycia mocy obliczeniowych, a tym samym presję na dostawców infrastruktury.

TPU (Tensor Processing Unit) to wyspecjalizowane układy stworzone przez Google’a do obsługi obliczeń związanych z uczeniem maszynowym. Według Vahdata TPU są od 10 do 100 razy bardziej wydajne energetycznie niż tradycyjne procesory CPU w określonych zadaniach, takich jak trenowanie dużych modeli językowych czy obsługa algorytmów głębokiego uczenia.

Przyszłość procesorów to specjalizacja

Zdaniem Vahdata kluczowym kierunkiem rozwoju półprzewodników jest specjalizacja architektur, a nie ich uniwersalność. Google przewiduje, iż kolejne generacje procesorów będą projektowane pod konkretne klasy zadań, takie jak obsługa tzw. agentowych modeli AI, które wymagają innego profilu obliczeniowego niż klasyczne sieci neuronowe.

„Dla najlepszych zespołów projektowych na świecie droga od koncepcji do produkcji zajmuje dziś około dwóch i pół roku – jeżeli wszystko pójdzie idealnie, co rzadko się zdarza. Musimy skrócić ten cykl” – zaznaczył Vahdat.

Jego zdaniem kolejne fale innowacji będą oparte właśnie na jeszcze węższej specjalizacji, bo oszczędności energii, kosztów i miejsca w centrach danych są zbyt duże, by je ignorować.

Ograniczenia infrastruktury AI

Wiceprezes Google zwrócił uwagę, iż branża stoi przed szeregiem barier – od dostępności energii elektrycznej i działek pod nowe inwestycje, po czasochłonne procedury administracyjne i presję w łańcuchach dostaw. choćby ogromne środki inwestycyjne nie są w stanie natychmiast przełożyć się na wzrost dostępnej mocy obliczeniowej.

„Słyszałem rozmowy o bilionach dolarów, które mają zostać wydane, i wierzę, iż to realne liczby. Ale nie wiem, czy uda się je faktycznie spożytkować w takim tempie, jak byśmy chcieli. Ten deficyt potrwa jeszcze trzy, cztery, a może choćby pięć lat” – przyznał Vahdat.