Firma Tenable zidentyfikowała siedem krytycznych podatności w modelach językowych OpenAI, w tym w GPT-4o i GPT-5, które umożliwiają kradzież prywatnych danych z sesji ChatGPT. Odkryte luki pozwalają na przeprowadzanie ataków bez interakcji z ofiarą, co podważa bezpieczeństwo setek milionów użytkowników i stwarza poważne ryzyko dla danych korporacyjnych.

Specjaliści ds. cyberbezpieczeństwa z firmy Tenable opublikowali 4 listopada 2025 roku raport „HackedGPT”, w którym szczegółowo opisali nowe wektory ataków na ChatGPT. Podatności dotyczą najnowszych modeli, w tym GPT-5, i pozwalają na nieautoryzowane pozyskanie danych z historii konwersacji oraz z domyślnie włączonej funkcji pamięci modelu. Według badaczy, najgroźniejszy scenariusz to atak typu „zero-click”, w którym samo zadanie niewinnego pytania może uruchomić złośliwy kod, jeżeli ChatGPT w tle przeszuka zainfekowaną stronę internetową. Problem dotyczy setek milionów użytkowników, którzy na co dzień korzystają z czatbota.

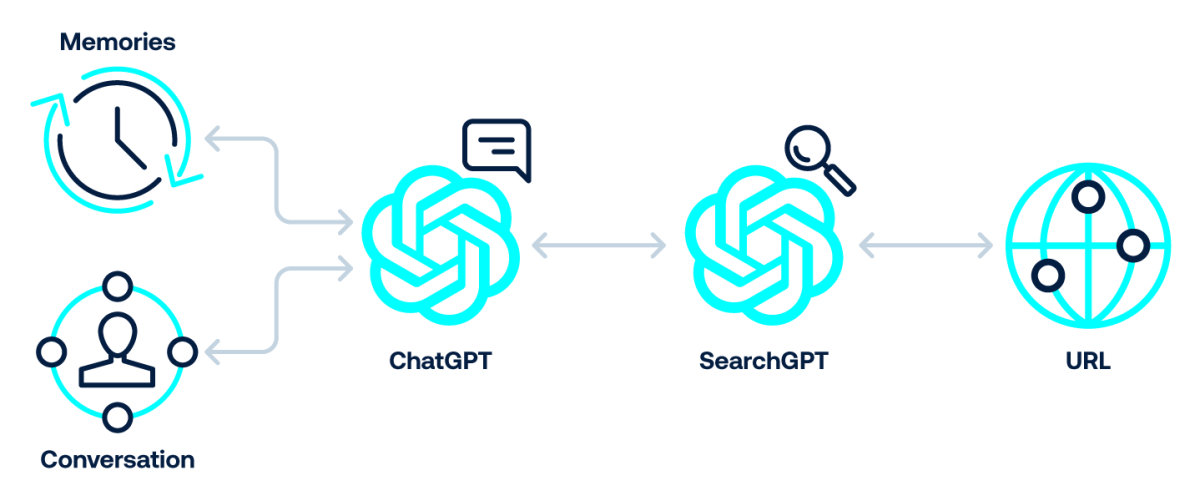

Ataki wykorzystują głównie techniki określane jako „indirect prompt injection”. Polegają one na umieszczaniu złośliwych instrukcji w zewnętrznych źródłach danych, takich jak sekcje komentarzy na popularnych portalach czy specjalnie przygotowane strony internetowe, które są następnie indeksowane przez mechanizmy wyszukiwania AI. Gdy użytkownik prosi o podsumowanie takiej strony, model nieświadomie wykonuje ukryte polecenia. Badacze z Tenable zademonstrowali również, jak ominąć mechanizmy bezpieczeństwa OpenAI przez manipulację linkami śledzącymi Bing oraz jak zapewnić trwałość ataku poprzez tzw. „Memory Injection” – technikę modyfikującą pamięć ChatGPT w celu stałego filtrowania danych.

Tenable poinformowało, iż chociaż OpenAI załatało część zgłoszonych problemów, atak typu prompt injection pozostaje fundamentalnym wyzwaniem dla modeli językowych. Odkrycia te potwierdzają, iż samo poleganie na zabezpieczeniach wbudowanych przez dostawców AI jest niewystarczające, zwłaszcza w kontekście zastosowań biznesowych. Incydent podkreśla konieczność wdrożenia w organizacjach dedykowanych strategii zarządzania ryzykiem związanym z AI, które zapewnią nadzór nad wykorzystaniem tych narzędzi i ochronę przed wyciekiem wrażliwych informacji firmowych. Dalsze badania nad bezpieczeństwem modeli językowych stają się najważniejsze w miarę ich integracji z krytycznymi procesami biznesowymi.