Nvidia znów podnosi poprzeczkę w wyścigu technologicznym. Ich najnowszy układ do obliczeń sztucznej inteligencji, Blackwell Ultra GB300, właśnie wszedł do masowej produkcji i wygląda na to, iż może na długo zdefiniować standardy w tej branży.To nie jest kolejna ewolucyjna aktualizacja, ale znaczący skok technologiczny. Firma postanowiła wykorzystać całe swoje doświadczenie, tworząc rozwiązanie, które trafi do największych graczy na rynku AI. Blackwell Ultra GB300 jest już w masowej produkcji i wszystko wskazuje na to, iż właśnie obserwujemy początek nowej ery w przetwarzaniu danych.

Ostatnie słowo architektury Blackwell

Przed przejściem na zupełnie nową architekturę Rubin, Nvidia postanowiła dać z siebie wszystko, ponieważ układ zawiera aż 208 miliardów tranzystorów, co stanowi 2,6 raza więcej niż poprzednia generacja Hopper. Produkcja odbywa się w procesie TSMC 4NP, czyli ulepszonej wersji technologii 5 nm zoptymalizowanej specjalnie pod kątem rozwiązań grupy zielonych.

Czytaj też: Intel i LG Innotek nawiązują współpracę. Sztuczna inteligencja ma zoptymalizować produkcję w inteligentnej fabryce

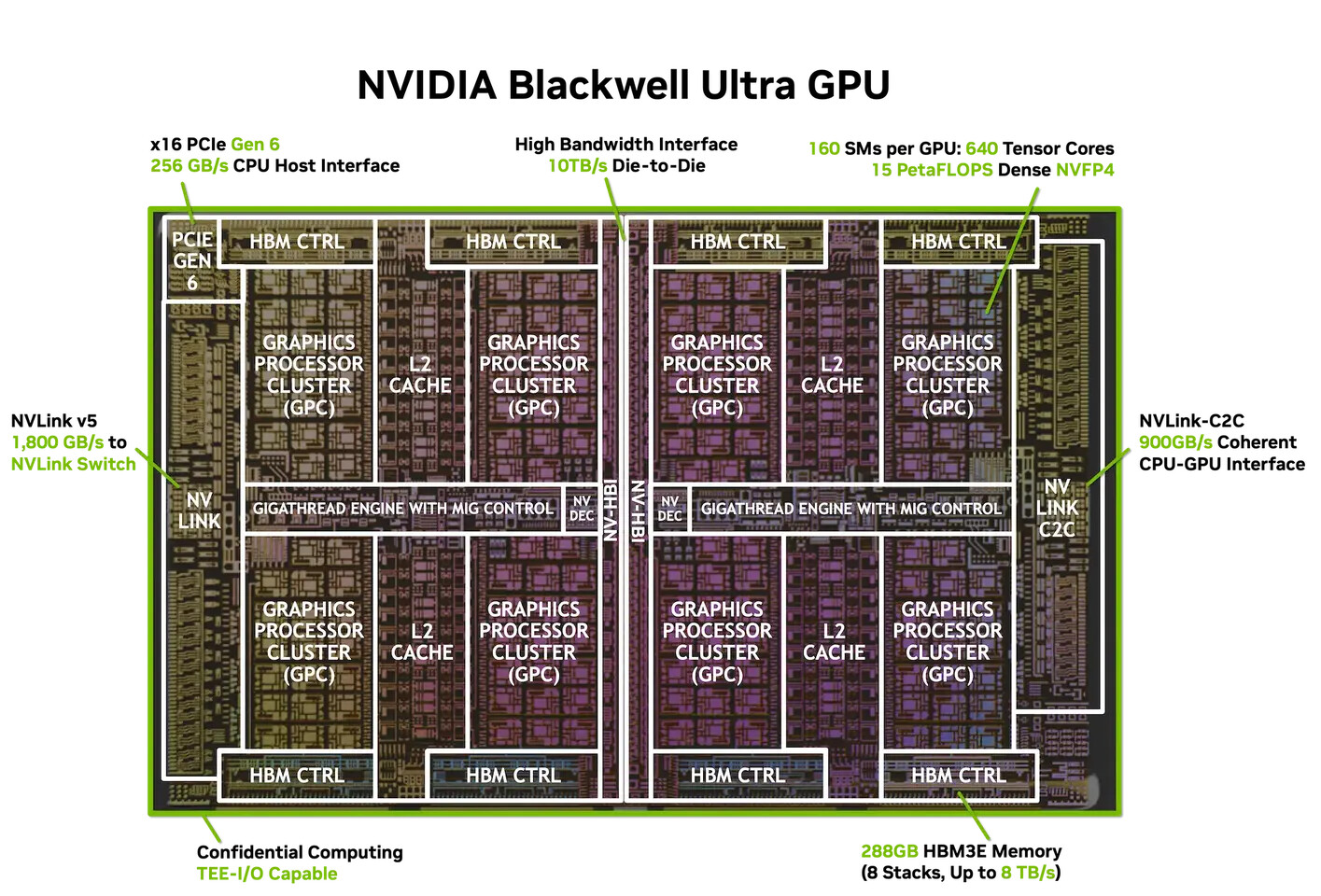

Najciekawszym aspektem jest konstrukcja Dual Reticle GPU, gdzie dwie połączone matryce działają jak jeden układ scalony. Komunikację między nimi zapewnia interfejs NV-HBI o imponującej przepustowości 10 TB/s. Po raz pierwszy w branży zastosowano standard PCIe Gen 6, podczas gdy inne rozwiązania wciąż korzystają z PCIe Gen 5.

Moc ma jednak swoją cenę, ponieważ układ wymaga aż 1400 W, co jest wartością porównywalną z poborem energii przez przeciętne gospodarstwo domowe przez kilka godzin. To rodzi pytania o opłacalność i ekologiczny aspekt takich rozwiązań. Blackwell Ultra GB300 zawiera 160 multiprocesorów strumieniowych, 20 480 rdzeni CUDA oraz 640 rdzeni Tensor 5. generacji obsługujących najnowsze formaty obliczeniowe FP8, FP6 i NVFP4.

Czytaj też: IBM i AMD nawiązują współpracę w celu stworzenia superkomputerów kwantowo-centrycznych

Dodatkowo układ dysponuje 288 GB pamięci HBM3E w ośmiu stosach, z magistralą 8192-bit i przepustowością do 8 TB/s. To 3,6 raza więcej pamięci niż Hopper H100 i o 50% więcej niż wcześniejsze układy Blackwell. Taka pojemność pamięci pozwala na uruchamianie modeli AI liczących setki miliardów parametrów bez konieczności korzystania z wolniejszej pamięci zewnętrznej. Wydajność układu w formacie FP8 wynosi 5 PFLOPS dla operacji gęstych i 10 PFLOPS dla rzadkich, a w nowszym formacie NVFP4 osiąga jeszcze lepsze wyniki: 15 PFLOPS dla operacji gęstych i 20 PFLOPS dla rzadkich.

Przepustowość jednostek SFU została podwojona, co znacząco przyspiesza obliczenia warstw uwagi w modelach Transformer. Łączność NVLink 5 zapewnia przepustowość 1,8 TB/s na GPU, a interfejs PCIe Gen6 x16 oferuje 256 GB/s. Układ jest wysoce skalowalny, ponieważ możliwe jest połączenie choćby 576 GPU w jednej topologii.

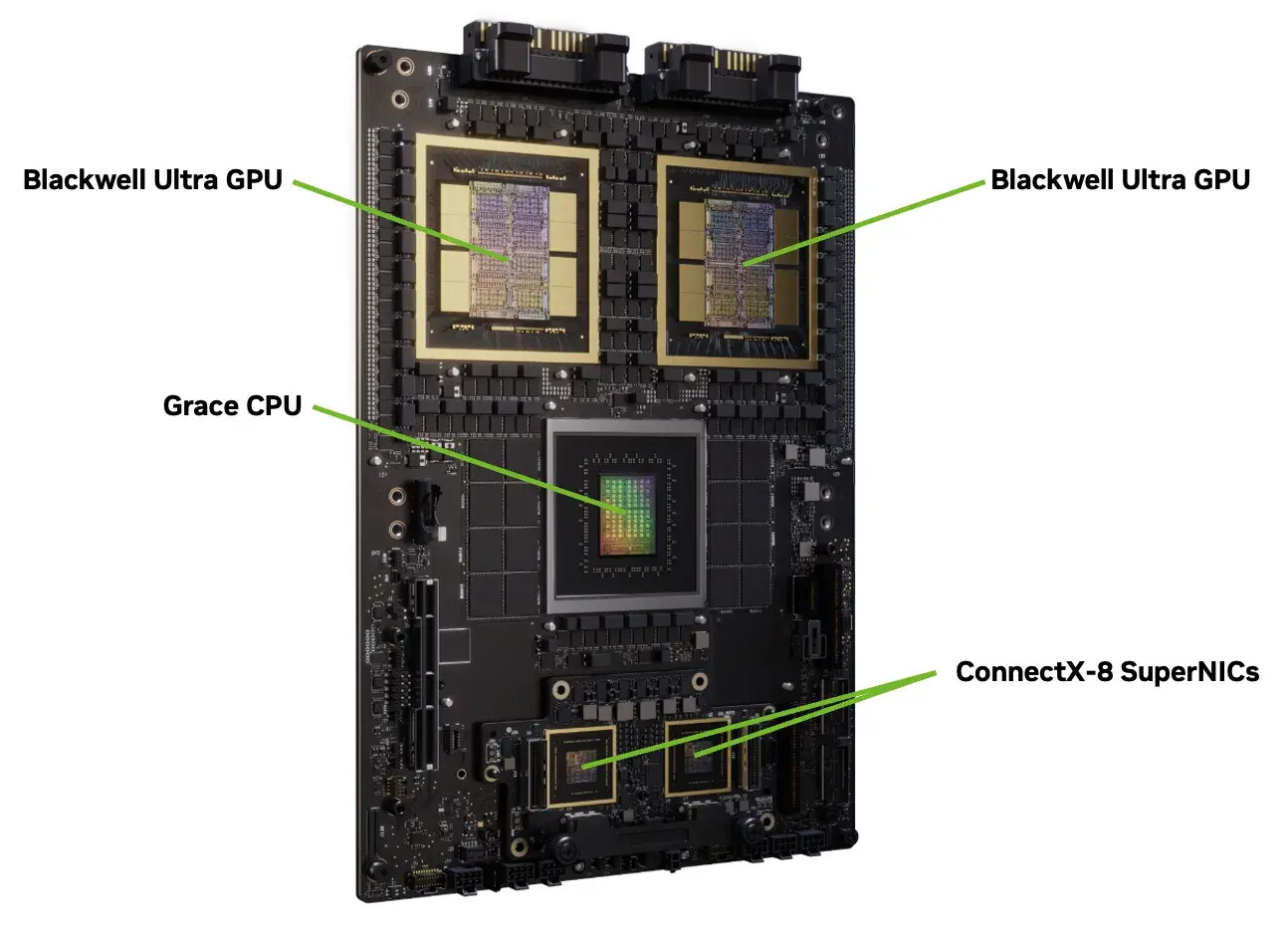

System Grace Blackwell Ultra Superchip łączy jeden procesor Grace z dwoma układami Blackwell Ultra, oferując do 30 PFLOPS mocy obliczeniowej dla operacji gęstych i 40 PFLOPS dla rzadkich plus 1 TB zunifikowanej pamięci. System GB300 NVL72 to chłodzone cieczą szafy z 36 superchipami osiągające łącznie 1,1 eksaflopsa mocy obliczeniowej FP4.

Czytaj też: Nowe wyzwania dla AI. Polski matematyk stworzył zadanie nie do rozwiązania

Dla przedsiębiorstw Nvidia przygotowała zaawansowane funkcje bezpieczeństwa i zarządzania. Partycjonowanie MIG pozwala dzielić GPU na niezależne instancje, podczas gdy Confidential Computing zapewnia sprzętową ochronę modeli AI z szyfrowaniem NVLink. System AI-driven RAS monitoruje tysiące parametrów i przewiduje potencjalne awarie.

Warto zauważyć, iż inwestycje grupy zielonych w infrastrukturę AI przekładają się na technologie konsumenckie. Dzięki takim układom jak Blackwell Ultra powstają rozwiązania pokroju DLSS czy RTX Video Super Resolution, które wykorzystują algorytmy sztucznej inteligencji do poprawy jakości obrazu i wydajności w grach.

Blackwell Ultra GB300 to nie tylko najwydajniejszy chip AI na świecie, ale także fundament dla kolejnej generacji technologii. Im potężniejsze układy otrzymują deweloperzy, tym szybciej zaawansowane funkcje AI trafią do kart graficznych GeForce i usług takich jak GeForce NOW. Pozostaje jednak pytanie o dostępność i koszty takich rozwiązań oraz ich realny wpływ na rozwój sztucznej inteligencji w najbliższych latach.