OpenAI postanowiło wejść na nowy poziom samowystarczalności. Firma, znana z rozwoju ChatGPT i modeli GPT, ogłosiła współpracę z Broadcomem w celu stworzenia niestandardowych akceleratorów AI. Według doniesień, obie firmy rozpoczęły już prace nad projektem, który ma zapewnić OpenAI dostęp do choćby 10 gigawatów mocy obliczeniowej w nadchodzących latach.

To liczba, która może brzmieć abstrakcyjnie, ale w praktyce oznacza ogromną infrastrukturę, zdolną do obsługi milionów zapytań na sekundę i trenowania modeli o niespotykanej dotąd skali. Pierwsze akceleratory mają trafić do centrów danych w 2026 roku, a pełna produkcja ruszy przed końcem dekady.

Co to zmienia?

Ruch ten nie jest przypadkowy. OpenAI od miesięcy boryka się z rosnącym zapotrzebowaniem na moc obliczeniową. Stworzenie własnych układów daje firmie szansę na dostosowanie sprzętu bezpośrednio do potrzeb jej modeli, co może przełożyć się na większą efektywność energetyczną i wydajność.

Dzięki współpracy z Broadcomem OpenAI nie musi wszystkiego robić od zera. Broadcom dostarczy nie tylko wsparcie produkcyjne, ale też swoje doświadczenie w zakresie projektowania układów, które można zoptymalizować pod konkretne zadania AI. To oznacza, iż akceleratory OpenAI mogą działać szybciej i zużywać mniej energii niż tradycyjne GPU, które muszą być bardziej uniwersalne.

OpenAI i Broadcom ogłaszają strategiczną współpracę / foto. Broadcom

OpenAI i Broadcom ogłaszają strategiczną współpracę / foto. BroadcomNowy gracz w walce o dominację w AI

Wielkie modele językowe, takie jak GPT-4 czy GPT-5, pochłaniają gigantyczne ilości energii i pamięci. Każda nowa generacja wymaga nie tylko mocniejszych serwerów, ale też lepszej optymalizacji na poziomie sprzętowym. Własny układ daje OpenAI pełną kontrolę nad tym procesem – od architektury po sposób chłodzenia i zużycie energii.

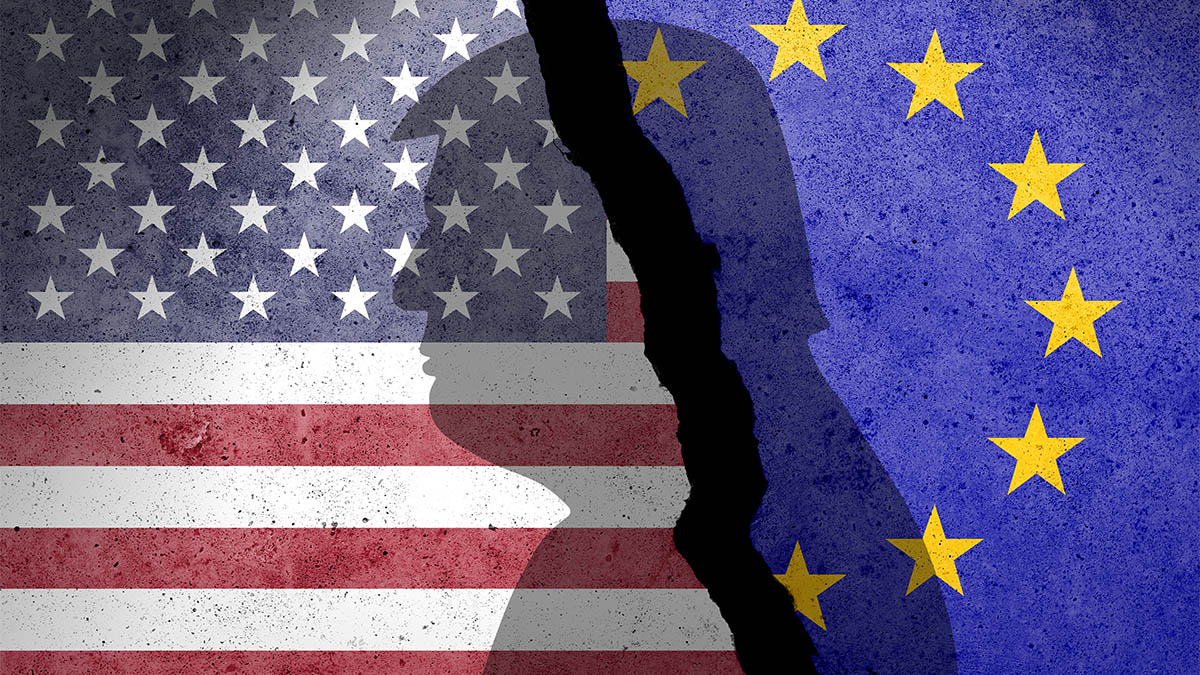

Choć Nvidii wciąż daleko do utraty dominacji, to taki ruch ze strony OpenAI może być początkiem większej zmiany. Analitycy wskazują, iż w dłuższej perspektywie na podobne rozwiązania zdecydują się też inni gracze – Google ma TPU, Amazon ma Trainium, a teraz OpenAI dołącza do wyścigu z własnym rozwiązaniem. Każda z tych firm chce nie tylko wydajności, ale też niezależności od jednego dostawcy, co w dzisiejszym świecie technologii jest na wagę złota.

Techniczny aspekt układów OpenAI

Nowe chipy, nad którymi pracuje OpenAI, będą prawdopodobnie bazować na architekturze ASIC, podobnie jak rozwiązania stosowane przez Google. Tego typu układy są tworzone od podstaw do konkretnych zadań – w tym przypadku do trenowania modeli językowych i generatywnych sieci neuronowych. Dzięki temu mogą działać choćby dwukrotnie szybciej i zużywać o połowę mniej energii niż klasyczne karty graficzne.

Nie bez znaczenia jest też fakt, iż OpenAI planuje pełną integrację swoich chipów z systemami chłodzenia cieczą i zasilaniem zoptymalizowanym pod obciążenia AI. Takie rozwiązania nie tylko zwiększają wydajność, ale też pozwalają ograniczyć koszty eksploatacyjne centrów danych.

Czy zwykły user to odczuje?

Dla przeciętnego użytkownika ChatGPT czy DALL-E zmiany nie będą odczuwalne natychmiast. Ale w dłuższej perspektywie może to oznaczać tańszy dostęp do usług AI, krótsze czasy odpowiedzi i bardziej zaawansowane możliwości modeli. Im bardziej wydajna infrastruktura, tym większe możliwości rozwoju sztucznej inteligencji w codziennych produktach, od asystentów głosowych, po aplikacje edukacyjne czy biznesowe.

W praktyce oznacza to, iż OpenAI staje się coraz mniej zależne od dostawców i może samodzielnie decydować o kierunku rozwoju swoich technologii. jeżeli projekt zakończy się sukcesem, Broadcom może stać się nowym filarem rynku AI, a Nvidia po raz pierwszy od lat poczuje realny oddech konkurencji na plecach.

Źródło: OpenAI