Ostatni egzamin ludzkości pokazuje, jak słabe są dziś najlepsze modele AI. Skrupulatnie przygotowany test obnaża granice wiedzy generatywnej sztucznej inteligencji.

„Ostatni egzamin ludzkości” to nazwa benchmarku – testu możliwości generatywnej sztucznej inteligencji – stworzonego przez organizację non-profit Center for AI Safety i firmę Scale AI. Egzamin powstał na fali premiery modelu 4o OpenAI, który ówcześnie osiągnął niemal 100 proc. we wszystkich benchmarkach. CAIS i Scale AI chcieli stworzyć test znacznie bardziej wymagający niż jakikolwiek dotychczas znany benchmark, sprawdzający wiedzę z każdej możliwej dziedziny w najdrobniejszych szczegółach.

Choć prace nad egzaminem rozpoczęły się pod koniec 2024 roku, to ich efekty opublikowano dopiero w minionym tygodniu w czasopiśmie Nature. I te są świetne. Albo tragiczne. Zależnie od punktu widzenia.

Ostatni egzamin ludzkości sprawdził AI na poziomie eksperckim

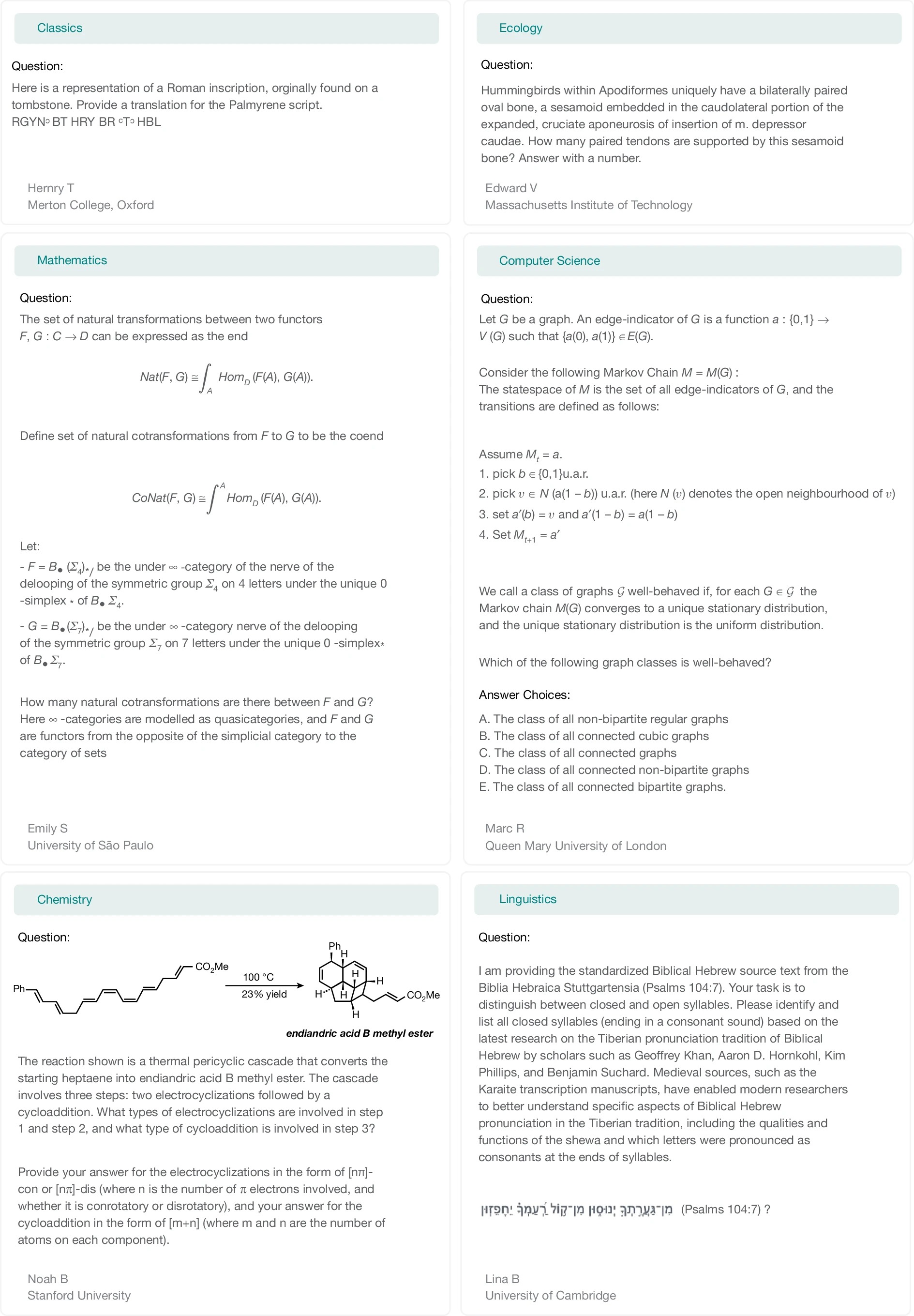

Bo jeżeli ktoś spodziewał się, iż najlepsze dziś modele AI poradzą sobie z nowym benchmarkiem choćby przyzwoicie, to musiał gwałtownie zrewidować oczekiwania. „Ostatni egzamin ludzkości” (Humanity’s Last Exam, HLE) składa się z 2500 pytań z ponad stu dziedzin – od matematyki i fizyki, przez biologię i chemię, po informatykę, nauki społeczne i humanistyczne. Pytania przygotowało niemal tysiąc ekspertów z ponad 50 krajów, a każde z nich było wcześniej sprawdzane na czołowych modelach. jeżeli którykolwiek system potrafił poprawnie odpowiedzieć, zadanie trafiało do kosza.

„Ostatni egzamin ludzkości” jest benchmarkiem multimodalnym – część pytań wymaga analizy zarówno tekstu, jak i obrazu. Około jednej czwartej to pytania wielokrotnego wyboru, reszta wymaga podania krótkiej, jednoznacznej odpowiedzi. Wśród zadań dominują matematyka (41 proc.), biologia/medycyna (11 proc.), informatyka/AI (10 proc.), fizyka (9 proc.) oraz przedmioty humanistyczne (9 proc.).

Przykładowe pytania zawarte w ostatnim egzaminie ludzkości

Przykładowe pytania zawarte w ostatnim egzaminie ludzkościW ten sposób skonstruowano HLE, który jest prawdziwym koszmarem dla AI. GPT-4o osiągnął zaledwie 2,7 proc. poprawnych odpowiedzi. Claude 3.5 Sonnet – 4,1 proc. Gemini 1.5 Pro – 4,6 proc. Najlepszy wynik wśród modeli testowanych w momencie tworzenia zestawu uzyskał model o1 od OpenAI – 8 proc. dokładności. To przepaść w porównaniu z ponad 90-procentowymi rezultatami, jakie te same systemy notują w popularnych testach pokroju MMLU.

Autorzy testu nie kryją, iż taki był cel. HLE ma mierzyć nie to, co AI już potrafi, ale to, czego jeszcze nie potrafi. Innymi słowy: wyznaczać granicę pomiędzy możliwościami dzisiejszych modeli językowych a poziomem eksperckiej wiedzy człowieka w zamkniętych, weryfikowalnych zadaniach akademickich.

Jeszcze bardziej niepokojący od niskiej skuteczności jest inny wniosek z badania: modele bardzo często są kompletnie źle skalibrowane. Innymi słowy, z dużą pewnością siebie podają błędne odpowiedzi. Wskaźniki błędu kalibracji dla większości systemów przekraczają 70 proc., co oznacza, iż AI nie tylko nie wie, ale też „nie wie, iż nie wie”.

Od czasu publicznego udostępnienia HLE na początku 2025 r. sytuacja zaczęła się jednak gwałtownie zmieniać. Nowsze modele, trenowane już z myślą o tym benchmarku, notują wyraźnie lepsze wyniki. GPT-5 osiąga około 25 proc. poprawnych odpowiedzi, a najnowszy Gemini 2.5 Pro – ponad 21 proc. To wciąż daleko od poziomu człowieka, ale trend jest jednoznaczny.

„Ostatni egzamin ludzkości” nie będzie „ostatni”

I właśnie tu pojawia się najważniejszy problem. Benchmarki, choćby tak ambitne jak „Ostatni egzamin ludzkości”, gwałtownie stają się celem samym w sobie. Firmy optymalizują modele pod wyniki w tabelkach, podobnie jak studenci „kują” pod egzamin. W przypadku ludzi taka nauka zwykle przekłada się na realne kompetencje. W przypadku AI – niekoniecznie.

Autorzy HLE podkreślają, iż choćby perfekcyjny wynik w tym teście nie oznaczałby, iż maszyna potrafi samodzielnie prowadzić badania naukowe, formułować nowe hipotezy czy rozumieć świat w ludzki sposób. Benchmark mierzy sprawność w rozwiązywaniu zamkniętych problemów, a nie inteligencję jako taką.

Dlatego „Ostatni egzamin ludzkości” jest jednocześnie sukcesem i ostrzeżeniem. Sukcesem, bo wreszcie powstał test, który prawdziwie odsiewa najlepsze modele, ale i pokazuje, jak daleko im jeszcze do eksperckiego poziomu. Ostrzeżeniem, bo historia AI pokazuje, iż choćby najtrudniejsze benchmarki prędzej czy później zostaną „rozgryzione”

Na razie jednak jedno jest pewne: najlepsze sztuczne inteligencje świata na „ostatnim egzaminie” masowo oblewają. I to właśnie ten fakt mówi o ich możliwościach więcej niż jakikolwiek marketingowy przekaz.

Więcej na temat sztucznej inteligencji:

- Chrome przestanie być przeglądarką. Google idzie na całość

- Jedną zapowiedzią zdeklasowali ChataGPT. Gdzieś musi być haczyk

- Gemini szalenie potaniało. ChatGPT właśnie przestał mi się opłacać