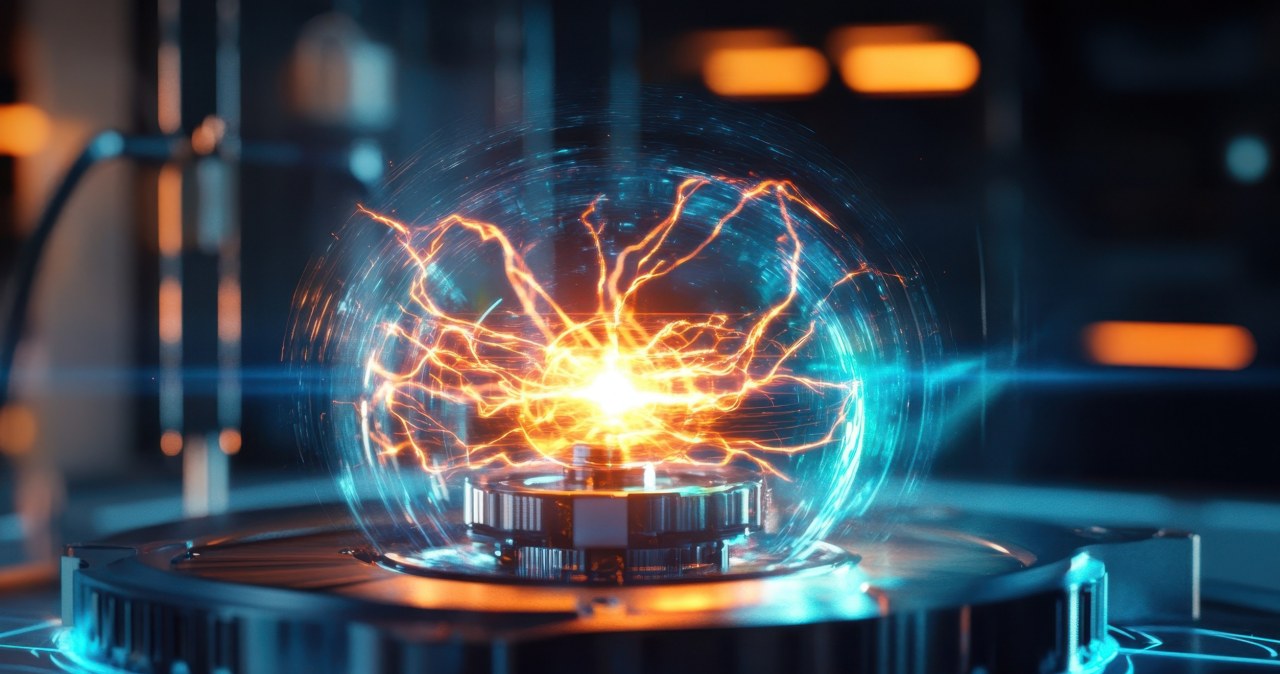

OpenAI znowu zadziwił świat, tym razem prezentując możliwości najnowszego modelu generującego wideo nazwanego Sora. Czy to symulator świata fizycznego – jak chciałaby firma, która go stworzyła? A może „tylko” narzędzie wideo dla twórców i zabawka dla masowego użytkownika? I to na dodatek niebezpieczna w niewłaściwych rękach?

Sora to tak zwany model dyfuzyjny, a więc model generatywnej sztucznej inteligencji, który wytwarza obraz z „szumu” w kolejnych iteracjach, aż osiągnie adekwatny efekt (wyobraź sobie obraz na telewizorze w przypadku częstotliwości, na której nie ma żadnego kanału).

O tym, iż wideo można stworzyć nie tylko przy pomocy modelu dyfuzyjnego, ale również przy pomocy LLM-u, pisaliśmy w artykule o VideoPoet, modelu od Google’a.

Modele takie są powszechnie stosowane do generowania obrazów i wideo, jednak OpenAI wyniósł tę technikę na wyższy poziom przy użyciu potężnej architektury transformerów (a więc architektury, z której korzystają duże modele językowe, LLM-y).

Efekt? Możliwe stało się stworzenie spójnego wideo w wysokiej rozdzielczości o długości do minuty, czyli kilka-kilkanaście razy dłuższego od obecnych na rynku modeli.

Symulator świata fizycznego? Jeszcze nie…

OpenAI twierdzi, iż głównym celem stworzenia tego modelu było stworzenie fundamentów symulacji świata fizycznego.

„Sora to fundament dla modeli, które mogą zrozumieć i symulować świat fizyczny, co jest umiejętnością, która, jak wierzymy, będzie ważnym kamieniem milowym w osiągnięciu ogólnej sztucznej inteligencji (AGI)” – napisała firma na swojej stronie internetowej.

W to, iż celem OpenAI jest osiągnięcie AGI, nie powinniśmy specjalnie wątpić – to zdecydowanie obsesja tej firmy. Jak jednak Sora radzi sobie ze światem fizycznym? Sądząc po udostępnianych klipach – ciągle tak sobie.

Na pewne aspekty związane z brakiem zrozumienia świata przez model wskazuje sama firma. Model czasami tworzy mało prawdopodobne ruchy ludzkie, postacie mogą pojawiać się i znikać, zwłaszcza w scenach z wieloma osobami. Obiekty mogą przenikać przez inne obiekty, przedmioty z natury sztywne – zmieniać kształty. Również pewne sekwencje nie zachowują logiki świata: osoba gryzie ciastko, które po ugryzieniu pozostaje nietknięte lub kobieta dmucha na palące się świeczki na torcie – i nic się nie dzieje, świecą się jak poprzednio.

Ja dostrzegam jeszcze co najmniej jedną wadę modelu, mianowicie problem z trzecim wymiarem przestrzennym – głębią. O ile model dobrze radzi sobie z perspektywą, również przy poruszającej się „kamerze”, o tyle ma istotne problemy z fizycznymi konsekwencjami rozmieszczenia przedmiotów. Najlepiej to, być może, widać na poniższym wideo wytworzonym przez Sorę:

Cienie i zmiana perspektywy wyraźnie pokazują, iż okiennice dość mocno wystają poza parapet. Przy próbie przejścia do drugiego okna dalmatyńczyk po prostu by spadł. Tego model – było nie było, uczony na treściach z dwuwymiarowym komponentem przestrzennym – po prostu nie rozumie. Bez wbudowania w model pojęcia głębi – bardziej fundamentalnego niż sama perspektywa – zbudowanie na podstawie Sory symulator świata fizycznego nie będzie prawdopodobnie możliwe.

Narzędzie wideo dla twórców? Jasne, iż tak

Możliwości Sory w procesach twórczych na pewno są trudne do przecenienia. Od prototypowania (bo można prototypować jednym zdaniem – w końcu obraz można generować z tekstu), przez wypełnianie dziur w materiale (model też to potrafi), po wytwarzanie wideo z obrazka. Wszystkie te możliwości oferuje Sora.

Doskonała jest do krótkich klipów reklamowych (po kilkadziesiąt sekund). Jednak Sorę można też wykorzystać do dłuższych form filmowych – jest w stanie wykorzystać kontekst stworzonego uprzednio wideo, by stworzyć spójną kontynuację na istotnie więcej niż jedna minuta. Tu oczywiście też w drogę będą wchodzić artefakty – niespójności wytworzonego obrazu – ale są to pewnie przeszkody do pokonania.

Takie drobne artefakty widać choćby na pierwszym wideo zaprezentowanym przez OpenAI w swoim komunikacie o powstaniu Sory:

Jak być może zauważyliście, spacerująca po ulicach Tokio kobieta w dwóch momentach „zacina się” w swoim kroku, a pod koniec wideo zaczyna się „ślizgać” – przemieszcza się, niemal nie poruszając nogami.

Nawet z tymi lekkimi wadami Sora będzie na pewno użyteczna dla artystów. Nic dziwnego zatem, iż zostanie udostępniona do testowania grupie artystów wizualnych, projektantów i filmowców.

Świetna zabawka. Tylko nie dawajcie jej niebezpiecznym ludziom

Sora, jeżeli stanie się powszechnie dostępna, będzie niewątpliwie świetną zabawką dla większości z nas. Ja osobiście bardzo lubię stworzyć jakiś obrazek w Dall-E 3, a zabawa z wideo pewnie będzie jeszcze lepsza.

Oczywiście znajdą się niestety tacy, którzy taką zabawką będą „źle się bawić.” Sora to świetne narzędzie do manipulacji, deepfake’ów i oszustw. Dla przestępców i państw o złych intencjach.

Wszystko wskazuje na to, iż OpenAI jest tego świadome. Model, jak wspomniałem, udostępniono grupie twórców, ale nikomu więcej. w tej chwili będzie on przedmiotem testowania przez specjalny zespół, który oceni nową technologię pod kątem ryzyk.

Firma buduje system wykrywający, czy dane wideo było wytworzone przez Sorę. I będzie dodawać do pliku wideo metadane C2PA (umożliwiające identyfikację sztucznie wytworzonych treści). OpenAI planuje zbudować detektor niedozwolonych zapytań tekstowych, a choćby detektory treści zabronionych w klatkach powstałego filmu.

Czy to wystarczy, by zapobiec nadużyciom? Czas pokaże, ale nie jestem optymistą.

Dowiedz się, kiedy można wykorzystywać obrazy stworzone dzięki GenAI? Jakie są licencje? Sprawdzamy na przykładzie 5 aplikacji!

Źródło grafiki: Kadr z wideo wygenerowanego przez Sorę. OpenAI.