I. Wstęp

Sztuczna inteligencja (AI) stanowi w tej chwili narzędzie o niespotykanych wcześniej możliwościach (1), które może być wykorzystane do różnorodnych celów, w tym także do manipulacji opinią publiczną w czasie wyborów. W kontekście procesu wyborczego, działania takie podejmowane dzięki sztucznej inteligencji mogą prowadzić do szeregu negatywnych skutków, w tym wpływania na podejmowanie decyzji wyborczych.

Jednym z największych zagrożeń, jakie stoją przed naszym społeczeństwem, jest wykorzystanie sztucznej inteligencji do celów nieetycznych, w tym manipulacji wyborczej. Takie zachowania mogą prowadzić do osłabienia zaufania społecznego do instytucji publicznych, ograniczania wolności słowa, rozprzestrzeniania dezinformacji i pogłębiania podziałów społecznych.

Szczególną uwagę trzeba zwrócić na manipulację społeczną, która prowadzona dzięki sztucznej inteligencji może okazać się szczególnie niebezpieczna w kontekście nadchodzących wyborów, z uwagi na trudność jej wykrycia i kontrolowania (2). Istniejące ramy prawne i zabezpieczenia są często niewystarczające, a rozwój technologii AI i algorytmów uczenia maszynowego tylko pogłębia istniejący problem.

W związku z tym, iż przedmiotowa technologia może być wykorzystywana w celu wpływania na proces wyborczy, zasadnym wydaje się podjęcie działań na poziomie krajowym i międzynarodowym w celu wypracowania rozwiązań skutkujących wzmocnieniem istniejących regulacji i wprowadzenia działań ochronnych. Dynamiczny rozwój technologii determinować powinien również prowadzenie ciągłych badań nad jej rozwojem, obejmujących m.in. analizę ryzyka możliwości występowania zjawisk przestępnych wykorzystujących AI.

Uważamy, iż negatywne skutki manipulacji wyborczej dzięki sztucznej inteligencji mogą doprowadzić do osłabienia demokratycznych wartości i zaufania społecznego, w skrajnych przypadkach prowadząc do kryzysu politycznego. Dzięki rosnącej ilości dostępnych danych i możliwościom analizy oraz interpretacji danych przez AI, algorytmy mogą być wykorzystane do kierowania zachowaniami wyborców, zwłaszcza tych, którzy są wrażliwi na określone kwestie. Zagrożenie to jest szczególnie istotne w kontekście konfliktu międzynarodowego, z którym w obecnych czasach się mierzymy, a skutki naszych decyzji w kontekście nadchodzących wyborów mogą bezpośrednio wpłynąć na przyszłość narodu i państwa polskiego. Dlatego też, istotnym jest, aby odpowiednie instytucje podejmowały w tym kierunku działania, celem ochrony procesu wyborczego przed bezprawnym wpływem na jego wynik.

Warto również zaznaczyć, iż jednocześnie sztuczna inteligencja może mieć pozytywny wpływ na omawiany proces (3). Technologia może umożliwiać szybsze i dokładniejsze przetwarzanie danych, identyfikowanie problemów i trendów, a także zwiększanie przejrzystości i uczciwości wyborów.

Mając na uwadze powyższe, koniecznym jest podjęcie działań mających na celu zapewnienie uczciwości procesu wyborczego, a także jego ochronę przed manipulacją i dezinformacją. Wymaga to współpracy międzynarodowej, budowania zaufania społecznego i odpowiedniego regulowania wykorzystania sztucznej inteligencji w kontekście politycznym (4). Tylko w ten sposób możemy zagwarantować, iż proces wyborczy będzie przebiegał uczciwie i zgodnie z demokratycznymi wartościami.

W niniejszym artykule podjęliśmy się zadania wyszczególnienia oraz opisania poszczególnych zagrożeń związanych z rozwojem AI w kontekście jej przestępnego wykorzystania w celu wpływania na proces wyborczy. Co istotne, w związku z obecną sytuacją geopolityczną, toczącą się za naszą wschodnią granicą wojną oraz niepowodzeniami wojsk rosyjskich na froncie, a także silnym poparciem społecznym dla walczącej Ukrainy w Polsce, opisane zagrożenia stają się coraz bardziej realne (5).

II. Definicja sztucznej inteligencji

Sztuczna inteligencja to dziedzina nauki, która zajmuje się projektowaniem i tworzeniem programów i systemów komputerowych, które są zdolne do wykonywania zadań, które normalnie wymagają inteligencji ludzkiej, takich jak rozpoznawanie obrazów, rozumienie mowy i języka naturalnego, przetwarzanie tekstu, planowanie, podejmowanie decyzji, a także uczenie się na podstawie doświadczeń. Według Alan Turinga (6), pioniera badań nad sztuczną inteligencją, sztuczna inteligencja jest "symulacją myślenia przez maszynę".

AI znajduje zastosowanie w wielu dziedzinach, takich jak przetwarzanie języka naturalnego, przetwarzanie obrazów i dźwięku, systemy ekspertowe, robotyka, medycyna, finanse, marketing, a także gry komputerowe. Współczesne definicje sztucznej inteligencji są przez cały czas przedmiotem debaty i nie ma jednolitej definicji, która byłaby akceptowana przez wszystkich badaczy. Niemniej jednak, można wskazać jej kilka charakterystycznych cech.

Według Johna McCarthy'ego, jednego z pionierów sztucznej inteligencji, sztuczna inteligencja to "nauka i inżynieria tworzenia inteligentnych maszyn, w szczególności programów komputerowych (7)."

Z kolei według Yoshuy Bengio, jednego z czołowych specjalistów w dziedzinie uczenia maszynowego, sztuczna inteligencja to dziedzina, która zajmuje się budowaniem maszyn, które potrafią uczyć się i działać na podstawie swojego doświadczenia (8).

Mimo różnic w definicjach, wszystkie wskazują na to, iż sztuczna inteligencja to dziedzina nauki, która zajmuje się projektowaniem, tworzeniem programów i systemów komputerowych, które są zdolne do wykonywania zadań, które normalnie wymagają ludzkiej inteligencji. Jednak ze względu na mnogość technologii i dziedzin nauki, które są związane z AI, ogólne zdefiniowanie tej dziedziny jest trudne i wymaga dalszych prac badawczych.

III. Wykorzystanie AI do celów przestępnych, przykłady możliwych ataków

W dzisiejszych czasach media społecznościowe odgrywają kluczową rolę w przekazywaniu informacji. Oferują do niej szybki i łatwy dostęp, a także umożliwiają interakcję między użytkownikami, m.in. w celu wymiany doświadczeń. Warto dodać, iż stanowią dla znaczącej części społeczeństwa pierwsze źródło informacji, które wielokrotnie nie jest przez nich weryfikowane pod kątem prawdziwości (9).

Przykładem negatywnej roli mediów społecznościowych w procesie wyborczym może być referendum w sprawie Brexitu. W trakcie prowadzonej kampanii w Wielkiej Brytanii w 2016 roku, media społecznościowe były wykorzystywane do szerzenia dezinformacji i manipulowania opinią publiczną. W jej trakcie doszło do wykorzystania nielegalnych metod wpływania na opinię publiczną celem przekonania społeczeństwa do opowiedzenia się za wyjściem Wielkiej Brytanii z Unii Europejskiej. Wykorzystywane były narzędzia w postaci farm trolli i botów, ukierunkowanych głównie na szerzenie dezinformacji (10).

Ta negatywna rola mediów społecznościowych, jaką odegrały w procesie Brexitu podkreśla potrzebę zwiększenia świadomości na temat zagrożeń związanych z dezinformacją i manipulacją. Zwłaszcza teraz, w dobie ich rosnącej roli życiu społecznym oraz niesamowitym rozwoju technologii sztucznej inteligencji mogą być wykorzystywane w celu wpływania na życie polityczne w danym kraju. W kontekście wyborów, niektóre zastosowania AI mogą prowadzić do poważnych zagrożeń dla demokracji, takich jak manipulowanie ich wynikami, szerzenie dezinformacji, czy fałszowanie materiałów wyborczych. W niniejszym punkcie przedstawimy trzy potencjalne scenariusze ataków, których prawdopodobieństwo wystąpienia jest wysokie.

1.Manipulacja algorytmami mediów społecznościowych

Manipulacja algorytmami mediów społecznościowych (11) może przyjmować wiele różnych form i być wykorzystywana przez różne podmioty w celu osiągnięcia różnych celów, w tym politycznych. Oto kilka przykładów, w których AI może odgrywać kluczową rolę w tym kontekście:

a) Tworzenie trendów (12) – Sztuczna inteligencja może być używana do analizowania danych z mediów społecznościowych w celu identyfikacji tematów, które mają największe szanse na "zatrendowanie". Następnie, może tworzyć treści, które są specjalnie dostosowane do tych tematów, a także kontrolować fałszywe konta i boty, które masowo udostępniają przedmiotowe treści, w efekcie kreując fałszywe trendy. W rezultacie, takie działania mogą wpłynąć na opinię publiczną, kierując uwagę społeczeństwa na wybrane tematy, które służą interesom osób/podmiotów odpowiedzialnych za manipulacje.

b) Analiza danych demograficznych – Sztuczna inteligencja może być używana do analizowania danych demograficznych i preferencji politycznych różnych grup społecznych. Na jej podstawie jest w stanie tworzyć spersonalizowane treści, które skierowane mogą być następnie kierowane do konkretnych grup wyborców. W kolejnym etapie, mogą być promowane dzięki mediów społecznościowych, co pozwala na skierowanie przekazu politycznego do najbardziej podatnych na niego grup społecznych, a tym samym zwiększenie ich zaangażowania w kampanie wyborcze.

c) Wpływanie na algorytmy rekomendacji (13) – Sztuczna inteligencja może być również używana do manipulowania algorytmami rekomendacji, które sterują tym, jakie treści są promowane w mediach społecznościowych. Przykładowo, AI może analizować, jakie typy treści mają największe szanse na rekomendację przez algorytmy serwisów takich jak Facebook, czy Twitter. W oparciu o powyższe dane technologia może generować treści o podobnych cechach, które są pożądane w określonych przekazach politycznych. W rezultacie, mają większe szanse na dotarcie do szerokiej grupy odbiorców, co może prowadzić do zmanipulowania ich poglądów.

d) Kształtowanie opinii publicznej – Technologia AI może również być używana do monitorowania przestrzeni publicznej w celu zbierania informacji na temat konkretnych kandydatów, czy tematów politycznych. Na podstawie zebranych danych, może generować strategie komunikacyjne, które mają na celu wpłynąć na społeczeństwo w sposób korzystny dla określonego kandydata, czy grupy politycznej. Strategie mogą polegać na generowaniu i promowaniu treści, które mają na celu podważenie wiarygodności przeciwników politycznych, podkreślanie pozytywnych aspektów własnych kandydatów, czy promowanie kontrowersyjnych tematów, odwracających uwagę od kluczowych problemów. Opisane działania mogą prowadzić do zniekształcenia debaty publicznej i wpłynąć na wyniki wyborów.

e) Tworzenie baniek informacyjnych (14) – Sztuczna inteligencja może być wykorzystana do umacniania istniejących baniek informacyjnych poprzez analizowanie danych z mediów społecznościowych w celu identyfikacji osób o określonych poglądach politycznych. Następnie, AI może generować i promować treści, które potwierdzają przekonania tych osób, jednocześnie ograniczając dostęp do informacji, które mogą prowadzić do zmiany ich poglądów. Powyższe może prowadzić do wzrostu polaryzacji politycznej i utrudnienia dialogu między przedstawicielami różnych opcji politycznych.

f) Zwiększanie liczby interakcji (15) – technologia AI może być używana do sterowania botami, które generują sztuczne interakcje, takie jak „lajki”, komentarze czy udostępnienia, w celu zwiększenia popularności określonych treści politycznych. Takie działania mogą wpłynąć na algorytmy rekomendacji mediów społecznościowych, prowadząc do jeszcze większego rozprzestrzeniania promowanych przez siebie treści wśród użytkowników. W następstwie powyższego, manipulacja algorytmami mediów społecznościowych może prowadzić do zniekształcenia postrzegania rzeczywistości przez społeczeństwo i mieć bezpośredni wpływ na proces wyborczy.

Manipulacja algorytmami mediów społecznościowych przy użyciu sztucznej inteligencji może przyjmować różne formy i mieć poważne konsekwencje dla procesu wyborczego oraz demokratycznych instytucji. W związku z tym, niezwykle ważne jest zwrócenie uwagi na takie zagrożenia i podjęcie odpowiednich działań, które pozwolą na ochronę procesu wyborczego przed wpływem szkodliwych działań.

2. Szerzenie dezinformacji dzięki botów i fałszywych kont

Sztuczna inteligencja może również odgrywać istotną rolę w szerzeniu dezinformacji (16) dzięki botów i fałszywych kont w mediach społecznościowych(17). Oto kilka przykładów, w których AI może być wykorzystywana w celu wpływania na wyniki wyborów:

1) Generowanie fałszywych wiadomości (18) – Sztuczna inteligencja może być używana do generowania fałszywych wiadomości, które mają na celu wprowadzenie dezinformacji na temat kandydatów, partii politycznych lub wydarzeń związanych z wyborami. Dzięki zaawansowanym technikom generowania tekstu, takim jak GPT-3, algorytm może tworzyć wiarygodnie wyglądające treści, które mogą być trudne do odróżnienia od prawdziwych informacji. Takie fałszywe wiadomości mogą następnie być gwałtownie rozpowszechniane dzięki botów i fałszywych kont, co może prowadzić do zmiany postrzegania rzeczywistości przez wyborców.

2) Wzmocnienie polaryzacji społecznej – AI może być używana do identyfikowania użytkowników mediów społecznościowych o określonych przekonaniach politycznych, a następnie generowania i promowania treści, które mają na celu wzmocnienie tych przekonań. Działania takie mogą się przyczynić do zwiększenia polaryzacji politycznej w społeczeństwie, co może wpłynąć na wyniki wyborów.

3) Kreowanie fałszywych tożsamości – omawiana technologia może być używana do generowania fałszywych tożsamości i kont w mediach społecznościowych. Dzięki zaawansowanym technikom generowania obrazów, takim jak StyleGAN (19), AI może tworzyć realistyczne zdjęcia profilowe, które są trudne do odróżnienia od prawdziwych. Takie fałszywe konta mogą być następnie wykorzystywane do szerzenia dezinformacji, manipulowania opinią publiczną, czy wprowadzania zamętu w debacie politycznej.

4) Automatyzacja trollingu (20) – AI może być wykorzystywana do automatyzacji trollingu (21)

w mediach społecznościowych, czyli celowego wprowadzania zamętu, szerzenia negatywnych emocji oraz prowokowania konfliktów między użytkownikami. Algorytm może analizować dane, aby identyfikować osoby o określonych przekonaniach politycznych, a następnie generować i publikować treści, które mają na celu wzbudzenie negatywnych emocji.

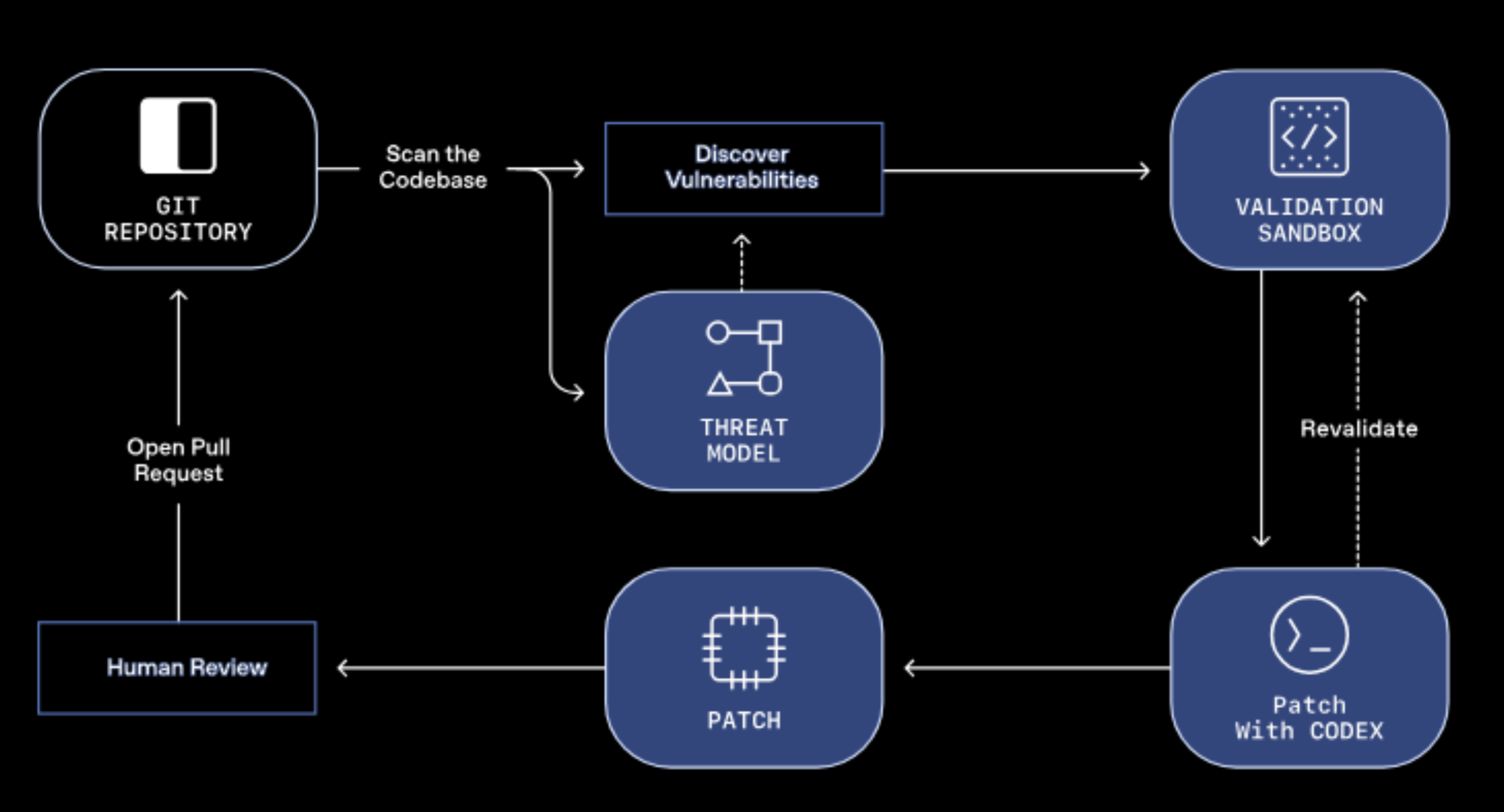

5) Inżynieria społeczna i phishing (22) – Sztuczna inteligencja może być wykorzystywana do przeprowadzania skomplikowanych ataków inżynierii społecznej i phishingu, które mają na celu wyłudzenie poufnych informacji lub wprowadzenie użytkowników w błąd. Może analizować dane z mediów społecznościowych, aby identyfikować potencjalne ofiary, a następnie generować wiarygodne, spersonalizowane treści mające na celu zdobycie dostępu do kont, haseł lub innych poufnych informacji. Powyższe działania mogą prowadzić do uzyskania przez przestępców dostępu do ważnych danych wyborczych lub wprowadzenia dezinformacji w celu manipulowania procesem wyborczym lub jego wynikami.

6) Mikrotargetowanie – Sztuczna inteligencja może być wykorzystywana tworzenia precyzyjnych kampanii informacyjnych lub dezinformacyjnych do konkretnych grup odbiorców. Dzięki analizie danych z otwartych źródeł informacji, może identyfikować preferencje polityczne, zainteresowania czy choćby lęki poszczególnych użytkowników,

a następnie generować i promować treści, które są dostosowane do ich profilu.

Podsumowując, sztuczna inteligencja może odgrywać istotną rolę w szerzeniu dezinformacji (23) dzięki botów i fałszywych kont w mediach społecznościowych, wpływając na wyniki wyborów na różne sposoby. W związku z tym, istnieje potrzeba zwrócenia uwagi na takie zagrożenia i podjęcie odpowiednich działań, które pozwolą na ochronę procesu wyborczego przed ich negatywnym wpływem.

3.Wykorzystanie deepfake (24) w kampaniach wyborczych

Deepfake (25) to rodzaj sztucznej inteligencji, która umożliwia tworzenie realistycznych filmów, w których twarze i głosy osób są zmanipulowane w taki sposób, iż wyglądają na kogoś innego. Sztuczna inteligencja może być wykorzystywana do tworzenia nagrań z politykami, które mogą wprowadzać dezinformację, manipulować wyborcami i wpłynąć na wyniki wyborów. Oto kilka przykładów, w jakich ta technologia może być wykorzystywana (26) w kampaniach wyborczych:

1) Wystąpienia publiczne – omawiana technologia może być wykorzystywana do tworzenia fałszywych wystąpień publicznych polityków, w których wygłaszają oni nieprawdziwe, manipulacyjne lub kontrowersyjne wypowiedzi. Takie deepfake'i mogą następnie być udostępniane w mediach społecznościowych lub innych kanałach informacyjnych, wprowadzając dezinformację wśród wyborców i wpływając na ich decyzje wyborcze.

2) Reklamy – Deepfake może być wykorzystywany do tworzenia fałszywych reklam wyborczych, które mają na celu wprowadzenie dezinformacji na temat kandydatów, partii politycznych lub wydarzeń związanych z wyborami. Dzięki zaawansowanym technikom generowania obrazów i dźwięków, AI może tworzyć wiarygodnie wyglądające treści, które są trudne do odróżnienia od ich prawdziwych odpowiedników. Przedmiotowe reklamy mogą następnie być gwałtownie rozpowszechniane w mediach społecznościowych i wprowadzać dezinformację wśród wyborców.

3) Manipulacja wizerunkiem – Deepfake może być wykorzystywany do manipulowania wizerunkiem polityków, np. poprzez tworzenie realistycznie wyglądających negatywnych zachowań lub wypowiedzi, które wprowadzają dezinformację na temat ich postaw czy decyzji. Takie obrazy mogą następnie być udostępniane w sieci, wpływając na decyzje wyborcze i wyniki wyborów.

4) Podważanie wiarygodności mediów – Deepfake może być również wykorzystywany do podważania wiarygodności mediów poprzez tworzenie fałszywych filmów, które wyglądają na oryginalne, natomiast zawierają nieprawdziwe informacje lub manipulacje. Następnie, mogą być udostępniane w sieci jako informacje prawdziwe, co prowadzi do dezinformacji.

5) Ataki na przeciwników politycznych – Deepfake może być wykorzystywany do atakowania przeciwników politycznych, np. poprzez tworzenie fałszywych filmów, które wyglądają na to, iż popełnili oni jakieś przestępstwo. Działania takie mają na celu wprowadzenie dezinformacji na temat przeciwników politycznych, zwiększenie polaryzacji społecznej i wpływanie na wyniki wyborów.

Warto tutaj przywołać zdarzenia z 2018 r., kiedy to w sieci opublikowano deepfake’a przedstawiającego prezydenta Gabonu (27), Ali Bongo wygłaszającego przemówienie zawierające kontrowersyjne treści. Materiał został wykorzystany przez opozycję jako dowód na to, iż prezydent jest pod wpływem podmiotów zagranicznych. W rezultacie, doszło do destabilizacji sytuacji politycznej w kraju i protestów społecznych.

Podsumowując, deepfake może być wykorzystywany w kampaniach wyborczych w celu wprowadzenia dezinformacji i manipulacji zachowaniami wyborców. Tworzenie wystąpień publicznych i reklam, manipulowanie wizerunkiem, podważanie wiarygodności mediów oraz ataki na przeciwników politycznych to tylko niektóre z przykładów, w jakie sposób deepfake może być wykorzystywany. W związku z tym, istnieje realna potrzeba zwrócenia uwagi na takie zagrożenia i podjęcie odpowiednich działań, które pozwolą na ochronę procesu wyborczego przed ich szkodliwym wpływem (28,29).

IV. Geopolityczne ryzyko Polski

W obecnej sytuacji międzynarodowej, w której Polska jako członek Sojuszu Północnoatlantyckiego i państwo aktywnie wspierające Ukrainę w konflikcie zbrojnym z Rosją, istnieje uzasadnione ryzyko (30), iż staniemy się celem ukierunkowanych ataków wykorzystujących sztuczną inteligencję w celu osłabienia polskiej pozycji międzynarodowej lub destabilizacji sytuacji wewnętrznej.

Jednym z realnych scenariuszy ataku na Polskę może być próba wprowadzenia dezinformacji dzięki botów i fałszywych kont w mediach społecznościowych. Atakujący mogliby wykorzystać sztuczną inteligencję, aby stworzyć wiarygodne profile oraz boty, które w sposób masowy rozprzestrzenią fałszywe informacje mające na celu wpłynięcie na opinię publiczną i zmianę wyników wyborów. W przypadku wykorzystania deepfake, ataki mogą być ukierunkowane na kandydatów lub ich sztaby wyborcze, w celu wprowadzenia zamieszania lub skompromitowania ich wizerunku.

V. Podsumowanie

Wobec powyższych zagrożeń, ważne jest, aby osoby odpowiedzialne za bezpieczeństwo procesu wyborczego były świadome zagrożeń związanych z wykorzystaniem sztucznej inteligencji i podejmowały odpowiednie środki zapobiegawcze.

Koniecznym jest edukowanie społeczeństwa na temat zagrożeń związanych z dezinformacją oraz sposobów, w jaki można się przed nią bronić. Należy zachęcać do krytycznego myślenia i weryfikacji źródeł informacji przed ich udostępnieniem lub przekazywaniem dalej.

W Polsce działa wiele instytucji odpowiedzialnych za „informacyjne i cyfrowe” bezpieczeństwo państwa, w tym Ministerstwo Obrony Narodowej, Agencja Bezpieczeństwa Wewnętrznego, Biuro Bezpieczeństwa Narodowego oraz Narodowe Centrum Bezpieczeństwa Cyberprzestrzeni. Ich zadaniem jest monitorowanie sytuacji i zapewnienie bezpieczeństwa państwu oraz społeczeństwu. Jednakże, wobec dynamicznie zmieniającej się sytuacji międzynarodowej i szybkiego rozwoju technologii, ważne jest ciągłe doskonalenie i aktualizacja systemów wykrywających zjawiska przestępne wykorzystujące AI oraz ścisła kooperacja między instytucjami odpowiedzialnymi za bezpieczeństwo państwa.

W świetle zagrożeń wynikających z rozwoju sztucznej inteligencji, niezbędne jest również ustanowienie przepisów prawnych, które umożliwią skuteczne reagowanie na opisane wyżej ataki wykorzystujące tę technologię. W tym celu koniecznym jest również stałe monitorowanie i aktualizacja obowiązujących przepisów prawa oraz stosowanie sankcji karnych wobec osób lub instytucji, które dopuszczają się opisywanych w niniejszym artykule działań. Wszystkie inicjatywy państwa powinny być ukierunkowane na ochronę wartości demokratycznych, zapewnienie stabilności i bezpieczeństwa wewnętrznego państwa oraz jego obywateli.

W kontekście trwającej wojny na Ukrainie oraz rosnącej roli Polski w regionie, zagrożenia związane z atakami na infrastrukturę wyborczą, czy szerzeniem dezinformacji mogą mieć jeszcze większe znaczenie, a jej stabilność i bezpieczeństwo są najważniejsze dla całego regionu Europy Środkowo-Wschodniej.

Dlatego też, polskie władze powinny podjąć wszelkie możliwe środki, aby zapewnić odpowiedni poziom bezpieczeństwa publicznego w kraju. Przede wszystkim należy inwestować w rozwój technologii, wzmocnienie systemów zabezpieczeń oraz edukować społeczeństwo na temat zagrożeń związanych z dezinformacją i atakami z użyciem AI.

Warto również zwrócić uwagę na organizacje i instytucje, których głównym przedmiotem zainteresowania jest bezpieczeństwo wewnętrzne oraz szkolenie pracowników z branży bezpieczeństwa i cyberbezpieczeństwa. Należy również wspierać rozwój innowacyjnych technologii oraz tworzyć silne partnerstwa publiczno-prywatne oraz międzynarodowe w celu skutecznego przeciwdziałania ewentualnym zagrożeniom.

Reasumując, zagrożenia związane z wykorzystaniem sztucznej inteligencji w celu destabilizacji życia publicznego w Polsce w kontekście nadchodzących wyborów są realne i mogą mieć poważne konsekwencje dla bezpieczeństwa państwa i jego obywateli.

Autor: Michał Szpot

Źródła:

- Bianca Nogrady, „The real risks of artificial intelligence”, BBC, https://www.bbc.com/future/article/20161110-the-real-risks-of-artificial-intelligence, 10.11.2016 r.

- Tom Simonite, „What Happened to the Deepfake Threat to the Election?”, WIRED, https://www.wired.com/story/what-happened-deepfake-threat-election/, dostęp:16.11.2020 r.

- Mark Minevich, 7 Ways AI Could Solve All Of Our Election Woes: Out With The Polls, In With The AI Models, FORBES, https://www.forbes.com/sites/markminevich/2020/11/02/7-ways-ai-could-solve-all-of-our-election-woes-out-with-the-polls-in-with-the-ai-models/?sh=ee7bc0622c91, 02.11.2020 r.,

- Vyacheslav Polonski, „"The Good, the Bad, and the Ugly: The Uses of Machine Learning in Election Campaigns", Centre for Public Impact, https://www.centreforpublicimpact.org/insights/good-bad-ugly-uses-machine-learning-election-campaigns, 30.08.2017 r.

- Elaine Kamarck, The Brookings Institution, „Malevolent soft power, AI, and the threat to democracy”, https://www.brookings.edu/research/malevolent-soft-power-ai-and-the-threat-to-democracy/, 29.11.2018 r.

- A. Turing, "Computing Machinery and Intelligence", Mind, 1950.

- J. McCarthy, "What is Artificial Intelligence?", Stanford University, źródło: http://www-formal.stanford.edu/jmc/whatisai/, 12.11.2007 r.

- Ian Goodfellow, Yoshua Bengio, and Aaron Courville, „Deep learning”, Springer Science+Business Media, źródło: https://link.springer.com/article/10.1007/s10710-017-9314-z, 29.10.2018 r.

- Karolina Żyłowska, (25.06.2020 r.), „Media społecznościowe pierwszym źródłem informacji?”, źródło: https://socialpress.pl/2020/06/media-spolecznosciowe-pierwszym-zrodlem-informacji, dostęp: 13.04.2023 r.

- V. K. Brändle, Ch. Galpin, H.Trenz (21.07.2020 r.), „Brexit as ‘politics of division’: social media campaigning after the referendum”, Taylor & Francis, https://www.tandfonline.com/doi/epdf/10.1080/14742837.2021.1928484?needAccess=true&role=button, dostęp: 13.04.2023 r.

- Perry Carpenter, „The Dangerous Art Of Social Media And Messaging Manipulation”, Forbes, źródło: https://www.forbes.com/sites/forbesbusinesscouncil/2020/08/03/the-dangerous-art-of-social-media-and-messaging-manipulation/?sh=e47960d3f699, 03.08.2020 r.

- Indre Deksnyte, „How AI Can Create And Detect Fake News”, Forbes, żródło: https://www.forbes.com/sites/forbescommunicationscouncil/2019/09/12/how-ai-can-create-and-detect-fake-news/?sh=1f1f56e0e84b, 12.09.2019 r.

- Filippo Menczer, „Here’s exactly how social media algorithms can manipulate you”, Big Think

- Michael J Mc Cusker, „The Adjustment Experiment…, 06.09.2021 r., źródło:https://medium.com/change-becomes-you/the-adjustment-experiment-are-we-falling-prey-to-social-media-manipulation-4e2106d04c62, 06.09.2021 r

- ibidem

- K. Sedova, C. McNeill, A. Johnson, A. Joshi, I. Wulkan, „AI and the Future of

Disinformation Campaigns”, CSET, źródło: https://cset.georgetown.edu/publication/ai-and-the-future-of-disinformation-campaigns-2/, 12.2021 r. - Berit Anderson, „The Rise of the Weaponized AI Propaganda Machine”, Medium, https://medium.com/join-scout/the-rise-of-the-weaponized-ai-propaganda-machine-86dac61668b, 13.02.2017 r.

- Will Knight, „AI Can Write Disinformation Now and Dupe Human Readers”, Wired, źródło:https://www.wired.com/story/ai-write-disinformation-dupe-human-readers/, 24.05.2021 r.

- James Vincent, „ThisPersonDoesNotExist.com uses AI to generate endless fake faces”, The Verge, https://www.theverge.com/tldr/2019/2/15/18226005/ai-generated-fake-people-portraits-thispersondoesnotexist-stylegan, 15.02.2019 r.

- J. Skowronski (2019), „Trolls and bots are disrupting social media — here’s how AI can stop them”, żródło: https://towardsdatascience.com/trolls-and-bots-are-disrupting-social-media-heres-how-ai-can-stop-them-d9b969336a06, dostęp: 13.04.2023 r.

- E. Musiał (2017) „Trolling jako przykład zagrożeń informacyjnych w cyberprzestrzeni”, UP w Krakowie, źródło: https://rep.up.krakow.pl/xmlui/bitstream/handle/11716/2040/18--Trolling-jako-przyklad-zagrozen-Musial.pdf?sequence=1, dostęp: 13.04.2023 r.

- J. Rashid, T. MAhmood, M. Nisar, T. Nazir,(2020) „Phishing Detection Using Machine Learning Technique”,SMARTTECH, źródło:https://www.researchgate.net/publication/347308591_Phishing_Detection_Using_Machine_Learning_Technique, dostęp: 13.04.2023 r.

- NSA (2021), „Artificial Intelligence: Next Frontier is Cybersecurity”, źródło: https://www.nsa.gov/Press-Room/News-Highlights/Article/Article/2702241/artificial-intelligence-next-frontier-is-cybersecurity/, 13.04.2023 r.

- Sam Gregory (11.06.2018 r.), „Mal-uses of AI-generated Synthetic Media and Deepfakes: Pragmatic Solutions Discovery Convening, June 2018: Summary of Discussions and Next Step Recommendations”, źródło: https://www.researchgate.net/publication/341464776_Mal-uses_of_AI-generated_Synthetic_Media_and_Deepfakes_Pragmatic_Solutions_Discovery_Convening_June_2018_Summary_of_Discussions_and_Next_Step_Recommendations, dostęp: 13.04.2023 r.

- Cristian Canton Ferrer, Brian Dolhansky, Joanna Bitton, Paarth Neekhara (19.11.2020 r.), „Adversarial Threats to DeepFake Detection: A Practical Perspective”, META AI, źródło: https://ai.facebook.com/research/publications/adversarial-threats-to-deepfake-detection-a-practical-perspective/, dostęp: 13.04.2023 r.

- Matteo Wong (20.12.2022 r.), „We Haven’t Seen the Worst of Fake News”, The Atlantic, źródło: https://www.theatlantic.com/technology/archive/2022/12/deepfake-synthetic-media-technology-rise-disinformation/672519/, dostęp: 13.04.2023 r.

- Karen Hao (10.10.2019 r.), „The biggest threat of deepfakes isn’t the deepfakes themselves”, MIT Technology Review, źródło:https://www.technologyreview.com/2019/10/10/132667/the-biggest-threat-of-deepfakes-isnt-the-deepfakes-themselves/, dostęp: 13.04.2023 r.

- Tom Signote, (16.11.2020), „What Happened to the Deepfake Threat to the Election?”, WIRED, r., źródło: https://www.wired.com/story/what-happened-deepfake-threat-election/, dostęp: 13.04.2023 r.

- João Paulo Meneses (22.01.2021 r.), „Deepfakes and the 2020 US elections: what (did not) happen”, ArXiv, źródło: https://arxiv.org/ftp/arxiv/papers/2101/2101.09092.pdf, dostęp: 13.04.2023 r.

- Ben Wodecki (19.09.2022 r.), „Russia creates AI weapons department to ‘intensify’ military”, źródło: https://aibusiness.com/verticals/russia-creates-ai-weapons-department-to-intensify-military, dostęp: 13.04.2023 r.