Czy powszechnie stosowane GPU są idealne do kosztujących majątek centrów danych? Zdaniem Microsoftu jest lepsze rozwiązanie, układ bardziej wyspecjalizowany od tego wywodzącego się z kart graficznych dla graczy. A iż wymarzonego układu na rynku nie ma to Microsoft zdecydował się go stworzyć.

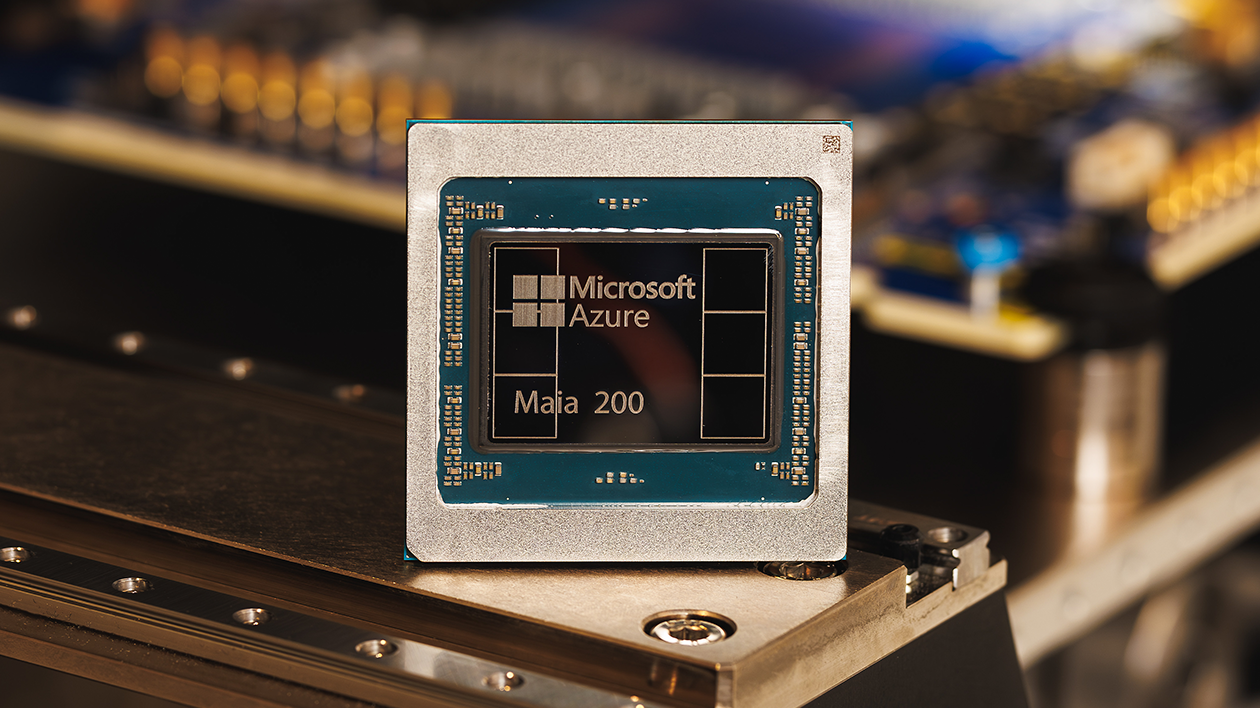

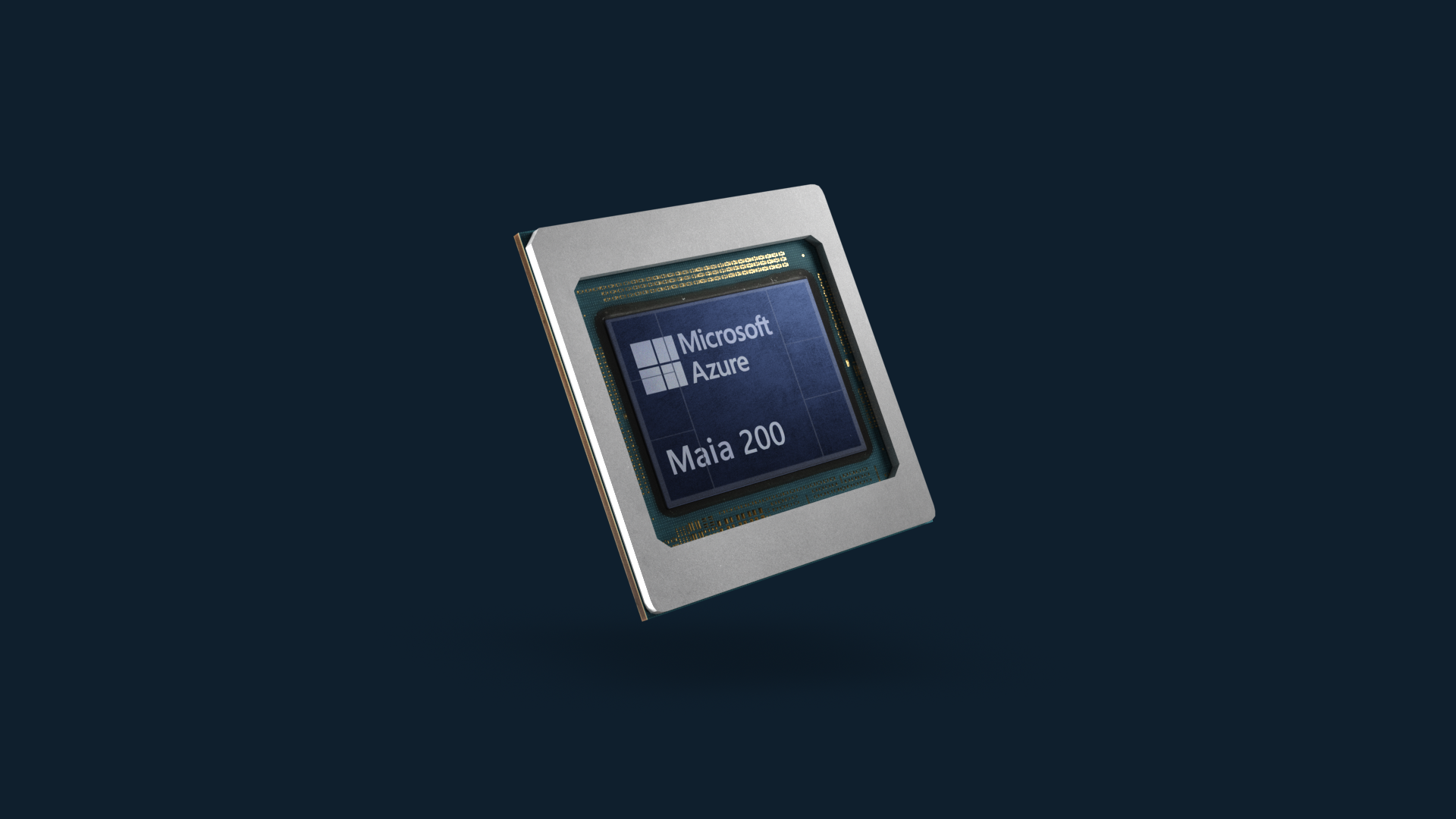

Microsoft oficjalnie uruchomił produkcję układów Maia 200 – własnego akceleratora AI zaprojektowanego od podstaw z myślą o jednym celu: radykalnym obniżeniu kosztów i zwiększeniu efektywności wnioskowania dużych modeli językowych w chmurze Azure. Maia 200 ma być odpowiedzią na pytanie jak skalować AI bez wykładniczego wzrostu kosztów i złożoności.

Wydajność to dopiero początek. Prawdziwy problem leży gdzie indziej

W dyskusjach o akceleratorach AI najczęściej padają FLOPS-y. Tymczasem inżynierowie dobrze wiedzą, iż surowa moc obliczeniowa to tylko połowa równania. Drugą – często trudniejszą – jest przepustowość danych.

Możesz mieć silnik o mocy tysiąca koni, ale jeżeli paliwo dopływa przez słomkę, to nigdzie nie pojedziesz. W AI jest podobnie: model musi być nieustannie karmiony danymi, a każde wąskie gardło pamięci lub sieci potrafi zabić choćby najbardziej imponujące parametry obliczeniowe.

Microsoft postanowił więc nie łatać istniejących rozwiązań, ale zaprojektować cały stos – od krzemu, przez oprogramowanie, po architekturę centrów danych – jako jedną, spójną całość. Maia 200 jest efektem tej filozofii.

Specyfikacja, która nie potrzebuje marketingu

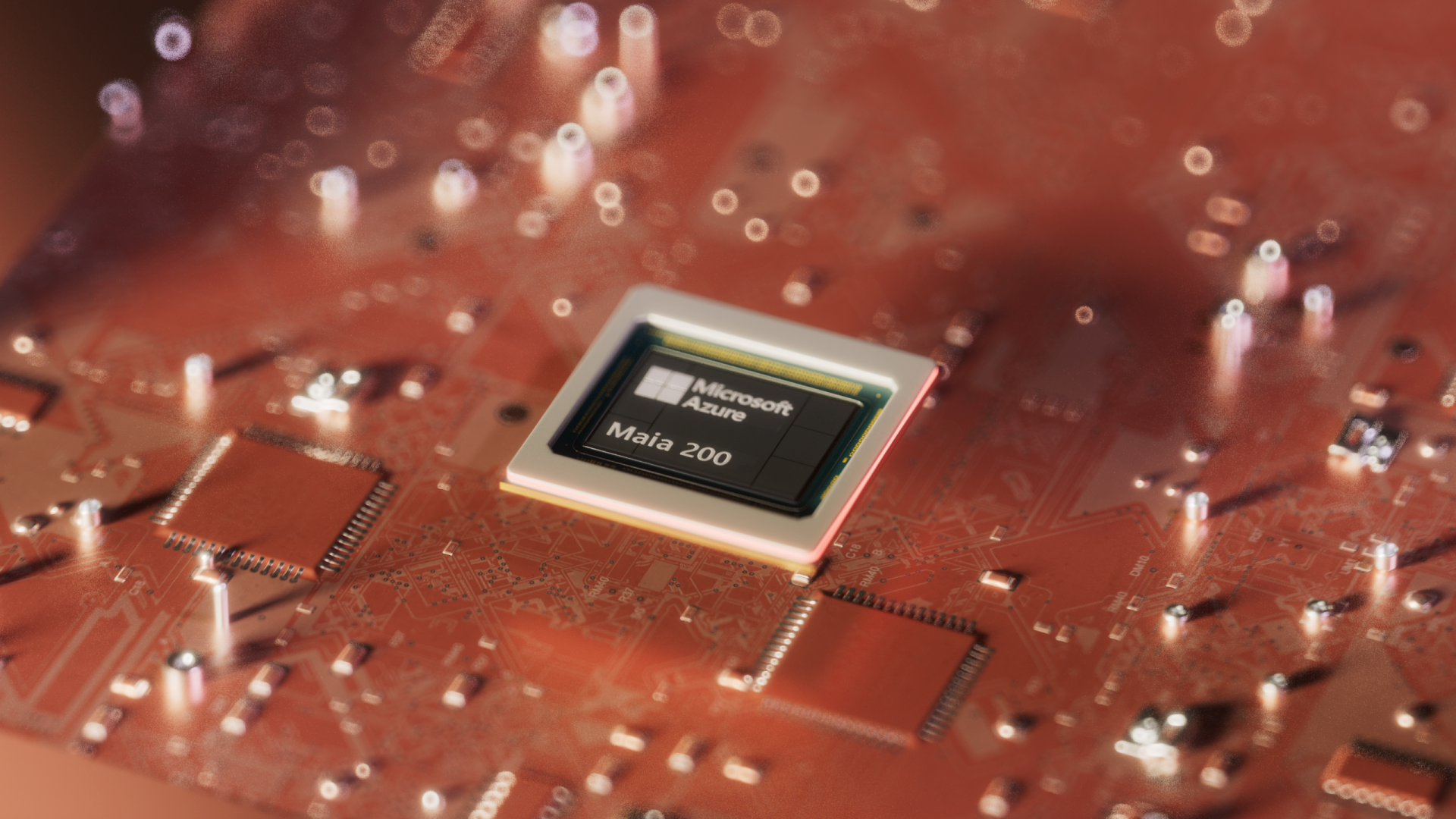

Microsoft Maia 200

Microsoft Maia 200Każdy układ Maia 200 powstaje w procesie TSMC N3 i zawiera ponad 100 mld tranzystorów. To poziom zarezerwowany dotąd dla najbardziej zaawansowanych GPU, ale tutaj cała architektura została zoptymalizowana pod potrzeby inferencji dużych modeli.

Najważniejsze liczby:

- >10 PFLOPS w precyzji FP4

- ~5 PFLOPS w FP8

Dla porównania: to około trzykrotność FP4 Amazon Trainium 3 i wyższa wydajność FP8 niż w Google TPU v7. W praktyce oznacza to, iż pojedynczy węzeł Maia 200 jest w stanie obsłużyć choćby największe współczesne modele – i to z zapasem na kolejne generacje.

Ale to wciąż nie jest najciekawsza część układu.

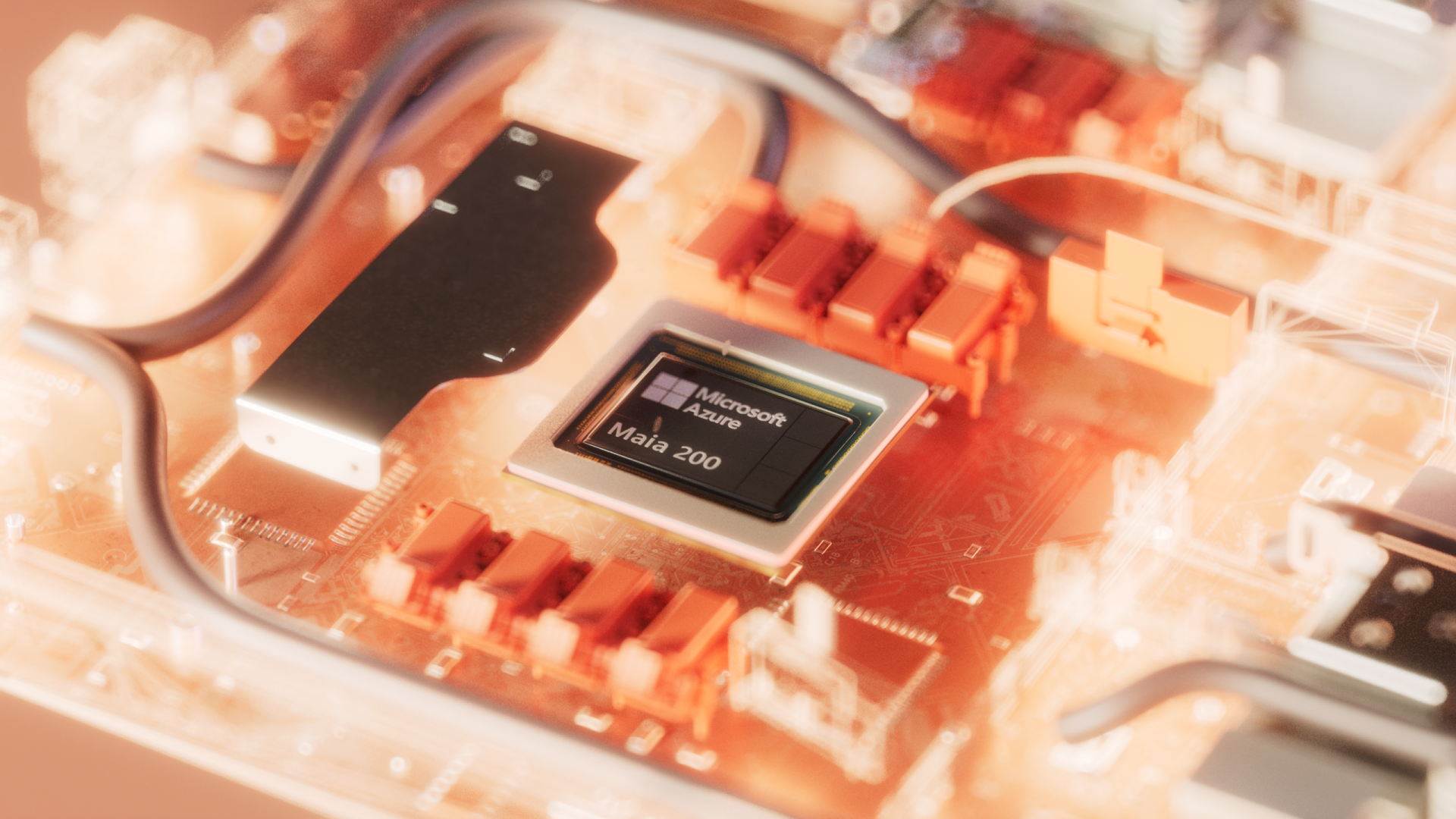

Pamięć: największy wróg AI zamienia się w jej sprzymierzeńca

To właśnie podsystem pamięci jest tym, co odróżnia Maię 200 od większości akceleratorów dostępnych dziś na rynku. Microsoft zastosował 216 GB HBM3e o przepustowości 7 TB/s , 272 MB SRAM na chipie, zaawansowane silniki DMA i rozbudowaną sieć NoC. To zmiana, która pozwala trzymać znacznie większą część modelu lokalnie, bez konieczności rozpraszania go na wiele urządzeń.

Microsoft Maia 200

Microsoft Maia 200Efekt? Mniej akceleratorów potrzebnych do uruchomienia modelu, mniejsza złożoność topologii, niższe koszty energii i chłodzenia.

Przewidywalny, skalowalny Ethernet

Microsoft postawił na standardowy Ethernet w przeciwieństwie do konkurencji, która często opiera się na własnych, zamkniętych technologiach sieciowych. Tyle iż w wersji, która nie ma nic wspólnego z tym, co znamy z serwerowni sprzed dekady.

Każdy akcelerator otrzymuje 1,4 TB/s przepustowości skalowania, 28 portów 400 GbE i wsparcie dla klastrów do 6144 akceleratorów.

W obrębie jednego modułu cztery układy Maia 200 są połączone bezpośrednio, bez przełączników pośrednich. Ten sam protokół komunikacji działa zarówno w obrębie racka, jak i między rackami, co pozwala skalować klastry bez utraty deterministycznej wydajności.

Microsoft Maia 200

Microsoft Maia 200To podejście ma jedną ogromną zaletę: przewidywalność. W AI przewidywalność jest walutą cenniejszą niż surowa moc.

Od symulacji do krzemu: projektowanie jak w lotnictwie, nie jak w IT

Microsoft nie projektował Mai 200 metodą prób i błędów. Zanim pierwszy prototyp trafił do fabryki firma przeprowadziła jedne z największych w historii symulacji emulacyjnych infrastruktury AI.

Dzięki temu modele AI działały na prototypach w ciągu kilku dni od dostarczenia pierwszych układów. A czas od pierwszego krzemu do działającego racka w datacenter skrócono o ponad połowę względem typowych projektów infrastruktury AI.

To tempo jest bezprecedensowe.

Efektywność kosztowa: najważniejszy argument

Microsoft deklaruje, iż Maia 200 to najbardziej efektywny kosztowo system inferencyjny, jaki kiedykolwiek wdrożył. W liczbach: około 30 proc. lepsza wydajność na dolara niż dotychczasowe rozwiązania. Dla operatorów chmur, którzy obsługują miliardy zapytań dziennie, realne oszczędności liczone w dziesiątkach milionów dolarów rocznie – i to przy rosnących wymaganiach modeli.

Maia 200 już pracuje. I to w najbardziej wymagających projektach. Pierwsze wdrożenia trafiły do regionu Azure Central US, a kolejne = m.in. US West 3 – są już w kolejce. W następnych miesiącach Maia 200 pojawi się w kolejnych regionach Azure na całym świecie.

Microsoft Maia 200

Microsoft Maia 200Układy już dziś wspierają projekty zespołu Microsoft ds. superinteligencji, w tym generowanie syntetycznych danych, reinforcement learning i rozwój modeli napędzających Microsoft 365 Copilot i Foundry.

W kontekście syntetycznych danych – kluczowych dla trenowania frontierowych modeli – Maia 200 ma szczególnie duże znaczenie. Jej architektura pozwala generować ogromne ilości wysokiej jakości danych domenowych (tekst, instrukcje, kod) szybciej i taniej niż dotychczas.

Maia SDK: narzędzia dla tych, którzy chcą wycisnąć z układu maksimum

Wraz z premierą sprzętu Microsoft udostępnił Maia SDK, czyli zestaw narzędzi dla deweloperów:

- kompilator Triton,

- pełne wsparcie dla PyTorch,

- NPL – niskopoziomowy język programowania,

- symulator Maia i kalkulator kosztów.

To otwarte zaproszenie dla laboratoriów badawczych, startupów AI i projektów open-source, by zacząć optymalizować modele pod nową architekturę.

To dopiero początek. Maia jest programem wielopokoleniowym

Microsoft jasno komunikuje: Maia 200 to pierwsza generacja. Kolejne są już w fazie projektowania. Każda ma podnosić poprzeczkę w zakresie wydajności na wat, wydajności na dolara, skalowalności i integracji z oprogramowaniem. W praktyce oznacza to, iż Microsoft buduje własną, długoterminową linię akceleratorów AI – podobnie jak Google z TPU czy Amazon z Trainium/Inferentia.

Maia 200 nie jest kolejnym akceleratorem AI. To efekt strategii, w której krzem, oprogramowanie, sieć i architektura centrów danych zostały zaprojektowane jako jeden organizm. Rezultat to system, który wdraża się szybciej, działa przewidywalniej, skaluje się prościej i kosztuje mniej.

Maia 200 to nie tylko krok naprzód dla Microsoftu. To sygnał dla całej branży, iż czasy stosowania uniwersalnych GPU do wszystkiego powoli się kończy. Nadchodzi czas wyspecjalizowanych, głęboko zintegrowanych platform AI – a Maia 200 jest jednym z pierwszych poważnych zwiastunów tej zmiany. A jeżeli dodatkowo oznacza to przywrócenie zdrowej podaży układów scalonych na rynku konsumenckim to trudno o lepsze wieści.