Cyfrowa transformacja przedsiębiorstw coraz częściej opiera się na sztucznej inteligencji. Przykładowo w branży programowania w ciągu dwóch lat 85% osób będzie korzystać z generatywnej AI. Szerokie stosowanie AI w biznesie to także szansa dla cyberprzestępców – alarmują analitycy ESET, którzy w II połowie 2023 r. zablokowali 650 000 prób oszustw za pośrednictwem złośliwych domen, używających nazwy Chat GPT lub podobnego tekstu, sugerującego powiązanie z najpopularniejszym narzędziem AI.

AI – wielka szansa na cyfrową transformację

Wykorzystanie generatywnej sztucznej inteligencji w biznesie stało się koniecznością. Menedżerowie i dyrektorzy firm, które przeprowadzają cyfrową transformację, powinni być świadomi, iż wdrażanie AI nie jest już tylko wizerunkową ciekawostką, ale też koniecznym ruchem, w konkurencyjnym środowisku biznesowym. Tendencja ta jest już doskonale widoczna wśród firm z sektora IT . Jak wynika z raportu Capgemini „Gen AI in software”, aż 85% programistów w ciągu najbliższych dwóch lat będzie korzystać z Gen AI. Ponadto, aż 80% ankietowanych uważa, iż automatyzacja prostych, powtarzalnych zadań dzięki narzędzi i rozwiązań Gen AI znacząco zmieni ich pracę i umożliwi skupienie się na zadaniach o większej wartości. Dla 46% osób na stanowiskach inżynierów oprogramowania, narzędzia AI już teraz stanowią wsparcie przy codziennych zadaniach. Z generatywnej sztucznej inteligencji w pracy korzystają coraz intensywniej także specjaliści z wielu innych branż. Zamiast zadawać pytanie, czy korzystać z AI, powinniśmy zastanowić się, jak to robić, by było to bezpieczne dla firmy.

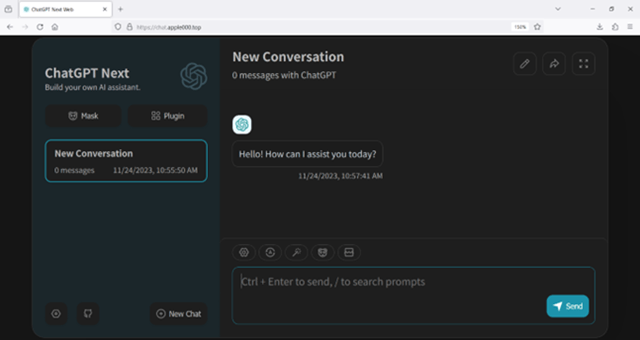

Chat GPT – uważaj na fałszywe narzędzie web i aplikacje

Chat GPT bije rekordy popularności. Szacuje się, iż posiada 60% udziału w rynku wykorzystywanych narzędzi AI . Przekłada się to na skalę zagrożeń.

– Statystyki są druzgocące – tylko w drugiej połowie 2023 r. ESET zablokował ponad 650 000 prób wejścia użytkowników na fałszywe strony związane z „chatgpt” lub podobnym tekstem w nazwie. Drugim znaczącym wektorem ataku na użytkowników jest reklamowanie i próba nakłonienia do instalacji fałszywych aplikacji bliźniaczo podobnych do Chat GPT. W sklepach z aplikacjami (szczególnie mobilnymi) zaroiło się od fałszywych kopii różnych aplikacji imitujących najnowsze wersje, np. Chat GPT 5, Sora czy MidJourney, zawierających złośliwe oprogramowanie – opisuje Beniamin Szczepankiewicz, analityk laboratorium antywirusowego ESET.

To właśnie pracownik, skuszony oszczędnością czasu, często chcący usprawnić swoją pracę, jest najsłabszym ogniwem systemu i prowokuje niebezpieczne sytuacje. Fałszywe aplikacje po pobraniu i instalacji mogą atakować użytkowników reklamami, nakłaniać do dodatkowych zakupów w aplikacji lub wymagać subskrypcji usług, które nie istnieją i lub są wyjątkowo niskiej jakości.

– Odkryliśmy również próby oszustw, w których cyberprzestępcy obiecywali dostęp do zaawansowanych możliwości sztucznej inteligencji, które miałyby zostać udostępnione za dodatkową opłatą. Znaczna część ataków jest przeprowadzana dzięki reklam w mediach społecznościowych, gdzie masowo proponowane są użytkownikom fałszywe strony lub aplikacje opisuje Beniamin Szczepankiewicz

Niezaufane a zainstalowane aplikacje desktopowe lub mobilne mogą również zawierać złośliwe oprogramowanie, za pomocą którego oszuści mogą przejąć kontrolę nad komputerem/telefonem komórkowym czy innym urządzeniem, a tym samym zyskać dostęp do przechowywanych tam wszelkich danych: osobowych (także klientów), finansowych czy innych. To już z kolei otwiera cyberprzestępcom furtki do wyłudzeń czy szantażu. Co więcej przechwycone mogą zostać np. dane uwierzytelniające do kont służbowych, a to już prosta droga do ataku na daną firmę lub jej klientów.

Jak pokazuje praktyka, pracownicy korzystając z narzędzi sztucznej inteligencji, nie pamiętają o zasadach bezpieczeństwa cyfrowego. Jak wynika z danych Cyberhaven Labs, ilość danych wprowadzanych przez pracowników do narzędzi Gen AI gwałtownie skoczyła – tylko w okresie od marca 2023 r. do marca br. niemal sześciokrotnie! Do narzędzi AI pracownicy wprowadzają poufne informacje, np. finansowe, dotyczące klientów, pracowników i wiele innych. Należy pamiętać, iż dane które wprowadzamy do narzędzi typu AI mogą być w przyszłości używane do trenowania nowych nowszych wersji, a co za tym idzie zmniejszamy poziom prywatności

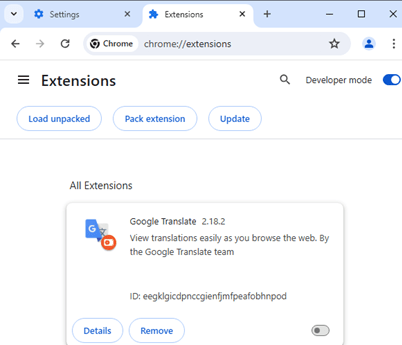

Wtyczka translatora – zachowaj czujność

Innym sposobem cyberprzestępców wykorzystujących popularność AI jest próba nakłonienia do instalacji fałszywej wtyczki imitującej Tłumacza Google – kierują do niej fałszywe reklamy na Facebooku wykorzystujące wizerunek OpenAI lub Gemini.. Chociaż wtyczka łudząco przypomina realną, w rzeczywistości jest to złośliwe oprogramowanie, które zostało zaprojektowane do wykradania m.in. danych logowania do serwisu Facebook. W ciągu roku systemy ESET zarejestrowały i udaremniły 4 000 prób tego typu oszustw.

Generatywna sztuczna inteligencja jest wielką szansą dla przedsiębiorstw, ale wymaga też od menedżerów i zarządów firm odpowiedzialności we wdrażaniu narzędzi. Pozostawienie wolnej ręki pracownikom może prowadzić do wycieków danych, a co za tym idzie strat finansowych i reputacji. Jak ich unikać? Opracowując w firmie odpowiednie polityki i procedury związane z AI, aktualizując na bieżąco oprogramowanie antywirusowe, a także szkoląc i dzieląc się z pracownikami wiedzą m.in. o konieczności uważnej weryfikacji autentyczności aplikacji AI, z jakich zamierzają skorzystać i jakie dane wprowadzają do systemów AI. Zawsze warto powtarzać także uniwersalne prawdy dotyczące czujności, weryfikacji linków w które się klika i korzystaniu z uwierzytelniania wieloskładnikowego.

1Źródło: https://www.visualcapitalist.com/ranked-the-most-popular-ai-tools/

foto. ESET