AI ma problem z newsami — tak twierdzą badacze z BBC, którzy przetestowali cztery chatboty z wykorzystaniem źródeł z artykułów z BBC. Okazało się, iż 51% odpowiedzi chatbotów zawierało istotne problemy w co najmniej jednej z siedmiu kategorii badanych przez nadawcę.

Badacze z BBC postanowili sprawdzić, jak dobrze sztuczna inteligencja radzi sobie z podsumowaniem newsów. W badaniu poprosili cztery chatboty: specjalizujące się w łączeniu wyszukiwania z AI Perplexity oraz Gemini od Google, Copilota od Microsoftu i ChatGPT od OpenAI o napisanie odpowiedniego podsumowania wydarzenia lub zjawiska, biorąc za źródła artykuły dostępne na stronach BBC.

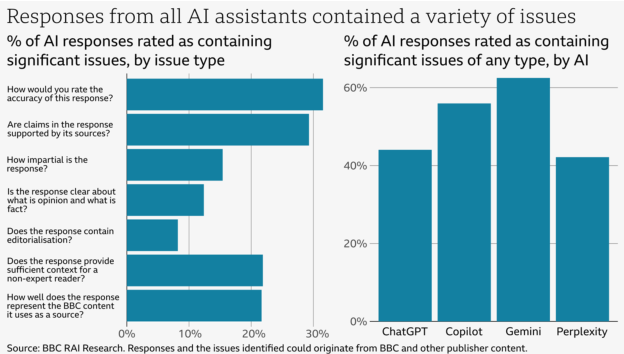

Odpowiedzi były oceniane w siedmiu kategoriach: precyzji, wierności źródłom, bezstronności, oddzielania opinii od faktów, wystarczającego kontekstu i wierności treściom BBC. Wyniki testu trudno raczej określić jako sukces sztucznej inteligencji.

AI ma problem z newsami. To duży problem!

Najgorzej sztuczna inteligencja wypadła w bodaj najważniejszej kategorii — precyzji odpowiedzi. Tutaj przeszło 30% podsumowań zawierało błędy. Chatboty podawały nieprawidłowe liczby, daty i fakty ze źródeł, które same cytowały.

Innym częstym błędem popełnianym przez chatboty był niewłaściwy dobór źródeł. Często korzystały one ze źródeł, które zawierały nieaktualne informacje, co prowadziło do stwierdzeń, iż na przykład Rishi Sunak wciąż jest premierem Wielkiej Brytanii.

Innymi częstymi problemami w odpowiedziach jest niezapewnienie czytelnikowi odpowiedniego kontekstu oraz brak wierności źródłom z BBC. Błędy w tych kategoriach dotyczyły nieco ponad 20% odpowiedzi.

Nie tylko największe chatboty dają możliwość podsumowania newsów. Taką funkcjonalność oferuje również nasz polski Bielik.

Nie przegap najważniejszych trendów w technologiach!

Zarejestruj się, by otrzymywać nasz newsletter!

Gemini wielkim przegranym, niszowe Perplexity o włos wygrywa z ChatGPT

Który z chatbotów wypadł najsłabiej, a który najlepiej? Zdecydowanie najgorzej wypadł Gemini od Google, wśród którego odpowiedzi aż przeszło 60% zawierało poważne problemy, a 46% zawierało błędy faktyczne. Jest to o tyle zadziwiające, iż test BBC łączył podsumowywanie z wyszukiwaniem — a przecież w wyszukiwaniu Google jest niekwestionowanym gigantem.

Dużo lepiej radziły sobie ChatGPT i Perplexity. Zajmowały one dwa pierwsze miejsca w każdej z siedmiu kategorii. choćby jednak w ich przypadku poważne problemy dotyczyły przeszło 40% odpowiedzi. Copilot od Microsoftu był gdzieś pomiędzy dwójką liderów i Gemini.

Skąd się biorą problemy sztucznej inteligencji z newsami?

Skąd się biorą problemy AI z newsami, skoro duże modele językowe generalnie świetnie sobie radzą z podsumowywaniem tekstu? Po pierwsze, sztuczna inteligencja wydaje się być nieco na bakier z chronologią — przeszukując internet, nie zawsze wybiera najnowsze źródła informacji. Stąd prawdopodobnie wpadki w rodzaju uznania Rishi Sunaka za obecnego premiera Wielkiej Brytanii. Problem ten może być tak naprawdę głębszy — ChatGPT choćby w trybie „deep research” miał problemy ze wbudowaniem w odpowiedź najnowszych informacji, jak ostatnio pokazał test przeprowadzony przez The Verge.

Drugim problemem jest prawdopodobnie to, iż duże modele językowe posiadają pewną wewnętrzną reprezentację wiedzy o świecie. Nie znamy wszystkich szczegółów technicznych badania BBC i nie wiemy, jak dobrze badaczom udało się zmusić sztuczną inteligencję do „wyłączenia” tej wewnętrznej wiedzy i korzystania tylko ze źródeł. A te dwa źródła informacji mogą być ze sobą sprzeczne, prowadząc do błędów.

Dodatkowo, jak pokazuje raport, mimo iż chatboty poproszono o korzystanie ze źródeł BBC, część odpowiedzi oparta była o inne źródła z internetu. To również mogło prowadzić do nieścisłości.

Niezależnie od źródeł tych błędów, pamiętajmy, iż się one, i to dość często, zdarzają. Więc jeżeli w pracy czy na studiach korzystamy z AI do podsumowania najnowszych wiadomości — zawsze sprawdzajmy źródła. jeżeli tego nie zrobimy, to błąd może być po stronie sztucznej inteligencji, ale kompromitacja — naszej.

Źródło grafiki. Sztuczna inteligencja, model Dall-E 3