AMD właśnie podniosło poprzeczkę w segmencie akceleratorów AI, prezentując serię Instinct MI350 oraz AMD Developer Cloud na wydarzeniu Advancing AI 2025. To nie jest zwykła ewolucja – to zmiana w sposobie, w jaki będziemy trenować i wdrażać modele sztucznej inteligencji. A najlepsze? Całość oparta jest na otwartych standardach, co w dzisiejszych czasach brzmi jak oddech świeżego powietrza.

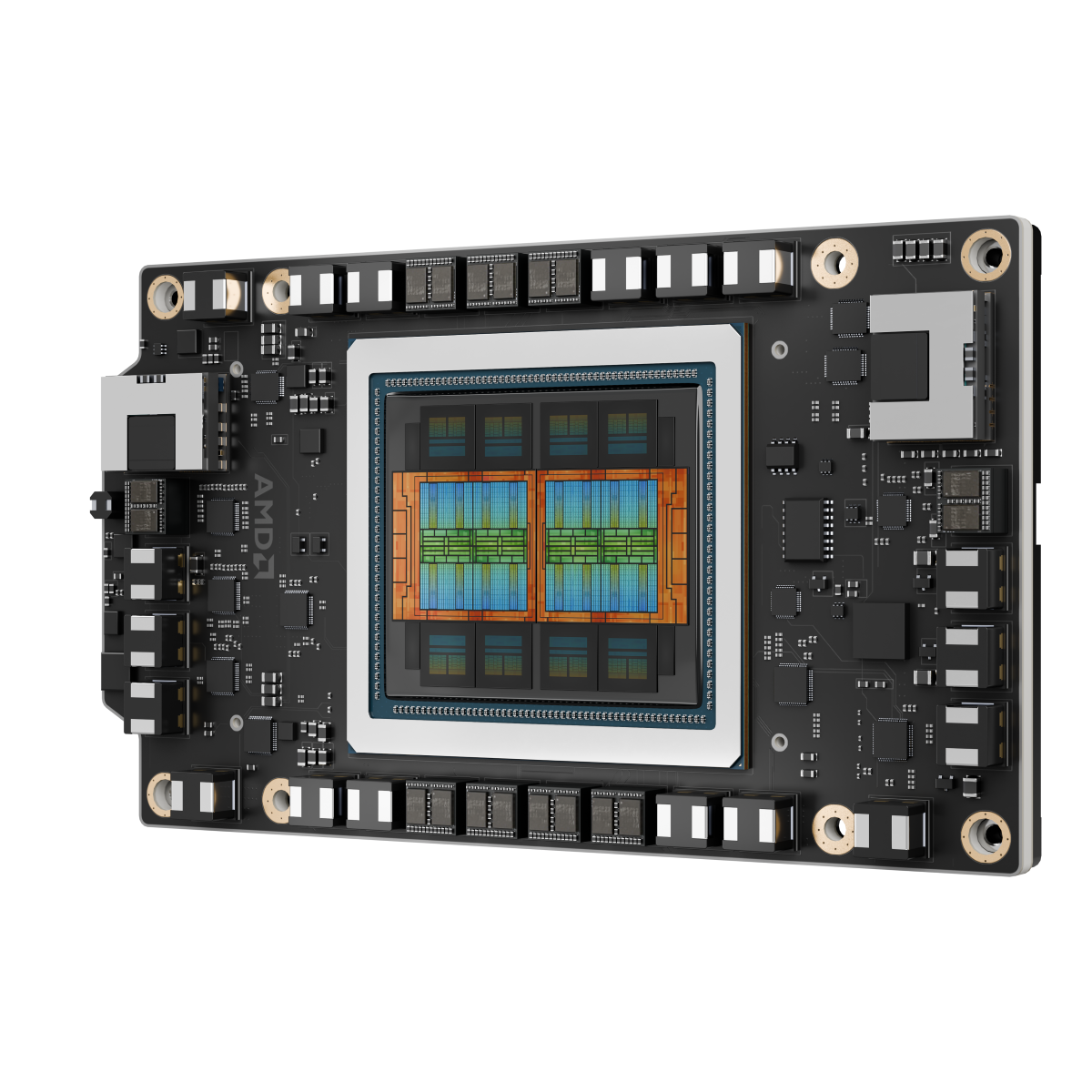

Nowa seria AMD Instinct MI350 składa się z dwóch głównych modeli: MI350X i MI355X, oba zbudowane na architekturze AMD CDNA 4. To nie są zwykłe karty graficzne – to prawdziwe bestie obliczeniowe zaprojektowane z myślą o najbardziej wymagających zadaniach AI.

AMD Instinct MI350X

- 288 GB pamięci HBM3E z przepustowością 8 TB/s

- Wydajność FP16: 4,6 PFLOPS

- Wydajność FP8: 9,2 PFLOPS

- Wydajność FP4: 18,45 PFLOPS

- Pobór mocy: do 1000 W

AMD Instinct MI355X:

- Również 288 GB pamięci HBM3E z przepustowością 8 TB/s

- Wydajność FP16: 5 PFLOPS

- Wydajność FP8: 10,1 PFLOPS

- Wydajność FP4: 20,1 PFLOPS

- Pobór mocy: do 1400 W

Różnica w poborze mocy między modelami może wydawać się znacząca, ale pamiętajmy – w świecie AI każdy dodatkowy PFLOPS to potencjalnie godziny zaoszczędzonego czasu obliczeniowego.

Architektura CDNA 4 – więcej niż suma części składowych

Nowa architektura CDNA 4 przynosi szereg usprawnień, które w praktyce przekładają się na znaczący wzrost wydajności. Najważniejsze innowacje to:

- Podwojone jednostki macierzowe – 2x więcej operacji mieszanej precyzji na takt na jednostkę obliczeniową;

- Rozszerzona pamięć lokalnych danych (LDS) – zwiększona do 160KB z poprawioną przepustowością;

- Obsługs nowych formatów danych – FP4 i FP6 zgodnie ze specyfikacją OCP MX;

- Ulepszona efektywność energetyczna – optymalizacje na poziomie napięcia i częstotliwości

AMD Instinct MI350

AMD Instinct MI350ROCm 7 – wydajność, której nie trzeba koloryzować, by ją sprzedać

Wraz z nowym sprzętem AMD wprowadza ROCm 7 – najnowszą wersję swojego stosu systemu AI. Liczby mówią same za siebie:

- 3,5x poprawa wydajności inference w porównaniu do ROCm 6;

- 3x poprawa wydajności treningu – średnio we wszystkich testowanych modelach;

- Obsługa najnowszych modeli jak Llama 4, Gemma 3 i DeepSeek od pierwszego dnia.

Te ulepszenia to nie tylko teoretyczne liczby w benchmarkach. W praktyce oznaczają one, iż model, który wcześniej potrzebował godzin na przetworzenie, teraz może to zrobić w ułamku tego czasu.

ROCm 7 wprowadza wyrafinowane podejście do rozproszonego wnioskowania, współpracując z ekosystemem open-source, włączając frameworki takie jak SGLang, vLLM i llm-d. To oznacza, iż możemy efektywnie rozłożyć obliczenia na wiele GPU, co jest najważniejsze przy pracy z największymi modelami językowymi.

AMD Developer Cloud, czyli demokratyzacja AI

AMD Developer Cloud to odpowiedź na jedno z największych wyzwań współczesnego rozwoju AI – dostęp do odpowiedniego sprzętu. Platforma oferuje:

- Środowisko zero-setup – notebooki Jupyter uruchamiające się natychmiast;

- Prekonfigurowane kontenery Docker z popularnymi narzędziami AI;

- Skalowalne opcje obliczeniowe – od 1x MI300X (192 GB pamięci GPU) do 8x MI300X (1536 GB pamięci GPU);

- Darmowe kredyty dla deweloperów – 25 godzin na start z możliwością uzyskania dodatkowych 50 godzin.

To podejście to prawdziwa demokratyzacja AI – każdy z GitHub ID może teraz eksperymentować z najnowszymi technologiami AMD bez konieczności inwestowania w drogi sprzęt.

Ekosystem partnerów i siła współpracy

Lista partnerów AMD robi wrażenie i pokazuje, jak poważnie branża traktuje nową ofertę. Meta wykorzystuje Instinct MI300X do inferencji modeli Llama 3 i Llama 4, planując współpracę przy platformie MI450. Oracle Cloud Infrastructure (OCI) jako jeden z pierwszych wdraża infrastrukturę rack-scale z GPU MI355X. Microsoft uruchomił Instinct MI300X w produkcji na Azure dla modeli proprietary i open-source. Cohere wdraża swoje modele Command na MI300X.

Szczególnie interesująca jest kooperacja z Humain, która ma zbudować otwartą, skalowalną i efektywną kosztowo infrastrukturę AI wykorzystującą pełne spektrum platform obliczeniowych AMD. To sygnał, iż przyszłość AI nie musi być monopolizowana przez jednego dostawcę.

Efektywność energetyczna? 30×25 to dopiero początek

AMD nie tylko osiągnęło swój cel 30×25 (30-krotna poprawa efektywności energetycznej do 2025 roku), ale go przekroczyło, osiągając 38-krotną poprawę. To oznacza 97 proc. redukcję zużycia energii przy tej samej wydajności w porównaniu do systemów sprzed pięciu lat.

Ale AMD nie zamierza spocząć na laurach. Nowy cel to 20-krotna poprawa efektywności energetycznej na poziomie racka do 2030 r. W praktyce oznacza to, iż typowy model AI, który dziś wymaga ponad 275 racków do treningu, będzie mógł być wytrenowany w mniej niż jednym racku, zużywając 95 proc. mniej energii.

Co to oznacza w praktyce?

- Redukcja emisji CO2 z około 3000 do 100 ton metrycznych CO2 dla treningu modelu;

- Znaczące obniżenie kosztów operacyjnych centrów danych;

- Możliwość wdrażania AI na większą skalę bez proporcjonalnego wzrostu zużycia energii.

Przyszłość to seria MI400 i architektura Helios

AMD już teraz pokazuje karty na przyszłość, prezentując zapowiedź serii Instinct MI400 planowanej na 2026 r. najważniejsze cechy to:

- Do 432 GB pamięci HBM4;

- 19,6 TB/s przepustowości pamięci;

- 40 PFLOPS wydajności FP4 i 20 PFLOPS FP8;

- 300 GB/s przepustowości scale-out.

Razem z architekturą racka Helios, która zintegruje procesory Epyc Venice, GPU MI400 i karty sieciowe Pensando Vulcano, AMD kreśli wizję przyszłości, w której AI będzie jeszcze bardziej wydajne i dostępne.

Pierwsza karta sieciowa gotowa na Ultra Ethernet Consortium

AMD Pensando Pollara 400 AI NIC to pierwsza w branży karta sieciowa gotowa na standardy Ultra Ethernet Consortium. Oferuje

- 20 proc. lepszą wydajność RDMA w porównaniu do konkurencji;

- 25 proc. wyższą wydajność dzięki optymalizacjom systemu UEC;

- Pełną programowalność dzięki architekturze P4.

W świecie AI, gdzie komunikacja między GPU często stanowi wąskie gardło, takie ulepszenia mogą mieć najważniejsze znaczenie dla wydajności całego systemu.

Nowa era AI już się rozpoczęła

AMD Instinct MI350 wraz z ROCm 7 i AMD Developer Cloud to nie tylko kolejne produkty – to kompleksowa wizja przyszłości sztucznej inteligencji. Wizja, w której otwarte standardy przeważają nad zamkniętymi ekosystemami, efektywność energetyczna jest równie ważna co surowa wydajność, dostępność dla deweloperów nie jest ograniczona przez bariery finansowe a innowacje powstają dzięki współpracy, a nie monopolowi.

Czy AMD zdoła rzucić wyzwanie dominacji NVIDIA w segmencie AI? Sądząc po reakcji partnerów i imponujących specyfikacjach szanse są całkiem realne. A dla nas, entuzjastów technologii, najważniejsze jest to, iż mamy wybór – i konkurencja zawsze oznacza lepsze produkty dla wszystkich.

Seria MI350 będzie dostępna w drugiej połowie bieżącego roku, a AMD Developer Cloud jest już dostępny dla deweloperów na całym świecie. Czas pokaże, czy ta ofensywa AMD przyniesie oczekiwane rezultaty, ale jedno jest pewne – rynek AI właśnie stał się znacznie bardziej interesujący.