Nowe wieści z największych labów AI: Meta opublikowała nową Llamę, tym razem z numerkiem 4, za to OpenAI ostrzegł, iż GPT-5 nie nadejdzie na końcu maja, jak się dotąd spodziewano, ale raczej za kilka miesięcy. Za to w międzyczasie zobaczymy „rozumujące” modele o3 i o4-mini.

Dosłownie w dwa tygodnie po premierach Gemini 2.5 Pro od Google’a oraz DeepSeeka V3 z chińskiego labu AI, mamy kolejnego kandydata do czołówki w modelach sztucznej inteligencji. Długo oczekiwane modele Llama 4 w końcu się ukazały — w miniony weekend. Na razie dwa mniejsze, bo na największy jeszcze sobie poczekamy. Ale te „mniejsze” wcale nie są małe. Pamiętacie Llamy wielkości kilku miliardów parametrów, które można było uruchomić na zwykłej karcie graficznej przeciętnego peceta? Z nowymi modelami od Mety tak się nie da.

Meta opublikowała Llamę 4. Nie jest mała, ale dużo może

Tym razem modele Llama są naprawdę spore. Najmniejszy z nich, Scout, ma 109 milionów parametrów. Posiada architekturę mixture-of-experts, a więc taką, w której w fazie wnioskowania (ang. inference), czyli generowania treści, aktywna jest tylko część modelu — model podzielony jest na 16 tzw. ekspertów, z których tylko dwa są aktywne. Tak czy inaczej, do jego uruchomienia potrzeba karty H100 Nvidii — sprzętu serwerowego. Zdecydowanie jest to model do wykorzystania w chmurze.

Jedną z podstawowych zalet Scouta jest jego olbrzymie okno kontekstowe — to aż 10 mld tokenów, co pozwala na tworzenie podsumowań z obszernych zestawów dokumentów. Dotychczas okno kontekstowe przekraczające 1 mld tokenów oferowały wyłącznie modele od Google’a.

Drugi z udostępnionych modeli, Maverick, pozostało większy. Przy 400 mld parametrów jest równie duży jak dotychczas największy model Mety Llama 405B. To także model w architekturze mixture-of-experts z aż 128 ekspertami. Przy wnioskowaniu aktywni są tylko dwaj eksperci.

Maverick, w odróżnieniu od Scouta, jest modelem multimodalnym, co oznacza, iż może wnioskować na przykład z obrazków.

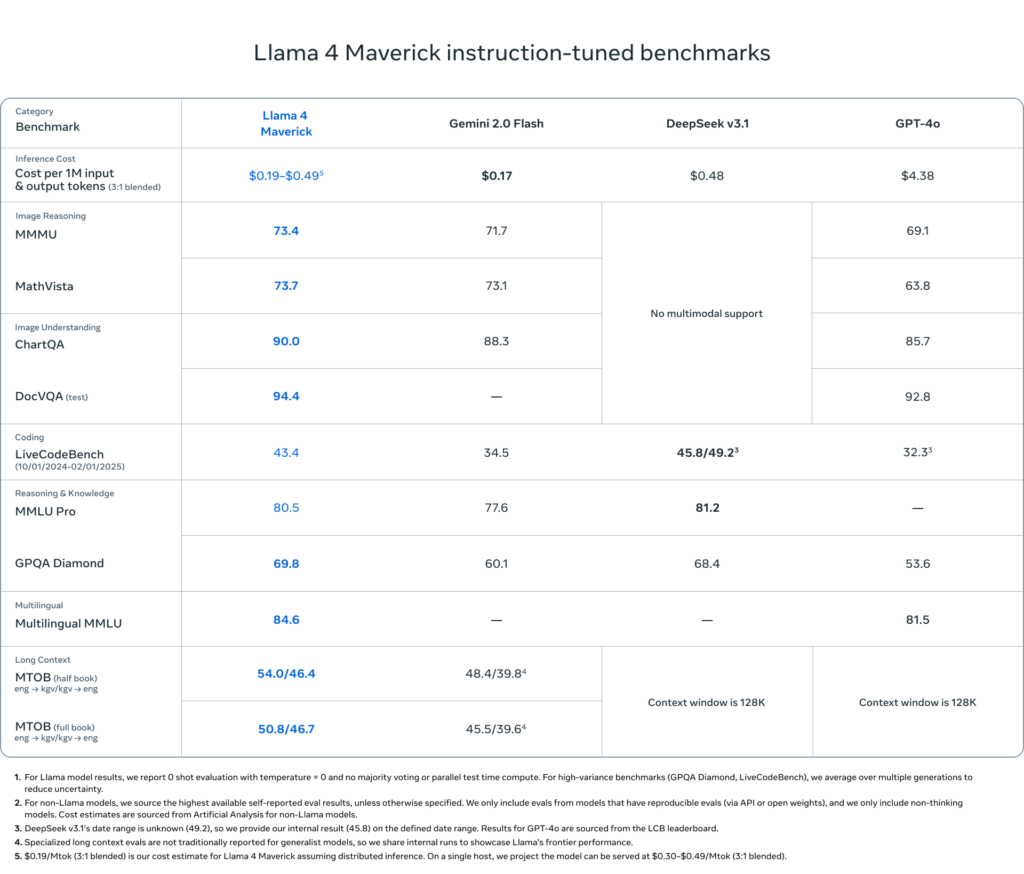

Musimy pamiętać, iż są to modele tradycyjne, a więc „nierozumujące”. I z takimi też modelami Meta porównuje swoje najnowsze produkty — Maverick jest porównywany z Gemini 2.0 Flash, DeepSeekiem-V3.1 i GPT-4o. I w tych porównaniach nowy model Mety wypada korzystnie. Podobnie jest w przypadku Scouta porównywanego do Gemmy 27B czy Mistrala 24B.

Źródło: Meta

Źródło: MetaWyniki te pokazują jednak, iż większy z modeli Mety jest istotnie w tyle za przodującym w tej chwili modelem „rozumującym” czyli Gemini 2.5 Pro, którego rezultaty były w porównywalnych kategoriach co najmniej o kilka punktów lepsze.

Należy jednak docenić fakt, iż Maverickowi udało się uzyskać na LM Arenie drugie miejsce, za Gemini 2.5, ale przed wieloma modelami „rozumującymi” – choćby jeżeli pojawiły się wątpliwości, czy model udostępniony na LM Arenie jest taki sam jak ten udostępniony deweloperom.

Meta zapowiada jeszcze jeden model, Behemoth, który będzie największy ze stajni Mety i z 2 bilionami parametrów będzie wyprzedzał rozmiarem GPT-4. Pojawiły się również sugestie, iż w najbliższym czasie zobaczymy model rozumujący od Mety.

Nie przegap najważniejszych trendów w technologiach!

Zarejestruj się, by otrzymywać nasz newsletter!

OpenAI opóźnia GPT-5

Równie dobrych wiadomości dla swoich fanów nie miało OpenAI. Jak się okazuje, prace nad GPT-5, a więc pierwszym modelem hybrydowym łączącym tryb tradycyjny z rozumującym, jeszcze trochę potrwają. Wcześniej sugerowano, iż model ukaże się pod koniec maja, teraz Sam Altman przyznaje, iż będzie to „za kilka miesięcy”.

Skąd ta zmiana? Okazało się, iż integracja wszystkiego jest trudniejsza, niż zakładano. Ponadto firma zakłada, iż nowy model będzie oznaczać istotnie zwiększone zapotrzebowanie na moce obliczeniowe i chce być na to przygotowany. To, iż integrowanie tradycyjnych modeli językowych z rozumującymi nie jest proste, pokazuje przykład modelu Claude 3.7 Sonnet od Anthropica, który na przykład na LM Arenie błąka się pod koniec drugiej dziesiątki rankingu, choć przez wiele miesięcy jego poprzednik Claude 3.5 Sonnet był jednym z ulubieńców świata AI.

W międzyczasie zobaczymy nowe modele rozumujące — pełną wersję o3 i miniaturową wersję modelu następnej generacji, czyli o4-mini. Te powinny się ukazać za kilka tygodni. Wtedy przekonamy się, czy Google’owi uda się utrzymać długo wyczekiwane prowadzenie w wyścigu modeli.

Źródło zdjęcia: Simon Wiedensohler/Unsplash