Zakrojone na szeroką skalę badanie Microsoftu pokazuje, iż większość z nas ocenia poprawnie kilka ponad połowę prezentowanych obrazów. To oznacza, iż w wielkiej grze prawdziwe czy sztuczne przegrywamy już na starcie.

Microsoft uruchomił internetowy quiz Real or Not?, w którym użytkownicy mieli 15 prób na wskazanie, czy widzą zdjęcie, czy grafikę wygenerowaną przez AI. Projekt miał oswajać opinię publiczną z faktem, iż deepfake’i to już internetowa codzienność.

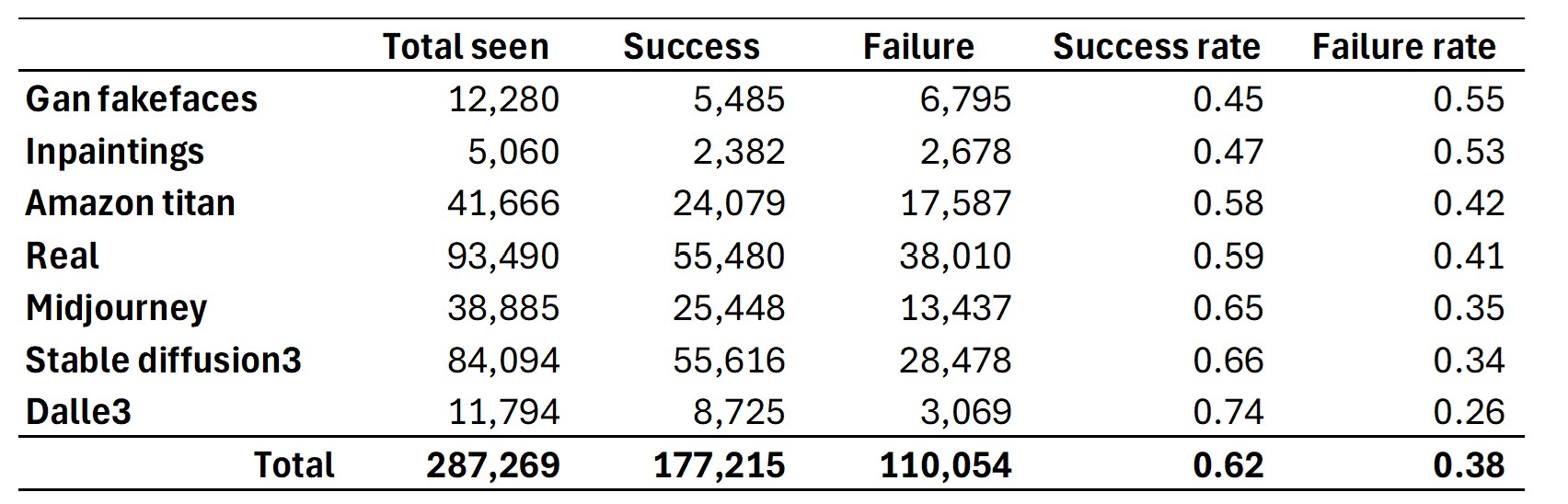

Wraz z premierą quizu firma zainicjowała badanie, w które włączyło się ponad 12,5 tys. osób z różnych krajów. Zebrano 287 tys. indywidualnych ocen pojedynczych kadrów – to największa jak dotąd próba empiryczna sprawdzająca zdolność ludzi do rozpoznawania syntetycznych obrazów w praktyce.

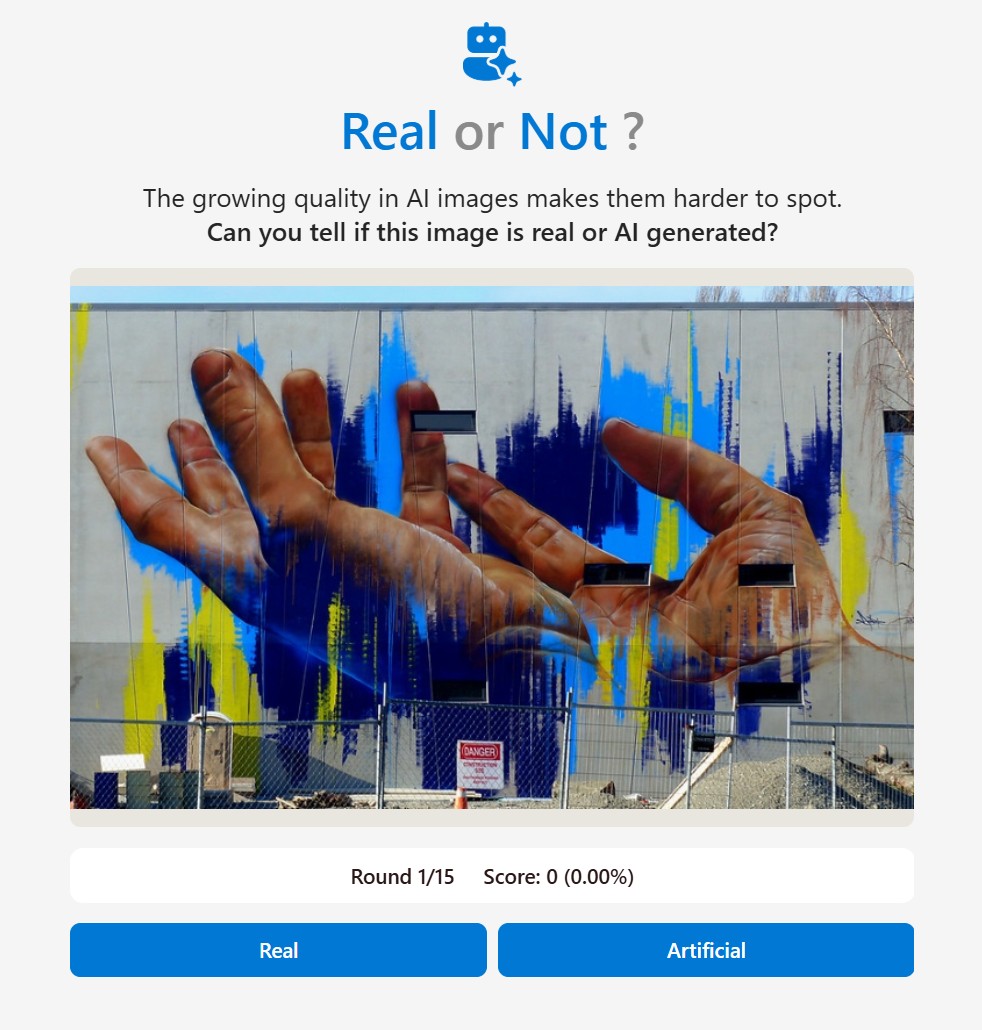

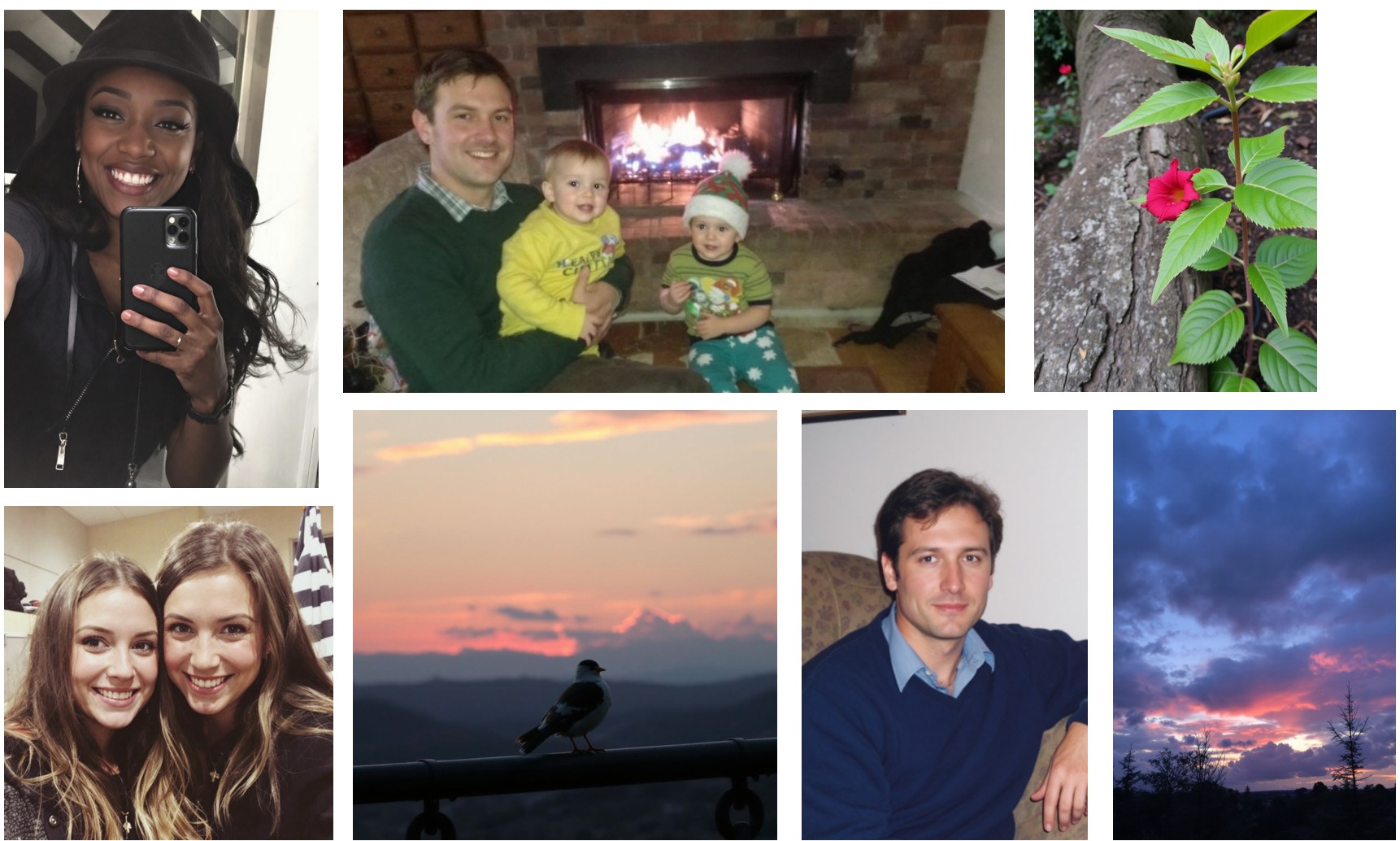

Jedno ze zdjęć prezentowanych w ramach Real or Not

Jedno ze zdjęć prezentowanych w ramach Real or NotWyniki obnażyły bolesną prawdę: średnia skuteczność wyniosła zaledwie 62 proc., czyli ledwie powyżej rzutu monetą. To surowy policzek dla naszej technologicznej pewności siebie – zwłaszcza gdy pamiętamy, iż systemy generatywne z każdym miesiącem stają się lepsze w maskowaniu własnych niedoskonałości.

Real or Not? – quiz, który obnaża złudzenia

Formuła zabawy jest zwodniczo prosta: patrzysz, klikasz, przechodzisz do następnego ujęcia. Kiedy jednak emocje opadną, większość uczestników odkrywa, iż intuicja zawodzi – szczególnie przy pozornie banalnych motywach typu zachód słońca nad miastem.

Skuteczność rozpoznawania fake’ów z podziałem na modele AI

Skuteczność rozpoznawania fake’ów z podziałem na modele AIAutorzy quizu specjalnie nie podkręcali trudności. W puli znalazły się zarówno zdjęcia amatorskie, jak i generatywne kreacje Midjourney czy DALL-E 3, ale bez ekstremalnych, hiperrealistycznych scen mających na celu zmylenie choćby zawodowych grafików. Każdy uczestnik oceniał maksymalnie kilkanaście kadrów; algorytm dbał o równą reprezentację kategorii (portret, natura, urbanistyka, żywność, przedmioty codzienne).

Odchylenie standardowe było niewielkie – ogromna większość ankietowanych mieściła się w przedziale 55-70 proc. Oznacza to, iż nie istnieje szeroka klasa ekspertów zdolna bezbłędnie demaskować deepfake’i – choćby pasjonaci fotoedycji mylą się niemal tak samo często jak statystyczny Kowalski-statystyczny.

Portrety łatwiejsze, krajobrazy prawie jak prawdziwe

Ludzie od najmłodszych lat są wyczuleni są na szczegóły wyglądu twarzy – to ewolucyjny radar pozwalający odczytać intencje i emocje. Nic więc dziwnego, iż portrety okazały się najmniej podchwytliwe – choć 35 proc. błędów to i tak sporo. W przypadku natury i panoram miejskich sprawy mają się odwrotnie: zdjęcie z drona nad fiordem czy nocny skyline Hongkongu nie zawiera zbyt wielu znajomych elementów, które mózg mógłby zweryfikować. Efekt? Nieznaczna większość ocen kończy się pomyłką.

Żadna z tych fotografii nie jest prawdziwa, wszystkie są tworem AI

Żadna z tych fotografii nie jest prawdziwa, wszystkie są tworem AIPsycholodzy poznawczy tłumaczą, iż wzrok ludzki zaprogramowano na szybkość, nie dokładność. Ewolucyjnie liczyło się dostrzeżenie drapieżnika w gąszczu, a nie analiza piksel po pikselu – dlatego skanujemy scenę od ogółu do szczegółu i łatwo przeoczamy subtelne anomalie typu tekst na szyldzie w nieistniejącym języku.

Sytuację pogarsza element presji czasu: w trybie quizu wiele osób klika po 2-3 s, by zaliczyć następny slajd. Badacze pokazali, iż już wydłużenie analizy do 10 s podnosi celność choćby o 8 pp., ale mało kto utrzyma taką dyscyplinę poza laboratorium. W realu scrollujemy znacznie szybciej, a więc przenosimy własną ułomność percepcji na X-a, Reddita i rodzinny czat WhatsAppa.

Algorytmy kontra człowiek – kto wygrywa?

Badacze przetestowali równolegle własny system wykrywania deepfake’ów oparty na hybrydzie cech statystycznych (DCT, SRM) i semantycznych embedów CLIP. Narzędzie osiągnęło ponad 95 proc. trafności na identycznej próbie obrazów.

Te zdjęcia są prawdziwe. Nie wygenerowało ich AI

Te zdjęcia są prawdziwe. Nie wygenerowało ich AIBrak pewności co do autentyczności zdjęć podważa fundamenty debaty publicznej. jeżeli każdy kadr może być iluzją, łatwiej włączyć tryb wszystko jest fejkiem, co paradoksalnie sprzyja szerzeniu nieprawdy – bo odbiorcy odrzucają również rzetelne materiały.

Microsoft, Adobe i kilkudziesięciu partnerów forsują standard Content Credentials, który dodaje kryptograficzne podpisy i historię edycji bezpośrednio do pliku. Gdy system wykryje, iż obraz przeszedł przez generatywny silnik flaguje go w metadanych C2PA, dzięki czemu portale społecznościowe mogą go odpowiednio oznaczyć.

Innym pomysłem są cyfrowe wodne znaki wbudowane w strukturę pikseli – trudno je usunąć bez degradacji jakości. Problem w tym, iż standardów jest wiele, a popularne platformy nie zawsze uznają te same sygnatury. Dopóki branża nie uzgodni wspólnego języka będziemy skazani na patchwork zabezpieczeń.

Jeżeli do tej pory wierzyliście, iż wprawne oko wystarczy, by wyłapać komputerowe fałszerstwo – statystyki studzą entuzjazm

62 proc. skuteczności oznacza dwa pudła na każdych pięć prób. Technologia rozwinęła się do punktu, w którym przeciętny internauta musi liczyć na dodatkowe wsparcie – czy to w postaci automatycznych detektorów, czy rosnącej kultury weryfikacji faktów. Do czasu aż globalne standardy znakowania i solidne regulacje staną się powszechne najprostszą tarczą pozostaje zdrowa dawka nieufności.