Pierwszy Międzynarodowy raport bezpieczeństwa AI zostanie wykorzystany do poinformowania o nadchodzących dyskusjach dyplomatycznych na temat sposobu złagodzenia różnych zagrożeń związanych ze sztuczną inteligencją (AI), ale podkreśla, iż istnieje przez cały czas wysoki stopień niepewności na temat dokładnej natury wielu zagrożeń i jak najlepiej z nimi poradzić sobie z nimi .

Zlecone po inauguracyjnym AI Safety Summit prowadzony przez rząd Wielkiej Brytanii w Bletchley Park W listopadzie 2023 r. – i kierowany przez AI Academic Yoshua Bengio – raport Obejmuje szeroki zakres zagrożeń, jakie stwarza technologia, w tym jej wpływ na miejsca pracy i środowisko, jej potencjał do rozprzestrzeniania cyberataków i głębokich szaf oraz sposób wzmocnienia uprzedzeń społecznych.

Bada także ryzyko związane z koncentracjami rynkowymi w sprawie AI i rosnące „AI Badania i Rozdanie [Research and Development] Podziel ”, ale ogranicza się do patrzenia na wszystkie te ryzyko w kontekście systemów, które mogą wykonywać wiele różnych zadań, znane również jako AI ogólne.

Dla każdego z wielu ocenianych ryzyka raport powstrzymał się od wyciągania ostatecznych wniosków, podkreślając wysoki stopień niepewności co do rozwoju gwałtownie poruszającej się technologii. Wezwało się do dalszego monitorowania i gromadzenia dowodów w każdym obszarze.

„Obecne dowody wskazują na dwa główne wyzwania w zarządzaniu ryzykiem ogólnym przeznaczonym”-powiedział. „Po pierwsze, trudno jest ustalić priorytety ryzyka ze względu na niepewność co do ich nasilenia i prawdopodobieństwa wystąpienia. Po drugie, określenie odpowiednich ról i obowiązków w łańcuchu wartości AI może być złożone oraz zachęcić do skutecznego działania. ”

Jednak raport jest jasny w swoim wniosku, iż wszystkie potencjalne przyszłe skutki przedstawione przez AI IT są przede wszystkim kwestią polityczną, które będą określone przez wybory społeczeństw i rządów.

„Jak opracowuje się ogólna sztuczna inteligencja i przez kogo, które problemy mają na celu rozwiązanie, czy będziemy w stanie czerpać jego pełny potencjał ekonomiczny, który z niego korzysta, oraz rodzaje ryzyka, na które się narazujemy-odpowiedzi na odpowiedzi Te i wiele innych pytań zależą od wyborów, które społeczeństwa i rządy dokonują dziś iw przyszłości, aby ukształtować rozwój ogólnej sztucznej inteligencji ”, powiedział, dodając, iż istnieje pilna potrzeba międzynarodowej współpracy i porozumienia w tych kwestiach.

„Konstruktywna dyskusja naukowa i publiczna będzie niezbędna dla społeczeństw i decydentów, aby dokonać adekwatnych wyborów”.

Ustalenia raportu – które opierają się na Tymczasowy raport bezpieczeństwa AI Wydany w maju 2024 r., Który wykazał brak eksperckiej zgody na największe ryzyko – mają na celu poinformowanie o dyskusji na nadchodzącym szczycie akcji AI we Francji, na początku lutego 2025 r., Który wynika z dwóch poprzednich szczytów w Bletchley i Seul, Korea Południowa.

„Sztuczna inteligencja jest centralnym tematem naszych czasów, a jej bezpieczeństwo jest kluczowym fundamentem budowania zaufania i wspierania adopcji. Badania naukowe muszą pozostać fundamentalnym filarem prowadzącym te wysiłki ” – powiedziała Clara Chappaz, delegat francuskiego ministra ds. AI i technologii cyfrowych.

„Ta pierwsza kompleksowa ocena naukowa dostarcza bazy dowodów potrzebnych dla społeczeństw i rządów do odpowiedzialnego ukształtowania przyszłego kierunku AI. Te spostrzeżenia będą informować o kluczowych dyskusjach na nadchodzącym szczycie akcji AI w Paryżu. ”

Ryzyko systemowe

Badając szersze ryzyko społeczne wdrażania sztucznej inteligencji – poza możliwościami każdego indywidualnego modelu – raport stwierdził, iż wpływ na rynki pracy jest „prawdopodobnie głębokie”.

Zauważył, iż chociaż istnieje znaczna niepewność w tym, jak AI wpłynie na rynki pracy, korzyści z produktywności generowania technologii „prawdopodobnie doprowadzą do mieszanych efektów na wynagrodzenie w różnych sektorach, zwiększając płace niektórych pracowników, jednocześnie obniżając płace dla innych”, z najważniejszym wpływem krótkoterminowym na miejsca pracy, które składają się głównie z zadań poznawczych.

Ulepszone możliwości AI ogólnego zastosowania prawdopodobnie zwiększą obecne ryzyko dla autonomii i dobrego samopoczucia pracowników, jak powiedział, podkreślając szkodliwe efekty „ciągłe monitorowanie i decyzje dotyczące obciążenia Ai-opartą na AI” mogą mieć, mogą mieć, szczególnie dla pracowników logistycznych.

Zgodnie z styczeń 2024 Ocena wpływu AI na nierówność przez Międzynarodowy Fundusz Walutowy (MFW)-który stwierdził, iż AI może pogorszyć nierówność bez interwencji politycznej-raport powiedział: „Automatyzacja pracy opartej na AI prawdopodobnie zaostrzy nierówność, zmniejszając udział wszystkich dochodów, które trafiają do pracowników w stosunku do właścicieli kapitału”.

Nierówność można dalej pogłębić w wyniku tego, co określa raport „podział badań i rozwoju AI”, w którym rozwój technologii jest wysoce skoncentrowany w rękach dużych państw położonych w krajach o silnej infrastrukturze cyfrowej.

„Na przykład w 2023 r. W USA opracowano większość godnych uwagi modeli AI (56%). Ta różnica ujawnia wiele LMIC [low- and middle-income countries] na ryzyko zależności i może zaostrzyć istniejące nierówności ”, powiedział, dodając, iż koszty rozwoju mają jedynie rosnąć, zaostrzając ten podział.

Raport podkreślił również rosnący trend „Ghost Work”, który odnosi się do Przeważnie ukryta siła robocza wykonywana przez pracowników -Często w niepewnych warunkach w krajach o niskich dochodach-w celu wsparcia rozwoju modeli AI. Dodał, iż chociaż praca ta może zapewnić ludziom możliwości ekonomiczne, „charakter tej pracy w stylu kontraktowym często zapewnia kilka korzyści i ochrony pracowników oraz mniejszą stabilność pracy, ponieważ platformy obracają rynki, aby znaleźć tańszą pracę”.

Z tym wszystkim związane jest „wysoki stopień” koncentracji rynkowej wokół sztucznej inteligencji, co pozwala niewielkim garstce potężnych firm dominować w podejmowaniu decyzji dotyczących rozwoju i wykorzystania technologii.

Na temat wpływu na środowiskoRaport zauważono, podczas gdy operatorzy centrum danych coraz częściej zwracają się do odnawialnych źródeł energii, znaczna część szkolenia AI na całym świecie przez cały czas opiera się na źródłach energii o wysokiej zawartości węgla, takich jak węgiel lub gaz ziemny, a także zużywa znaczne ilości wody.

Dodał, iż poprawa wydajności samego sprzętu związanego z AI „nie negowała ogólnego wzrostu zużycia energii przez AI i być może dodatkowo przyspieszają ją z powodu„ efektów odbicia ””, ale „obecne liczby w dużej mierze opierają się na szacunkach, które stają się jeszcze bardziej, które stają się jeszcze bardziej zmienne i zawodne po ekstrapolowaniu w przyszłości ze względu na szybkie tempo rozwoju w terenie ”.

Ryzyko z awarii

Podkreślając „konkretne szkody”, które AI może powodować w wyniku jej potencjału do wzmocnienia istniejących uprzedzeń politycznych i społecznych, raport stwierdził, iż „może prowadzić do wyników dyskryminacyjnych, w tym nierównego alokacji zasobów, wzmocnienia stereotypów i systematycznego zaniedbania niektórych grup lub punkty widzenia ”.

W szczególności zauważył, w jaki sposób większość systemów AI jest szkolona w zakresie zestawów danych dotyczących języka i obrazów nieproporcjonalnie reprezentują kultury anglojęzyczne i zachodnieże wiele wyborów projektowych jest zgodnych z poszczególnymi światopoglądami kosztem innych, a obecne techniki łagodzenia stronniczości są niewiarygodne.

“Holistyczne i partycypacyjne podejście Obejmuje to różnorodne perspektywy, a interesariusze są niezbędne do złagodzenia stronniczości ” – powiedział.

Powtórzenie wyników raportu okresowego dotyczącego ludzkiej utraty kontroli systemów AI-których niektórzy martwią, może spowodować zdarzenie na poziomie wyginięcia-raport potwierdził takie obawy, ale zauważył, iż opinia jest bardzo różna.

„Niektórzy uważają to za nieprawdopodobne, niektórzy uważają, iż może to nastąpić, a niektórzy uważają to za skromne ryzyko, które wymaga uwagi ze względu na wysoką ciężkość” – powiedział. „Bardziej podstawowo, presja konkurencyjna może częściowo określić ryzyko utraty kontroli… [because] Konkurencja między firmami lub między krajami może doprowadzić ich do zaakceptowania większego ryzyka, aby pozostać wyprzedzeniem. ”

Ryzyko z złośliwego użytkowania

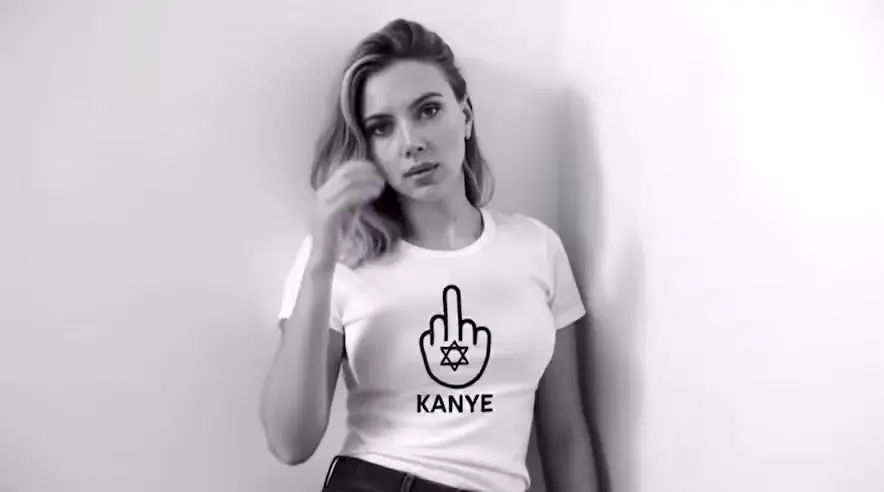

Pod względem złośliwego używania sztucznej inteligencji w raporcie podkreślono problemy związane z bezpieczeństwem cybernetycznym, głębokich szaf i jego użyciem w rozwoju broni biologicznej lub chemicznej.

Na głębokich szafkach odnotowano szczególnie szkodliwy wpływ na dzieci i kobiety, które mają wyraźne zagrożenie związane z wykorzystywaniem seksualnym i przemocą.

„Obecne metody wykrywania i techniki znakowania wodnego, jednocześnie postępując, wykazują mieszane wyniki i stają przed utrzymującymi się wyzwaniami technicznymi”, powiedział. „Oznacza to, iż w tej chwili nie ma pojedynczego solidnego rozwiązania do wykrywania i zmniejszania rozprzestrzeniania się szkodliwej zawartości wygenerowanej przez AI. Wreszcie szybki rozwój technologii AI często wyprzedza metody wykrywania, podkreślając potencjalne ograniczenia polegania wyłącznie na interwencjach technicznych i reaktywnych. ”

W przypadku bezpieczeństwa cybernetycznego zauważono, iż podczas gdy systemy AI wykazały znaczny postęp w autonomicznym identyfikacji i wykorzystywaniu luk w lukach cybernetycznych, ryzyko te są zasadniczo możliwe do zarządzania, ponieważ AI można również stosować defensywnie.

„Szybkie postępy w możliwościach utrudniają wykluczenie ryzyka na dużą skalę w najbliższym czasie, podkreślając w ten sposób potrzebę oceny i monitorowania tych zagrożeń”, powiedział. „Konieczne są lepsze wskaźniki, aby zrozumieć scenariusze ataku w świecie rzeczywistym, szczególnie gdy ludzie i AI pracują razem. Krytycznym wyzwaniem jest łagodzenie możliwości ofensywnych bez uszczerbku dla zastosowań obronnych. ”

Dodał, iż chociaż nowe modele AI mogą tworzyć przewodniki krok po kroku do tworzenia patogenów i toksyn, które przewyższają wiedzę na poziomie doktora, potencjalnie przyczyniając się do obniżenia barier w rozwoju broni biologicznej lub chemicznej, pozostaje on „technicznie złożonym” procesem ” , co oznacza „praktyczna użyteczność dla nowicjuszy pozostaje niepewna”.