Wielu może odnieść wrażenie, iż w ostatnich latach coraz ciężej jest nadążyć za tym, co się dzieje na świecie, a przede wszystkim za szybkością zmian na rynku pracy. O ile świat IT zawsze charakteryzował się szerokim zakresem stanowisk, technologii i możliwości rozwoju, to są pewne elementy tech stacku, które z roku na rok zyskują na sile, bądź utrzymują się stabilnie. Zastanówmy się, jak może wyglądać praca w IT w 2025 pod kątem jednych z najlepiej płatnych stanowisk takich jak m.in. DevOps Engineer, SysOps Engineer, Site Reliability Engineer, Cloud Engineer, Automation Engineer, Software Engineer i czy warto uczyć się takich technologii jak chmura, IaC, CaC?

Przeanalizowałam aktualną sytuację na rynku pracy wokół technologii chmurowych, IaC, CaC, aby zweryfikować co tak naprawdę warto znać, by zostać poszukiwanym specjalistą w IT. Porównałam te wyniki z raportami i analizami ogólnie panujących trendów na rynku w tym zakresie.

Wnioski są ciekawe, także zapraszam do analizy!

Praca w IT w 2025 – Której chmury warto się uczyć?

Odwieczne pytanie każdej osoby nowej w świecie chmur to “Od jakiej chmury rozpocząć naukę?” Kiedyś odpowiedź była jasna – AWS. Amazon był liderem na rynku dostawców chmurowych, ponieważ jako jeden z pierwszych zaczął tworzyć tego typu usługi. A jak to wygląda dzisiaj?

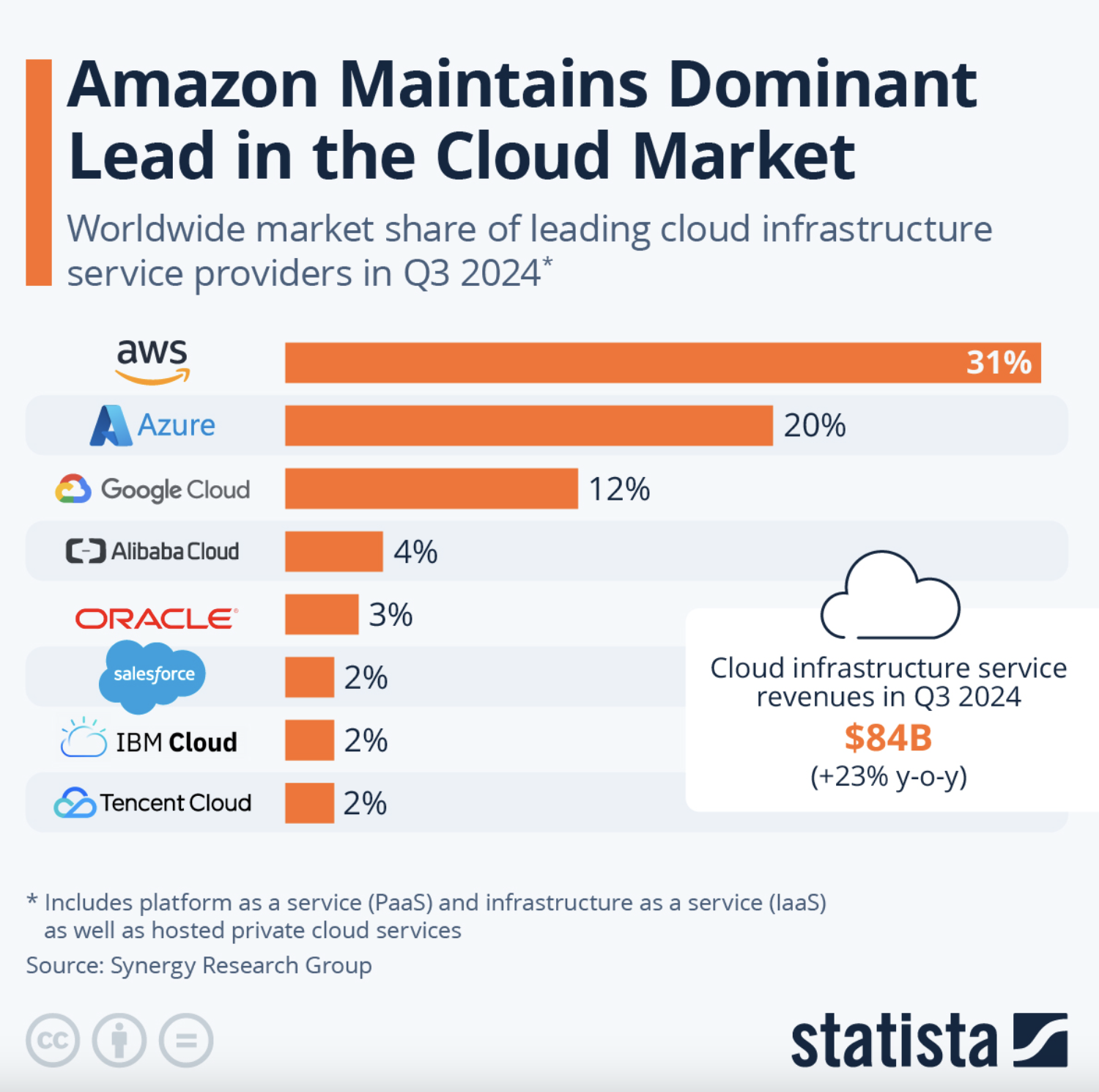

Zgodnie z raportem Statista, Amazon przez cały czas przoduje jeżeli chodzi o podział udziałów na rynku infrastruktury chmurowej.

Nie powinno nas to dziwić biorąc pod uwagę m.in. to, ile lat AWS jest na rynku.

Jednak by przewidzieć potencjalną przyszłość dostawców chmurowych w kolejnych miesiącach/latach, powinniśmy popatrzeć na to z perspektywy wzrostów co kwartał każdego roku i przeanalizować, w przypadku jakiej chmury wzrosty w ostatnim czasie są najbardziej dynamiczne.

Porównując dane z trzeciego kwartału 2024 roku powyżej z danymi z roku 2023 możemy zauważyć spory wzrost udziałów w rynku chmury Microsoft Azure.

Wzrosty dostawców chmury, takich jak Google Cloud, AWS i Microsoft Azure, są w dużej mierze napędzane przez rozwój technologii sztucznej inteligencji (AI) oraz ich wdrażanie w ramach chmurowych usług AI/ML.

Kluczowe rozwiązania, które mogą mieć wpływ na wzrosty w tych trzech prowadzących w statystykach chmurach to m.in.:

- Amazon Bedrock, który umożliwia łatwe wdrażanie i dostosowywanie foundation models od dostawców takich jak Anthropic (Claude), AI21 Labs, Stability AI i własnego Titan AI.

- Azure OpenAI Service pozwala na dostęp do GPT-4, DALL-E, Codex i innych modeli OpenAI z integracją w ramach ekosystemu Microsoft (np. Copilot dla Office 365 i GitHub Copilot).

- Google Cloud Vertex AI + Gemini AI to z kolei w pełni zarządzana platforma do tworzenia modeli AI, w tym dostęp do modeli Google Gemini i PaLM 2.

Oferty pracy odzwierciedlają mniej więcej to, co pokazują statystyki.

Znalazłam ponad 3000 ofert pracy ze znajomością chmury AWS (2940 wyników dla AWS, 218 wyników dla Amazon Web Service), około 2863 ofert z chmurą Azure i około 2500 ofert z chmurą GCP (1491 wyników dla GCP, 1063 wyników dla Google Cloud).

Którą chmurę wybrać?

Podsumowując, trudno przewidzieć, jak będzie wyglądał rynek w przeciągu najbliższych lat. Warto śledzić rozwój technologii opartych o AI u każdego dostawcy. Znajomość Amazona jest dobrym wyborem, ale chmura Azure i Google mają duży potencjał do wzrostów w przyszłości i mogą prześcignąć lub wyrównać udziały na rynku w odniesieniu do chmury Amazon.

Znając przynajmniej dwie, a najlepiej trzy topowe chmury, otwieramy sobie drogę do ogromnych możliwości w kontekście poszukiwania pracy (bardzo dużo ofert pracy), a także zmniejszamy konkurencję w trakcie procesu rekrutacji.

Automatyzacja infrastruktury a praca w IT w 2025

Automatyzacja to zdecydowanie coś bez czego aktualnie nie obejdziemy się na technicznych stanowiskach, jeżeli chodzi o pracę w IT w 2025. Developerzy muszą orientować się w narzędziach CI/CD, sieciowcy muszą korzystać ze skryptów i narzędzi do automatyzacji sieci, spece od cyberbezpieczeństwa muszą automatyzować procesy detekcji zagrożeń, osoby pracujące z chmurą nie wyklikują już niczego w GUI, bo są do tego świetne narzędzia do automatyzacji.

Configuration as Code

Ansible przez cały czas utrzymuje się wysoko w statystykach jeżeli chodzi o najczęściej wykorzystywane narzędzie do automatyzacji konfiguracji.

Na portalu JustJoinIT odnotowałam 632 oferty, gdzie ta technologia została wymieniona.

Inne alternatywy takie jak Puppet (168 ofert) czy Chef (136 ofert) pomimo tego, iż są równie ciekawymi narzędziami to nie są głównym wyborem w większości firm. Być może jeden z faktów, iż Ansible jest napisany w Pythonie powoduje, iż firmy się na niego decydują, ponieważ dużo łatwiej jest znaleźć specjalistę ze znajomością Pythona niż Ruby (Puppet i Chef).

Infrastructure as Code

Przejdźmy do omówienia sytuacji odnośnie narzędzi skupionych na tworzeniu infrastruktury.

AWS CloudFormation to narzędzie dedykowane chmurze Amazon, które pojawiło się w 88 ofertach. Pomimo tego, iż jest to świetne narzędzie do tworzenia infrastruktury w chmurze AWS, to jednak patrząc na znajomość tego narzędzia z punktu możliwości zatrudnienia, lepszą opcją byłby wybór narzędzia cloud-agnostic czyli takiego, którym da się zarządzać infrastrukturą w wielu chmurach.

Podobna sytuacja jest z narzędziem dedykowanym chmurze Azure czyli Azure ARM, które pojawiło się w 70 ofertach pracy.

Terraform został stworzony jako alternatywa dla AWS CloudFormation, by można było zarządzać wieloma chmurami, a nie tylko chmurą Amazon.

Z punktu widzenia osoby, która chce w przyszłości pracować z kilkoma chmurami czy po prostu chce mieć większy zakres ofert pracy do wyboru, Terraform jest dobrym strzałem. Potwierdzają to statystyki na portalu JustJoinIT, gdzie Terraform pojawia się w 1021 ofertach pracy.

Kolejnym ciekawym narzędziem jest Pulumi, jednak przez cały czas nie jest ono jeszcze tak rozpowszechnione jak inne i pojawia się w 34 ofertach.

Zwróćcie uwagę również na to, iż to jak długo technologia jest na rynku ma duże znaczenie. Dobrym porównaniem jest Terraform i OpenTofu.

Terraform jest na rynku od około 7 lat. Wiele dużych firm wdrożyło go do tworzenia swojej kluczowej infrastruktury i nawet, gdy na rynku pojawiają się kolejne alternatywy takie jak Pulumi czy OpenTofu to wiele firmom nie będzie się opłacało inwestować czasu w migrację do nowego narzędzia, dlatego ta technologia może pozostać z nami na wiele lat.

Co prawda są sygnały, iż Terraform może przejść w formę płatną jednak nic nie pozostało przesądzone, nie ma też informacji jaka byłaby to opłata, a co więcej choćby jeżeli firmy zdecydowały by się na migrację z Terraforma do innej technologii to przez cały czas będą potrzebować do tego ludzi ze znajomością tego narzędzia. OpenTofu jest forkiem Terraforma, który pojawił się w zeszłym roku i ma być alternatywa dla płatnego Terraforma, dlatego patrząc przyszłościowo, być może warto rozważyć zapoznanie się z tym narzędziem. Dla osób znających Terraforma, migracja do OpenTofu będzie banalnie prosta na tym etapie i jest to kolejny powód dla którego znajomość Terraforma może być dobrym wyborem patrząc długofalowo na rynek pracy.

Praca w IT w 2025 – Czy warto uczyć się sieci, by ją zdobyć?

Zaczynając pracę w IT nie znałam się na sieciach. Skupiałam się na nauce Linuxa, różnych narzędzi do automatyzacji, programowania w Pythonie i tworzeniu skryptów w Bashu. Wiedziałam jak wystawić prostą stronę w Internecie, puścić pinga i pare innych podstawowym rzeczy.

Jednak z czasem zauważyłam, iż sieci to był temat, który rozumiało zwykle tylko pare osób w firmie. Wiedziały jak skomunikować ze sobą kilka usług, kiedy stworzyć i wykorzystać konkretny typ load balancera, kiedy przyda się reverse proxy, NAT, routing statyczny lub dynamiczny, jak skonfigurować serwer VPN. Pomimo tego, iż sieci to ta część wiedzy IT, która w większości nie zmienia się tak dynamicznie jak frameworki w językach programowania to kilka ludzi ją rozumiało.

Okazuje się, iż osoby które posiadają wiedzę z sieci i potrafią połączyć ją z umiejętnością automatyzacji, zrozumienia cloud computing, Kubernetesa, zrozumienia architektury np. pracy w dużą ilością zależnych od siebie mikroserwisów są niezwykle cenne, bo są w stanie rozwiązywać bardzo kompleksowe problemy.

Na hasło networking pojawiło się około 600 ofert pracy, co pokazuje, iż jest całkiem spore zapotrzebowanie na osoby znające te zagadnienia.

Co interesujące przekrój ofert w jakich wymagana była znajomość sieci był bardzo szeroki, m.in:

- Penetration Tester

- Software Developer

- Java Developer

- DevOps Engineer

- Technical Escalation Engineer

- First Line Support Engineer

- Cloud Architect

- Cloud Engineer

- Technical Solutions Engineer

- Linux System Administrator

- Site Reliability Engineer

- Infrastructure Engineer

Kubernetes nie tylko dla DevOpsa

Kubernetes poza tym, iż jest modnym słowem przez ostatnie lata, pojawia się w coraz szerszym zakresie już nie tylko w ofertach dla DevOps inżynierów czy specjalistów od chmury, ale choćby na stanowiskach programistycznych. Oczywiście stopień jego znajomości na danych stanowiskach się różni, jednak nie zmienia to faktu, iż zamiast czekać aż jego sława przeminie, lepiej spróbować się z nim zaprzyjaźnić.

Na hasło K8S pojawiło się 110 ofert, a na hasło Kubernetes 2054 oferty.

Ponadto, pojawia się coraz więcej ofert pracy na stanowiska Kubernetes Engineer czy Kubernetes Administrator, co pokazuje, iż jest to na tyle duże i kompleksowe narzędzie, iż osoby specjalizujące się w nim mogą być w przyszłości coraz bardziej poszukiwani.

Możecie zapytać “Ale w jakiej chmurze specjalizować się jeżeli chodzi o Kubernetesa – GKE, AKS, EKS?”

Odpowiem, iż to nie ma wielkiego znaczenia. Może kierować się powyższymi statystykami odnośnie chmury i wybrać tego najbardziej popularnego.

Warto jednak pamiętać, iż twórcą Kubernetesa jest firma Google, dlatego w chmurze GCP tworzenie klastrów i zarządzanie nimi jest stosunkowo łatwe w porównaniu z innymi dostawcami. jeżeli dopiero zaczynasz naukę, możesz zatem wybrać usługę GKE czyli klaster Kubernetes w chmurze Google.

Jak wyglądały moje początki?

Na początku mojej kariery zawodowej w świecie IT pracowałam jako wsparcie aplikacji, administrator Linuxa, junior SysOps inżynier. Uczyłam się różnych narzędzi, technologii, ale brakowało mi wiedzy jak łączyć ze sobą te wszystkie klocki. Czasami nie do końca potrafiłam też debugować złożone problemy w infrastrukturze i kodzie.

Pracując jako DevOps inżynier napotkałam kolejne problemy. Co firma to potrzeba znajomości innej chmury i zdarzało się, iż choćby znając dobrze jednego z topowych dostawców, nie udawało mi się zdobyć pracy w firmach, które mnie interesowały. Powodem był brak znajomości innych wymaganych chmur, a co za tym idzie – firma nie mogła zaoferować mi górnych widełek z tego samego powodu.

Brakowało mi szkolenia, gdzie mogłabym:

- nauczyć się 3 chmur na raz,

- podszlifować swoją umiejętność automatyzacji dzięki Terraform i Ansible,

- zobaczyć, jak tworzy się różne usługi w chmurze, a nie tylko to co znałam ze swojej pracy,

- dowiedzieć się, jak tworzyć kompleksowe infrastruktury czyli stworzyć aplikację, ukryć ją za load balancerem czy połączyć ją z baza danych.

Czy dało się coś z tym zrobić? Jeszcze nie tak dawno przyznałabym, iż niestety nie – trzeba uczyć się na własną rękę z różnych źródeł. Dziś jednak mogę powiedzieć, iż jeżeli borykacie się z podobnymi problemami lub chcecie ułatwić sobie znalezienie pracy, śmiało możecie sprawdzić, jakie projekty wykonacie w trakcie TF Maestro – programu, którego jestem mentorem.

Projekt 1: Naucz się integrować elementy infrastruktury

Stwórz sieć VPC lub VNet

Utwórz maszyny wirtualne na Linuxie

Zabezpiecz sieć dzięki firewalla

Wdróż aplikację Python przy użyciu Ansible

Utwórz bazę danych MySQL

Połącz aplikację Python z bazą danych

Zapewnij wysoką dostępność i dodatkową warstwę bezpieczeństwa dzięki load balancerom przed aplikacją

Projekt 2: Wystaw aplikację w Kubernetes w bezpieczny sposób

Utwórz klaster Kubernetes

Wdróż prostą aplikację przy użyciu Helm

Wystaw aplikację przy pomocy load balancera

Projekt 3: Automatyzacja przy użyciu Terraform i Ansible

Stwórz wszystkie wymienione usługi w chmurze przy użyciu Terraform

Skonfiguruj maszynę wirtualną dzięki Ansible (tworzenie użytkowników, wdrażanie i konfiguracja aplikacji, instalowanie pakietów i inne)

Naucz się zarządzać dużym kodem przy pomocy Terragrunt

Stwórz Cloud Storage, aby zabezpieczyć pliki stanu

Poznaj najlepsze praktyki pisania kodu

Przetestuj swój kod przy użyciu darmowych narzędzi

Przeprowadź analizę bezpieczeństwa kodu

Projekt 4: Zabezpieczanie infrastruktury

Naucz się najlepszych praktyk dotyczących bezpieczeństwa w chmurze

Zabezpiecz maszyny wirtualne dzięki kluczy SSH

Naucz się analizować bezpieczeństwo kodu

Skonfiguruj reguły firewalla

Wykorzystaj menedżery sekretów w kodzie

Projekt 5: Migracja Terraform do OpenTofu

Poznaj alternatywne narzędzie dla Terraform czyli OpenTofu

Zmigruj kod Terraform do OpenTofu

Projekt 6: Wdrożenie statycznej strony w Cloud Storage

Utwórz Cloud Storage (np. S3 bucket)

Wdróż prostą stronę HTML + CSS (np. maintenance page)

Udostępnij ją w Internecie

Projekt 7: Poznaj 3 największych dostawców chmury

Twórz usługi w MS Azure, Google Cloud i AWS, takie jak:

- bazy danych

- klastry Kubernetes

- load balancery

- VPCs i VNets

- firewalle

- maszyny wirtualne

Poznaj różnice między MS Azure, Google Cloud i AWS

Projekt 8: Naucz się troubleshootingu

Rozwiązywanie problemów z:

- połączeniami między usługami

- błędami aplikacji

- błędami w Linuxie

- błędami Terraform

- problemami związanymi z dostawcami chmurowymi

Gdybym miała dostęp do tej wiedzy lata wstecz, zyskałabym nie tylko czas, ale także wiele cennych umiejętności, które ułatwiłyby mi znalezienie pracy. Kolejna edycja projektu TF Maestro rusza już w najbliższym czasie, warto być na bieżąco.

Chcesz zrozumieć, jak tworzyć infrastrukturę z Terraform i OpenTofu w AWS, Azure, Google Cloud?

TF Maestro to wiedza o tworzeniu i zarządzaniu infrastrukturą, która pomoże Ci zrozumieć, jak tworzyć infrastrukturę z Terraform i OpenTofu w trzech topowych chmurach: AWS, Azure, Google Cloud. Sprawdź szczegóły i pobierz bezpłatny e-book 10 Praktycznych Przypadków Użycia Terraform i OpenTofu.Z e-booka dowiesz się, jak działa Terraform i OpenTofu, ale także, na co zwracać uwagę, by uniknąć pułapek i błędów początkujących. To kopalnia użytecznych wskazówek w przystępnej formie.

Podsumowanie. Praca w IT w 2025 – czy to idealny czas na rozwój?

Analizując obecną sytuację na rynku IT oraz prognozy na najbliższy czas, możemy zauważyć, jak może wyglądać praca w IT w 2025 roku, a także dojść do kilku kluczowych wniosków.

Po pierwsze, technologie chmurowe przez cały czas będą odgrywać istotną rolę w kształtowaniu rynku pracy. Znajomość topowych dostawców chmury – AWS, Azure i Google Cloud – otwiera szerokie możliwości zatrudnienia i zwiększa konkurencyjność na rynku. Warto inwestować w naukę co najmniej dwóch z tych platform, aby zwiększyć swoją atrakcyjność dla pracodawców.

Drugim istotnym trendem jest rosnąca rola automatyzacji w zarządzaniu infrastrukturą IT. Narzędzia takie jak Terraform, Ansible czy Kubernetes stają się standardem w wielu firmach, a ich znajomość to w tej chwili niemal obowiązek dla specjalistów DevOps, Cloud Engineerów czy Site Reliability Engineerów.

W szczególności Terraform zyskał ogromną popularność jako rozwiązanie cloud-agnostic, co czyni go bezpiecznym wyborem na przyszłość.

Nie można również zapominać o znaczeniu umiejętności sieciowych, które choć nie zmieniają się tak dynamicznie jak języki programowania, pozostają najważniejsze dla wielu stanowisk technicznych. Osoby łączące wiedzę z zakresu sieci, chmury oraz automatyzacji są coraz bardziej poszukiwane na rynku pracy.

Kubernetes z kolei staje się coraz bardziej wszechstronną platformą, wykorzystywaną nie tylko przez DevOpsów, ale również przez programistów i architektów chmurowych. Jego rosnąca popularność sugeruje, iż warto poświęcić czas na naukę tego narzędzia, niezależnie od konkretnego dostawcy chmurowego.

Podsumowując, praca w IT w 2025 roku będzie wymagała od specjalistów nie tylko znajomości konkretnej technologii, ale również umiejętności łączenia różnych dziedzin i narzędzi. najważniejsze kompetencje to:

- Znajomość co najmniej dwóch platform chmurowych (AWS, Azure, GCP),

- Umiejętność pracy z narzędziami automatyzacji (Terraform, Ansible, CI/CD),

- Podstawowa i zaawansowana wiedza sieciowa,

- Zrozumienie i umiejętność pracy z Kubernetesem,

- Umiejętność dostosowania się do dynamicznych zmian w technologii.

Inwestowanie w te obszary to najlepsza strategia dla wszystkich, kto chce rozwijać się w IT i być gotowym na wyzwania przyszłości!

Autor

Katarzyna Brzozowska— mentorka programu TF Maestro, inżynier DevSecOps z technicznym zapleczem jako administrator Linuxa, SysOps inżynier i DevOps inżynier. Specjalizuje się w cyberbezpieczeństwie, automatyzacji, rozwiązanich chmurowych. Prowadzi organizację Be Like Neo & Trinity, której ideą jest wsparcie w karierze IT poprzez mentoring, a także dzielenie się wiedzą z zakresu technologii szczególnie skupiając się na tematach związanych z DevOps oraz cyberbezpieczeństwem. Po godzinach Kasia współpracuje z organizacjami Girls Code Fun i Nerds Coding Gang jako mentorka, a także dzieli się wiedzą na wydarzeniach branżowych, takich jak festiwal KubeDevSec, konferencja Secure czy Infoshare.