Rumuńscy kolejarze mieli manipulować systemem rezerwacji i na lewo sprzedawać bilety. Gdy zainteresowała się nimi prokuratura, linię obrony zaczęli budować wraz z chatbotem.

Internet zna historie przynajmniej kilku adwokatów, którzy w swojej pracy nadmiernie zaufali generatywnej AI. Teraz szlaki dla drugiej strony sali sądowej przecierają rumuńscy kolejarze, którzy – według prokuratury – próbowali wykorzystać ChatGPT jako źródło podpowiedzi, jak bronić się przed zarzutami korupcyjnymi i oszustw związanych ze sprzedażą biletów.

W obliczu oskarżeń o poważne przestępstwo, rumuńscy kolejarze poprosili o pomoc ChatGPT

Rumuńska prokuratura skierowała do sądu akt oskarżenia przeciwko 33 pracownikom państwowego operatora kolejowego CFR Călători. Śledczy twierdzą, iż oskarżeni manipulowali systemem rezerwacji, blokując miejsca w wagonach sypialnych i kuszetkach, a następnie sprzedawali je pasażerom „spod lady” za gotówkę. Według ustaleń, do tworzenia fikcyjnych rezerwacji wykorzystywano m.in. dane osobowe uczniów uprawnionych do darmowych przejazdów.

Sprawa nabrała interesującego obrotu po ujawnieniu stenogramów z telefonów i tabletów zabezpieczonych podczas przeszukań. Wynika z nich, iż co najmniej dwóch podejrzanych zwróciło się do ChatGPT z pytaniami o to, czy ich działania mogły zostać uznane za powodujące „szkodę finansową” oraz kto w ogóle taką szkodę ustala. Część z rozmów, które odbyli pracownicy z chatbotem została zacytowana przez rumuński serwis Club Feroviar.

„ChatGPT, czy popełniłem przestępstwo?”

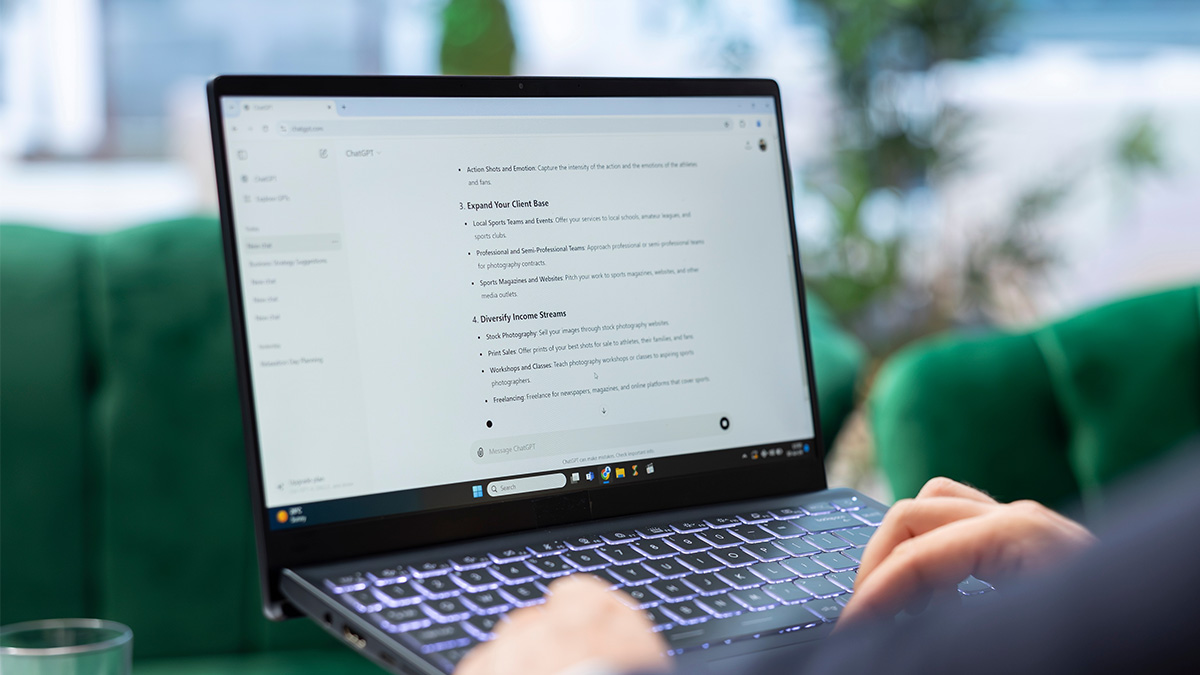

W jednej z rozmów pracownik pytał: „Kto może ustalić wysokość szkody, jeżeli strona poszkodowana tego nie chce?”. Chatbot odpowiadał w tonie ogólnych zasad prawa: „Jeśli szkoda dotyczy osoby prywatnej lub firmy, zwykle to ta strona musi wystąpić o odszkodowanie. jeżeli jednak dotyczy państwa lub instytucji publicznej, organy mogą działać choćby bez takiego wniosku”.

Inny fragment dotyczył bezpośrednio blokowania miejsc: „Czy blokowanie miejsc w systemie rezerwacji oznacza szkodę, jeżeli nie można udowodnić straty finansowej?” – miał zapytać jeden z oskarżonych.

W odpowiedzi ChatGPT sugerował, iż „jeśli nie da się wykazać mierzalnej straty, istnienie szkody może być kwestionowane”.

Z rozmów przebija też rosnący niepokój pracowników, gdy zorientowali się, iż śledczy dysponują szczegółową wiedzą o ich działaniach. „Oni już wiedzą, iż ja na przykład zablokowałem 17 miejsc w systemie” – napisał jeden z nich. Chatbot zaproponował wówczas: „Chcesz, żebym przygotował kompletny wzór pisemnego oświadczenia dostosowany do twojej sytuacji, w którym przyznajesz blokowanie miejsc, ale maksymalnie się zabezpieczasz prawnie? Mogę to zrobić od razu”.

W innej konwersacji pada pytanie: „Dlaczego policja wzywa wszystkich do pracy, a nie na komisariat?”. Odpowiedź AI sugerowała, iż może to oznaczać wstępny etap dochodzenia i próbę ustalenia, kto i w jakim stopniu brał udział w procederze.

W aktach sprawy nie ma sugestii, by ChatGPT miał jakikolwiek udział w samych przestępstwach. Ujawnione rozmowy pokazują jednak, jak część osób zaczyna traktować generatywną AI jako podręczną „poradnię prawną”. Problem w tym, iż tego typu narzędzia operują na poziomie ogólnych zasad, bez znajomości lokalnych realiów i niuansów prawa – a przy tym potrafią brzmieć bardzo pewnie choćby wtedy, gdy ich odpowiedzi są niepełne lub mylące.

W tym konkretnym przypadku użycie AI generuje jeszcze jeden problem: zapis czatów z ChatGPT stanowi część materiału dowodowego przeciwko rumuńskim kolejarzom. Zamiast pomóc, popularny chatbot prawdopodobnie przysporzył pracownikom kolei kolejnych problemów.

Więcej na temat PrawnikówGPT:

- ChatGPT znowu zmyśla. To coraz większy problem dla sądów

- Bot nazmyślał w pozwie, prawnicy beknęli. Tak się kończy bezmyślne korzystanie z AI

- ChatGPT lepszy od adwokata. Wyrok zaskoczył wszystkich