Sztuczna inteligencja miała zrewolucjonizować badania naukowe i medycynę. Problem jednak w tym, iż coraz częściej uczy się na danych, które nigdy nie istniały. Eksperci ostrzegają – jeżeli nie zaczniemy ich weryfikować, zamiast postępu czeka nas cyfrowe błędne koło.

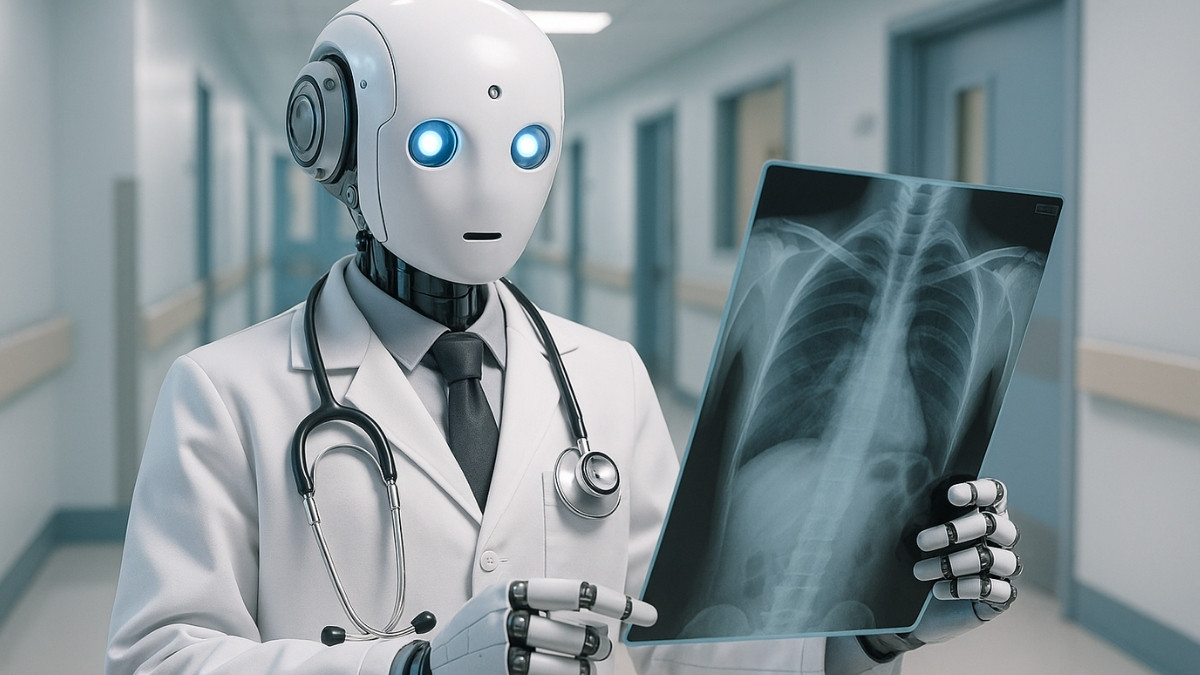

Wyobraź sobie ucznia, który zamiast czytać książki i obserwować świat, bazuje wyłącznie na własnych domysłach i notatkach kolegów. Tak dziś wygląda rozwój sztucznej inteligencji w wielu obszarach nauki, a zwłaszcza w medycynie. Algorytmy uczą się na tzw. danych syntetycznych, czyli cyfrowych symulacjach rzeczywistych informacji. Zamiast tysięcy prawdziwych zdjęć rentgenowskich, dostają wygenerowane obrazy stworzone przez inne algorytmy.

Jak czytamy na łamach Nature, tak właśnie wygląda rzeczywistość, która na pierwszy rzut oka ma same zalety: dane syntetyczne są tanie, łatwo dostępne, nie wymagają klauzul RODO i można ich używać tam, gdzie brakuje zasobów, np. w szpitalach w Afryce czy w Azji. Tyle iż z czasem modele uczą się nie na rzeczywistości, a na wcześniejszych syntetycznych wersjach tej rzeczywistości. I tu zaczyna się problem.

Sztuczna inteligencja zaczyna wierzyć we własne kłamstwa

Coraz więcej algorytmów przetwarza dane, które nie mają już wiele wspólnego ze światem rzeczywistym. To jak robienie kopii kopii kopii. W końcu obraz staje się nieczytelny. Naukowcy mówią wprost: może dojść do zjawiska model collapse, czyli cyfrowego załamania, w którym AI zacznie tworzyć nonsensowne wyniki, choć na pozór będą wyglądać logicznie.

Tymczasem część uczelni rezygnuje z konieczności opiniowania takich badań przez komisje etyczne. Bo przecież to tylko sztuczne dane. Prawda? Problem jednak w tym, iż wiele z tych danych bazuje na prawdziwych informacjach pacjentów i istnieje ryzyko, iż ktoś kiedyś powiąże je z konkretną osobą. W erze AI nic nie jest całkowicie anonimowe.

Naukowcy biją na alarm. Nie wszyscy chcą jednak słuchać

Zisis Kozlakidis z WHO zwraca uwagę na brak przejrzystości: twórcy modeli rzadko ujawniają, jak dokładnie wygenerowali dane, na których AI się uczyła. W efekcie nie da się zweryfikować wyników. A bez tego nie ma mowy o rzetelnej nauce. Randi Foraker z Uniwersytetu Missouri apeluje z kolei o wprowadzenie standardów raportowania dla danych syntetycznych. Inni badacze, jak Marcel Binz z Niemiec, celowo udostępniają swoje modele publicznie, by mogły być sprawdzone przez innych.

Choć temat może brzmieć dla nas odlegle, to nie dotyczy tylko USA czy Niemiec. W Polsce również wdraża się AI w szpitalach, na uczelniach czy w instytutach badawczych. jeżeli chcemy rozwijać nasze modele uczciwie i odpowiedzialnie, musimy zadbać o walidację, czyli niezależne sprawdzenie, czy wyniki mają sens. jeżeli tego nie zrobimy, zamiast rewolucji czeka nas cyfrowa katastrofa: AI, która świetnie rozumie świat, który sama sobie wymyśliła.

*Grafika wprowadzająca wygenerowana przez AI