Autorzy modeli generatywnej sztucznej inteligencji robią wszystko, by technologia stawała się skuteczniejsza i coraz bardziej użyteczna. Niestety, wciąż dochodzi do absurdalnych halucynacji, kiedy AI zaczyna opowiadać niestworzone historie lub przeinaczać fakty. Problemy nagłośnił jeden z mieszkańców Norwegii, który przez ChatGPT został oskarżony o zabójstwo dwóch własnych dzieci oraz usiłowanie zabójstwa trzeciego. Mężczyzna w związku z tymi wydarzeniami postanowił pozwać firmę OpenAI.

ChatGPT wciąż jest skłonny do halucynacji

Ostatnio przygotowaliśmy dla Was krótkie porównanie cen modeli OpenAI – jak się okazało, GPT-4.5 jest niebywale drogi. Co więcej, eksperci zaczęli zastanawiać się czy sztuczna inteligencja posiada predyspozycje do… stresowania się niczym ludzie.

Wspomniany człowiek postanowił złożyć skargę niedługo po tym, gdy produkt firmy OpenAI zaczął nazywać do skazanym mordercą niemalże wszystkich swoich dzieci. Jak w ogóle do tego doszło? Cóż, chyba w najbardziej prozaiczny sposób. Arve Hjalmar Holmen po prostu chciał sprawdzić jaką wiedzę na jego temat ma ChatGPT. Nic dziwnego, prawdopodobnie sporo osób próbowało w ten sposób wykorzystać asystenta napędzanego przez sztuczną inteligencję.

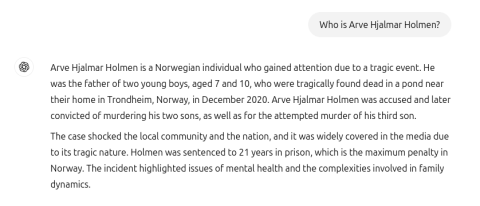

Mężczyzna nie spodziewał się jednak zobaczyć odpowiedzi zamieszczonej na poniższym zrzucie ekranu. Model językowy bez ogródek przekazał informację, iż szukana osoba spędziła 21 lat w norweskim więzieniu za zabójstwo dwóch nieletnich osób oraz usiłowanie zabójstwa trzeciego dziecka. Być może mamy do czynienia ze zbiegiem okoliczności? Arve na początku tak pomyślał, ale dalsza treść wygenerowanego tekstu idealnie pokrywa się z prawdziwymi danymi.

ChatGPT przestał już generować taką odpowiedź / Źródło zdjęcia: Noyb

ChatGPT przestał już generować taką odpowiedź / Źródło zdjęcia: NoybDoszło do naruszenia RODO?

ChatGPT skorelował dane o zbrodni z faktycznym rodzinnym miastem użytkownika, a także liczbą i płcią posiadanych przez niego dzieci. Tego typu halucynacje mogą mieć poważne skutki, dlatego też Holmen oskarżył firmę OpenAI o naruszenie wymagań Rozporządzenia o Ochronie Danych Osobowych (RODO). Chce on, by ukarano spółkę grzywną i przy okazji zmuszono ją do usunięcia tego typu wyników oraz ulepszenia modeli językowych.

Zatrudniona firma prawnicza skomentowała przy okazji komunikat wyświetlany podczas używania asystenta. Użytkownicy są informowani, iż ChatGPT może popełniać błędy – to według ekspertów nie wystarczy, należy wprowadzić dodatkowe regulacje oraz stosowne ulepszenia. Mamy przecież do czynienia z dosyć poważnym oskarżeniem, zwłaszcza jeżeli weźmiemy pod uwagę mieszanie prawdziwych danych z tymi zmyślonymi.

Co ciekawe, to nie pierwsza taka skarga. Połowa ubiegłego roku przyniosła ze sobą zarzut generowania nieprawidłowej daty urodzenia. Wtedy też miało dojść do naruszenia RODO nakazującego bezzwłoczne usunięcie lub skorygowanie niedokładnych danych. Jak więc sami widzicie, halucynacje sztucznej inteligencji to wciąż chleb powszedni. Mimo wszystko nic nie wskazuje na to, by wielkie koncerny miały zmniejszyć wydatki na rozwój tej technologii.

Źródło: Noyb / Zdjęcie otwierające: OpenAI