Kolejne odcinki można odnaleźć na mojej stronie głównej

https://jacekh.substack.com/

Obiecałem, iż w kolejnym odcinku zaprezentuję swoje prace, a tu znowu zamiast galerii arcydzieł są opowiastki o mojej przygodzie z generacją obrazów i wyniki eksperymentów. Tłumaczy mnie tylko fakt, iż wszystkie prezentowane ilustracje są jak najbardziej moimi wynikami. Poprzednio pokazałem, w jaki sposób na wygląd obrazka wpływa styl określony albo dzięki wyboru któregoś z predefiniowanych, czyli przygotowanych przez kogoś stylów, albo przez przywołanie nazwiska artysty. Okazuje się jednak, iż wyniki generacji obrazu silnie zależą także od użytego modelu oraz zdefiniowanej techniki malarskiej lub graficznej. Badam tę sprawę dosyć intensywnie i stale różne wyniki mnie zaskakują. Przypominam, iż tak jak opisałem w części pierwszej cała zabawa odbywa się na NightCafe: https://creator.nightcafe.studio/

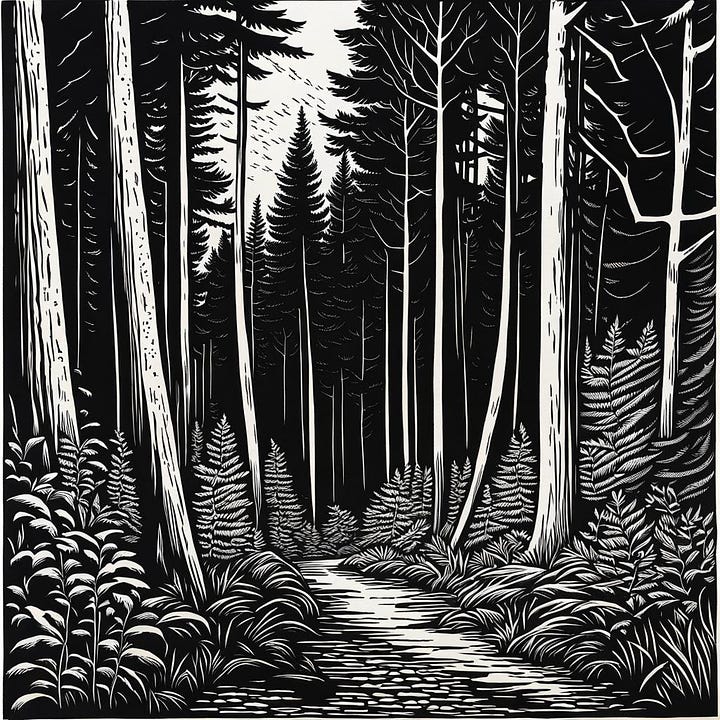

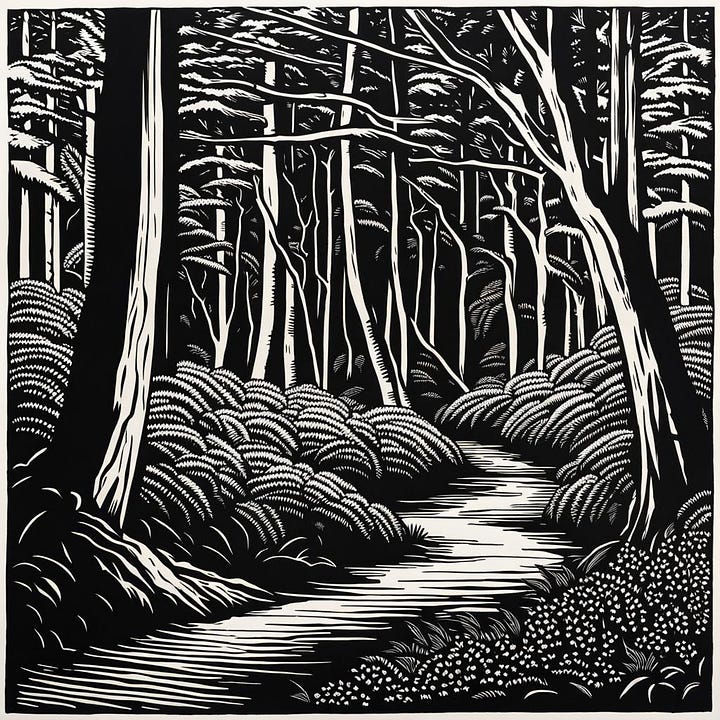

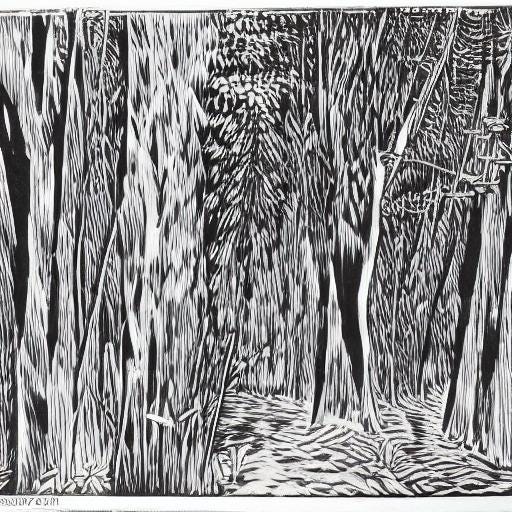

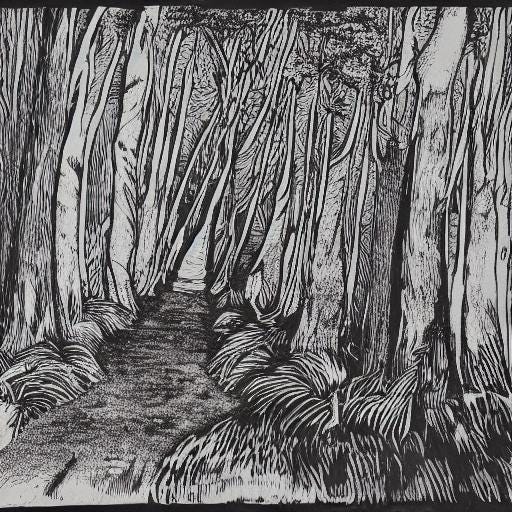

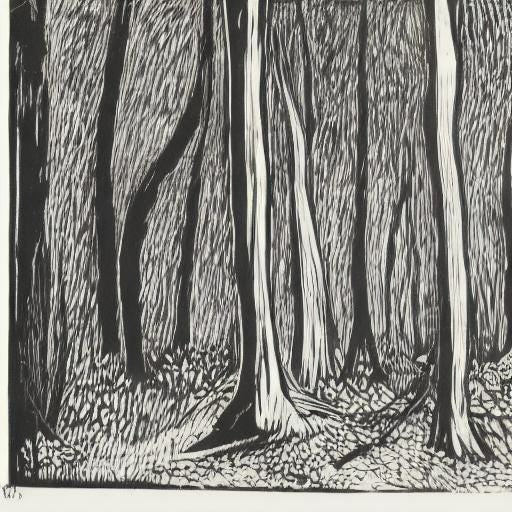

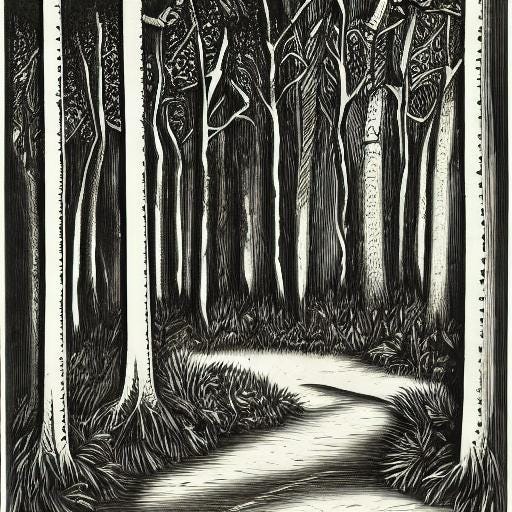

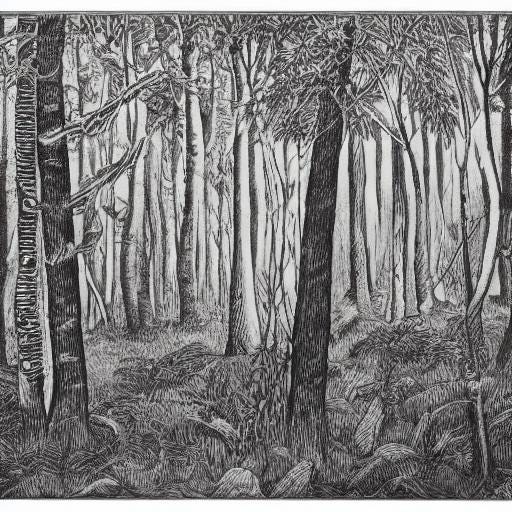

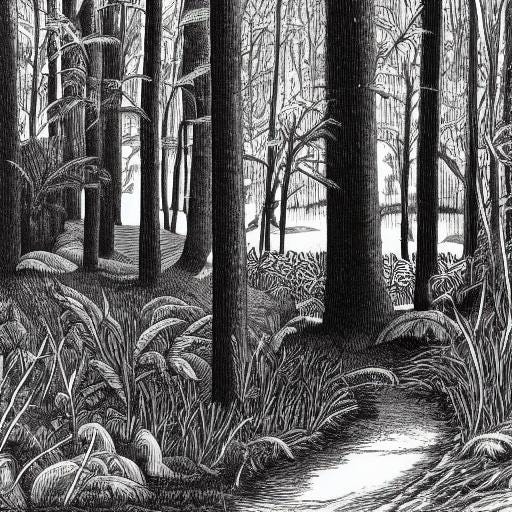

Na początek wybierzmy prosty prompt: A Corner of the Forest, b&w.

Dodatek b&w wskazuje, iż nie chcemy dzieł kolorowanych. Powinniśmy jeszcze określić technikę wykonania, gdyż w przeciwnym razie model użyje swojego domyślnego stylu. o ile wpiszemy powyższy tytuł w wyszukiwarkę, uzyskamy masę trafień na przykład Kubusia Puchatka, bo w tłumaczeniu nasz prompt to Leśny Zakątek. Jednakże nasz prompt jest również tytułem powstałego w 1931 roku dzieła angielskiego drzeworytnika Ethelberta White’a. Jego tak zatytułowaną pracę znalazłem w książce „English wood-engraving 1900-1950” wydanej ponownie przez wydawnictwo Dover, które specjalizuje się w reedycjach dawnych książek głównie na tematy naukowe i artystyczne. Oczywiście pracę można zobaczyć również w sieci. https://www.google.com/search?q=Ethelbert+white+a+corner+in+the+forest

Aż się prosi o dodanie nazwiska pana White’a do promptu. Gdybyśmy się na to zdecydowali, musielibyśmy przywołać pełne imię i nazwisko artysty, gdyż w jego wypadku samo nazwisko mogłoby zostać zinterpretowane jako kolor. Jednakże nie użyjemy artysty w prompcie, gdyż nie wiemy, czy poszczególne modele go rozpoznają i czy nie sprawi to dodatkowych niespodzianek. Będziemy testować różne techniki tworzenia obrazów na drewnie oraz porównywać działanie różnych modeli AI bez powoływania się na artystę.

Chcemy, używając różnych modeli generować obrazy wyglądające na wykonane dzięki dwu technik drzeworytniczych. Ostatecznie prompt będzie miał postać (wydaje się, iż wielkość liter nie ma znaczenia):

A Corner of the Forest, woodcut, b&w

albo

A Corner of the Forest, wood engrawing, b&w

Słabo się na tym znam i nie mam pewności, jakie są prawidłowe polskie nazwy obu technik drzeworytniczych. Gdzieś widziałem określenia zależne od kierunku włókien drewna. Rozróżniano drzeworyt wzdłużny (woodcut) i drzeworyt sztorcowy (wood engraving). Ten pierwszy wykonywany dłutem na powierzchni deski. Ten drugi sposób polegał na użyciu rylca na powierzchni klocka powstałej po przecięciu drewna w poprzek włókien. Stosowany był do odwzorowywania w wysokiej rozdzielczości ilustracji lub całych stron książek (ksylografia).

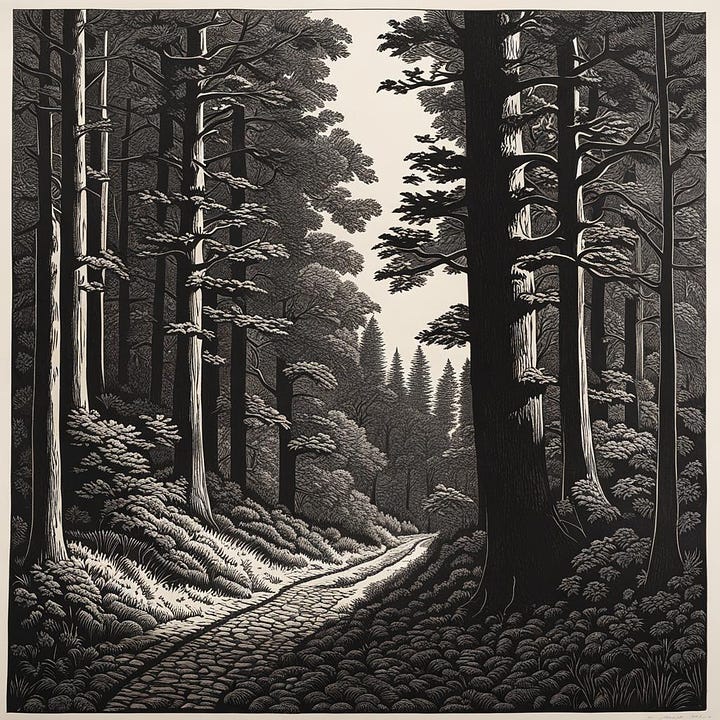

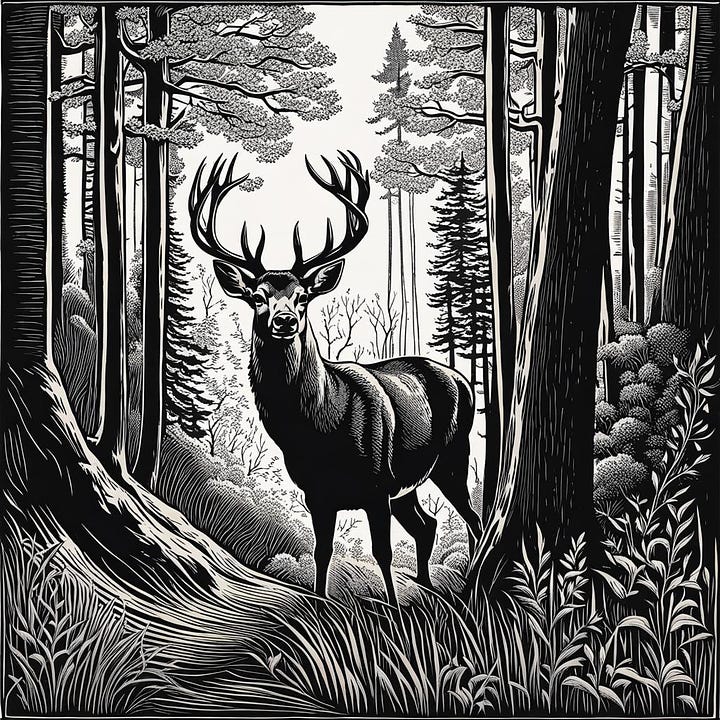

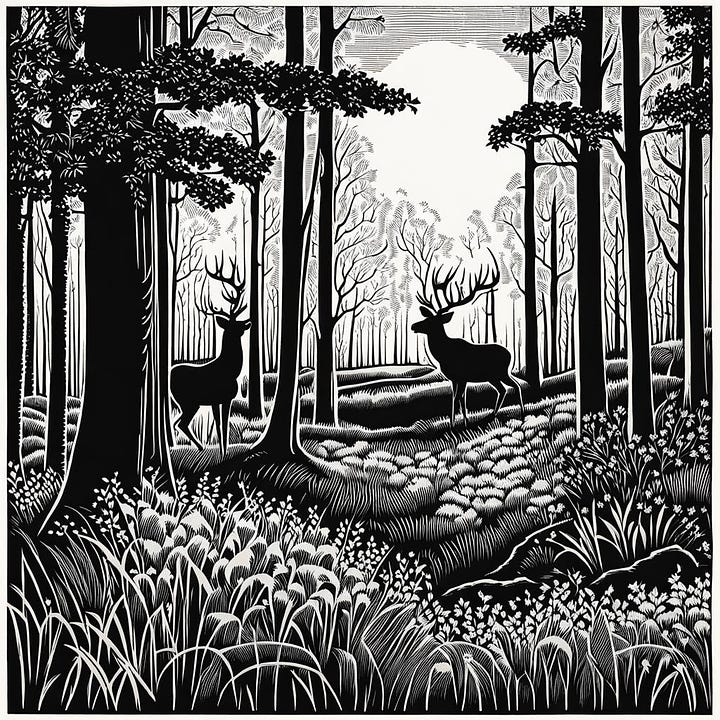

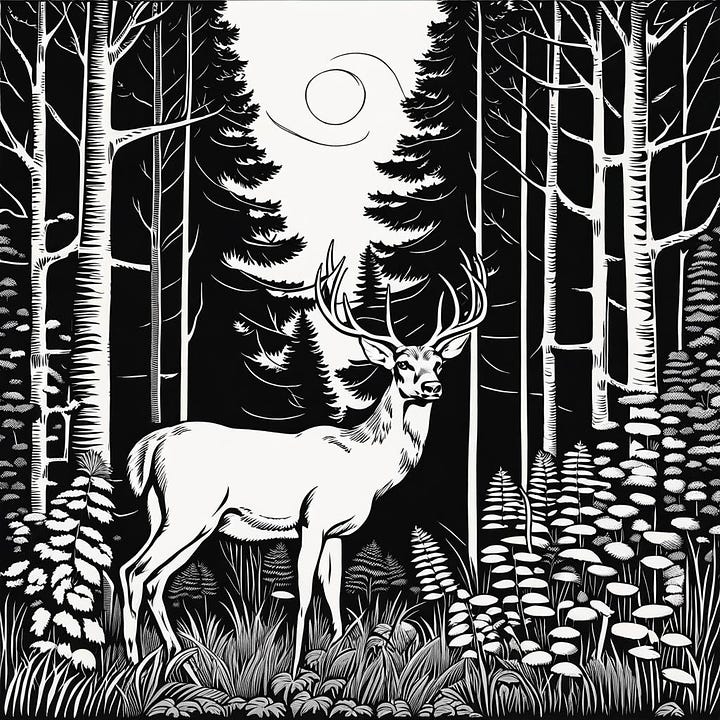

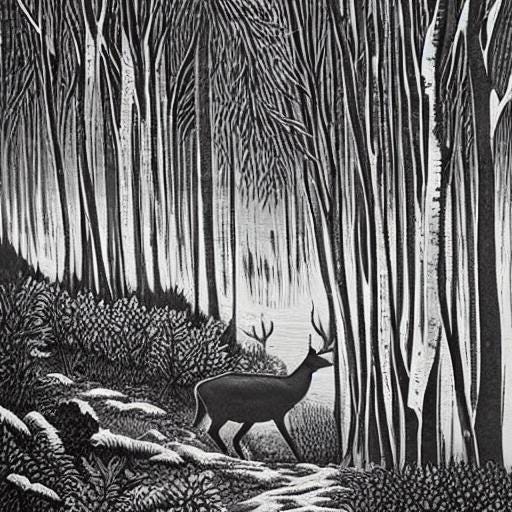

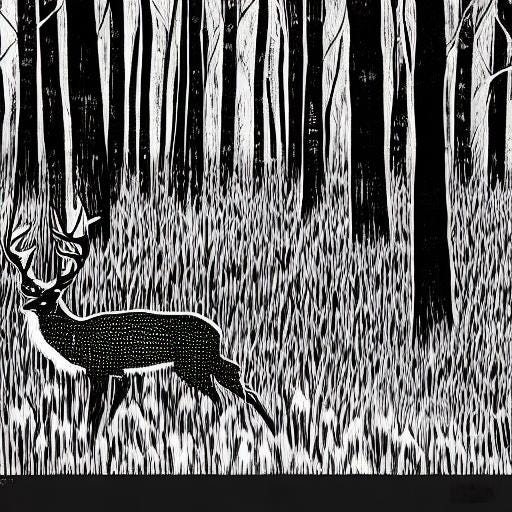

Oto wyniki. Oglądając je, pamiętajmy, iż są pomniejszone w stosunku do oryginalnego drzeworytu.

Powyższe obrazki, aczkolwiek miłe nie są przesadnie podobne do oryginału, ponadto brak jest na nich jelenia, który tam występuje. (Aby się pojawił, powinniśmy go specjalnie dopisać do promptu). Dobrze jednak ilustrują różnicę pomiędzy woodcut (na górze) i wood engraving (dolne). Wygenerowane zostały używając modelu SDXL 1.0. Podobne wyniki można uzyskać przy użyciu innych modeli wywodzących się SDXL, jakie są dostępne na NightCafe. Wyniki są dobre i konsystentne, to znaczy wielokrotna generacja obrazów przy użyciu tego samego promptu daje wyniki o podobnym charakterze, czyli wykonane są tą samą techniką. Zmienia się kompozycja obrazu, ale technika jest taka, jak sobie zażyczyliśmy. Niestety jest to model, którego użycie kosztuje nas 1 kredyt za każdy obraz, czyli 5-10 groszy, w zależności od rodzaju subskrypcji. Przy intensywnej pracy kasa płynie jak na stacji paliw.

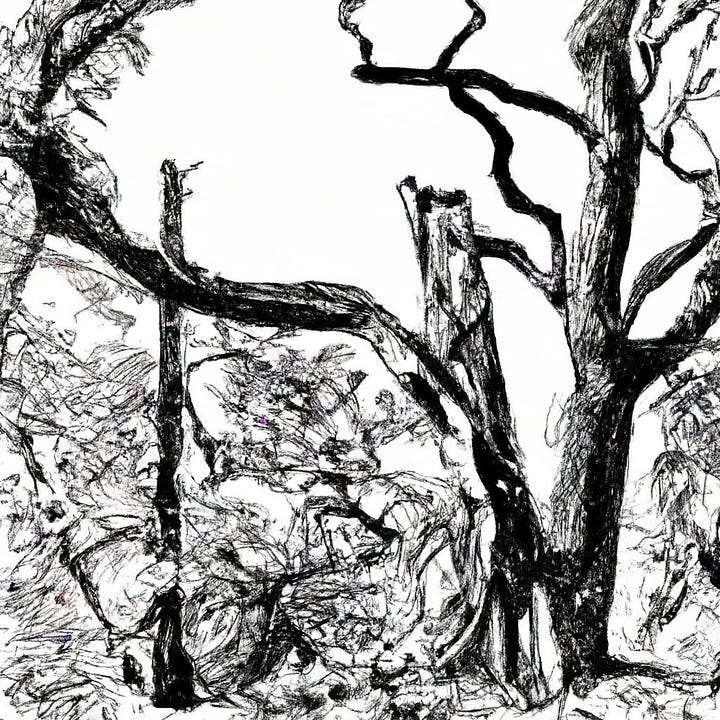

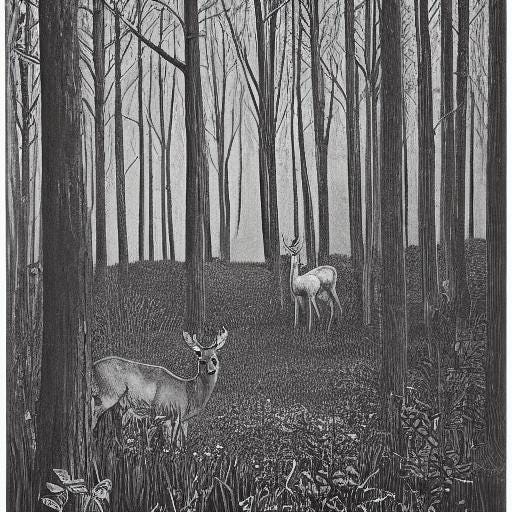

Sprawdźmy jeszcze popularny w pewnych kręgach twórców model DALL-E 2. Oto jego wyniki, po lewej woodcut, po prawej wood engraving, ale chyba nie bardzo to widać. Dla mnie te obrazy bardziej wyglądają na rysunki, choć ten po prawej cechuje lepsze odwzorowanie szczegółów. prawdopodobnie właściciele OpenAI, czyli głównie Microsoft, nie uznali za potrzebne trenowania modelu na takich głupotach jak klasyczny drzeworyt i jest to jakaś jego nowomodna odmiana. Użycie DALL-E też jest płatne.

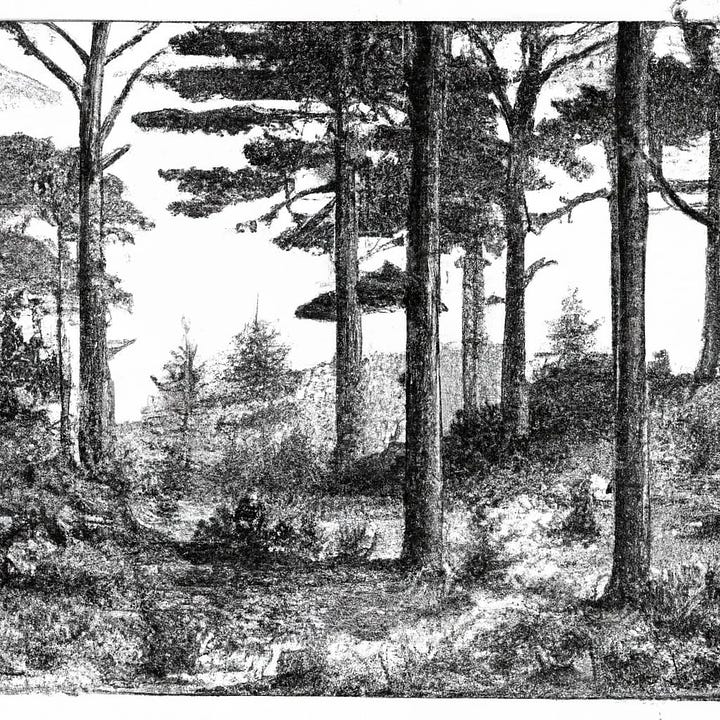

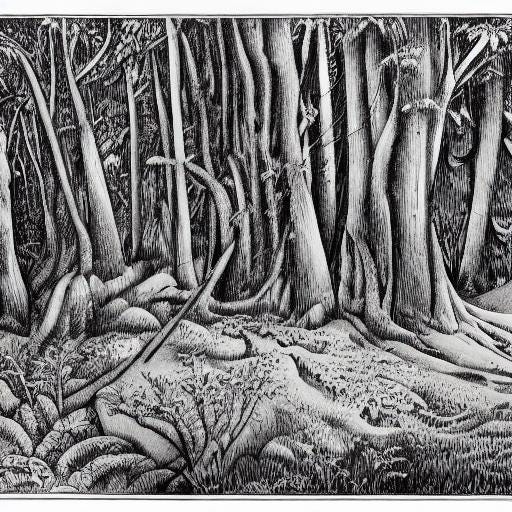

Sprawdźmy więc, co uzyskamy dzięki modeli, z których możemy korzystać bez płacenia. Pora na Stable Diffusion.

Zauważmy, iż tutaj różnice pomiędzy dwoma technikami są praktycznie niewidoczne. Można uznać, iż różnice pomiędzy reprezentantami tej samej techniki bywają większe niż pomiędzy technikami. Czasem zdarza się, iż wszystkie obrazy niezależnie od naszego wyboru techniki wyglądają jak nieostre fotografie. Nie potrafiłem odkryć, od czego to zależy. Bywają dłuższe lub krótsze ciągi generowanych obrazów o określonym charakterze, aby potem nieoczekiwanie ten charakter uległ skokowej zmianie. Widocznie trenowanie modelu było wykonane w mniej konsekwentny sposób, więc dla Stable Diffusion podobnie jak dla tłumacza Google woodcut i wood engraving to jest to samo, czyli drzeworyt. Jednakże patrząc na powyższe przykłady, możemy dojść do wniosku, iż nie bacząc na jego nieobliczalność, warto czasem korzystać z modelu Stable Diffusion, gdyż daje on ciekawsze i bardziej zróżnicowane kompozycje.

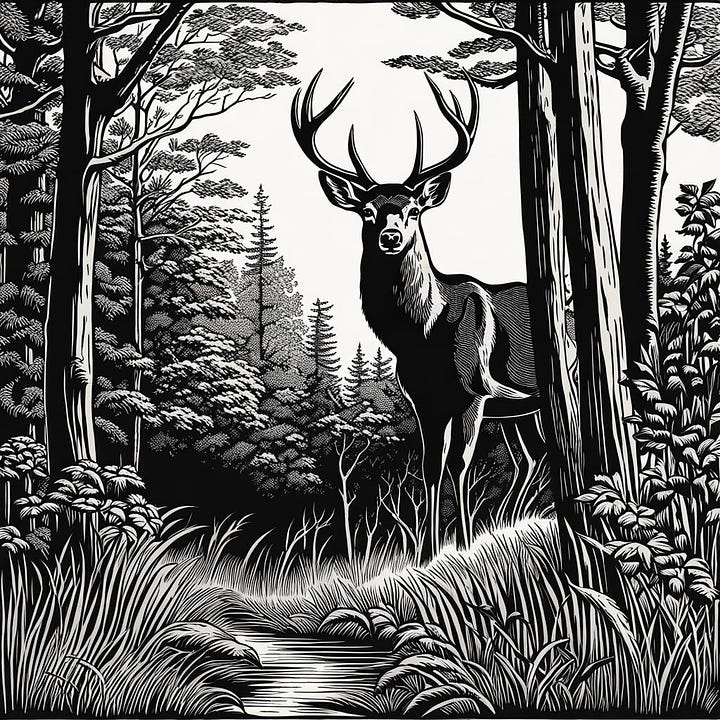

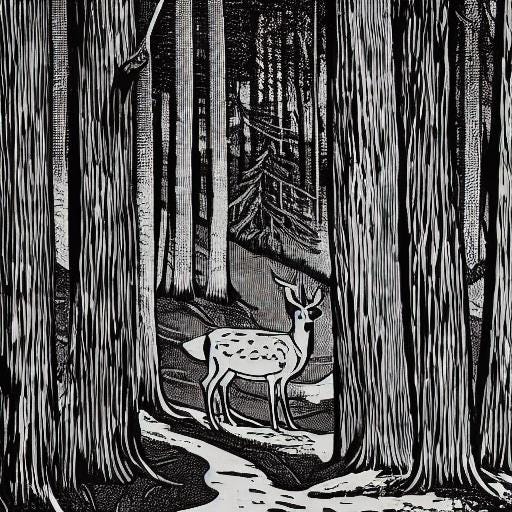

Oczywiście chcąc uzyskać bardziej określoną kompozycję, będziemy musieli rozwinąć prompt. Teraz wygląda on tak: A Corner of the Forest with a deer, woodcut, b&w.

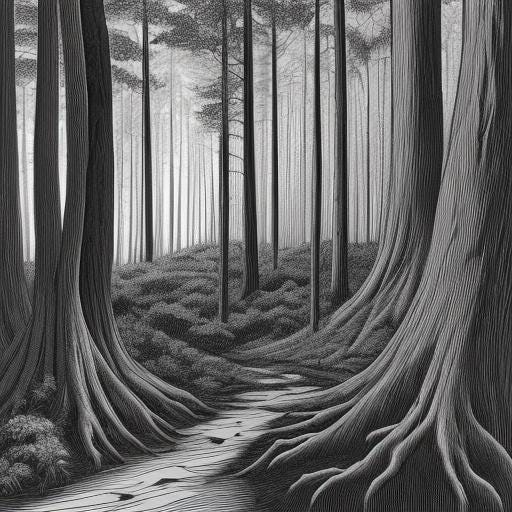

Moim zdaniem jeleń poprawił kompozycję. Te obrazy są ciekawsze od pierwszej czwórki, gdzie wszędzie była jakaś droga albo strumyk. Pozbyliśmy się kilku naszych cennych kredytów używając modelu SDXL 1.0, więc jeszcze dla porządku zobaczmy wyniki dla Stable Diffusion 1.5. Niestety przy użyciu modelu DreamShaper v8 powstawały obrazki wylizane, czyli coś w rodzaju nieostrej fotografii, trochę podobne do pierwszego z przedstawionych poniżej, więc tych wyników już nie przedstawię.

I znowu widać, iż model Stable Diffusion jest bardziej nieobliczalny, ale i bardziej kreatywny. Nie jest tak, iż następny obraz jest podobny do wszystkich poprzednich. Chcąc uzyskać niebanalny wynik, chętnie sięgniemy po ten model.

Pokazana nieobliczalność ma również swoje złe strony, albowiem gdy w końcu zobaczymy coś, co mogłoby się nam podobać, okaże się, iż złe kadrowanie obcięło człowiekowi głowę albo coś innego. Do pewnego stopnia można temu zaradzić, ale sposoby skuteczne w przypadku innych modeli często tu zawodzą. Wynika to prawdopodobnie z faktu, iż ten model był trenowany na niekonsystentnych danych. Ponieważ model SD jest otwarty i ogólnie dostępny mogą w innych miejscach wystąpić egzemplarze trenowane od zera w inny sposób, czyli bez powyższych niedostatków. Na przykład poszukując w sieci sposobów na ich uniknięcie, znalazłem na prompthero.com podstronę poświęconą Stable Diffusion, która oferuje entuzjastom generowanie własnej pornografii. Zatem należy podejrzewać, iż ten egzemplarz modelu trenowany był na zupełnie innym niezawierającym drzeworytów, ale za to całkiem spójnym zbiorze obrazów i nie wykazuje opisanych tu zachowań. Z drugiej jednak strony być może w tym przypadku obcięcie na obrazie głowy nie byłoby aż tak wielką tragedią.

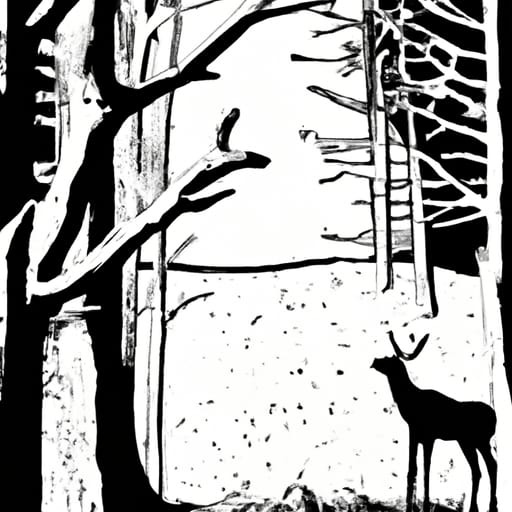

I jeszcze wyniki modelu DALL-E 2.

Być może źle go oceniłem. To chyba jednak jest drzeworyt? Po prostu inny styl, on też się może przydać. Post zrobił się przydługi, więc sprawdzenie, jakie wyniki otrzymamy po powołaniu się na konkretnego drzeworytnika, znajdą się w następnym. Chyba żeby niekoniecznie.

Ponieważ stale odkrywam coś nowego, z pewnością znowu napiszę o generacji obrazów z użyciem AI. Jednakże tym razem nie obiecuję niczego konkretnego. Okaże się.

Dziękuję za przeczytanie Substacka Jacka! Zapisz się bezpłatnie, aby otrzymywać nowe posty i wspierać moją pracę.