W dobie gwałtownego rozwoju technologii pojawia się coraz więcej narzędzi mogących zagrozić demokracji. Jednym z nich są aplikacje, które umożliwiają klonowanie głosu (określane też jako „deepfake audio”). Są one łatwe w obsłudze i tanie, a jednocześnie trudne do wykrycia.

Czym jest klonowanie głosu?

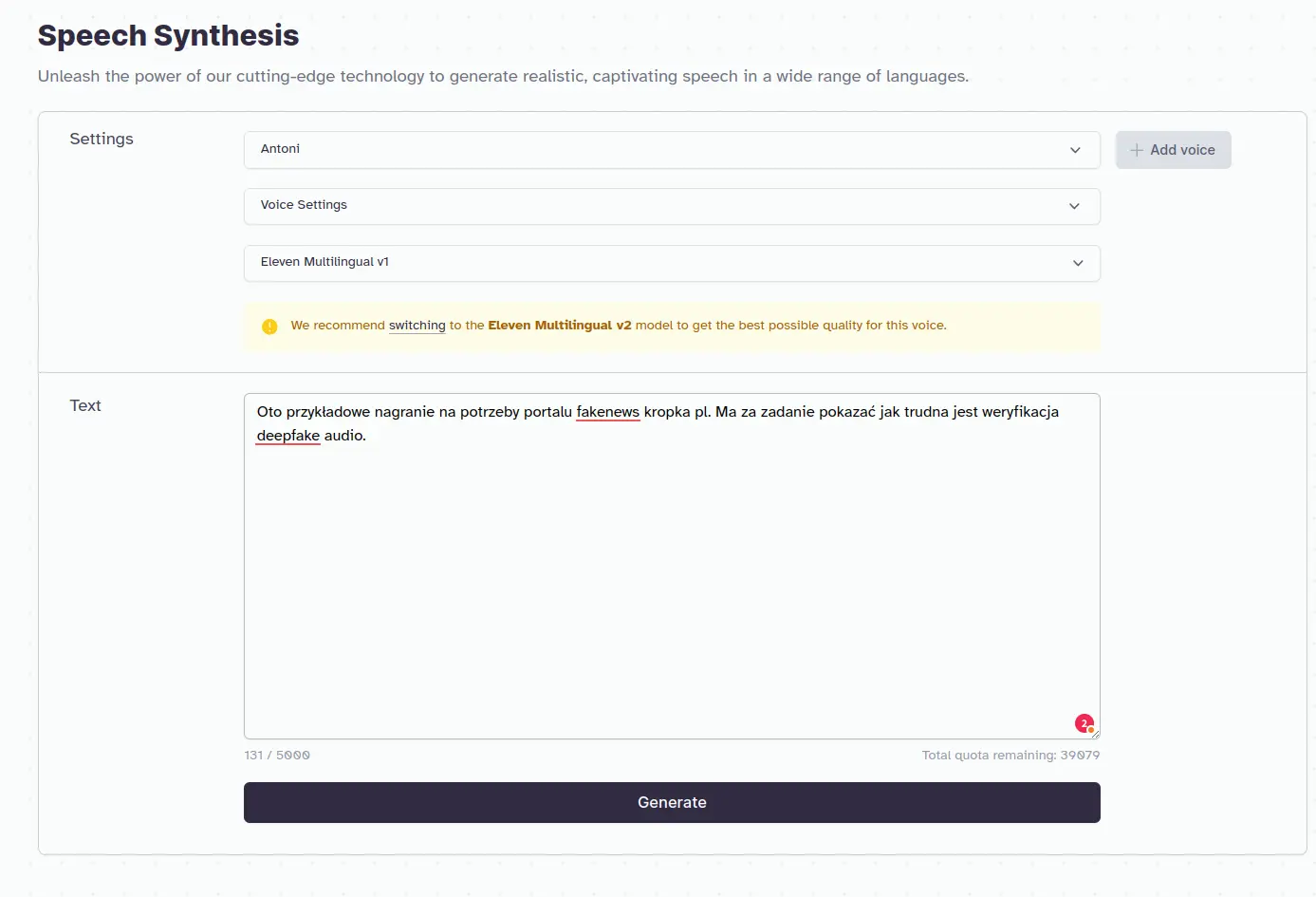

Klonowanie głosu polega na odtworzeniu barwy głosu konkretnej osoby dzięki sztucznej inteligencji. Najpopularniejsze platformy, takie jak ElevenLabs, oferują tę usługę za niewielką opłatą. Za niespełna pięć złotych (1 USD – za pierwszy miesiąc) możemy sklonować praktycznie każdy głos. Wystarczy pięciominutowa próbka, którą załadujemy na platformę ElevenLabs, i wpisując tekst w odpowiednie okno dialogowe, możemy sprawić, iż dowolna osoba wypowie dowolną kwestię.

Źródło: ElevenLabs

Źródło: ElevenLabsPowszechna dostępność poradników w języku polskim i angielskim sprawia, iż technologia ta jest ogólnie dostępna dla przeciętnego internauty.

Deepfake audio jako zagrożenie dla demokracji

Wybory w Słowacji

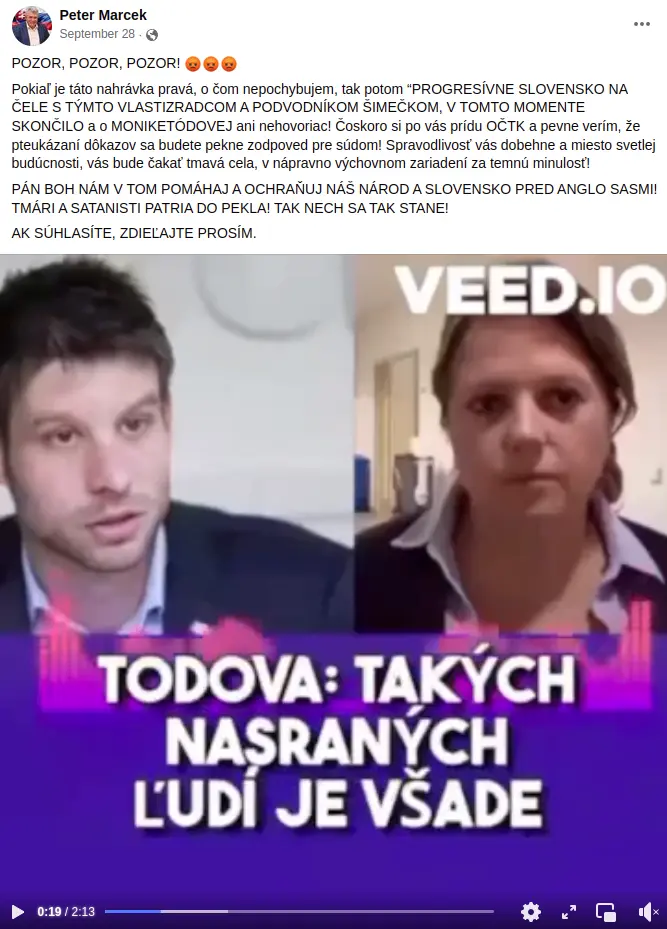

Kilka dni przed wyborami w Słowacji na platformach społecznościowych zaczęło krążyć nagranie, w którym słychać głos lidera tamtejszej partii Postępowa Słowacja, Michala Šimečka, oraz dziennikarki Moniki Tódovej z Denník N. Rzekomo mieli oni rozmawiać o manipulowaniu wynikami wyborów, polegającym na kupowaniu głosów od marginalizowanej mniejszości romskiej.

Źródło: Facebook, Peter Marcek

Źródło: Facebook, Peter MarcekNagranie zostało bardzo gwałtownie oznaczone jako fałszywe przez organizację sprawdzającą fakty AFP, jednak – co najważniejsze – ukazało się w okresie ciszy wyborczej, co ograniczyło możliwość jego publicznego zdementowania przez polityków.

Przywódca brytyjskiej opozycji, Sir Keir Starmer, ofiarą deepfake audio

Sir Keir Starmer, lider brytyjskiej Partii Pracy, również został ofiarą klonowania głosu. W nagraniu, które pojawiło się na Twitterze, rzekomo krytykuje on w niewybrednych słowach członków swojej partii oraz miasto Liverpool. Obydwa nagrania były sfałszowane, jednak do tej pory pozostają w obiegu. Na portalu X tweet z nagraniem ma już ponad 1,5 miliona wyświetleń i przez cały czas nie został oznaczony jako zmanipulowany.

Źródło: X/leo_hutz

Źródło: X/leo_hutzInne przypadki w Europie i na świecie

Jak podaje Washington Post, według organizacji NewsGuard 17 namierzonych kont na TikToku wykorzystywało sztuczną inteligencję do tworzenia fałszywych narracji, generując łącznie 336 milionów wyświetleń i 14,5 miliona polubień. W ostatnich miesiącach konta te umieszczały wygenerowane przez AI nagrania zawierające fałszywe przekazy. Twierdzono w nich na przykład, iż były prezydent USA Barack Obama jest powiązany ze śmiercią swojego osobistego kucharza, iż Oprah Winfrey jest „handlarką seksualną” oraz iż aktor Jamie Foxx został sparaliżowany i oślepiony przez szczepionkę na COVID-19. TikTok usunął te materiały dopiero po tym, jak został o nich poinformowany przez NewsGuard.

Klonowanie głosu w Polsce: Od polityki po #PandoraGate

W Polsce technologia klonowania głosu nie wywołała jeszcze poważniejszych skandali, ale jej rosnąca obecność i użycie wzbudzają kontrowersje i nie pozostają bez echa w społeczeństwie.

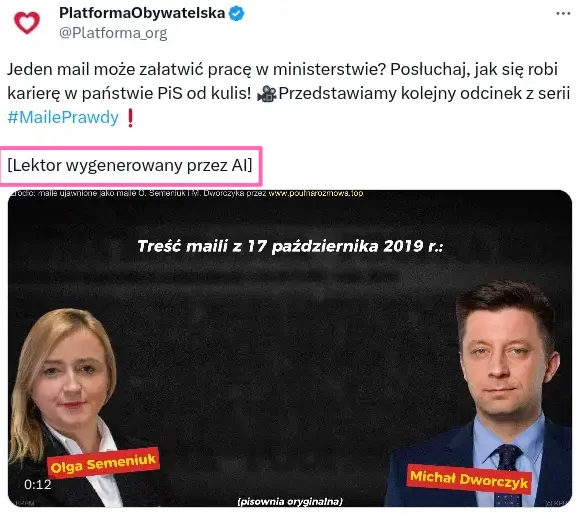

Polityczne eksperymenty: casus Platformy Obywatelskiej

W ramach jednego z kampanijnych spotów Platforma Obywatelska zdecydowała się na wykorzystanie sklonowanego głosu Mateusza Morawieckiego, by ukazać wewnętrzne napięcia w obozie rządzącym. W nagraniu słychać głos łudząco podobny do głosu premiera, który czyta maile pochodzące ze skrzynki Michała Dworczyka. Treść dotyczy nielojalności Zbigniewa Ziobry, co jest kontrastem do zacytowanej wcześniej wypowiedzi Mateusza Morawieckiego z mównicy sejmowej, gdzie twierdzi on, iż Zjednoczona Prawica jest „twarda jak stal”.

Źródło: X/Platforma_org

Źródło: X/Platforma_orgZaskakujący eksperyment wywołał falę krytyki, co zmusiło partię do późniejszego wyjaśnienia, iż głos został wygenerowany dzięki AI. W późniejszych działaniach Platforma Obywatelska była już bardziej transparentna, informując o użyciu technologii w treści postów.

Źródło: X/Platforma_org

Źródło: X/Platforma_org#PandoraGate: Youtuberzy, pedofilia i technologia

Jednym z wydarzeń, które wstrząsnęło polską opinią publiczną, był skandal związany z oskarżeniami o pedofilię wśród znanych polskich youtuberów, zwany #PandoraGate. Konopskyy, jeden z twórców wideo, który pomógł ujawnić aferę, zastosował technologię deepfake audio w swoim filmie. Wykorzystano AI, żeby wygenerować głos Stuarta „Stuu” w celu lepszej ilustracji tematu, o którym mowa w nagraniu. Co ważne, Konopskyy jasno i czytelnie zaznaczył, iż głosy są wygenerowane przez sztuczną inteligencję.

Źródło: YouTube, Konopskyy

Źródło: YouTube, KonopskyyTikTok, Jarosław Kaczyński i… Minecraft

TikTok, platforma w zamyśle służąca rozrywce, został wręcz zalany nagraniami, w których politycy wypowiadają nieistniejące kwestie. Znaleźć tam można m.in. filmy, w których Jarosław Kaczyński wypowiada się w niewybredny sposób o swoich oponentach lub gdzie razem z prezydentem Andrzejem Dudą grają w Minecrafta.

Źródło: TikTok/florek1

Źródło: TikTok/florek1Mimo humorystycznego wydźwięku takie przypadki skłaniają do refleksji nad potencjalnie poważnymi konsekwencjami klonowania głosu.

Reakcja gigantów społecznościowych

Platformy społecznościowe nie zareagowały adekwatnie do skali problemu. W przypadku nagrań Sir Keira Starmera X (dawniej Twitter) nie umieścił żadnego ostrzeżenia, iż nagranie może być zmanipulowane. Nadal widnieje ono w serwisie i generuje dezinformację. Meta i Google mają pracować nad rozwiązaniami pomagającymi w oznaczaniu treści jako wygenerowanych przez AI, ale na razie rezultatów nie widać. W tym momencie cały problem zrzucony jest na barki organizacji fact-checkingowych i mediów. To właśnie fact-checkerzy oznaczyli film Michala Šimečka jako manipulację. Rola Facebooka była marginalna, ponieważ nagranie zostało jedynie specjalnie oznaczone, a nie usunięte. przez cały czas można je obejrzeć i przesłuchać, a przy odrobinie wysiłku pobrać i rozpowszechniać dalej.

TikTok również ma pracować nad narzędziami, które automatycznie klasyfikują treści wygenerowanie przez AI. W tej chwili proces odbywa się tylko ręcznie. Gigant usuwa manipulacje oparte na AI w przypadku bardzo popularnych nagrań, kiedy roszczenie zgłasza osoba publiczna. Tak było w przypadku Toma Hanksa, którego głos i wizerunek zostały wykorzystane do reklamowania produktów dentystycznych bez jego wiedzy i zgody, lub deepfake’a z Mr.Beast, który reklamował scam z iPhone.

Wykrywanie deepfake audio

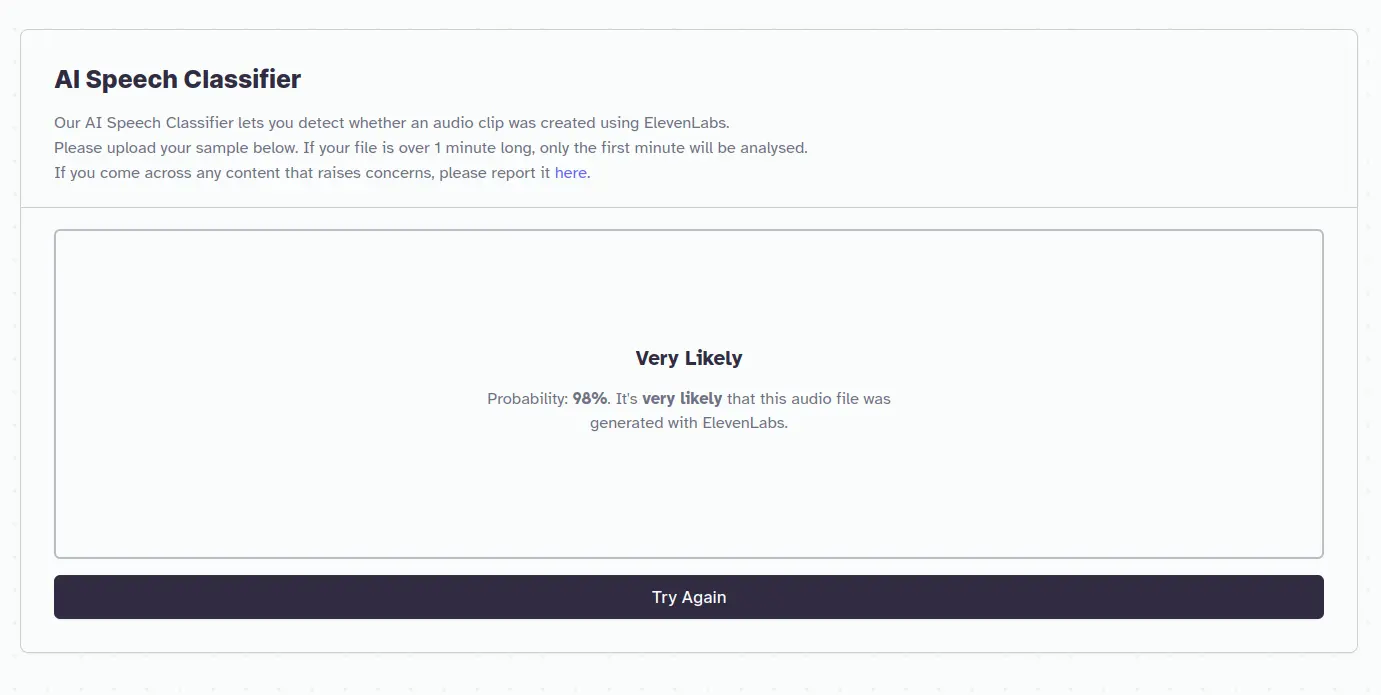

Niestety, jak dotąd, brakuje skutecznych narzędzi do wykrywania głosów wygenerowanych przez AI, co sprawia, iż klonowanie głosu jest trudne do wykrycia. Przykładowo, ElevenLabs udostępniło klasyfikator, który ma wykrywać, czy dane nagranie jest wygenerowane przez ElevenLabs bądź zmanipulowane, ale wystarczy dodać w tle jakieś zakłócenia (np. śpiew ptaków czy odgłosy samochodów) i klasyfikator kompletnie sobie nie radzi. Oto przykład:

Za pomocą ElevenLabs wygenerowaliśmy proste nagranie oparte o jeden z wielu dostępnych syntezatorów głosu. Nagranie poniżej:

Wynik klasyfikacji:

Klonowanie głosu – rezultaty

Klonowanie głosu – rezultatyJest bardzo prawdopodobne, iż ten plik audio został wygenerowany dzięki ElevenLabs.

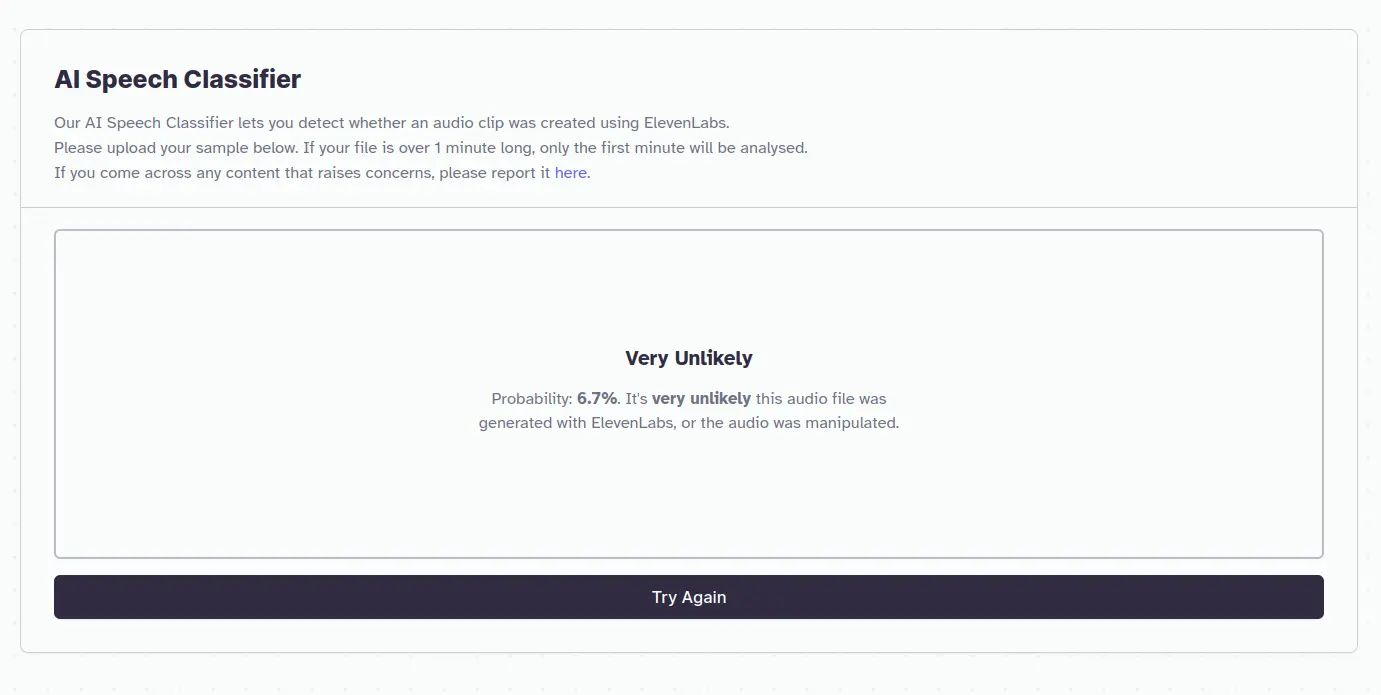

Czyli klasyfikator poprawnie rozpoznał, iż materiał jest wygenerowany przez AI. Dodajmy jednak dźwięki w tle, śpiew ptaków, odgłosy samochodów. Rezultat:

Wynik klasyfikacji:

Klonowanie głosu – rezultaty

Klonowanie głosu – rezultatyJest bardzo mało prawdopodobne, iż ten plik audio został wygenerowany dzięki ElevenLabs lub dźwięk został zmanipulowany.

Wystarczyło delikatnie „zabrudzić” nagranie i już klasyfikator ElevenLabs zwraca informację, iż prawdopodobieństwo wygenerowania przez AI spada z 98% do 6,7%.

Modyfikacja pliku dźwiękowego zajęła nam 2 minuty. Ten mały eksperyment pokazuje, jak trudne jest wykrywanie tego typu manipulacji. Sprawą oczywistą jest, iż potencjalni aktorzy dezinformacji będą zniekształcać nagranie, aby utrudnić jego weryfikację, co sprawi, iż dostępne w tej chwili klasyfikatory stają się bezużyteczne.

Podsumowanie

Technologia klonowania głosu rozwija się w błyskawicznym tempie i stwarza nowe wyzwania dla demokracji i prawdziwości przekazu medialnego. W tym momencie tylko wspólny wysiłek mediów, organizacji fact-checkingowych i platform społecznościowych może stanowić minimalną barierę przed rozprzestrzenianiem się dezinformacji w tej formie. Miejmy nadzieję, iż w najbliższej przyszłości pomogą w tym również rozwiązania technologiczne, które nie są w tej chwili dostępne dla ogółu.

Źródła:

The Washington Post: https://www.washingtonpost.com/technology/2023/10/13/ai-voice-cloning-deepfakes/

Wired: https://www.wired.co.uk/article/slovakia-election-deepfakes

AFP: https://fakty.afp.com/doc.afp.com.33WY9LF

DIG.watch: https://dig.watch/updates/meta-platforms-develops-labels-for-ai-generated-content

Wirtualnemedia.pl: https://www.wirtualnemedia.pl/artykul/pandora-gate-sylwester-wardega-stuu-boxdel-dubiel-fagata-pedofilia

Factcheckhub: https://factcheckhub.com/ai-voice-technology-used-to-create-misleading-videos-on-tiktok-report/